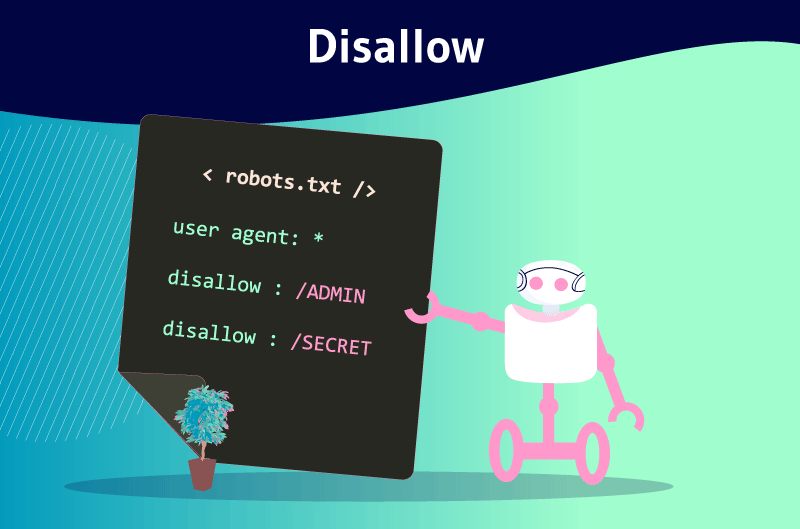

Disallow est une directive que les webmasters utilisent pour administrer les robots explorateurs des moteurs de recherche appelés crawlers. Le principal rôle de cette directive est d’indiquer à ces bots dans un fichier Robots.txt, de ne pas explorer la page ou le fichier spécifique d’un site web. À l’opposé, nous avons la directive Allow qui indique aux crawlers qu’ils peuvent accéder à ces mêmes éléments.

La création de contenu de qualité et des backlinks sont les techniques populaires pour référencer un site. Même si ces techniques dominent, il existe de nombreuses autres techniques qui contribuent au référencement d’un site web.

La plupart de ces techniques sont malheureusement peu connues bien que certaines d’entre elles se révèlent comme de véritables atouts pour référencer un site.

C’est le cas du fichier robots.txt, un fichier qui communique aux moteurs de recherche à travers plusieurs directives, comment explorer les pages d’un site web. Parmi ces directives, le Disallow sort du lot. Il s’agit d’un outil puissant capable d’influencer le référencement d’un site.

À travers cet article, nous découvrons ensemble la directive Disallow et son utilité pour le référencement. Pour finir, nous explorerons quelques meilleures pratiques pour éviter des erreurs au cours de son usage.

Chapitre 1 : Qu’est-ce que la directive Disallow et en quoi est-elle utile en SEO ?

La directive Disallow est une pratique de SEO légitime que nombre de webmasters utilisent déjà. Ce chapitre est consacré à la définition de cette directive et à son importance dans l’univers SEO.

1. Qu’est-ce que la directive Disallow ?

À l’instar d’autres balises comme Nofollow, la directive Disallow influence le comportement des robots explorateurs tels que Googlebot et Bingbot face à certaines sections d’un site web.

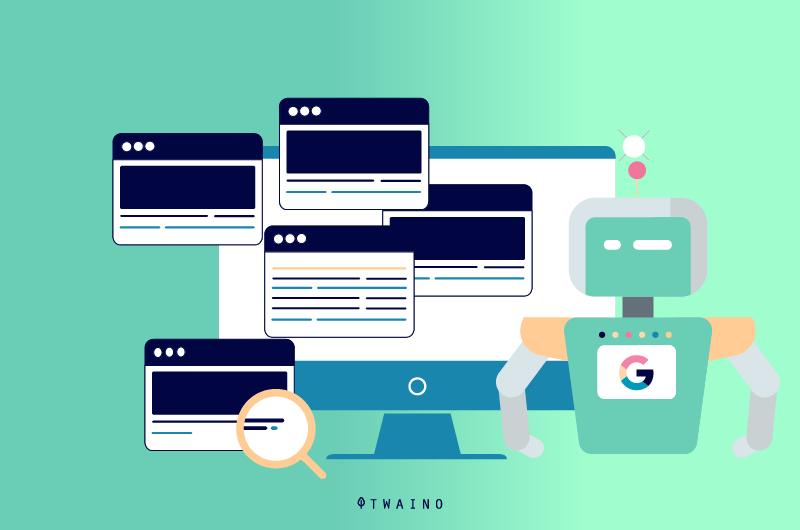

Ces robots fonctionnent comme des archivistes d’internet et rassemblent les contenus du web pour les cataloguer. Pour cela, ils explorent tous les sites web afin de découvrir les nouvelles pages et de les indexer.

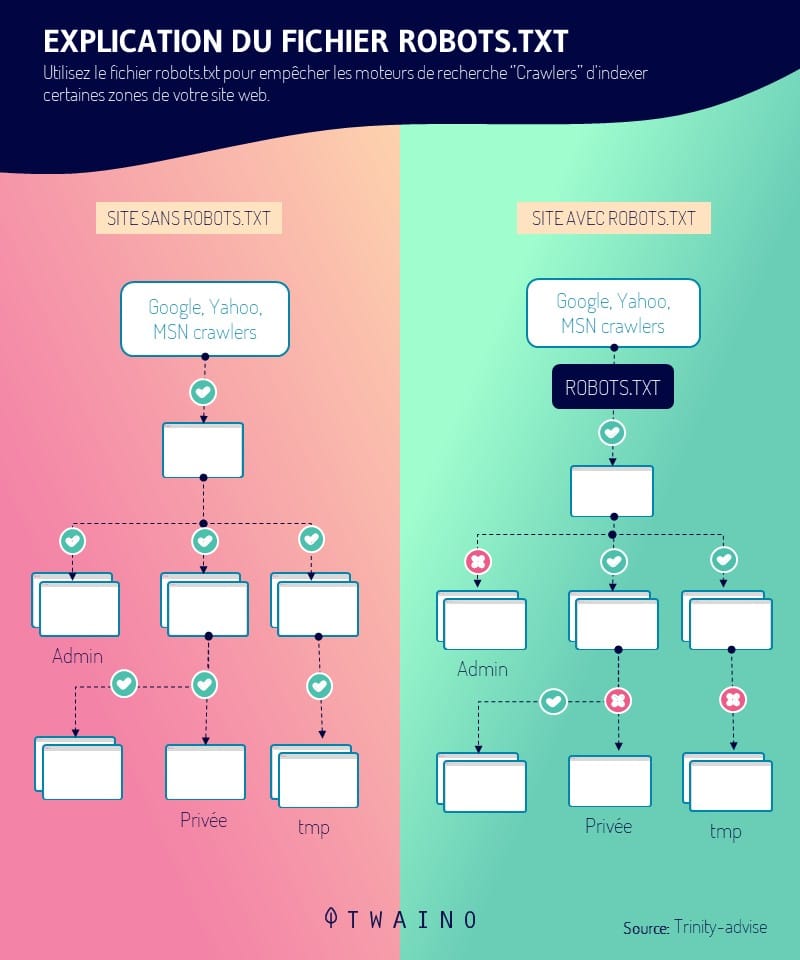

Les webmasters arrivent à donner diverses instructions aux robots explorateurs qui accèdent à leurs sites par le biais d’un fichier robots.txt. La directive Disallow est l’une de ces instructions.

Elle permet aux webmasters de bloquer l’accès à certaines ressources particulières d’un site web. Par conséquent, les robots explorateurs ne seront pas en mesure d’explorer les URL qui sont bloquées à l’aide de la directive Disallow.

Cette direction est parfois utilisée étroitement avec la directive Allow. Contrairement à la directive Disallow, il donne l’accès aux robots explorateurs et indique à ces derniers, les ressources qu’ils doivent explorer.

Il faut rappeler que ce sont seulement les bots des moteurs de recherche qui comprennent le langage utilisé dans le fichier robot.txt. Les bots qui n’utilisent pas ce langage comme les robots malveillants peuvent donc accéder aux ressources bloquées par la directive Disallow.

1.2. Où se trouve la directive Disallow ?

La directive Disallow est incluse dans un fichier robots.txt comme mentionné précédemment. Ce fichier se place dans la racine d’un site au premier niveau (www.votresite.com/robots.txt).

Les bots ne trouvent le fichier robots.txt qu’à l’emplacement indiqué ci-dessus. La dénomination correcte est robots.txt et les autres écritures telles que Robots.txt ou robots.TXT sont simplement ignorées.

Le fichier robots.txt comporte d’autres directives qui sont :

- Disallow ;

- Deny ;

- Order ;

- Etc.

Le fichier robots.txt reste accessible au public et on peut consulter pour n’importe quel site web. Il apparaît lorsqu’on ajoute « /robots.txt » à la fin d’un domaine. Ceci permet de voir l’ensemble des directives d’un site quand il possède ce fichier.

Le lien à ouvrir dans votre navigateur ressemble à celui-ci : www.votresite.com/robots.txt. Lorsque le fichier robots.txt ne se trouve pas à cette adresse, les bots supposent que le site ne dispose pas de tel fichier.

1.3. Quelle est l’importance de la directive Disallow ?

La directive Disallow peut être utilisée pour de nombreuses raisons. Avec les autres directives du fichier robots.txt, elle contribue à l’amélioration du classement d’un site.

Ces directives permettent d’orienter les crawlers vers les ressources et d’explorer seulement celles qui sont utiles.

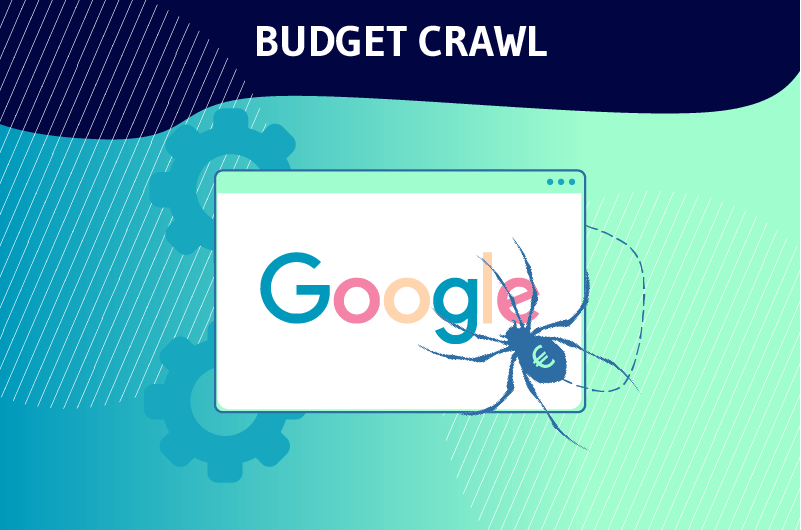

1.3.1. Optimisation du budget d’exploration

La directive Disallow est souvent utilisée pour interdire aux robots explorateurs d’explorer les pages qui n’ont pas de réel intérêt pour le référencement d’un site web. C’est ce que Google tente d’expliquer dans le passage suivant :

« Vous ne voulez pas que votre serveur soit submergé par le robot d’exploration de Google ou qu’il gaspille son budget d’exploration pour des pages sans importance ou similaires sur votre site.«

En termes simples, Google alloue un budget dit d’exploration à ses robots pour chaque site web. Ce budget est le nombre d’URL que les Googlebots peuvent explorer sur le site.

Mais lorsque les bots arrivent sur un site, ils se mettent à explorer chacune de ses pages. L’exploration d’un site prendra donc plus du temps à mesure que les pages sont nombreuses.

C’est pourquoi il faut aider les robots à ignorer les pages qui ne sont pas importantes à l’aide de la directive Disallow et de les orienter avec Allow vers les pages importantes qui méritent de classement.

Cela dit, en mettant de bonnes instructions dans le fichier robots.txt avec Disallow, les webmasters aident les bots à dépenser le budget d’exploration à bon escient. C’est l’une des raisons qui rendent la directive Disallow particulièrement utile pour le SEO.

Par ailleurs, la directive Disallow permet de garder les sections d’un site web privées et contribue à la prévention de la surcharge des serveurs. Elle permet aussi d’empêcher certaines ressources comme les images ou les vidéos d’apparaître dans les résultats de recherche.

1.3.2. La directive Disallow empêche-t-elle l’indexation d’une page ?

La directive Disallow n’empêche pas l’indexation d’une page, elle empêche plutôt son exploration.

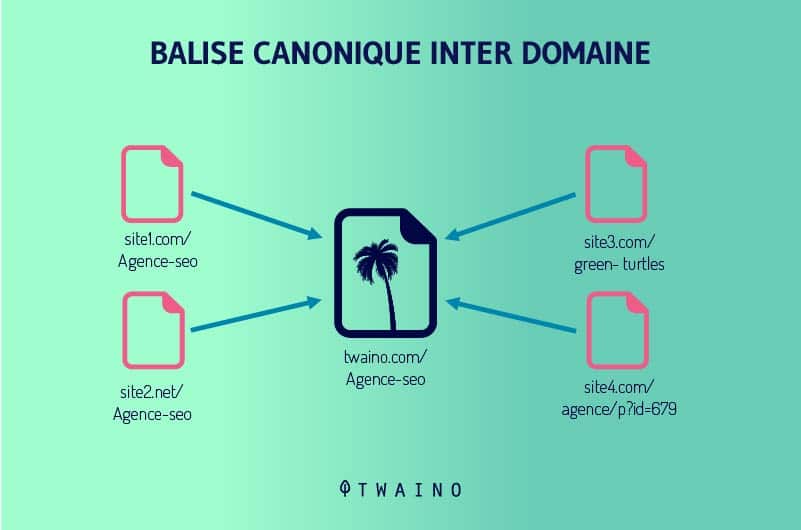

Par conséquent, une URL bloquée avec le Disallow peut apparaître dans les résultats de recherche lorsque Google trouve le contenu pertinent pour une requête. Elle peut être aussi classée lorsqu’il y a des backlinks et des balises canoniques qui pointent vers elle.

Google ne pourra toutefois qu’afficher d’autres informations que l’URL de la page. Cette dernière apparaît ainsi à la place du titre. Pour la méta description, le moteur de recherche montre un message qui indique qu’elle est indisponible en raison d’un fichier robots.txt.

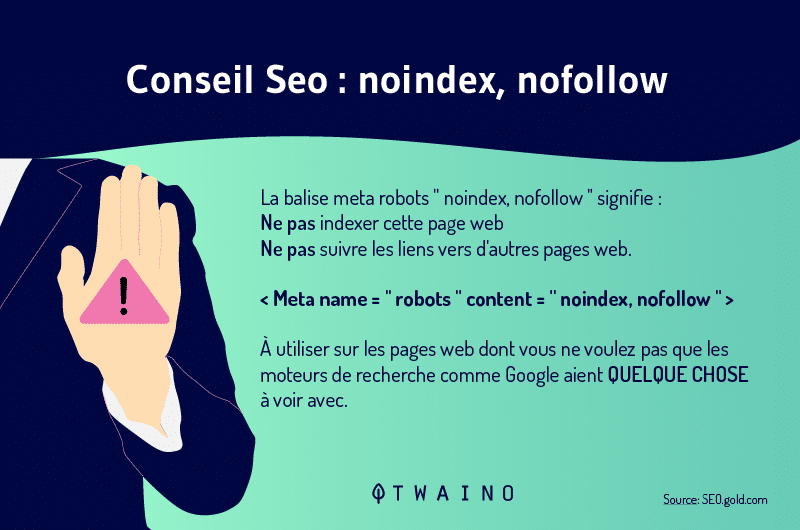

Pour empêcher les moteurs de recherche d’indexer une page web, on utilise la balise Noindex. Elle indique à ceux-ci de ne pas considérer la ressource en question dans les SERP.

Il faut aussi rappeler que les directives Disallow et Noindex peuvent être combinées. La balise Noindex vous permettra de mettre certaines de vos pages hors de l’index et éviter des problèmes comme les contenus dupliqués.

Notez que cette balise est différente de Nofollow, une balise qui s’emploie lorsqu’on souhaite indiquer à Google d’indexer la page, mais de ne pas suivre les liens de cette page.

Les balises Noindex et Nofollow peuvent être combinées lorsque vous ne souhaitez pas que la page en question soit indexée et ses liens ne doivent pas être suivis.

Chapitre 2 : Les formes d’application de Disallow et les bonnes pratiques pour éviter les erreurs

L’application de la directive Disallow est particulièrement simple et ne requiert que la maîtrise de la syntaxe et des caractères généraux. Ce chapitre aborde les formes d’application de la directive Disallow et les bonnes pratiques pour éviter des erreurs.

2.1. Utilisateurs des agent-users pour spécifier les moteurs de recherche

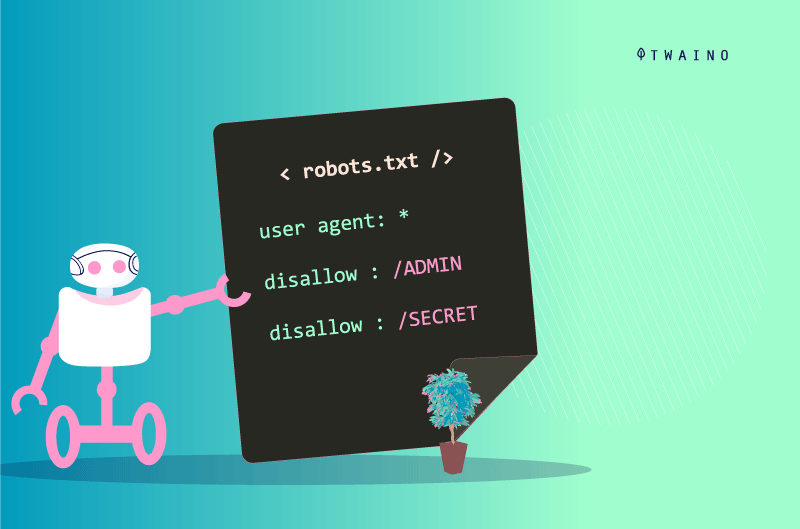

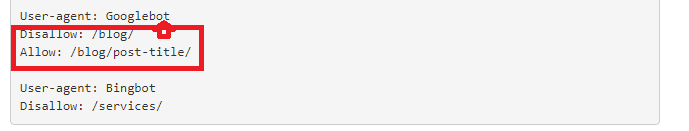

Pour appliquer la directive Disallow et les directives du fichier robots.txt, il faut commencer par mettre les user-agents pour lesquels le message est destiné. Il s’agit des bots qui vont considérer les instructions pour la directive.

Pour signifier qu’elles sont destinées pour tous les bots, on met le symbole (*) comme ci-dessous.

Mais lorsque s’adresser exclusivement aux Googlebots, on procède de la manière suivante :

- user-agent : Googlebots

Quand il s’agit de s’adresser seulement aux Bingbots, on écrit :

- user-agent : Bingbots

L’inscription d’un user-agent marque aussi le début des instructions pour un ensemble de directives. Ainsi, l’ensemble des directives comprises entre un premier user-agent et un deuxième user-agent sont traitées comme les directives du premier agent.

Par ailleurs, l’astérisque (*) représente l’ensemble des caractères possibles alors que le symbole de dollar ($) correspond à la manière dont les URL se terminent. Le dièse (#) quant à lui permet de débuter un commentaire.

Les commentaires sont seulement destinés aux humains et ne sont pas pris en charge par les robots. Ces trois symboles sont appelés des caractères génériques et la mauvaise gestion de ces caractères peut entraîner des problèmes à votre site.

2.2. Les formes différentes formes d’application de Disallow

La syntaxe de Disallow diffère selon la forme d’application.

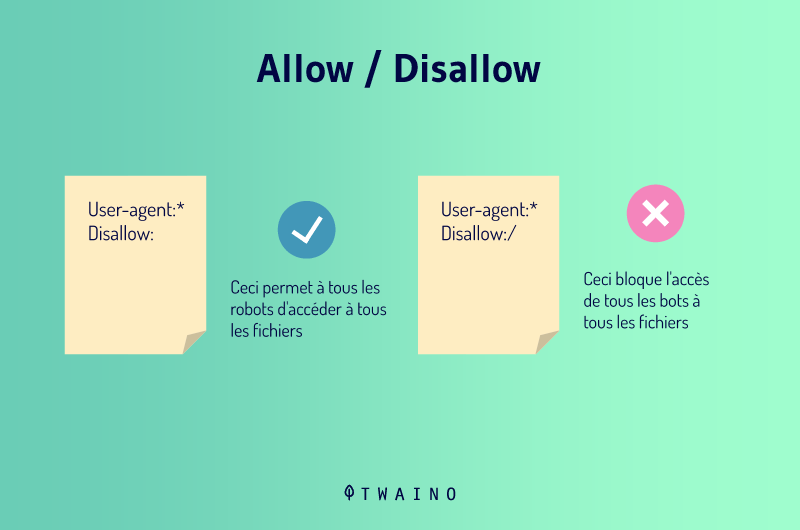

2.2.1. Disallow:

Lorsque vous mettez Disallow : sans rien ajouter après, vous indiquez aux crawlers qu’il n’y a pas de restriction. Cela signifie que tout ce qui se trouve sur votre page est bon à apprendre et les bots peuvent tout explorer.

Vous comprenez que cette syntaxe n’est pas utile puisque les moteurs de recherche vont explorer votre site de toute manière en son absence.

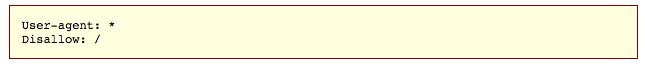

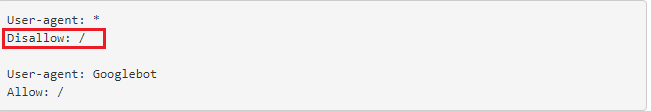

2.2.2. Disallow:/

Cette directive se lit Disallow all et permet d’interdire l’accès d’un site entier. Lorsque vous employez cette syntaxe, les robots des user-agents définis ne pourront explorer quoi que ce soit sur votre site. Cette syntaxe est utilisable lorsqu’un site est toujours en maintenance par exemple.

2.2.3. Disallow: blog

Ce code permet de bloquer l’accès à l’ensemble des pages dont l’URL commence par blog. Par conséquent, toutes les adresses commençant par https://www.votresite.com/blog seront simplement ignorées au cours de l’exploration.

2.2.4. Disallow:/*.pdf

Il est possible d’interdire l’exploration d’un type de fichier particulier et c’est ce que fait ce code avec les fichiers de type PDF. Les crawlers pourront ainsi ignorer les fichiers de ce type lors de l’exploration des URL suivants :

- https://www.votresite.com/contrat.pdf

- https://www.votresite.com/blog/documents.pdf

Il est également possible d’ajouter le symbole ($) à notre syntaxe pour indiquer aux bots que toutes les pages dont les URL se terminent par (.pdf) doivent être ignorées.

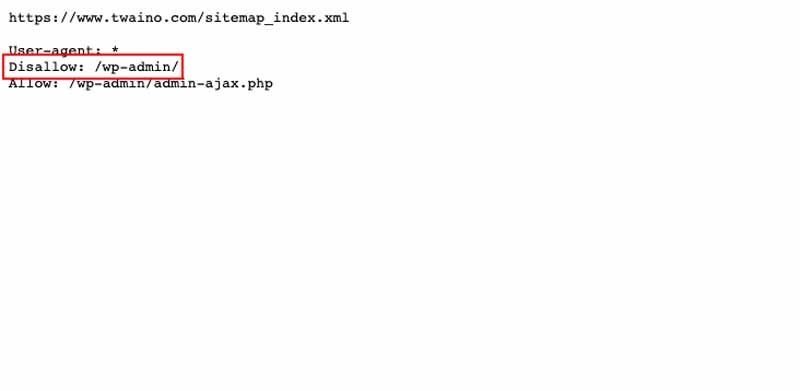

2.3. Disallow VS Allow

Les directives Disallow et Allow peuvent être utilisées à la fois dans un fichier robots.txt. Lorsqu’elles sont utilisées conjointement, l’usage des caractères génériques pourrait conduire à des instructions contradictoires.

De plus, les bots de Google exécutent souvent la directive la moins restrictive lorsque les instructions ne sont pas claires. Mais lorsque les directives Disallow et Allow correspondent à la même URL dans un fichier robots.txt, c’est l’instruction la plus longue qui l’emporte.

La longueur de l’instruction correspond au nombre de caractères de l’instruction en dehors de la directive. Il s’agit du chemin de la directive que les bots vont suivre. Pour les exemples ci-dessous, c’est la deuxième instruction qui sera exécutée.

- Disallow : /exemple* (9 caractères)

- Allow : /exemple.htm $ (13 caractères)

- Allow : /*pdf$(6 caractères)

2.4. Les meilleures pratiques pour éviter des erreurs

La mauvaise configuration du fichier robots.txt ou une mauvaise instruction de la directive Disallow peut freiner la performance de référencement de votre site. C’est pourquoi il est important d’être assez vigilant pour ne pas bloquer vos ressources par erreur.

D’autre part, vous ne devez pas bloquer les données sensibles seulement à l’aide de la directive Disallow. Comme mentionné précédemment, une page bloquée peut toujours apparaître dans les résultats de recherche et devenir publique.

De plus, les bots malveillants qui ne suivent pas les directives du fichier robots.txt peuvent explorer les pages qui sont censées être protégées à l’aide de Disallow. Le fichier robots.txt étant public, tout le monde peut le consulter et découvrir ce que vous essayez de cacher.

En ce qui concerne les user-agents, il est nécessaire de savoir les utiliser afin d’être précis dans l’enregistrement des instructions des différentes directives. Gardez à l’esprit qu’un moteur de recherche peut avoir plusieurs robots lorsque vous définissez les agents.

À titre d’exemple, Google utilise Googlebot pour la recherche organique, mais Googlebot-Image pour la recherche d’image.

Chapitres 3 : Autres questions posées sur la directive Disallow

Nous parcourons dans ce chapitre les questions qui sont régulièrement posées dans le cadre de la directive Disallow.

3.1. Qu’est-ce qu’un robots.txt ?

Un fichier robots.txt donne des directives aux moteurs de recherche quant à vos préférences d’exploration. Ce fichier est sensible dans l’univers du référencement et une petite erreur peut compromettre un site entier.

Mais lorsqu’il est utilisé à bon escient, il envoie de bons signaux à Google et contribue au référencement de votre site. Pour modifier un fichier robots.txt, vous n’aurez qu’à vous connecter à votre serveur par un client FTP et apporter ensuite les modifications.

Si vous n’arrivez pas à établir la connexion, vous pouvez contacter votre hébergeur. Par contre, si vous devez créer un nouveau fichier robots.txt, il suffit de le faire à partir d’un éditeur de texte brut.

Dans ce cas, assurez-vous de supprimer l’ancien si vous en avez déjà sur votre site. Gardez-vous d’utiliser un éditeur de texte comme Word, il peut introduire un autre code à votre texte.

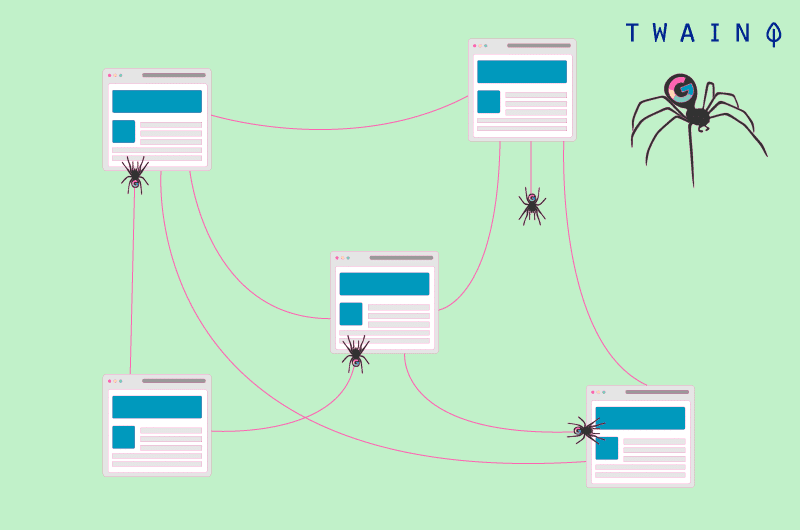

3.2. En quoi consiste l’exploration des robots ?

Encore appelée crawling, l’exploration des pages web est un processus par lequel les moteurs de recherche envoient des robots (araignées) pour examiner le contenu de chaque URL.

Ces robots se déplacent de page en page pour trouver de nouvelles URL ou de nouveaux contenus. C’est cette première étape qui permet aux moteurs de recherche de découvrir votre contenu pour programmer son indexation.

Le fichier robot intervient à cette étape et guide les bots selon vos préférences. L’exploration est distincte de l’indexation, car cette dernière consiste à stocker et à organiser les contenus trouvés pendant l’exploration.

3.3. Quelles sont les pages qu’on peut bloquer à l’aide de la directive Disallow ?

Les moteurs de recherche n’ont pas établi une règle universelle en ce qui concerne les pages à bloquer. L’emploi de la directive Disallow est donc propre à chaque site et dépend du jugement de son webmaster.

Cependant, cette directive peut aider à indiquer aux araignées de ne pas explorer les pages en cours de test. On peut aussi interdire l’accès de certaines pages comme celles de remerciement.

Lorsque vous travaillez aussi par exemple sur site multilingue, vous pourrez bloquer par exemple la version anglaise si elle n’est pas prête et empêcher les robots de l’explorer.

En ce qui concerne la page de remerciement, elle est généralement destinée aux nouveaux prospects. Ces pages peuvent quand même dépenser les budgets d’exploration et figurer dans les résultats de recherche.

Lorsqu’elle apparaît dans les résultats de recherche, la page de remerciement est accessible à tout le monde et les internautes peuvent y accéder sans suivre le processus de capture de prospect.

Mais en bloquant la page de remerciement, vous vous assurez que les prospects qualifiés pourront y accéder. Dans ce cas, la directive Disallow seule ne suffira pas puisqu’elle n’empêche pas l’indexation de l’URL en question.

Cela dit, la page en question peut toujours apparaître sur les SERP. Il est donc conseillé de combiner la directive DIsallow avec la directive Noindex. Ainsi, les robots explorateurs ne pourront ni visiter ni indexer la page.

Conclusion

Somme toute, il existe une multitude d’actions pour améliorer le classement d’un site. La directive Disallow est l’une de ces actions qui vous donnent un réel avantage en termes de référencement.

Elle permet d’interdire aux araignées des moteurs de recherche d’explorer les contenus qui ne sont pas utiles afin d’optimiser le budget d’exploration d’un site web.

De cette manière, elle permet aux robots-araignées d’utiliser ce budget de la meilleure façon pour augmenter la visibilité de vos contenus dans les résultats de recherche.

L’utilisation de la directive Disallow peut donc avoir un impact significatif lorsque les instructions sont bien données. Cependant, elle peut briser un site entier lorsque les instructions sont erronées.