Algorithm Change est une mise à jour de l’algorithme de Google qui se caractérise par l’ajout d’un nouveau signal de classement. Ces mises à jour permettent d’affiner des résultats de recherche et de fournir des réponses pertinentes aux requêtes des internautes. Bien que Google mette à jour régulièrement son algorithme, algorithm change correspond aux changements majeurs qui impact les résultats de recherche.

Les premiers résultats de recherche obtiennent en grande partie les clics organiques. Et selon une étude, les 05 premiers résultats représentent 67,60 % de tous les clics.

Pour cela, la plupart des propriétaires de site web souhaitent classer leur site dans les premiers résultats. Cependant, cela reste difficile, car L’algorithme de recherche de Google utilise plus de 200 facteurs pour classer les sites Web.

De plus, l’univers de référencement est constamment en changement et Google met fréquemment à jour son algorithme afin d’améliorer l’expérience de ses utilisateurs et de s’adapter aux nouvelles tendances.

Les mises à jour les plus importantes encore appelées algorithm change consistent à l’ajout d’un nouveau signal de classement. Ces modifications sont connues et Google communique souvent à leurs propos.

J’ai compilé ces plus grandes mises à jour de l’algorithme de Google que je vais vous présenter dans cet article.

Nous découvrons également comment se préparer pour les prochaines mises à jour du moteur de recherche afin que ces dernières n’affectent pas votre site.

Suivez donc !

Chapitre 1 : Qu’est-ce que l’algorithme change ?

Google s’attèle tous les jours à améliorer ses méthodes de traitement des requêtes pour offrir de meilleurs résultats à ses utilisateurs. Ces efforts se manifestent par les mises à jour majeures que le moteur de recherche apporte à son algorithme.

Ce chapitre est consacré à la définition de Algorithm change et les raisons pour lesquelles vous devez vous intéresser aux différentes mises à jour.

1.1. Définition Algorithm change

Selon Hubspot, le nombre de requêtes que Google traite chaque seconde est estimé à 63 000. Avec de tels volumes de requête, le moteur de recherche peut avoir des difficultés à offrir de réponse exacte à chaque requête.

C’est pour gérer ces difficultés que la firme américaine a créé un algorithme qui détermine quels sites web sont pertinents et peuvent être affichés pour un mot-clé ou une expression particulière.

Google apporte régulièrement des mises à jour à son système afin de corriger les failles de son algorithme et de contrecarrer les sites qui tentent de le manipuler. La plupart de ces mises à jour sont de minces modifications qui passent généralement inaperçues.

Cependant, le moteur de recherche propose parfois des mises à jour majeures qui ont un effet significatif sur les résultats de Google.

Ces changements subtils que Google apporte à son algorithme constituent l’Algorithm Change. Ils se caractérisent le plus souvent par l’ajout d’un nouveau signal à l’algorithme principal.

1.2. Pourquoi faut-il s’intéresser à l’Algorithm Change ?

Les mises à jour majeures de l’algorithme de Google peuvent aider les entreprises qui génèrent de revenus à partir du trafic organique et de la conversion à augmenter leurs revenus.

De la même manière, elles peuvent nuire à ces entreprises qui s’appuient sur le marketing numérique. En effet, les mises à jour sont avantageuses lorsqu’elles améliorent les performances d’un site.

Mais lorsque les nouvelles modifications pénalisent certaines pratiques que vous utilisiez autrefois sur votre site, il est évident que vous allez perdre du trafic organique et les conversions.

Le fait de garder un œil sur les mises à jour majeures permet de revoir votre stratégie de référencement afin de maintenir votre place dans les SERP.

Il est tout aussi important de comprendre les principales mises à jour précédentes, cela permet de comprendre les pratiques qui sont obsolètes et dont vous ne vous rendez pas compte.

Dans les chapitres suivants, nous découvrons les modifications majeures de l’algorithme de Google.

Chapitre 2 : La mise à jour Google Panda en 2011

Google Panda est l’une des modifications les plus importantes et les plus célèbres de l’algorithme de Google. Nous découvrons dans ce chapitre en quoi consiste cette mise à jour et comment s’y adapter.

2.1. Qu’est-ce que Google Panda ?

Avant Panda, les webmasters et les référenceurs utilisent toutes sortes de moyens pour classer un site dans les SERP.

Par conséquent, les meilleurs sites ne gagnent pas toujours dans les classements de recherche et les contenus de mauvaise qualité ont commencé par apparaître dans les résultats de recherche.

C’est dans le but de corriger cet état de chose et d’offrir des contenus de qualité à ses utilisateurs que Google a procédé à cette importante modification de son algorithme.

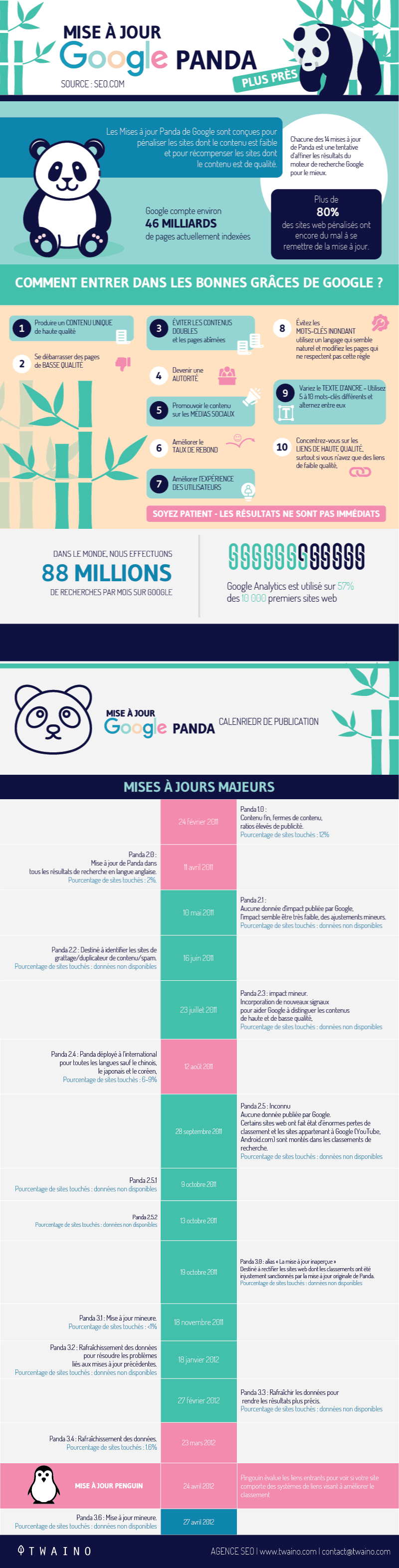

Cette mise à jour a commencé aux États-Unis en février 2011 et ensuite dans les autres pays à partir du 12 août de la même année. Depuis son introduction, Panda a fait l’objet de fréquentes modifications.

À travers Panda, Google cherche à améliorer l’expérience de ses utilisateurs en débarrassant les résultats de recherche des pages spams.

Il s’agit de punir les sites qui proposent des contenus de qualité médiocre et de récompenser ceux qui offrent des contenus frais ainsi que d’excellentes qualités.

Autrement dit, Google Panda se comporte comme un filtre qui retient les sites de grande qualité et repousse les sites de faible qualité à l’arrière des SERP.

2.2. Comment Google Panda a-t-il affecté les sites et quels sont les facteurs qui rendent un site vulnérable à cette mise à jour ?

Le déploiement de Google Panda a affecté considérablement de nombreux sites et on estime qu’il a touché plus de 12 % des sites sur le marché américain seul.

De manière générale, les modifications apportées au référencement par la mise à jour Panda ont affecté plus de 80 % des sites.

Avec Google Panda, il est évident pour les webmasters que seuls les contenus qui apportent de la valeur aux internautes peuvent avoir de visibilité dans les résultats de recherche. Parmi les facteurs qui rendent un site vulnérable, on retrouve :

- Pas assez de contenu unique ;

- Peu ou pas de backlinks de haute qualité ;

- Temps de rétention des visiteurs court (temps sur la page et temps sur le site) ;

- Un pourcentage élevé de contenu dupliqué ;

- Un taux de rebond élevé ;

- Un pourcentage élevé de pages dont le contenu n’est pratiquement pas unique ou original ;

- Un nombre élevé de publicités non pertinentes ;

- Le contenu de la page (et la balise de titre de la page) ne correspond pas aux requêtes de recherche pour lesquelles la page est performante ;

- Un nombre anormalement élevé de répétitions du même mot sur une page.

Lorsque Google Panda identifie un de ces facteurs sur votre site, cela peut affecter non seulement la page concernée, mais le site dans son ensemble.

2.3. Comment savoir Google Panda affecte un site et comment s’en sortir ?

Pour savoir si votre site est affecté, consultez fréquemment la performance de votre site. Si vos pages baissent brusquement dans les SERP d’un jour à un autre, il est probable que Panda pénalise votre site.

La solution pratique pour remédier à cela est de corriger ou de supprimer simplement les contenus de mauvaise qualité. Pour cela, procédez à l’évaluation des contenus de votre site afin de trouver les pages affectées par Panda.

Créez ensuite des contenus qui respectent les directives de Google pour éviter de subir des baisses de classement pour les prochaines mises à jour.

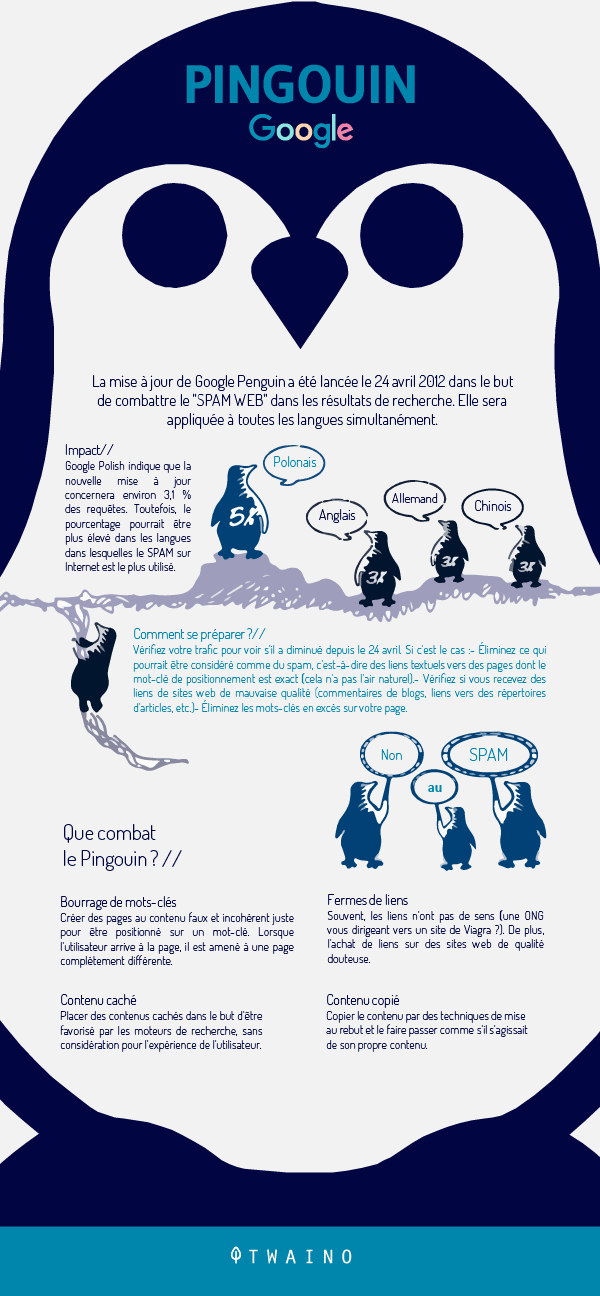

Chapitre 3 : La mise à jour Google Penguin en 2012

Nous aborderons dans ce chapitre la mise à jour Google Penguin contre les mauvais liens retour.

3.1. Qu’est-ce que Google Penguin ?

Google Penguin est une importante mise à jour de Google déployée en 2012 pour renforcer Panda. Après le déploiement de Panda pour s’attaquer aux sites de mauvaise qualité, Google a remarqué qu’il y avait encore beaucoup de spams dans les SERP.

Le moteur de recherche est donc revenu avec Penguin pour s’occuper des sites de spams restants. L’objectif de Penguin est de réduire le web spam et de sanctionner les sites qui manipulent les classements par des techniques de création de liens « chapeau noir ».

Cette mise à jour s’intéresse principalement aux liens entrants d’un site. Après plusieurs petites modifications, Penguin est devenu en 2016, une partie de l’algorithme principal de Google.

Cela dit, il s’exécute en même temps que l’algorithme de base pour évaluer les sites Web et les liens en temps réel.

3.2. Quel est l’impact de Google Penguin ?

Lorsque Google Penguin remarque que votre site fait l’objet de spams ou de manipulations, les pages concernées vont perdre de classement dans les SERP. Cela concerne surtout les sites qui obtiennent des liens de manière non naturelle notamment :

- L’utilisation de schémas de liens impliquant des liens non naturels et des échanges de liens excessifs ;

- Annonces textuelles frauduleuses ;

- Les backlinks de mauvaise qualité ;

- L’utilisation excessive de liens avec un texte d’ancrage optimisé.

Le plus souvent, le déclassement n’affecte pas l’ensemble d’un domaine. Il affecte seulement les mots-clés pour lesquels le site a fait du spamming ou sur-optimiser ses pages.

L’impact des sanctions peut aussi passer d’un domaine à un autre et il ne sert à rien de rediriger l’ancien domaine vers un nouveau pour échapper aux sanctions.

3.3. Que faire lorsque par Google Penguin sanctionne un site ?

Les sites qui augmentent artificiellement leur classement en achetant des liens à des fermes de liens ou d’autres sites de spams doivent se débarrasser de ces backlinks acquis de façon illicite.

Pour y arriver, ces derniers doivent renier ces liens à l’aide de l’outil de désaveu. Le désaveu de liens consiste à soumettre à Google dans un fichier, les URL qu’il doit ignorer afin qu’ils n’aient aucun effet sur votre site.

Cependant, si vous commettez l’erreur de renier des liens d’autorité, Google va également les ignorer et ils ne contribueront plus à votre classement.

C’est pourquoi il est conseillé de surveiller votre profil de backlinks et d’analyser chacun des liens qui entrent sur votre site. L’analyse de ces liens vous permettra de déterminer ceux qui sont de mauvaise qualité ou sont des spams.

Chapitre 4 : Algorithme change – Les mises à jour Google Hummingbird, Mobilegeddon, Fred et les interstitiels intrusifs

Nous découvrons dans ce chapitre quatre mises à jour majeures de Google notamment :

- Hummingbird ;

- Mobilegeddon ;

- Fred ;

- Les interstitiels intrusifs

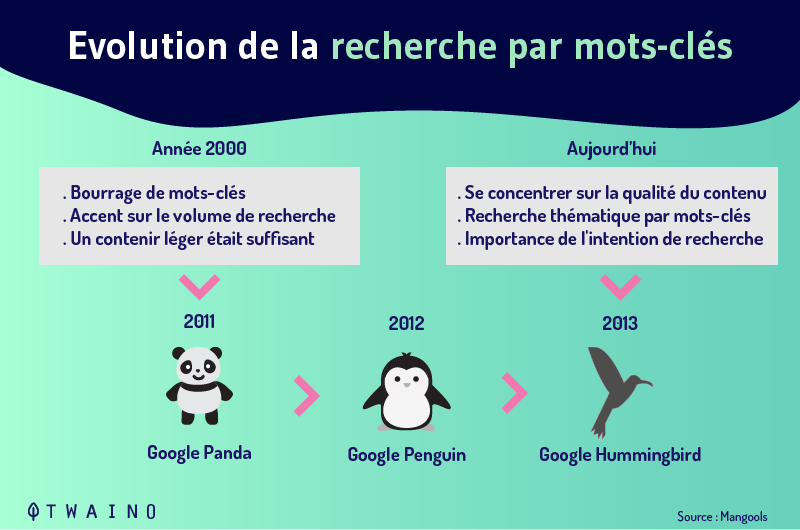

4.1. La mise à jour Google Hummingbird

Le déploiement de la mise à jour Hummingbird en 2013 a considérablement changé les anciennes habitudes de recherche. Autrefois, nous tapions des mots-clés dans le moteur de recherche et ce dernier nous fournissait des liens contenant ces mots spécifiques.

Google Hummingbird a rendu l’algorithme de recherche suffisamment intelligent pour prendre désormais en compte le contexte dans lequel les internautes formulent les requêtes.

En termes simples, cette mise à jour est consacrée à l’intention de recherche des internautes. Google est ainsi capable de comprendre le sens d’une phrase et de renvoyer des résultats plus précis aux requêtes de recherche complexes.

D’un point de vue technique, le moteur de recherche a intégré à son algorithme la recherche sémantique. Cette dernière prend en compte un certain nombre d’éléments à savoir :

- La recherche contextuelle ;

- L’emplacement de la recherche ;

- L’intention de la requête ;

- L’utilisation de synonymes ;

- La syntaxe ;

- Les requêtes communes et inhabituelles ;

- Les requêtes conceptuelles.

Google utilise également une base de connaissance appelée Knowledge graph. Il s’agit d’un ensemble de connaissances structurées obtenues auprès de spécialistes du secteur que le moteur de recherche associe à des objets spécifiques.

Pour tirer parti de cette mise à jour, les sites web doivent créer régulièrement des contenus pertinents pour un public spécifique. L’idée est de créer un grand nombre d’articles originaux sur les sujets de votre zone d’expertise.

Il est aussi conseillé d’opter pour l’utilisation des mots-clés à long traîne afin d’enrichir le champ sémantique de vos contenus. Vous pouvez également surfer sur les sites d’actualités de votre secteur et créer des contenus créatifs à partir des sujets tendances.

4.2. La mise à jour Mobilegeddon

Historiquement, la plupart des recherches en ligne se faisaient sur des ordinateurs de bureau.

Nombre des sites optimisent donc leurs sites pour les ordinateurs de bureau et n’ont pas de version mobile, donc pas besoin d’optimiser leurs sites pour le mobile.

Mais l’essor des smartphones a fait basculer la recherche en ligne en faveur des appareils mobiles. D’après une étude, 80 % des internautes ont utilisé un appareil mobile pour faire des recherches sur le web en 2019.

Pour répondre au besoin croissant de la recherche mobile et maintenir sa place de leader, Google a effectué une importante mise à jour en 2015 connue sous le nom de Mobilegeddon.

Cette mise à jour donne la priorité aux appareils mobiles et la convivialité mobile est devenue un facteur de classement.

Ainsi, lorsque les utilisateurs effectuent une recherche sur leurs smartphones, ce sont les pages adaptées aux mobiles qui apparaissent dans les SERP. Autrement dit, Mobilegeddon n’affecte que le classement de la recherche sur mobile.

Pour aider les webmasters à tester la convivialité de leur site sur le web, Google a mis à leur disposition des outils comme Google Mobile-Friendly Test. Cet outil permet de vérifier l’adaptabilité d’un site aux mobiles.

Il est aussi possible de vérifier directement dans Google Search Console/Mobile Usability à quel point votre site est adapté aux mobiles en termes d’optimisation.

L’outil PageSpeed vous permettra également de vérifier la vitesse de chargement des ressources de votre site. Plus vos pages se chargent lentement, plus elles dégradent l’UX.

4.3. Mise à jour Fred en 2017

À la surprise de tous les référenceurs et les webmasters, certains sites web ont connu une baisse massive de trafic organique en mars 2017. Il s’agissait d’une mise à jour de l’algorithme de Google qui a provoqué une baisse de trafic allant jusqu’à 90 %.

Au départ, Google n’avait pas annoncé le déploiement d’une mise à jour, ce qui a provoqué une panique au sein de la communauté des webmasters et des référenceurs. Le nom attribué à cette mise à jour n’est d’ailleurs pas un nom singulier.

Selon un expert en analyse des sites web de Google, le nom « Fred » fait référence à toutes les modifications pour lesquelles Google ne nous donne pas de nom.

Dans la suite de cet article, toute référence à Fred s’inscrit dans le contexte de la mise à jour majeure du 7 mars qui a beaucoup impacté les sites web.

Bien que l’objectif de cette mise à jour majeure soit resté longtemps vague, de nombreux référenceurs pensent que le principal facteur derrière Fred était la qualité.

Il s’agit de supprimer ce que Google considérait comme des résultats de faible qualité, à savoir des sites aux contenus minces qui diffusaient des publicités agressives.

La mise à jour Fred concerne surtout les sites qui priorisent la monétisation à l’expérience des utilisateurs.

Les sites les plus touchés par cette mise à jour sont ceux qui créent des contenus uniquement pour améliorer leurs classements et non pour satisfaire l’intention de recherche.

Ceci va à l’encontre de la politique de Google qui est de proposer un contenu de qualité axé sur les besoins des utilisateurs. Aujourd’hui, la plupart des sites s’inscrivent dans cette dynamique et créent des contenus qui apportent réellement une valeur unique au lecteur.

Ils se servent des outils SEO pour analyser les types de contenus qui sont susceptibles d’intéresser les utilisateurs et de générer du trafic.

4.4. La mise à jour des Interstitiels intrusifs

Étant donné que la recherche mobile prend le dessus, Google cherche à améliorer l’expérience des utilisateurs sur les appareils mobiles. C’est dans cette optique que le moteur de recherche a déployé la mise à jour « interstitiels intrusifs ».

Elle consiste à pénaliser les pages dont les ressources ne sont pas directement accessibles aux internautes à partir des pages de recherche. Il s’agit des publicités, popups ou des bannières qui superposent le contenu d’une page.

Il faut reconnaître que ces publicités ruinent l’expérience des utilisateurs sur mobiles, car ces derniers n’arrivent toujours pas à voir le bouton de la fermeture pour revenir au contenu.

C’est pourquoi Google a lancé une guerre contre les interstitiels intrusifs. Il rétrograde les sites coupables de cette pratique dans les SERP. Google ne considère plus ces sites comme adaptés aux mobiles.

Cependant, ce ne sont pas tous les interstitiels que Google pénalise. Il s’agit plutôt des interstitiels qui ont tendance à masquer complètement le contenu d’une page et entraîne une expérience frustrante.

Mais la pénalité de Google ne concerne pas les interstitiels de vérification d’âge ou les Cookies. Rappelons aussi que la pénalité des interstitiels ne concerne que la transition entre les résultats de recherche et la page en question.

Par conséquent, les interstitiels de sortir ne sont pas concernés ainsi que les interstitiels de page en page.

Chapitre 5 : Algorithme change – La mise à jour RankBain

RankBain est une mise à jour qui a apporté un grand changement dans la manière dont Google traite les résultats de recherche. Ce chapitre est consacré au fonctionnement de RankBain et comment optimiser votre site pour ce dernier.

5.1. Qu’est-ce que le RankBain ?

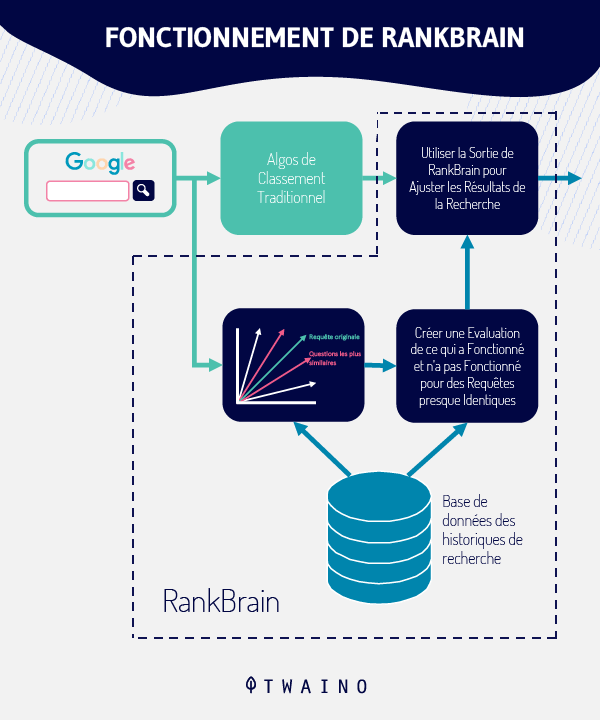

Entré en service depuis 2015, Le RankBain constitue désormais une partie constitutive de l’algorithme principal de Google. Cette mise à jour majeure s’inspire de Hummingbird pour comprendre l’intention de requête de recherche.

À la différence, RankBain utilise l’apprentissage automatique et l’intelligence artificielle (IA) pour apprendre à connaître les internautes et la manière dont ces derniers réagissent aux résultats de recherche.

En effet, l’IA permet aux machines de comprendre et d’agir comme des humains lorsqu’il s’agit de prendre une décision quant à une tâche qui leur est confiée.

Pour ce qui est de l’apprentissage automatique, il s’agit de la capacité des machines à apprendre par elles-mêmes à partir des données qu’elles reçoivent.

En clair, RankBain permet à l’algorithme principal de Google de traiter les résultats de recherche comme un humain et d’apprendre à connaître les utilisateurs afin de comprendre leurs préoccupations.

Au départ, il ne traite que 15 % des requêtes effectuées chaque jour, notamment celles que Google n’avait jamais enregistrées auparavant. Plus tard, il est étendu à d’autres recherches et intervient aujourd’hui dans la plupart des requêtes saisies sur le moteur de recherche.

Non seulement RankBain comprend les nouveaux termes de recherche, mais il est capable de modifier l’algorithme de son propre chef afin de s’adapter.

Pour l’anecdote, Google a demandé à un groupe d’ingénieurs et à RankBain de déterminer la meilleure page pour une requête spécifique. Contre toute attente, le programme a surpassé les ingénieurs de la firme américaine de 10 %.

5.2. Qu’est-ce qui rend RankBain si précis et comment fonctionne-t-il ?

Il utilise les signaux de l’expérience utilisateur afin de montrer à un visiteur les résultats qu’il est susceptible d’aimer. Plus les gens vont aimer une page parmi les résultats de recherche, plus cette page monte dans le classement.

Mais lorsque les internautes n’aiment pas une page, cette dernière sera remplacée dans les résultats de recherche et perdra sa place.

RankBain arrive à déterminer si les gens adorent une page en examinant certains éléments comme :

- Le taux de clics organiques : les personnes qui cliquent à partir des résultats de recherche ;

- Temps de séjour : la durée que passe un visiteur sur un site ;

- Taux de rebond : le pourcentage des personnes qui quittent rapidement le site.

5.3. Comment optimiser un site pour le RankBain ?

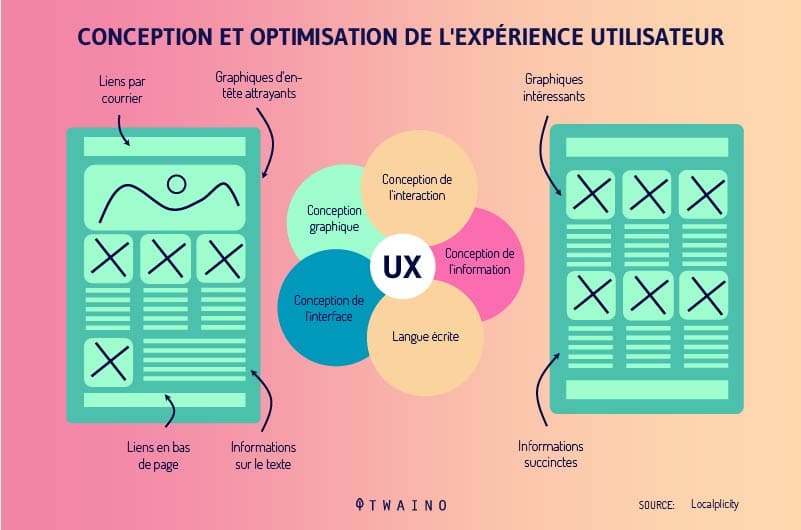

Comme RankBain utilise les signaux UX dans le classement des pages, il est important d’améliorer l’expérience des utilisateurs sur l’ensemble de votre site.

Cela consiste à créer des contenus exceptionnels qui sont accessibles et qui profitent réellement aux utilisateurs. De plus, les pages doivent se charger très rapidement et votre interface doit être belle et facilement navigable.

Plus vos contenus sont utiles et votre site facile à naviguer, plus les visiteurs passeront de temps sur votre site. Vous réduisez ainsi le taux de rebond, ce qui est avantageux pour votre site.

De cette manière, vous signalez au RankBain que les gens adorent votre site dans votre secteur et vous augmentez vos chances de remonter dans les SERP.

Chapitre 6 : Algorithm change – Les mises à jour Google BERT et Core Web Vitals

Nous aborderons dans ce chapitre les mises à jour BERT et Core Web Vitals.

6.1. La mise à jour Google BERT

6.1.1. Qu’est-ce que Google BERT ?

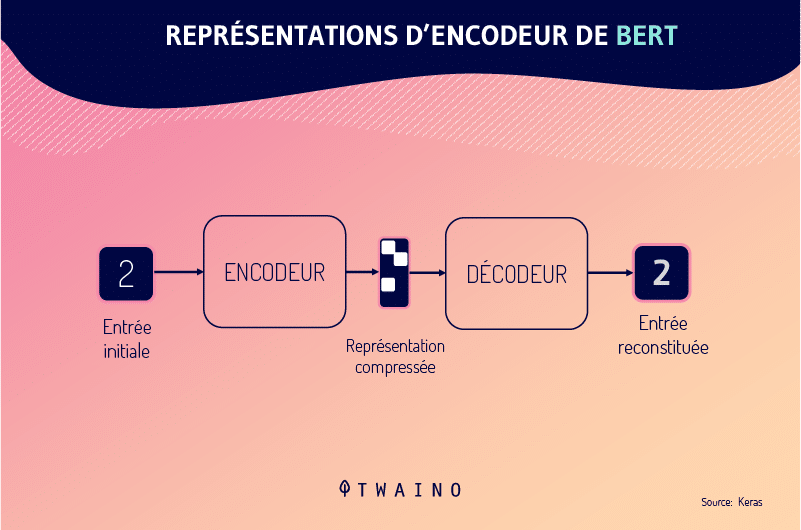

Cette mise à jour est un modèle de traitement du langage naturel (NLP) pré-entraîné et open-source développé par Google. Il est capable d’interpréter l’intention et le contexte d’une requête de recherche en se basant sur la relation entre l’ensemble des termes de recherche.

Le modèle BERT tente de comprendre le contexte d’un mot en fonction de tous les autres mots qui l’entourent, ce qui rend les résultats de recherche des requêtes plus précis.

À l’instar de RankBain, BERT est un algorithme d’apprentissage automatique qui apprend au fur et à mesure qu’ils rencontrent de nouvelles informations.

Les capacités de compréhension du langage de BERT donneront aux internautes de meilleurs résultats qui satisferont leur intention réelle.

En effet, l’intention de recherche repose plus sur les intérêts des utilisateurs . Ces derniers expriment généralement leurs intentions sous forme de requêtes dans les moteurs de recherche.

Mais il est toujours difficile aux moteurs de recherche comme Google d’interpréter l’intention souhaitée. À titre de preuve, Google estime que les internautes utilisent plusieurs termes (voire des phrases) pour une raison précise.

Ils craignent que les moteurs de recherche ne comprennent pas les requêtes composées d’un ou de très peu de termes. C’est pour combler cette lacune que Google a déployé la mise à jour Google BERT.

6.1.2. Recherche vocale Impact : Quel est l’impact Google BERT ?

Le modèle BERT s’applique aussi à la recherche vocale. Il comprend une fonction de traitement du langage qui prend en compte les différents accents des langues.

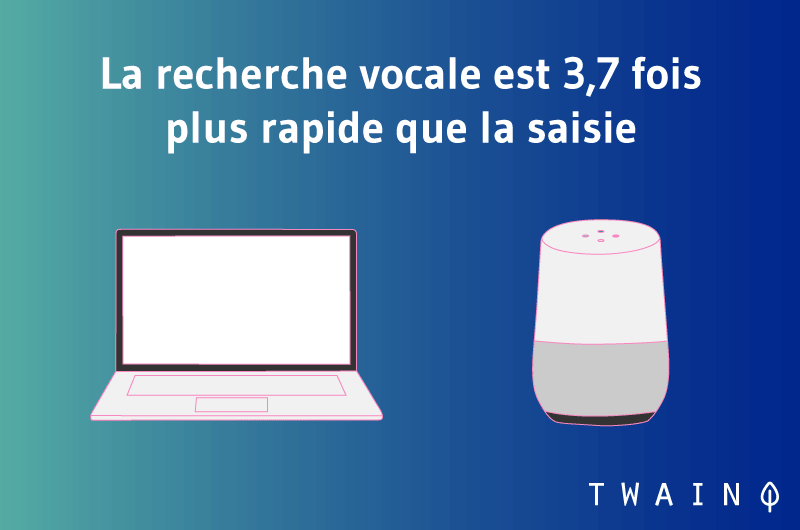

La recherche vocale est en plein essor et est sans aucun doute la prochaine grande nouveauté dans le monde du référencement. Selon une étude, 20 % des requêtes mobiles proviennent actuellement de la recherche vocale.

De plus, 72 % des personnes qui utilisent des dispositifs de recherche vocale affirment qu’ils font désormais partie de leurs habitudes quotidiennes. On peut en déduire que les gens utilisent la recherche vocale régulièrement.

Cela se justifie par le fait qu’elles donnent des résultats beaucoup plus rapides et sont beaucoup plus faciles.

En effet, la mise à jour BERT rend les résultats de recherche très précis. Depuis son déploiement, la reconnaissance vocale est précise à 95 % comparativement à 2013 selon Google.

La recherche vocale étant une partie si importante dans la recherche, il est indispensable pour les grandes entreprises et les petites entreprises locales d’optimiser leurs sites Web et leurs applications pour cela.

On estime que 58 % des personnes utilisent la recherche vocale pour se renseigner sur un commerce local.

Par ailleurs, l’optimisation pour la recherche vocale doit prendre en compte les raisons pour lesquelles les gens font des recherches vocales.

Une enquête publiée par un groupe de réflexion de Google suggère que, par le biais de la recherche vocale, les gens recherchent souvent des informations sur :

- Le mode d’emploi ;

- Les offres ;

- Les ventes ;

- Les événements à venir ;

- Le support client ;

- Les numéros de téléphone ;

- Etc.

6.2. La mise à jour Core Web Vitals (Août 2021)

Après trois mois de déploiement progressif, Google a maintenant confirmé la finalisation de cette mise à jour qui ajoutera Core Web Vitals comme facteur de classement.

Le moteur de recherche donne la priorité à l’expérience utilisateur avec les Core Web Vitals en mesurant les performances d’un site en fonction de l’expérience d’un visiteur lorsqu’il arrive sur une page.

La mise à jour de l’algorithme Core Web Vitals est conçue pour offrir aux visiteurs de tout site Web une expérience de page plus agréable et plus sûre que jamais.

L’expérience de la page n’est rien d’autre que l’ensemble des signaux qui mesurent la façon dont les utilisateurs perçoivent l’expérience d’interaction avec une page Web au-delà de sa valeur purement informative.

Les signaux d’expérience de page de Google comprennent :

- HTTPS ;

- L’absence d’interstitiels intrusifs ;

- La convivialité mobile.

Ces signaux combinés joueront désormais un rôle essentiel dans le classement des sites Web.

6.3. Comment se préparer aux prochaines modifications de l’algorithme de Google ?

Pour mieux se préparer aux prochaines mises à jour afin de ne pas perdre de classement du jour au lendemain, vous devez tirer leçon des changements précédents que Google avait apportés à l’algorithme de Google.

Ces mises à jour précédentes vous permettront de maîtriser les principes de bases de l’algorithme. Le moteur de recherche cherche surtout à fournir à ses utilisateurs plus rapidement des réponses pertinentes à leurs requêtes.

Il est évident que Google va continuer à œuvrer dans ce sens afin de rendre l’expérience de ses utilisateurs encore plus meilleure.

Pour rester en phase avec les prochaines mises à jour, vous devez donc continuer à créer des contenus de haute qualité que les visiteurs adorent vraiment.

C’est aussi important de réduire le temps de chargement de vos pages web, de rendre votre site convivial tout en évitant les publicités agressives. Autrement, les utilisateurs seront déçus et les signaux UX de votre site seront médiocres.

J’en veux pour preuve une étude de Google qui estime que lorsque le temps de chargement d’une page augmente de 10 secondes, il fort probable que les visiteurs rebondissent.

Par ailleurs, il faut surveiller régulièrement la performance de votre site afin d’identifier un changement subit dans les mesures de votre site. Cela indique probablement qu’une mise à jour affecte votre site.

Dès lors, commencerez à chercher les raisons pour lesquelles vous perdez de classement afin d’apporter des modifications conformes à l’algorithme de Google.

Chapitre 7 : Algorithm change – Les questions fréquentes sur les mises à jour de Google

Ce chapitre est consacré aux questions fréquentes sur les mises à jour de l’algorithme de Google.

7.1. Combien de mise à jour Google apporte-t-il à son algorithme par an ?

Le géant américain apporte régulièrement des modifications à son algorithme de base. Même s’il n’existe pas un nombre exact, Google met à jour son algorithme entre 500 à quelques milliers de fois chaque année selon Neil Patel.

Notez que la plupart de ces modifications sont mineures et n’affectent pas aussitôt les classements. Cependant, ces mises à jour qui semblent inoffensives peuvent avoir un impact sur la performance de votre site à long terme.

Par contre, les mises à jour de grandes ampleurs comme celles que nous avons présentées dans cet article affectent plus rapidement les sites et les résultats de recherche.

7.2. En quoi l’algorithme de Google est-il important ?

L’algorithme de Google est chargé du traitement des résultats et les différentes modifications peuvent affecter directement votre site. Lorsque votre site ne respecte pas les directives de Google, il peut vous pénaliser et vous allez perdre votre place dans les SERP.

Mais lorsque votre site est au top, l’algorithme de Google vous récompense dans les SERP et vous pouvez avoir des prospects qualifiés à partir de la recherche organique.

7.3. Quelles sont les modifications importantes de l’algorithme de Google ?

7.3.1. La mise à jour Panda en 2011

La mise à jour Panda a été lancée pour la première fois en 2011, mais elle a connu plusieurs mises à jour jusqu’en 2016 où elle a été ajoutée à l’algorithme de classement.

Panda cible les spams et les contenus faibles qui n’aident pas les utilisateurs. Il pénalise également les contenus minces, les contenus dupliqués et les contenus avec trop d’annonces.

7.3.2. La mise à jour Penguin — 2012

Environ un an après la mise à jour Panda, la mise à jour Penguin a été publiée, mettant une fois encore les contenus de qualité de l’avant. Cette mise à jour cible les spams en examinant les liens retour.

Elle récompense ceux qui ont des backlinks organiques de qualité et pénalise ceux qui ont des profils de backlinks non naturels.

7.3.3. La mise à jour Hummingbird — 2013

La mise à jour Hummingbird a été une modification de l’algorithme de Google pour le rendre plus intelligent dans l’interprétation de la recherche sémantique.

Elle a été conçue pour aider Google à comprendre l’intention ainsi que le contexte. Cela a forcé les professionnels de référencement à s’orienter vers des mots-clés à longue queue.

Cela a également encouragé les marketeurs à créer des contenus basés sur l’intention et les besoins des utilisateurs plutôt que sur un seul mot-clé.

7.3.4. La mise à jour mobile — 2015

La mise à jour mobile a forcé tous les sites à s’adapter aux mobiles sous peine d’être pénalisés dans les SERP pour la recherche mobile. Elle concerne tous les secteurs et chaque site doit avoir une version mobile de son site web.

7.3.5. La mise à jour de RankBrain — 2015

Lorsque RankBrain a été mis en service, il a introduit l’intelligence artificielle et l’apprentissage automatique dans l’algorithme de Google.

Cette partie de l’algorithme a la capacité de surveiller le comportement des utilisateurs et les réponses aux requêtes pour en « apprendre » davantage sur l’intention et la valeur de certaines pages. Il s’agit désormais du 3e signal de classement le plus important de Google.

7.3.6. Les interstitiels mobiles — 2017

Cette mise à jour est une pénalité de référencement qui s’applique aux sites diffusant des annonces interstitielles qui masquent le contenu de la page.

Il ne s’agissait pas d’une pénalité générale pour tous les interstitiels. Elle se concentre seulement sur les interstitiels intrusifs sur mobile et les interstitiels qui nécessitent que le visiteur les rejette manuellement.

7.3.7. La mise à jour « Fred » de Google — 2017

Mise à jour non confirmée de l’algorithme, Fred a eu un important impact sur les résultats de requêtes. Certains sites ont connu des baisses de trafic de près de 90 %.

Les paramètres exacts de Fred n’ont jamais été confirmés par Google. Mais il semble qu’elle s’attaque aux sites qui privilégient l’affichage d’annonces et/ou de widgets de monétisation du trafic au détriment du contenu.

7.3.8. BERT – 2019

BERT est un schéma de traitement du langage naturel qui se repose sur un réseau neuronal. Elle permet de mieux comprendre le contexte complet d’une requête en examinant tous les mots de la recherche.

Tout comme Hummingbird, elle cherche à améliorer l’expérience des utilisateurs et permet d’obtenir des résultats pertinents plus rapidement.

7.3.9. Core Web Vitals

Les Core Web Vitals sont un ensemble d’éléments que Google considère inhérents à l’UX d’une page web. Encore appelés mise à jour de l’expérience de la page, ils se composent de

- La convivialité pour les mobiles ;

- L’absence de popups interstitiels ;

- La navigation sécurisée (l’absence de logiciels malveillants sur votre page).

En résumé

Au terme de cet article, il convient de retenir que Algorithm Change est l’ensemble des modifications importantes que Google a apportées à son algorithme principal.

Le moteur de recherche s’inscrit dans la logique d’amélioration continuelle et les différents changements qu’il apporte à son algorithme de recherche lui permettent d’affiner les résultats de recherche.

Ces mises à jour importantes portent globalement sur l’amélioration de l’expérience utilisateur, les pénalités pour les pages de qualités médiocres et des spams ainsi que la convivialité sur mobile.

Les entreprises qui rêvent de voir leurs sites web classés dans les SERP doivent donc chercher à satisfaire les exigences de Google en termes d’expérience utilisateur, la création de contenu de qualité et l’adaptabilité aux mobiles.

En appliquant les différentes stratégies abordées dans cet article, vous allez pouvoir maintenir votre place dans les SERP et anticiper sur les prochaines mises à jour.

N’hésitez pas à partager votre expérience en commentaire si votre site a déjà été affecté une fois par les différentes mises à jour de Google.