Avouons-le, avec 93% des expériences en ligne qui commencent avec un moteur de recherche, il y a lieu de se familiariser avec ces plateformes. Pour cela, il est important de comprendre le fonctionnement des moteurs de recherche et de maîtriser les différents procédés qui vous permettront de vous positionner correctement dans leurs résultats. L’ensemble de ces pratiques est dénommé le SEO pour Search Engine Optimization. Il s’agit d’une discipline très vaste avec un vocabulaire très riche et vaste. En effet, que vous le veuillez ou non, si vous avez pour ambition d’augmenter la visibilité de votre site web, vous allez forcément être confronté à l’utilisation du SEO qui vous amènera régulièrement à être confronté à des termes qui peuvent parfois être difficiles à appréhender, notamment si vous êtes un novice dans le domaine. Pour cette raison, j’ai établi ce glossaire qui comprend les définitions et les explications concernant les mots et expressions qui sont employés dans le cadre du SEO. Dans la mesure où le SEO est un domaine pratiqué internationalement, vous allez retrouver régulièrement des termes en anglais qui font aujourd’hui l’unanimité, donc nous les avons maintenus tels que.

Naviguer plus facilement dans ce dictionnaire SEO en cliquant sur la première lettre du mot dont vous souhaitez trouver la définition:

A

Above the Fold

Above the Fold est un terme anglais dont l’équivalent direct n’existe pas en français et qui désigne « Au-dessus du pli » de façon littérale. En effet, il s’agit du contenu qui apparaît automatiquement sur un site internet avant que l’utilisateur ne défile vers le bas.

Il comprend généralement la zone du menu de navigation et la partie Slider. A ce niveau, gardez à l’esprit que Google a créé l’algorithme de mise en pages en 2012 afin que les sites présentant trop d’annonces dans cet espace soient moins bien référencés.

Action manuelle

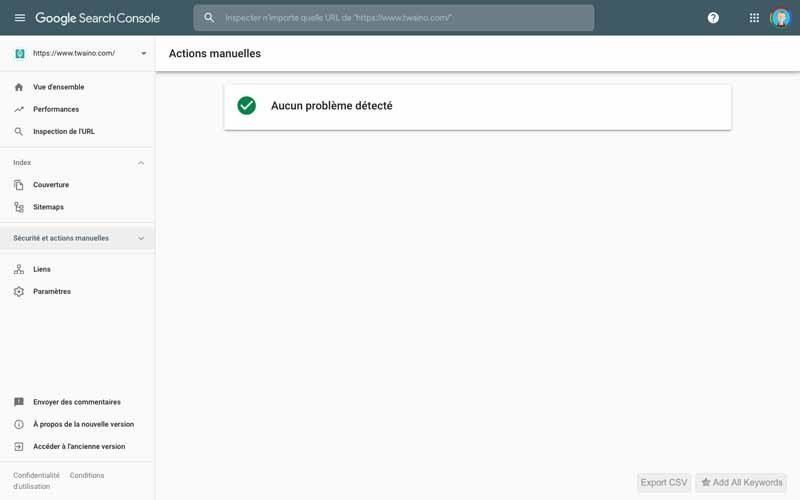

Une action manuelle est une pénalité infligée à un site web lorsque celui-ci ne respecte pas les consignes de Google liées à la qualité. Elle est généralement déterminée par l’équipe de Google et entraîne une rétrogradation voire la suppression des pages du site web dans les résultats de recherche.

Une action manuelle peut survenir s’il y a :

- Du spam généré par l’utilisateur ;

- Des liens artificiels vers votre site ;

- Des liens artificiels sur votre site ;

- Des techniques de dissimulation ou redirections trompeuses ;

- Des hébergeurs gratuits associés à du spam ;

- Du balisage structuré contenant du spam ;

- Du spam agressif ;

- Images dissimulées : Cloaking ;

- Etc…

Pour savoir si vous faites l’objet d’une action manuelle, Google indique « nous vous en informons dans le rapport sur les actions manuelles et dans le centre de messagerie de la Search Console ». Il est donc très important de configurer le compte Google Search Console de votre site web pour ne pas manquer d’être informé d’une éventuelle action manuelle.

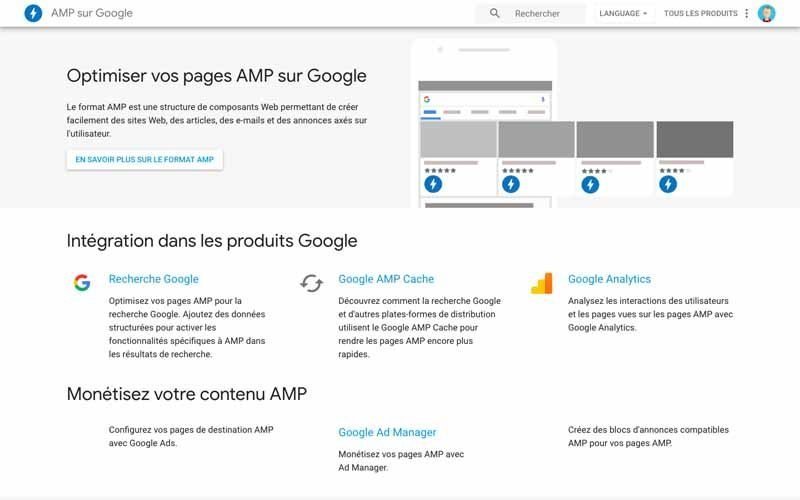

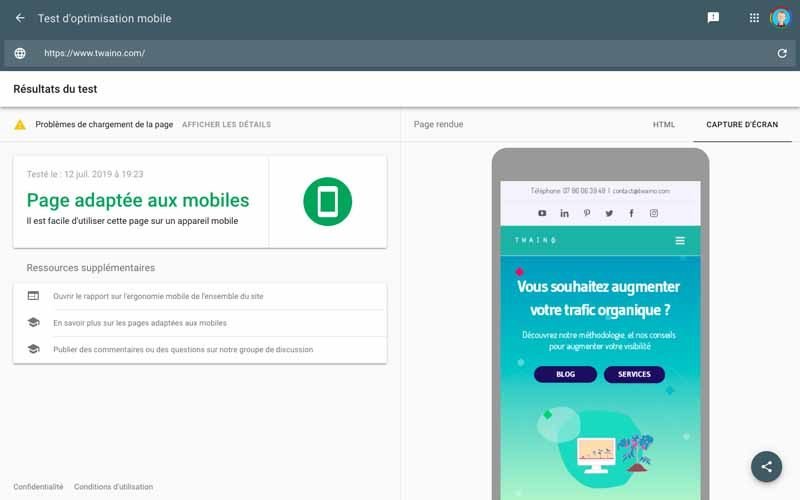

Accelerated Mobile Pages ou AMP

L’Accelerated Mobile Pages ou encore AMP est un projet open source lancée par Google en février 2016. Il a pour objet l’amélioration des performances des pages Web pour les appareils mobiles.

Cette technologie est déjà utilisée par un grand nombre de sites dont :

- ABC ;

- CNN ;

- Fox News ;

- Le Parisien ;

- The Washington Post ;

- Etc…

En fait, le chef produit principal de The Washington Post, David Merrell, indique : « Nous sommes résolus à accélérer les choses dans tous les domaines. Si le chargement de notre site prend beaucoup de temps, peu importe la qualité de notre journalisme, certaines personnes quitteront la page avant de voir ce qui s’y trouve. ».

Il serait donc judicieux que vous vous penchiez aussi sur l’utilisation de l’AMP pour votre site web. Et si vous avez un site web sur wordpress, je vous montre comment passer à l’AMP dans un prochain article.

AJAX

Asynchronous JavaScript and XML ou en français JavaScript asynchrone et XML, est un type de programmation qui permet à une page Web d’envoyer et de recevoir des données d’un serveur dans le but de modifier de façon dynamique cette page sans rechargement.

Algorithme

Dans le SEO, un algorithme est un programme informatique complexe que les moteurs de recherche utilisent afin de récupérer des données, et ceci, dans but de fournir des résultats pour une requête donnée.

Il est à noter que les moteurs de recherche n’utilisent pas un seul algorithme, mais un ensemble d’algorithmes. Ce qui leur permet de fournir des pages web classés suivant un certain nombre de facteurs via une page de résultats.

Algorithm Change

Les moteurs de recherche modifient sans cesse leurs algorithmes afin de les améliorer. Alors que certains changements passent totalement inaperçus, d’autres désignés comme étant « majeurs » ont un impact majeur. L’algorithm change se présente sous trois formes :

- New Algorithm ou nouvel algorithme : Il désigne l’ajout d’un nouvel algorithme par le moteur de recherche dans le but d’améliorer la qualité de la recherche. Au niveau de Google, nous avons par exemple : Panda et Google Penguin.

- Algorithm Update ou mise à jour de l’algorithme : Il désigne la modification de certains signaux au niveau d’un algorithme existant, ce qui impacte significativement le référencement. Par exemple, la mise à jour de Panda a affecté 12% de toutes les requêtes anglaises ;

- Algorithm refresh ou rafraîchissement de l’algorithme : Il s’agit de la réexécution d’un algorithme existant avec de petites modifications qui n’ont quasiment pas d’impact. En considérant la même source, seulement 1% à 2% de toutes les requêtes anglaise ont été affectées.

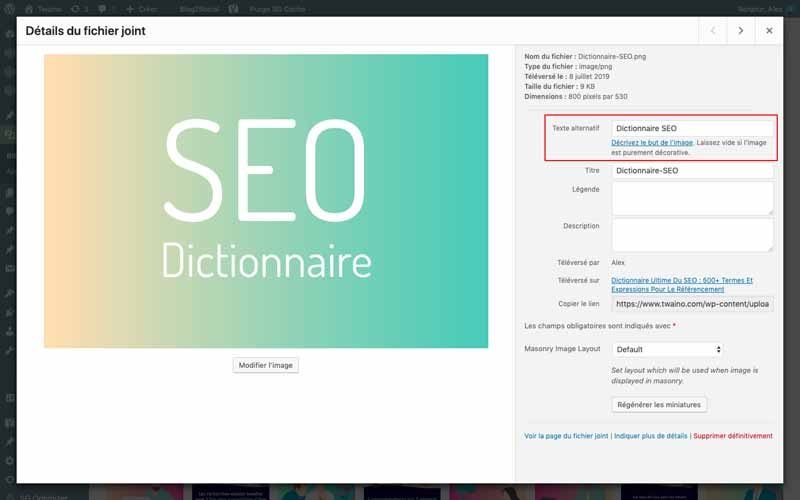

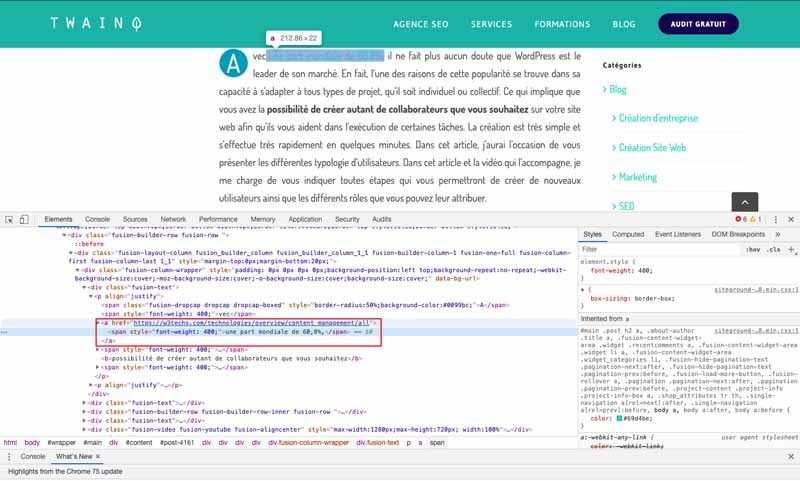

Alt text / Alt Tag / Text Attribute

Il s’agit d’une dénomination courte pour « Alternate Text » qui désigne une description des images pour les moteurs de recherche. En effet, les moteurs de recherche notamment Google, n’arrivent pas encore à comprendre le contenu des images. Toutefois, ils peuvent lire les balises « Alt text » afin d’afficher les images pertinentes dans ses résultats.

La prochaine fois que vous ajoutez des images dans vos articles, pensez à ajouter les balises « Alt Text ».

Analytics

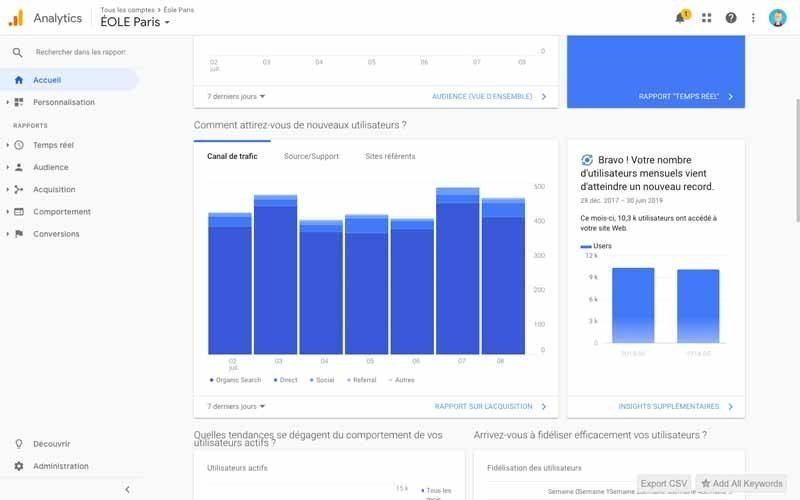

Il s’agit d’un logiciel qui vous permet d’analyser facilement votre site web grâce à la collecte de précieuses informations, dans le but de prendre des actions pour améliorer vos performances.

Parmi les puissants outils de cette catégorie, il y a Google Analytics qui permet d’avoir des informations pertinentes en temps réels.

Ancre de lien ou texte d’ancre

Selon definitions-seo, « Une ancre de lien désigne le contenu textuel du lien, qui apparaîtra par défaut en bleu et souligné dans un navigateur web. On l’appelle également Texte d’ancre et il indique le plus souvent de quoi parle la page distante. »

L’utilisation d’ancre de lien est une pratique très courante, mais notez qu’il est important de bien la définir afin qu’elle soit naturelle et bien interprétée par les moteurs de recherche.

Par exemple, « definitions-seo » est l’ancre qui vous mènera directement sur la page web comportant la définition d’ancre de lien.

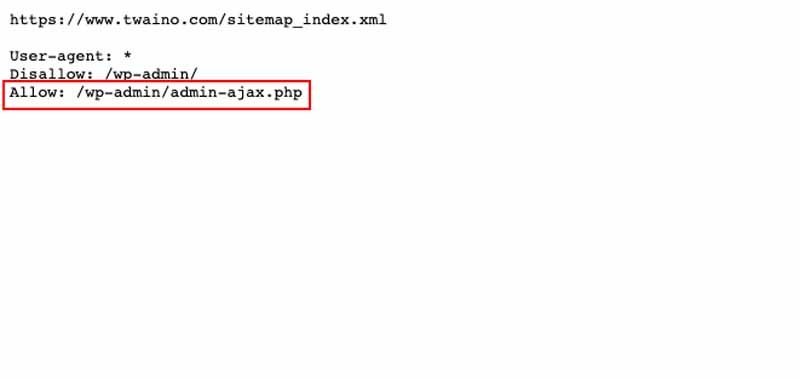

Allow

Les moteurs de recherchent vous permettent de contrôler l’indexation de votre site web. Ainsi, vous pouvez autoriser ou interdire l’indexation de votre site web ou des pages de votre site web par les robots des moteurs de recherche.

De ce fait, « Allow » est la directive utilisée dans le fichier « robots.txt » pour autoriser l’exploration de votre site web, contrairement à « Disallow » qui l’interdit.

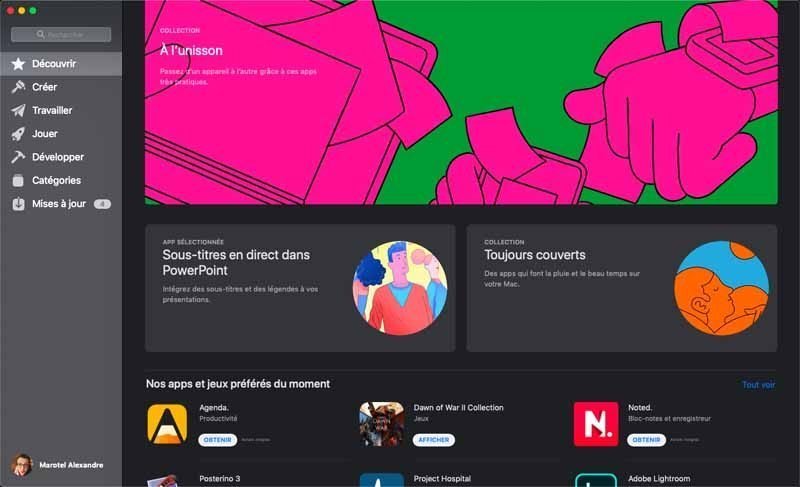

App Store Optimization ou ASO

App Store Optimization ou l’acronyme ASO désigne l’ensemble des techniques mises en place dans l’objectif d’améliorer le référencement d’une application sur les stores mobiles d’Internet. Il s’agit par exemple de PlayStore de Google pour le système Android et de l’App Store d’Apple.

En fait, l’Apple App Store dispose de 2,2 millions d’applications téléchargeable, tandis que le Google Play Store comporte 2,8 millions d’applications disponibles. En tenant compte de ces statistiques, il ne fait aucun doute qu’il est indispensable d’avoir une bonne stratégie afin de rendre visible votre application et de le rendre populaire.

Pour ce faire, il faut utiliser le ASO dont les principes diffèrent de ceux du SEO classique. Voici quelques critères selon thetool.io :

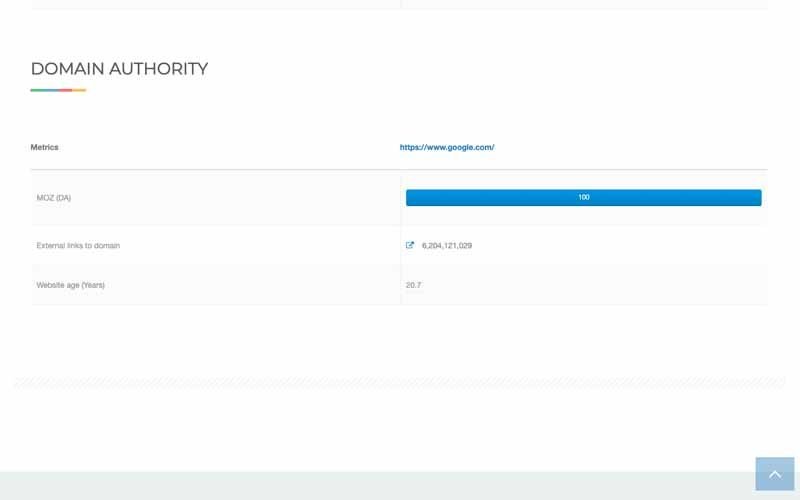

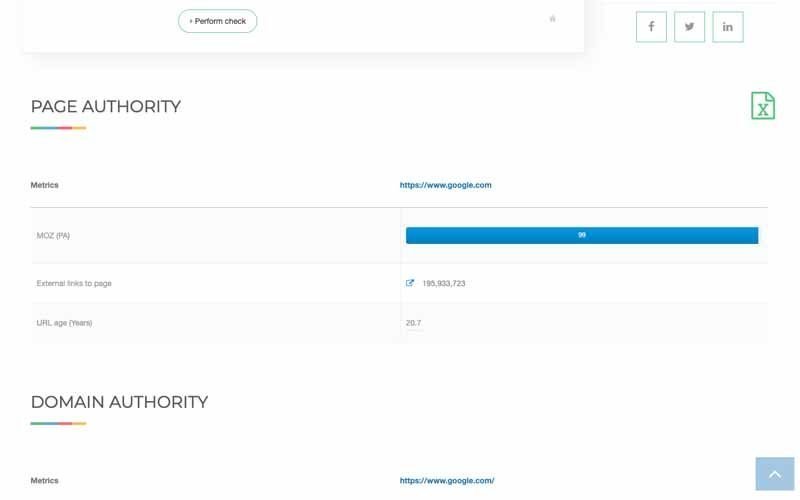

Authority ou Autorité

En termes de SEO, l’autorité fait référence à la confiance. Lorsque les internautes trouvent des informations pertinentes par rapport à leur recherche, votre site web, celui-ci est crédité de leur confiance. Votre site web peut aussi gagner en autorité si d’autres si sites web parlent de vous.

Authority Sites ou Site d’Autorité

Un site d’autorité est un site internet de qualité qui va être considéré comme étant très fiable. Lorsqu’un site web obtient beaucoup de backlinks, cela indique généralement que son contenu est de grande qualité et que les lecteurs vous font déjà confiance.

Toutefois, sachez que construire un site d’autorité va prendre du temps à construire. En effet, l’un des objectifs sera pour vous d’obtenir des liens entrants provenant d’autres sites d’autorité. Plus votre site est d’autorité, plus Google sera susceptible de vous privilégier dans ses classements.

Un exemple typique de site d’autorité est celui de Neil Patel.

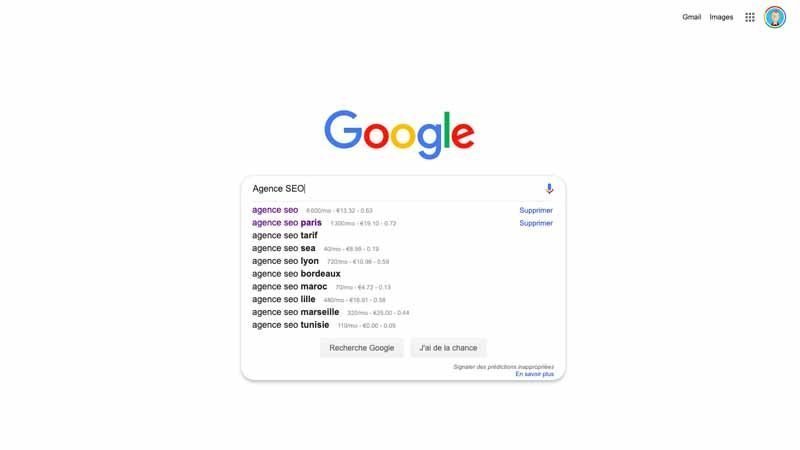

Autocomplétion ou suggestion automatique

[fusion_menu_anchor name= »B » class= » »][/fusion_menu_anchor]

Il s’agit d’une fonction qui permet aux moteurs de recherche de suggérer automatiquement des requêtes au fur et à mesure de la saisie de l’intention de recherche par l’internaute. Autrement dit, cette option limite le nombre de mots ou de caractère que vous êtes amené à saisir en proposant un complément qui pourrait convenir pour la suite de votre requête.

Cette fonctionnalité est rendue possible grâce à Google Suggest lancé en 2004 et Google Instant lancé en 2010.

B

Baidu

Fondé en janvier 2000 par Robin Li et Eric Xu, Baidu est le moteur de recherche le plus populaire en Chine avec une part de 66,2% contre 14,4% pour Google.

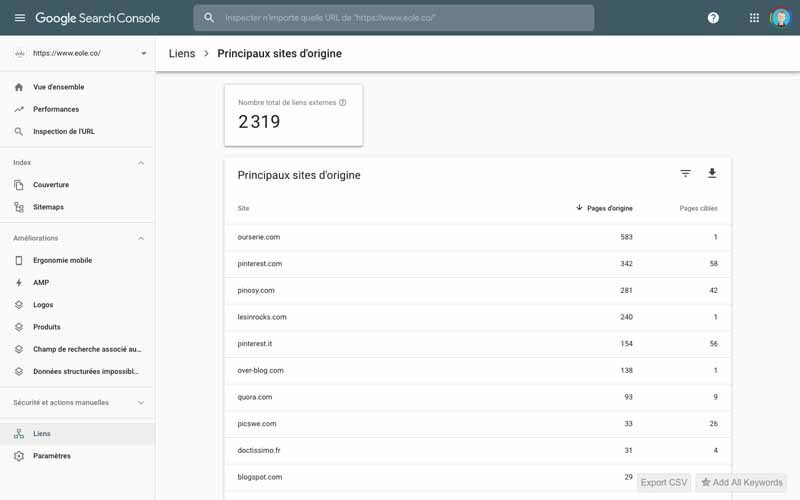

Backlink ou lien retour

Selon definitions-seo : « Un backlink est un lien hypertexte entrant, venant d’un autre site web. Si une page A fait un lien vers une page B (sur un autre site), on dit que A est un backlink de B ou que B obtient un backlink de la part de A. »

Les moteurs de recherche, notamment Google considère le backlink comme un critère dans le référencement des site web. Cela dit, le but n’est pas d’avoir de nombreux backlinks de divers sites, mais de faire en sorte qu’ils soient de qualité et proviennent de sites web pertinents. Pour suivre vos backlinks, un outil tel que Google Search Console peut vous aider à avoir une liste de ces liens ainsi que leur provenance.

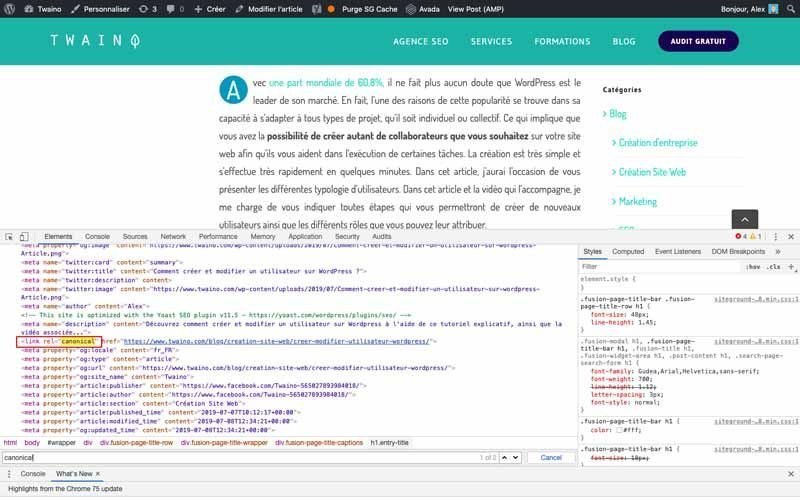

Balise Canonical ou Canonical URL

Conçu par Google, Bing et Yahoo en 2009, la balise canonicale permet d’éviter en quelques sorte le problème de duplicat content ou contenu dupliqué en français. En effet, cela indique qu’une page web reprend le même contenu qu’une autre page web.

Pour cela, cette balise comprend le lien de la page originale qui est dénommée canonique et se présente sous la forme .

Notez qu’il est très important de faire usage de la balise canonique puisque Google estime que : « Si vous n’indiquez pas explicitement à Google laquelle des URL est canonique, Google choisira la page canonique à votre place ou considérera toutes les pages similaires égales : cela pourrait entraîner un comportement indésirable…. ». Ce qui peut impacter négativement votre SEO.

De plus, l’utilisation des balises canonicales vous permet entre autres de :

- Gérer le contenu syndiqué ;

- Définir l’URL que vous souhaitez voir affichée dans les résultats de recherche ;

- Regrouper des indicateurs de liens pour les pages similaires ou en double ;

- Simplifier le suivi des statistiques d’un seul produit/sujet ;

- Etc…

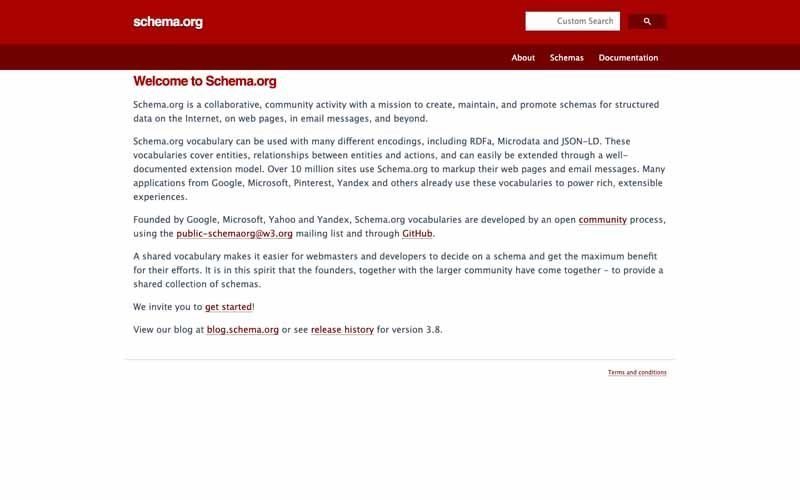

Balises de Données Structurées ou Rich Snippet

Les balises de données structurées encore appelées Rich Snippet en anglais, permettent aux moteurs de recherchent de mieux comprendre le contenu d’une page web et de l’analyser beaucoup plus facilement.

En effet, ce sont des balises sémantiques ajoutées au code HTML d’une page web dans le but de fournir des informations complémentaires sur le contenu de la page en question. Ce qui permet parfois aux moteurs de recherche d’ajouter des informations complémentaires dans leurs résultats de recherche.

Comme l’affirme Google qu’il : « s’appuie sur des données structurées trouvées sur le Web pour comprendre le contenu de la page, ainsi que pour recueillir des informations au sujet du Web et du monde en général. » et « La recherche Google utilise également des données structurées pour proposer des fonctionnalités spéciales dans les résultats de recherche et des optimisations. ».

Il s’agit donc d’un élément très important que je vous invite à insérer dans votre stratégie SEO.

Balises de pagination

Comme la plupart des autres balises, celles-ci aident les robots des moteurs de recherche à mieux indexer le contenu des pages web en indiquant que le contenu est divisé en plusieurs parties paginées et accessibles en de nombreux clics.

Ce concept a été introduit par Google en septembre 2011 et vous permet par exemple d’optimiser l’indexation des pages d’une grande liste de produit.

Prenons l’exemple d’illustration de Google : Supposons que vous avez 4 parties correspondant aux URL suivantes :

http://www.example.com/article?story=abc&page=1

http://www.example.com/article?story=abc&page=2

http://www.example.com/article?story=abc&page=3

http://www.example.com/article?story=abc&page=4

La première URL aura dans la partie Head de son code source une balise « rel= »next » indiquant l’URL de la page suivante :

La deuxième URL aura une balise « rel=prev » avec l’URL de la page précédente et une balise « rel=next » avec l’URL de la page suivante :

Et ainsi de suite jusqu’à la quatrième (et dernière) URL qui aura une balise « rel=prev » avec l’URL de la page précédente :

Pour aller plus loin sur le sujet, vous pouvez consulter cet article de webrankinfo.

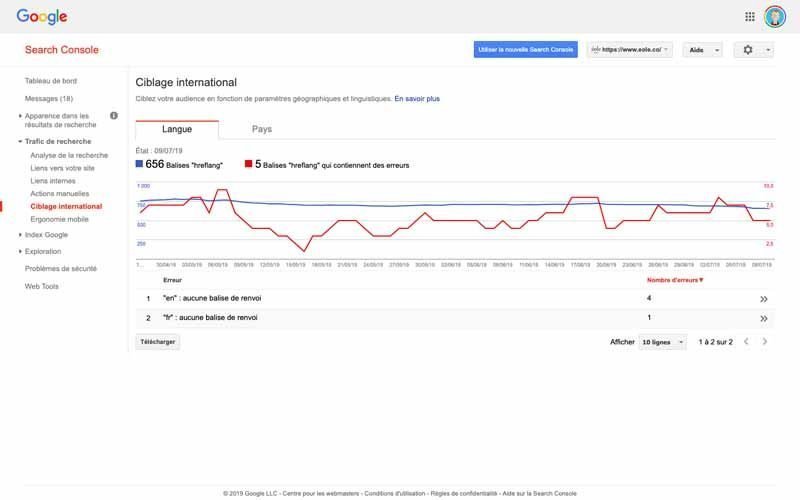

Balises Hreflang

Proposées par Google depuis l’année 2011, les balises Hreflang permettent d’indiquer la langue de la page et le pays cible auquel ladite page est destinée. Cette balise peut particulièrement vous aider si le contenu de vos pages sont traduits dans plusieurs langues.

Cependant, Google indique que : « même si vous choisissez de ne pas utiliser cette fonctionnalité, les différentes versions linguistiques de votre page peuvent être détectées par Google. Toutefois, il est généralement préférable de nous indiquer explicitement les pages spécifiques aux langues ou aux régions que vous couvrez. »

En reprenant l’exemple de abondance, les balises se présenteront de la manière suivante :

« Pour 4 sites web ciblés vers des langues et/ou des pays différents :

http://www.example.com/ : page d’accueil générale en espagnol.

http://es-es.example.com/ : page d’accueil en espagnol, pour l’Espagne.

http://es-mx.example.com/ : page d’accueil en espagnol, pour le Mexique.

http://en.example.com/ : page d’accueil en anglais.

Les balises suivantes pourront alors être intégrées respectivement dans chaque site :

. »

Balise meta

Selon definitions-seo, une balise meta est : « une balise HTML qui se trouve dans la partie HEAD du code source d’une page et qui fournit des méta-données au navigateur, c’est-à-dire des informations au sujet de la page en question. Les balises meta sont normalement invisibles dans le navigateur de l’internaute ».

Les balise meta se présentent généralement de la manière suivante :. De plus, il a plusieurs types de balise meta dont :

- La balise meta description ;

- La balise meta robots

- Etc…

Notez que Google n’accepte pas toutes les balises meta et si vous souhaitez vous familiariser avec ce type de balise, cet article de Google vous permettra de connaître celles qui sont acceptées.

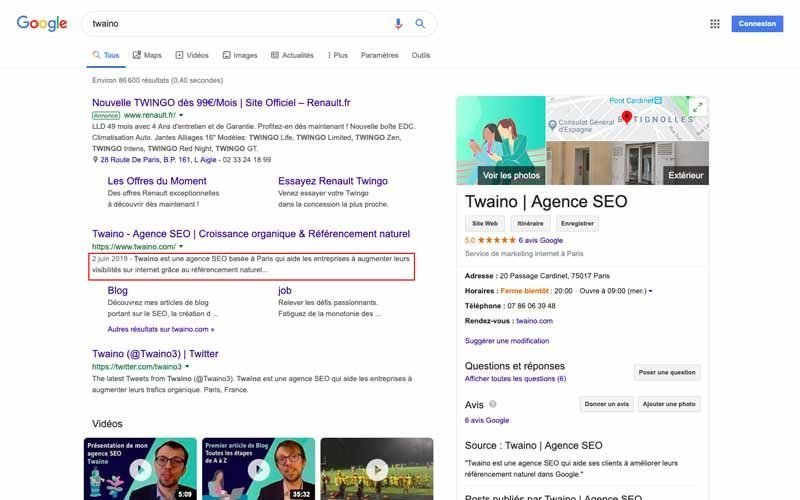

Balise meta Description

Il s’agit d’une balise meta très importante qui permet de fournir un résumé du contenu d’une page web aux moteurs de recherche afin que ceux-ci puissent l’afficher dans leurs résultats de recherche.

Bien qu’il ne s’agisse pas d’un critère permettant d’être mieux classé, elle permet d’améliorer le taux de clic dans le cas où elle est suffisamment accrocheuse.

Elle se présente sous la forme deet comprend environ 155 caractères au maximum avec Google.

Toutefois, la firme estime dans son article d’aide à la création de titres et d’extraits de qualité que : « Il n’y a pas de limite à la longueur des meta descriptions, mais les extraits des résultats de recherche sont tronqués au besoin, généralement pour s’adapter à la largeur de l’appareil. ».

Balise Meta Robots

Cette balise meta sert à donner des indications aux robots des moteurs de recherche en ce qui concerne la prise en compte d’une page web. Par exemple, elle signale à ces derniers s’ils doivent indexer une page ou pas.

Elle se présente généralement sous la forme :et vous pouvez découvrir comment bien l’utiliser sur cette ressource de contentking. Après, vous pouvez aussi vous informer sur l’impact de cette balise dans les résultats de recherche de Google.

Balise meta Keywords

Il s’agit d’une balise permettant d’indiquer les mots clés qui décrivent le contenu d’une page web aux moteurs de recherche. Mais pour rappel, Google a déclaré qu’il ne prenait pas en compte la balise meta keywords, donc cette balise est devenue obsolète.

Balise Title

La balise title correspond au titre d’une page web et se présente généralement les résultats des moteurs de recherche et dans la barre de titre du navigateur. Cette disposition fait d’elle l’une des balises les plus importantes en termes de référencement naturel et je vous invite à optimiser vos balises title correctement pour améliorer votre classement dans les résultats des moteurs de recherche.

Elle se présent sous la formeavec une limite de 512 pixels, soit environ 55 caractères. Les directives de Google peuvent aussi vous aider à optimiser significativement vos balises title.

Bing

Lancé en juin 2009, Bing est le troisième moteur de recherche en Avril 2019, après Google et Yahoo, avec une part du marché mondiale de 3,13%. Ce moteur de recherche a été conçu et lancé par Microsoft et remplace le Live Search anciennement Microsoft Live Search et MSN Search.

Bingbot

Tous les moteurs de recherche ont des robots qui leur permettent d’explorer le web afin de réaliser l’indexation des pages web, Bingbot est le nom du robot du moteur de recherche de Microsoft, Bing.

Black Box

En français Boîte noire, le Black Box est un programme informatique complexe dont les entrées et les sorties peuvent être observés, mais dont le processus interne n’est pas accessible en raison de sa nature confidentielle. Par exemple, l’algorithme de Google est un Black Box puisqu’on peut seulement appréhender les requêtes (entrées) et les résultats (sorties) sans pour autant connaître le fonctionnement de l’algorithme.

Black Hat

Google, le moteur de recherche le plus populaire au monde, a mis en place des consignes destinées aux webmasters que ces derniers se doivent de respecter. Toutefois, certains référenceurs ne suivent pas ces recommandations en utilisant des pratiques illicites pour manipuler l’algorithme des moteurs de recherche afin d’être mieux classé dans les résultats.

Google indique que ces pratiques sont : « susceptibles d’entraîner l’application d’une action manuelle pour cause de spam, d’une sanction de type algorithmique ou le retrait définitif du site concerné de l’index Google. ».

Les SEO qui ne respectent pas les règles imposées par Google sont appelés des Black Hat SEO et ceux qui suivent scrupuleusement les recommandations sont des White Hat SEO. Si vous souhaitez avoir plus d’information sur le sujet, cette ressource de seo vous sera d’une grande utilité.

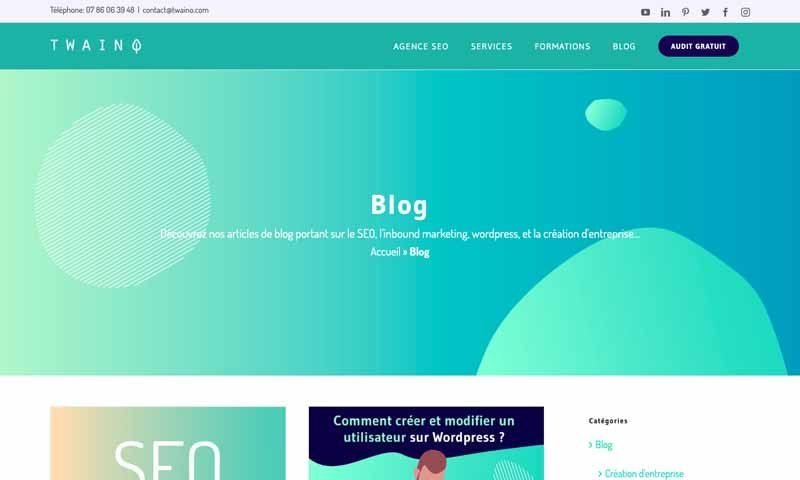

Blog

Le blog ou parfois blogue en français, est un type de site web ou une partie d’un site web dédiée à la publication périodique de contenu triée par ordre, du plus récent au plus ancien.

Les thématiques traités peuvent refléter des intérêts personnels ou corporatifs et peuvent aussi être rédigé par une ou plusieurs personnes.

A l’origine, les blogs avaient la dénomination de « Web logs » ou « Weblogs ». Mais étant donné que les fichiers journaux d’un serveur étaient aussi appelés « Web log », cela apportait de la confusion et l’abréviation « blog » a été créé, devenant du coup le terme le plus populaire.

Avoir un blog et être consistant dans la création de contenu est une pratique très pertinente en termes de SEO. En effet, HubSpo indique que « 55% des spécialistes du marketing indiquent que le blogging est leur première priorité ». Il s’agit donc d’une tactique très efficace si vous l’utilisez correctement.

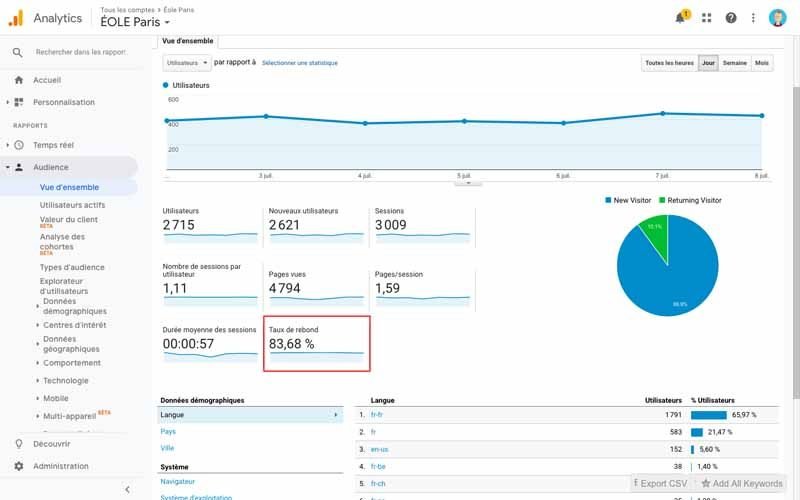

Bounce Rate ou Taux de rebond

Le bounce rate ou en français le taux de rebond, est la proportion de visiteurs d’un site web qui partent sans avoir visité une autre page en dehors de celle qu’ils ont consulté. Ce taux varie en fonction de plusieurs facteurs dont :

- Un contenu de mauvaise qualité ;

- Une mise en page étouffante ;

- Une page trop longue à se charger ;

- Un manque de Call to action ;

- L’insatisfaction des visiteurs due à un mauvais ciblage ;

- Etc…

Généralement, il y a rebond lorsque le visiteur a :

- Tapé une nouvelle URL ;

- Cliqué sur un lien externe ;

- Fermé l’onglet ou la fenêtre ;

- Cliqué sur « Précédent » dans son navigateur et est ressorti du site ;

- Etc…

Toutefois, il peut aussi signifier que les utilisateurs ont trouvé immédiatement ce qu’ils cherchaient. Si votre site web sert par exemple à fournir l’heure, les visiteurs n’auront pas besoin d’aller plus loin dans leur recherche.

Hubspot propose quelques astuces intéressantes pour analyser et limiter le taux de rebond.

Budget Crawl ou crawl budget en anglais

Selon definitions-seo, le budget crawl représente : « les limites en termes de nombre de pages que Googlebot (le robot de Google) va crawler sur un site web en tenant compte de plusieurs critères : taille du site, vitesse d’exploration, fréquence de mise à jour, qualité du contenu et nombre de clics. ».[fusion_menu_anchor name= »C » class= » »][/fusion_menu_anchor]

Néanmoins, Google indique dans un post que « si un site dispose de moins de quelques milliers d’URL, il sera exploré correctement la plupart du temps ». Ce qui indique que vous n’avez pas à vous inquiéter si vous avez un site internet comprenant seulement quelques pages, mais il est toujours utile de penser à optimiser son budget crawl afin d’améliorer l’indexation de vos pages.

C

Cache Google

Il s’agit de la version d’une page web que le moteur de recherche détient et montre dans ses résultats. Cette version n’est pas forcément celle qui est disponible à un moment donné sur la page web.

En effet, Google essaie d’avoir la version la plus récente possible des diverses pages qu’il indexe grâce à son robot. Mais tant que ce dernier ne repasse pas sur une page web pour la crawler à nouveau, il peut arriver, notamment si la page a été modifiée, que cette page soit différente de celle que connaît Google.

Il existe différentes solutions pour regarder le Cache Google de vos pages web et ce post de Google vous permettra de le faire.

Caffeine

Lancé en 2010 par Google, Caffeine est un programme qui a renouvelé l’ancien système d’indexation du moteur de recherche avec une nouvelle structure plus robuste et rapide. Ce renouvellement avait pour objectif d’être en phase avec l’évolution du web de l’époque et donc de répondre aux exigences de la toile.

Camel Case

Camel Case ou littéralement casse de chameau en français, est un est une pratique qui consiste à écrire une expression en mettant l’initial de chaque terme qui le compose en majuscule. En SEO, cette pratique vise à rendre plus visible les titres de pages web dans les résultats des moteurs de recherche.

MasterCard, PlayStation ou QuickTime sont des exemples lorsqu’on parle de Camel Case.

Cloaking

Il s’agit d’une violation aux directives de Google qui consiste à afficher différents contenus ou URLs aux personnes et aux moteurs de recherche. En SEO, cette pratique permet d’envoyer une page donnée à un visiteur humain tout en envoyant une autre au moteur de recherche.

Le but étant toujours d’être mieux classé dans les résultats des moteurs de recherche. Le cloaking se décline en plusieurs techniques dont :

- Le cloaking basé sur le user-agent ;

- Le cloaking « IP Delivery » basé sur l’adresse IP ;

- Le cloaking via Javascript, Flash ou Dhtml ;

- Le cloaking du texte ou du bloc invisible ;

- Etc…

Clustering

Selon definitions-seo : « Le Clustering, dans le domaine de la recherche d’information, désigne avant tout deux choses : d’une part, le fait pour les moteurs de ranger un site ou une page web dans des « clusters » (thématiques) différents : sport, politique, commerce électronique, etc. Et d’autre part, le fait de limiter dans leurs SERP le nombre de liens pour un même site web. ».

Cette définition indique donc que le terme Clustering peut être utilisé pour désigner deux différentes procédures au niveau des moteurs de recherche. La première concerne la catégorisation d’une page web, d’un site web… dans une thématique spécifique. Ce qui implique d’une page peut être compartimenté dans plusieurs clusters.

La seconde procédure concerne la limitation du nombre de liens par site web dans les résultats de recherche. En effet, Google applique déjà sa politique de diversité dans les résultats de recherche en limitant le nombre de liens par site web à seulement deux. Toutefois, ce nombre peut varier en fonction des requêtes.

Cocon sémantique

Inspiré du siloing, le cocon sémantique a été introduit par Laurent Bourrelly et se fonde sur une analyse sémantique des besoins du visiteur afin de concevoir une architecture pertinente de site web. Celle-ci est un mélange de maillage interne et d’optimisation des contenus.

De façon pratique, le cocon sémantique permet de pousser une page cible grâce à d’autres pages de niveau inférieur avec un système de netlinking interne pertinent. Le cocon sémantique présente un impact positif sur le référencement naturel et il serait judicieux de vous intéresser à cette technique pour créer votre propre cocon sémantique.

Concours SEO

Comme son nom l’indique, il s’agit d’une compétition mettant en jeu des référenceurs qui doivent se positionner sur une expression définie, et ce, sur une période donnée. Le référenceur qui arrive en tête à l’échéance de la durée convenue gagne le concours. Les règles peuvent varier et sont parfois très strictes. Il s’agit par exemple du concours Nextlevel de 2019 basé sur le mot clé « téléphone pliable ».

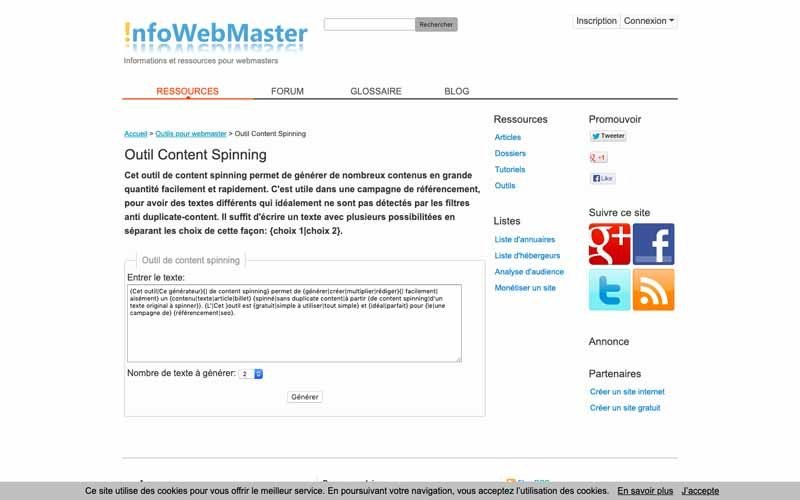

Content Spinning

Le content spinning ou le spinning est une pratique qui vise, de manière technique, à créer des textes à partir d’un texte original grâce à un logiciel. En effet, le content spinning est utilisé dans le référencement parce qu’il permet de créer rapidement du contenu, et d’éviter les problèmes de duplicat content via l’utilisation de mots et d’expressions qui sont en quelque sorte synonymes.

En reprenant l’exemple de redacteur.com, nous avons :

Le texte « Cette voiture est la plus rapide et la plus confortable du marché. De plus, son prix défie toute concurrence. »

Qui devient avec un logiciel de spinning : « {Cette voiture|Cette berline} est la plus {rapide|puissante|performante} et la plus {confortable|luxueuse} {du marché|de sa catégorie}. De plus, son prix {défie toute concurrence|est très accessible|est très raisonnable}. ».

De là, on peut avoir des phrases telles que :

« Cette berline est la plus performante et la plus confortable de sa catégorie. De plus, son prix est très accessible. »

« Cette voiture est la plus puissante et la plus luxueuse de sa catégorie. De plus, son prix défie toute concurrence. »

Cette méthode semble donc très économique en termes de temps, mais Google considère le content sipinning comme du spam, ce qui pourrait donc nuire à votre référencement si vous ne savez pas comment bien utiliser cette pratique.

Crawl

Le crawl désigne l’action des robots des moteurs de recherche à explorer un site web afin de connaître toutes les pages du site. Cette action s’effectue grâce aux liens proposés sur ces différentes pages et elle dépend de plusieurs facteurs comme l’indique Google : « Nos programmes informatiques déterminent les sites à explorer, la fréquence à laquelle l’exploration doit être effectuée, ainsi que le nombre de pages à explorer pour chaque site ». [fusion_menu_anchor name= »D » class= » »][/fusion_menu_anchor]

Crawler ou robot

Un robot est un programme utilisé par les moteurs de recherche pour collecter des données sur Internet. Lorsqu’un robot d’exploration visite un site Web, il sélectionne l’ensemble du contenu du site Web et le stocke dans une base de données. Il stocke également tous les liens externes et internes du site Web et les visitera à un moment ultérieur, il s’agit de la façon dont il se déplace d’un site Web à un autre.

D

Datacenter ou centre de données

En SEO, un datacenter est un lieu exclusivement réservé au stockage de l’infrastructure et de l’index des moteurs de recherche, qui lui permettent de fournir ses services. Google quant à lui disposait de 34 datacenters répartis un peu partout dans le monde en 2008.

La firme américaine donne plus d’information sur ses datacenters en dévoilant quelques adresses ainsi que leur description avec des images.

Demande de réexamen

Lorsqu’un site web fait l’objet d’une action manuelle ou de problèmes de sécurité, la demande de réexamen ou de considération est une étape qui lui permet de mettre fin à la pénalité ou au problème de sécurité. En effet, le site soumet cette demande à l’équipe Search Quality Team de Google après avoir corrigé les erreurs et les fautes constatées par la firme.

Cette demande se fait sous forme d’un formulaire à remplir et l’équipe juge si les corrections effectuées sont suffisantes ou pas. Dans le cas où elles ont été effectuées correctement, alors le problème est résolu ou la pénalité est annulée. Mais dans le cas contraire, il faut reprendre les corrections et soumettre encore une demande de réexamen.

Le processus de réexamen est généralement long puisqu’une demande peut prendre 1 à 3 semaines avant d’avoir une réponse, autant dire qu’il est judicieux de ne pas faire l’objet d’une pénalité.

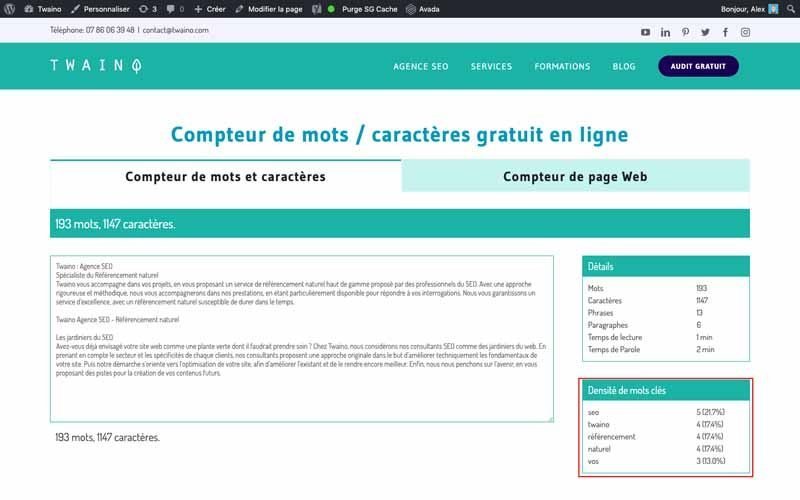

Densité de mots clés

La densité de mots clés désigne la proportion du nombre d’apparitions d’un mot par rapport au nombre total de mots du texte. En effet, l’utilisation de mots clés est une pratique très importante dans le SEO qui a vu le jour dans les années 2000. Elle consiste à répéter de mots clés un certain nombre de fois afin d’être mieux classé dans les résultats des moteurs de recherche.

Cela dit, même si une répétition de certain mots clés peut permettre au moteur de recherche de comprendre la thématique du contenu, travailler sur la densité de mots clés semble ne pas être très efficace selon Matt Cutts.

Si vous souhaitez tester votre densité de mots clés vous pouvez utiliser notre compteur de mots.

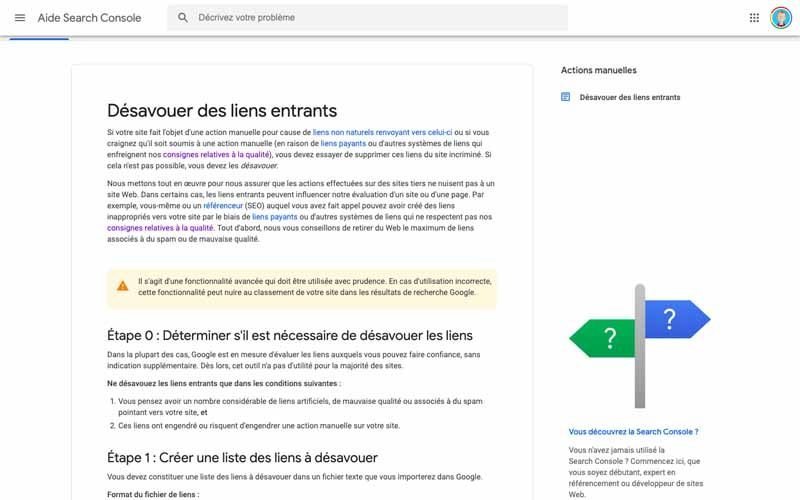

Désaveu de lien

Lorsque vous considérez que certains liens entrant vers votre site web sont ‘’toxiques’’ ou proviennent de sites web qui ne respectent pas les consignes de Googles, vous pouvez indiquer au moteur de recherche de ne plus considérer ces liens dans ses analyses.

En effet, votre site web peut être pénalisé si Google estime que ce dernier reçoit un nombre trop élevé de liens artificiels entrants. Il en va donc de votre intérêt de désavouer ces liens pour ne pas être pénalisé.

Toutefois, il convient de faire très attention puisque Google estime qu’il s’agit « d’une fonctionnalité avancée qui doit être utilisée avec prudence. En cas d’utilisation incorrecte, cette fonctionnalité peut nuire au classement de votre site dans les résultats de recherche Google. ».

Il convient donc de comprendre tous les enjeux du désaveu de lien et de le réaliser correctement.

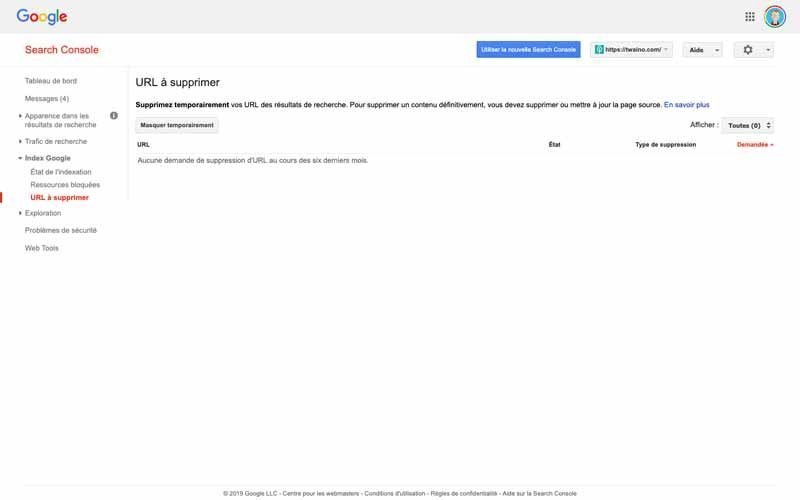

Désindexation

La désindexation est une pratique SEO qui consiste à indiquer aux moteurs de recherche les contenus qu’il ne faudrait pas considérer. Il peut s’agit de contenus de faible qualité ou des contenus que vous souhaitez garder privés pour qu’ils n’apparaissent pas dans les résultats des moteurs de recherche. On distingue par exemple :

- Les pages avec du duplicat content ;

- Les pages issues de l’importation d’un thème démo ;

- Les pages proposant du contenu spinné ;

- Les pages de résultats du moteur interne ;

- Etc…

La désindexation permet donc de trier et d’offrir aux internautes les contenus les plus qualitatifs. Pour effectuer la désindexation, vous avez plusieurs options dont :

- L’utilisation de la balise meta robots « noindex » ;

- Le fichier robots.txt ;

- Le formulaire de suppression d’URL dans la Search Console ;

- Etc…

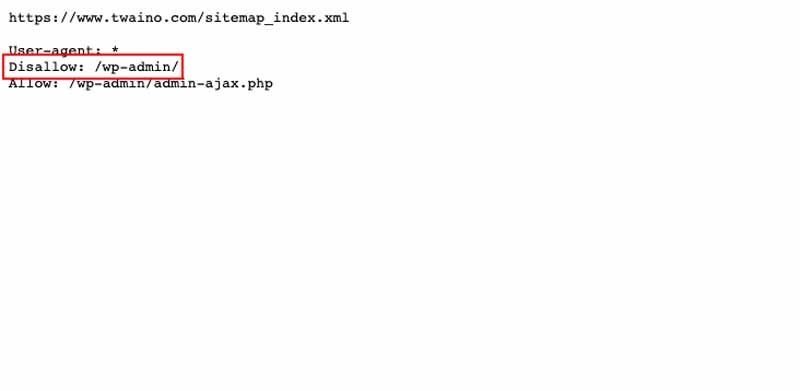

Disallow

Disallow est une directive qui permettent d’indiquer aux robots des moteurs de recherche de ne pas explorer une page ou un site web. En d’autres termes, vous pouvez l’utiliser pour faire en sorte que Googlebot n’aille pas dans certaines zones de votre site web.

La directive Disallow se configure dans le fichier robots.txt avec la syntaxe suivante :

Disallow: [path], avec le [path] comme début de l’URL de la page à ne pas explorer. En reprenant l’exemple de definitions-seo, on a :

« Pour un site de type https://www.exemple.com/ :

Disallow:

Aucune restriction. Accès libre.

Disallow: /

Le site est entièrement interdit à l’exploration.

Disallow: blog

Aucune page dont l’URL commence par « blog » ne sera explorée (exemple : https://www.exemple.com/blog ou https://www.exemple.com/blog/exemple.php).

Disallow: /*.pdf

Aucun document dont l’URL contient « .pdf » ne sera exploré (exemple : https://www.exemple.com/contrat.pdf ou https://www.exemple.com/blog/document.pdf ou https://www.exemple.com/blog/document.pdf?langue=fr). »

Cependant, notez que cette directive n’empêche pas l’indexation des pages web, ce qui induit les messages « Aucune information n’est disponible pour cette page » qui apparaissent dans les résultats de recherche.

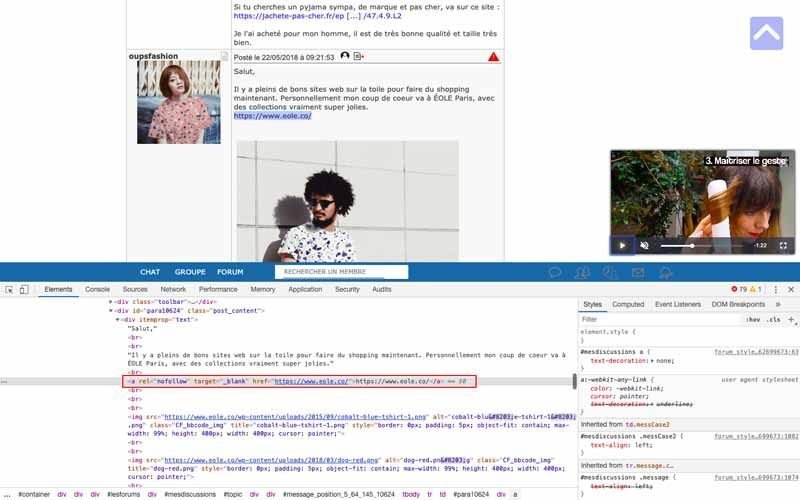

Dofollow

Un lien dofollow est un lien normal qui dirige vers une page web en indiquant qu’elle est utile et qu’il faut en tenir compte, ce qui augmente sa valeur aux yeux des moteurs de recherche. Il s’agit du contraire de nofollow qui indique aux moteurs de recherche de ne pas tenir compte du lien.

Le dofollow s’utilise lorsque :

- Le site Web est légitime et digne de confiance ;

- Le site est utile pour vos lecteurs ;

- Le site Web fournit des renseignements exacts ;

- Le site Web est pertinent par rapport à votre contenu ;

- Etc…

En effet, le dofollow indique qu’il n’y a pas de restriction avec le nofollow, par conséquent, il s’agit du lien classique comme : Texte du lien.

Dans le cas où il est utilisé dans une balise meta robots, cet attribut indique aux moteurs de recherche de tenir compte de tous les liens sortant de la page et se présente généralement sous la forme :ou.

Pour aller plus loin sur le sujet, vous pouvez consulter seopressor, qui en dit plus long sur le sujet.

DuckDuckGo

Lancé en 2008 aux Etats-Unis, le DuckDuckGo est un métamoteur qui puise ses données à partir de plusieurs moteurs de recherche généralistes tels que Google, Yahoo, Bing, etc… Sa philosophie selon Wikipédia est de : « préserver la vie privée et de ne stocker aucune information personnelle concernant les utilisateurs (adresses IP et traces numériques comme la signature du navigateur). ». Vous pouvez donc l’utiliser si vous souhaitez que vos données soient protégées.

De plus, DuckDuckGo offre une fonctionnalité qui permet de spécifier la source de l’information. Il s’agit des raccourcis :

- !wfr pour Wikipédia ;

- !g ;

- Etc…

Duplicate Content ou Contenu Dupliqué

Encore appelé contenu en double, il s’agit d’un concept particulièrement important en termes de SEO. Google indique « Par contenu en double, on entend généralement des blocs de contenu importants, appartenant à un même domaine ou répartis sur plusieurs domaines, qui sont identiques ou sensiblement similaires.».

Bien que le duplicat content ne génère pas généralement de sanction directe de la part de Google, le référencement ou la visibilité de votre page peut être impacté. En effet, Google entend offrir aux utilisateurs des informations distinctes afin d’être le plus complet possible. Pour cela, il s’efforce de ne pas proposer des contenus identiques en privilégiant la version originale au détriment des versions dupliquées.

Mais dans le cas où Google juge que vous utilisez le contenu en double pour manipuler le classement dans ses moteurs, votre site web peut être « retiré définitivement de l’index Google, auquel cas il ne s’affichera plus dans les résultats de recherche. ». La même ressource de Google vous indique quelques pratiques à observer pour résoudre le problème de duplicat content.

DUST

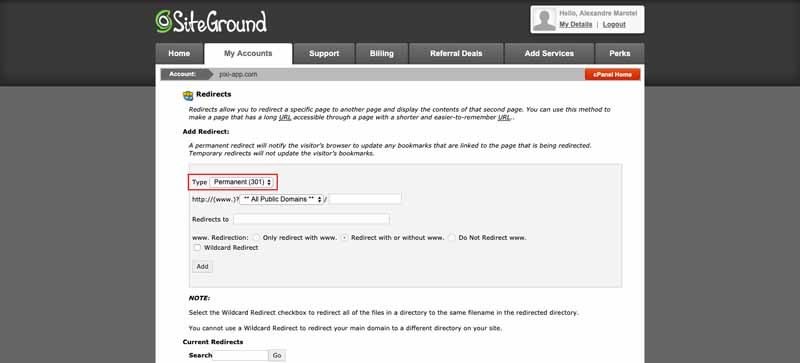

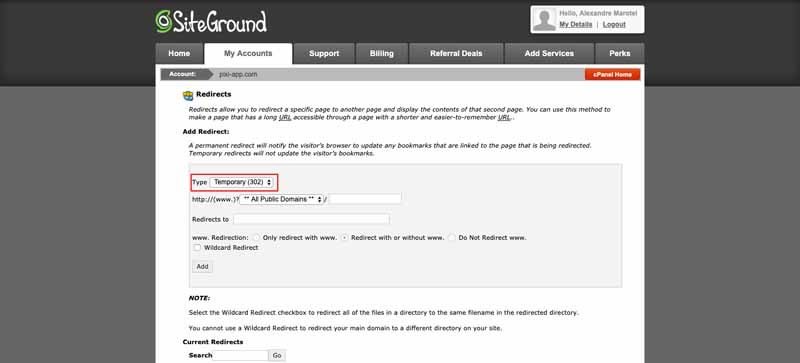

Le DUST ou Duplicate URL Same Text est un autre aspect du duplicat content et survient lorsqu’une page unique avec un seul code source peut être accédée via des liens différents. Dans cette mesure, les moteurs de recherche peuvent croire qu’il s’agit de plusieurs pages et considérer qu’il y a du contenu dupliqué.

Par exemple pour la page : https://www.example.com/, il peut y avoir ces URL pointant vers elle :

- https://example.com/ ;

- http://www.example.com/ ;

- https://www.example.com ;

- https://www.example.com/index.php.

Dans cet exemple, nous avons au totale 4 différentes URLs pour la même page et comme Google se base sur les URL pour identifier les pages, il considère qu’il s’agit de 4 pages différentes. De là, comme le contenu ne diffère pas, il va détecter du contenu dupliqué sur votre site web, ce qui pourrait vous pénaliser. Pour cela, vous pouvez faire usage de la balise canonical.

E

Exact Match Domain

Dans le souci d’être mieux référencé dans les moteurs de recherche, les référenceurs ont recours à plusieurs méthodes dont celle d’inclure dans le nom de domaine des mots clés représentant la thématique principale du site web. Le nom de domaine qui en résulte est le l’Exact Match Domain ou plus simplement EMD.[fusion_menu_anchor name= »E » class= » »][/fusion_menu_anchor]

Par exemple, on distingue formation-redaction-web.com ou restaurant-lyon.fr/ comme des EMD.

Bien que cette pratique semble être très avantageuse, Google a diminué l’influence des EMD sur son classement depuis 2010. N’empêche qu’il ne faille pas s’en priver et veiller à correctement définir son Exact Match Domain.

F

Favoris ou Bookmark

Le favoris ou bookmark en anglais, est un bon signe qui indique qu’un utilisateur a enregistré votre site Web ou un lien vers votre site dans son navigateur pour y revenir prochainement de manière beaucoup plus rapide. Cela signifie qu’il a aimé le contenu de ce lien et qu’ils aimeraient l’utiliser plus tard.

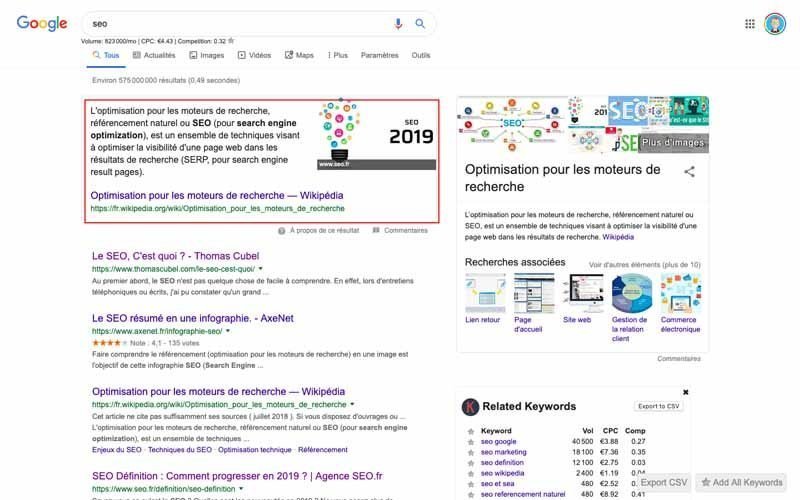

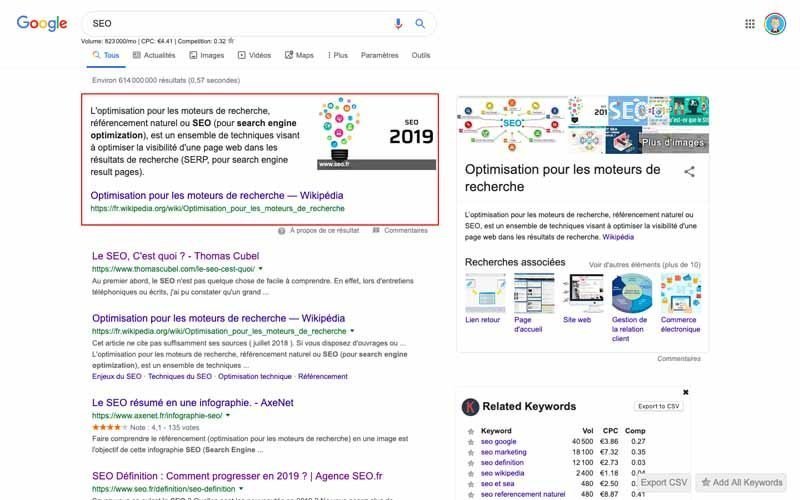

Featured Snippet

Encore connu sous les noms de « position 0 » ou d’extrait optimisé selon Google, le featured snippet est une fonctionnalité qui permet à Google d’afficher une réponse directe à une requête sans que l’utilisateur ne soit obligé de cliquer sur un lien. Il s’agit d’un brief aperçu que montre généralement Google lorsqu’il juge la réponse pertinente, l’utilisateur pourra alors cliquer sur le lien pour avoir beaucoup plus d’informations.

Les featured snippets sont sous forme d’encadré de texte situé au-dessus des résultats et s’accompagnent parfois d’image, il s’agit d’une position privilégiée pour augmenter votre visibilité.

A la question de savoir comment faire pour afficher un extrait optimisé de sa page, Google indique que : « Cela n’est pas possible. Les systèmes Google déterminent si une page peut constituer un extrait optimisé en fonction de la requête de recherche d’un internaute et, le cas échéant, la sélectionnent. ». Cela dit, il y a des pratiques qui vous permettront d’optimiser vos contenus pour qu’ils s’affichent dans les feature snippets.

Notez néanmoins que Google n’affiche pas certains contenus sous forme de featured snippet, il s’agit des contenus :

- A caractère sexuel explicite ;[fusion_menu_anchor name= »G » class= » »][/fusion_menu_anchor]

- Incitant à la haine ;

- Violents et dangereux ;

- Etc…

G

Geotargeting

Connu en français sous l’expression Ciblage Géographique, le geotargeting est une technique de ciblage des utilisateurs en fonction de leur situation géographique. Ceci est généralement effectué lorsque vous voulez afficher différents contenus ou publicités à vos visiteurs en fonction de l’endroit où ils se trouvent.

Selon Google, 75 % des consommateurs préfèrent des publicités personnalisées en fonction de leur lieu de résidence. Le geotargeting est donc une méthode très pertinente qu’il serait intéressant d’adopter.

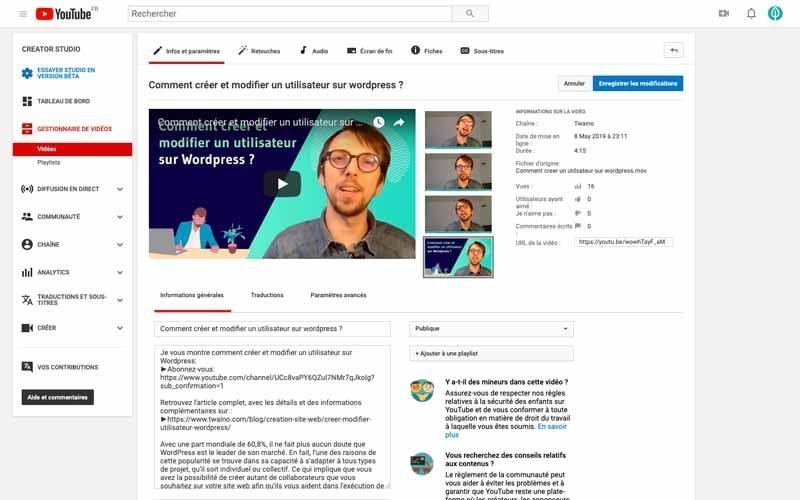

Google est le moteur de recherche le plus populaire au monde avec 94,2% de part du marché mondial. Il s’agit du leader incontesté de son domaine depuis plusieurs années et cette position est renforcée par les nombreux services et outils qu’il offre. En termes de référencement, il s’agit par exemple de :

- Google+ ;

- Google Alerts ;

- Google Analytics ;

- Google Keyword Planner ;

- Google Maps ;

- Google Mobile-Friendly Test ;

- Google My Business ;

- Google PageSpeed Insights ;

- Google Search Console ;

- Google Trends ;

- YouTube ;

- Etc…

Google+

Google+ est le réseau social de la firme américaine lancé en juin 2011, aussi bien les particuliers que les entreprises. Mais Google averti désormais que : « Google+ est uniquement disponible pour les comptes G Suite fournis par une entreprise ou un établissement scolaire. L’application n’est plus compatible avec les comptes personnels (se terminant généralement par @gmail.com) depuis le 2 avril 2019. »

Par conséquent, ses utilisateurs sont désormais les entreprises et les organisations qui peuvent créer des profils, rejoindre des communautés….

A noter que le contenu que vous y publiez est immédiatement indexé, il peut donc être utilisé comme un outil de référencement dans le marketing de votre entreprise.

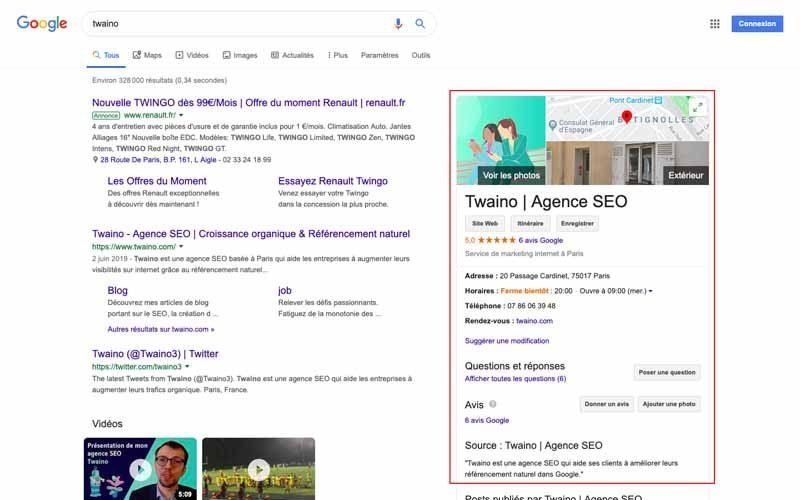

Google Ads

Google Ads est un service de publicité en ligne mise en place par Google où les utilisateurs se positionnent sur des mots-clés pour que leurs annonces apparaissent dans Google et son réseau publicitaire.

Google a mis en place un guide complet sur Google Ads que vous pouvez consulter pour savoir comment l’utiliser.

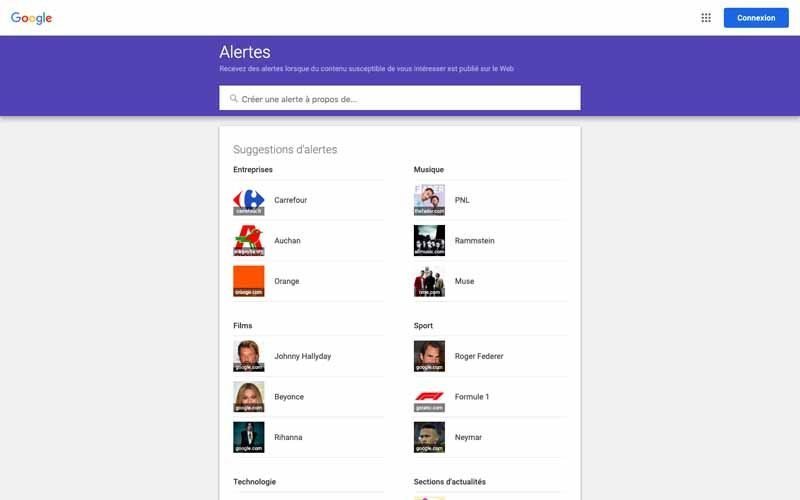

Google Alerts

Google Alerts est un service développé par Google pour notifier des contenus susceptibles d’intéresser l’utilisateur. En effet, vous pouvez le configurer pour qu’il suive différents mots-clés et lorsque du contenu comportant ces mots-clés est indexé, vous allez recevoir un email.

Certains des mots-clés que vous pouvez suivre sont entre autres :

- Votre nom ;

- Votre service ;

- Votre produit ;

- Le nom de votre entreprise ;

- Etc…

Vous pouvez l’utiliser pour la gestion de votre réputation, la création de liens ou pour surveiller vos concurrents et suivre l’évolution de leur contenu. Ce guide pratique de Google sur Google Alerts peut vous aider à configurer vos alertes. Pour aller plus loin sur le sujet, Smartkeyword.io donne quelques astuces pour son utilisation en matière de SEO.

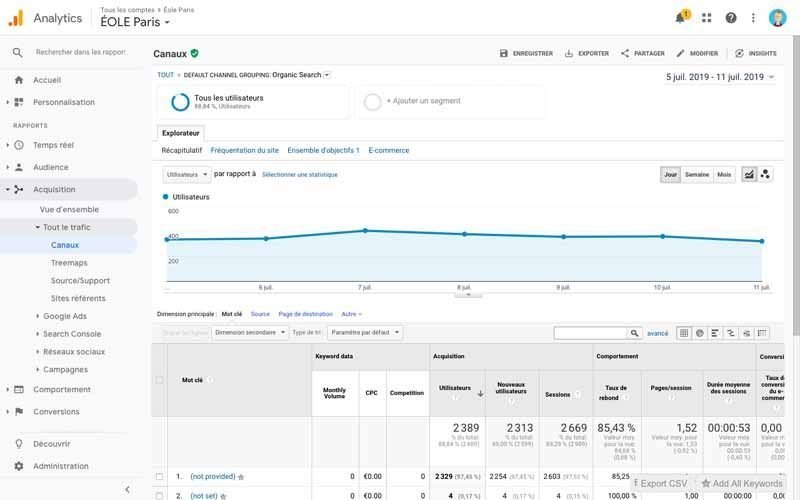

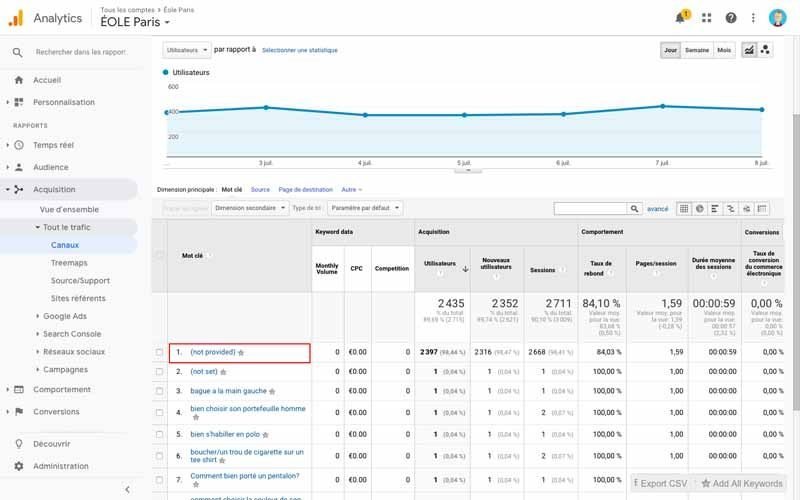

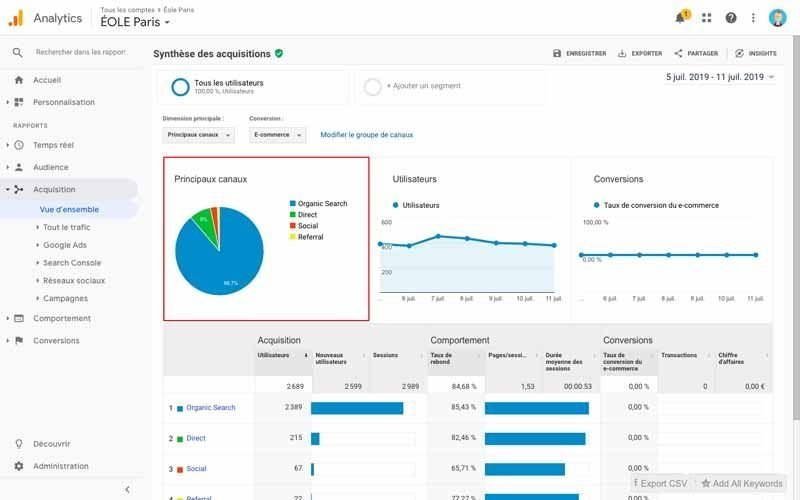

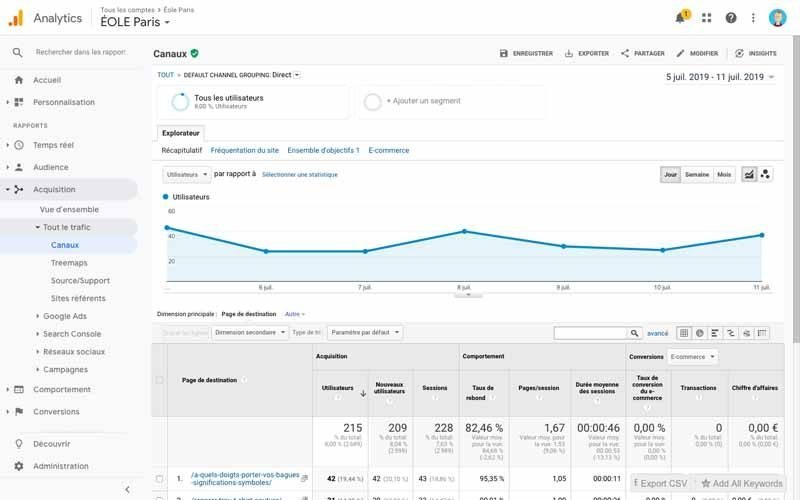

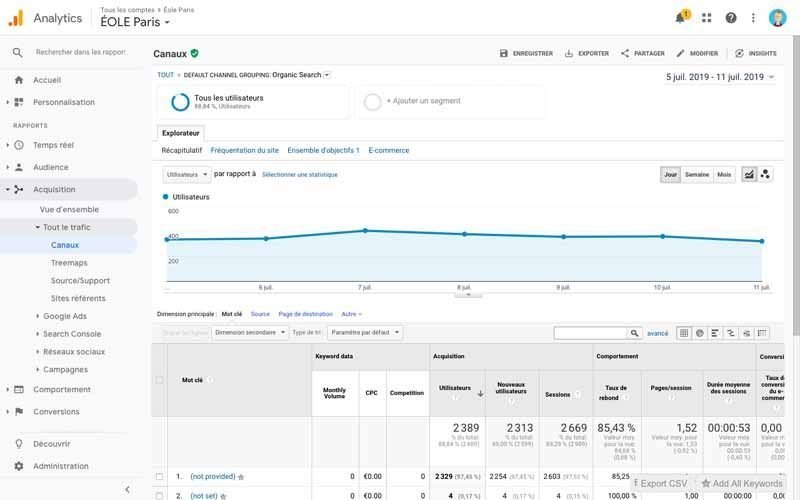

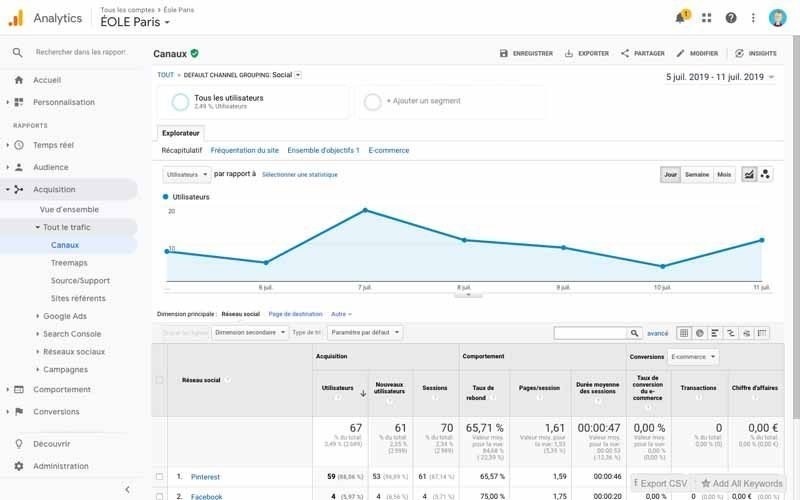

Google Analytics

Google Analytics est un outil développé par Google qui fournit de précieuses informations sur un site Web. Après avoir ajouté le code de suivi à votre site Web, vous recevrez des données détaillées sur le trafic de votre site Web. Ce qui vous permet de suivre vos utilisateurs, leur situation géographique, leurs intérêts, les appareils qu’ils utilisent pour accéder à votre site Web, leur temps d’attente et leur taux de rebond.

Vous pouvez également obtenir des données sur la quantité de trafic direct et organique que vous recevez. Enfin, vous pouvez voir comment votre site web fonctionne en termes de vitesse et de contenu.

Vous pouvez vous servir de ce guide de Google pour apprendre beaucoup plus sur ce puissant outil gratuit et mon article sur l’installation de Google Analytics peut vous aider.

Google bomb ou bombardement Google

Google bomb est une méthode de référencement qui vise à manipuler les résultats du moteur de recherche en affichant dans le SERP une personne ou une organisation sans rapport avec le mot-clé de la requête.

Cette pratique est généralement utilisée à des fins humoristiques et on distingue par exemple la requête « idiot » qui renvoie vers des images de Donald Trump ou « l’échec misérable » renvoyant vers George W. Bush dans les résultats.

Google bowling

Il s’agit d’une technique SEO Black Hat qui consiste à créer des backlinks vers un concurrent sur des sites Web non pertinents et spammeurs dans l’objectif que le concurrent soit pénalisé. Ce qui est susceptible de réduire le rang de ce dernier dans les SERPs et de permettre à celui qui le fait de gagner en classement.

Google AdWords

Voir Search Engine Advertising

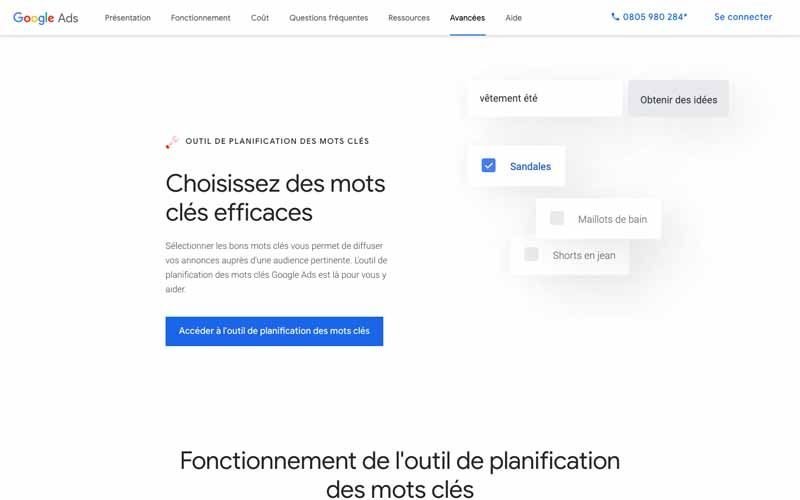

Google Keyword Planner

Google Keyword Planner est un outil qui permet aux annonceurs de déterminer le niveau de trafic qu’ils peuvent potentiellement obtenir avec un certain budget et une certaine campagne. L’outil offre également la possibilité d’estimer les coûts possibles d’un groupe de campagnes publicitaires.

Il est à noter que le gestionnaire de mots-clés ne peut être utilisé qu’avec un compte AdWords valide. En plus de l’utilisation pour la publicité dans les moteurs de recherche ou SEA, l’outil aide également les rédacteurs et les référenceurs à effectuer efficacement des recherches par mots-clés.

Bien que cet outil soit très efficace, Google souligne dans son guide sur l’outil de planification des mots clés que plusieurs facteurs peuvent affecter les performances d’une campagne dont :

- Votre budget ;

- Votre enchère ;

- Vos produits ;

- Le comportement des clients de votre secteur.

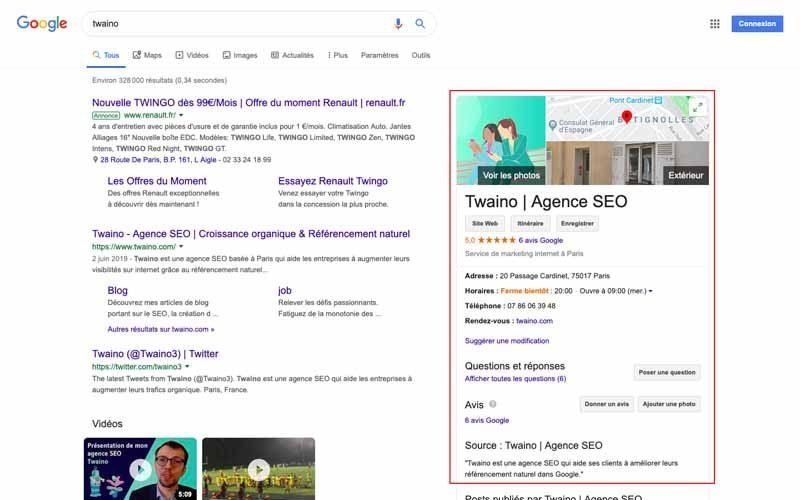

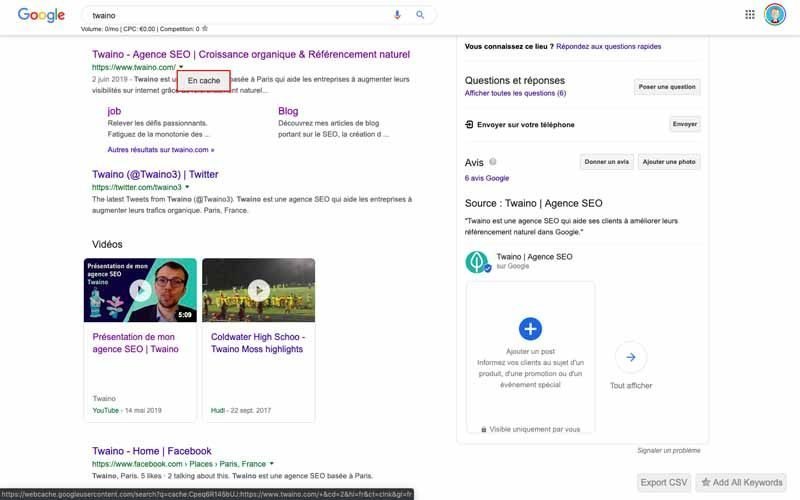

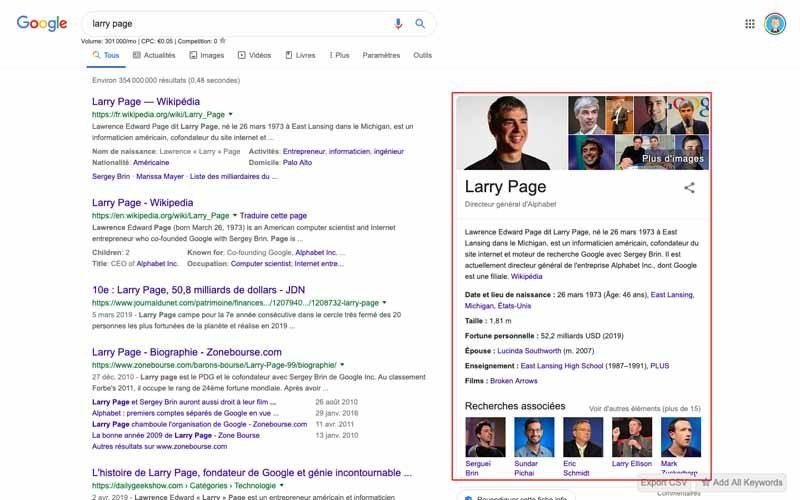

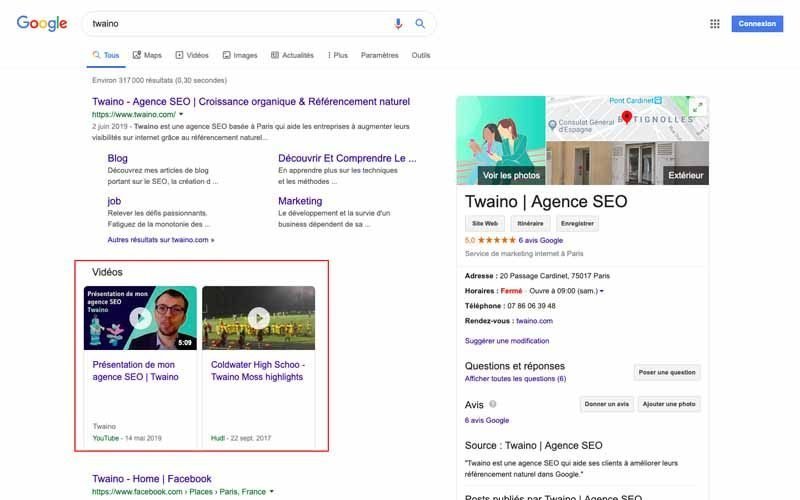

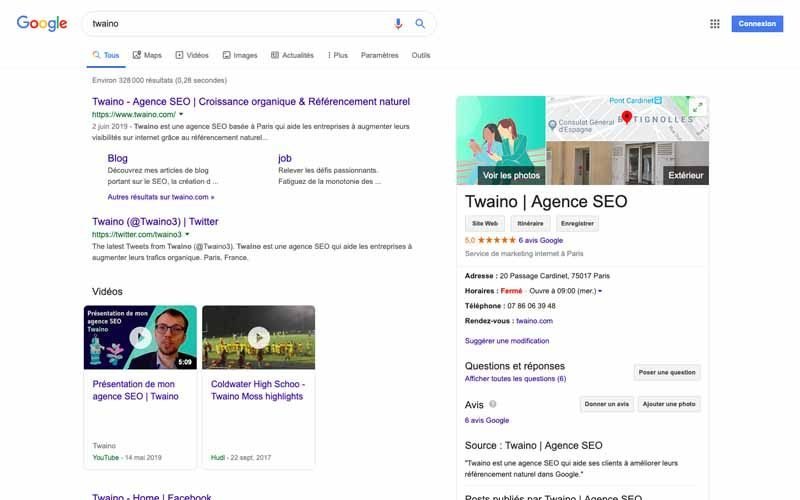

Google Knowledge Graph

Le Google Knowledge Graph est une base de connaissance ajouté à Google en 2012 qui permet d’avoir une compilation d’informations sur une entité sémantique. Il s’agit par exemple de :

- De personnes ;

- De lieux ;

- D’entreprise ;

- Etc…

Ces informations associées sont affichées dans une zone dédiée dans les résultats de recherche et proviennent de diverses sources. Sur les ordinateurs et les tablettes, le Knowledge Graph est affiché à droite à côté des résultats de la recherche organique. Sur les smartphones, l’affichage est au-dessus des résultats de la recherche.

Les éléments suivants peuvent être inclus dans le Google Knowledge Graph sont entre autres :

- Des données sur une entreprise, une personne ou un lieu ;

- Des images avec un lien vers Google Image Search ;

- Des extraits de texte ainsi que des liens vers les sources ;

- Des informations sur les requêtes de recherche similaires « autres également recherchées ».

Il s’agit d’un réel gain de temps pour les utilisateurs et vous pouvez aussi adopter certaines pratiques pour apparaître dans le Google Knowledge Graph dans le but de gagner en visibilité.

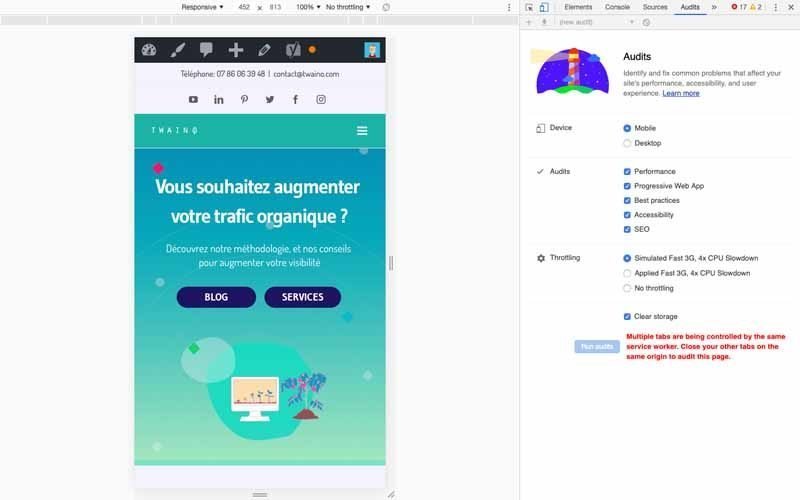

Google Lighthouse

Google Lighthouse est un outil open source permettant de réaliser des audits techniques de sites web. L’outil a été développé par Google et analyse les aspects suivants d’une URL : Performance ;

Application Web progressive ;

Accessibilité ;

Bonnes pratiques ;

SEO.

Le framework Lighthouse a déjà été intégré dans les autres outils d’analyse de performance de Google, tels que PageSpeed Insights et les audits basés sur le navigateur via les outils de développement du navigateur Chrome.

Avec les données que le Google Lighthouse permet d’avoir, il ne fait aucun doute qu’il s’agit d’un précieux outil pour le SEO et je vous invite à vous intéresser de près à l’utilisation de Google Lighthouse. Cet article de geekflare est susceptible de vous aider à comprendre aussi comment tester votre site web avec cet outil.

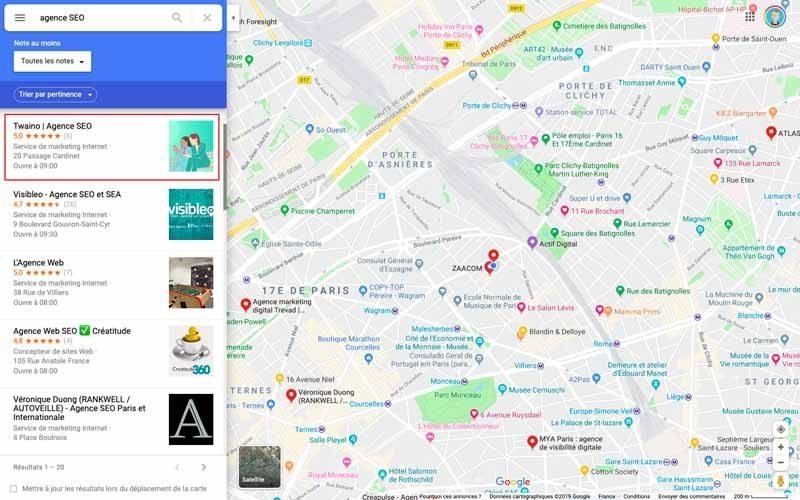

Google Maps

Il s’agit de l’un des plus populaires services de cartographie en ligne, sinon le plus grand. Il est très facilement accessible et reste complètement gratuit. Google Maps offre aux utilisateurs de nombreux services.

En effet, Google Maps peut être utilisé pour votre propre localisation et vous pouvez trouver des itinéraires d’un point A à un point B. Ici, il est possible de choisir si vous irez à pied, en vélo, en transports publics ou en voiture. Si vous ne savez pas l’utiliser, ce guide pratique de Google peut énormément vous aider.

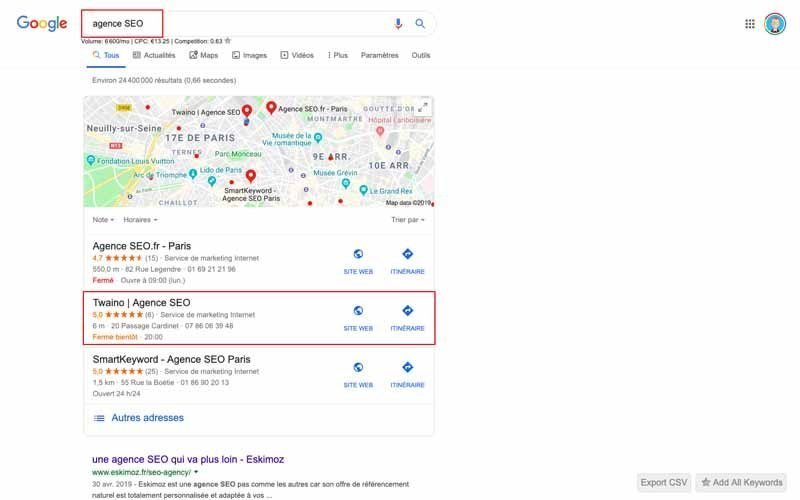

En termes de SEO, il s’agit d’un véritable levier puisque SEO Expert estime que : « 78 % des recherches géoréférencées sur mobile donnent lieu à un achat effectué hors ligne ». Il s’agit donc d’une vraie source de trafic d’autant plus que les résultats issus de Google Maps apparaissent souvent en haut des résultats de recherche.

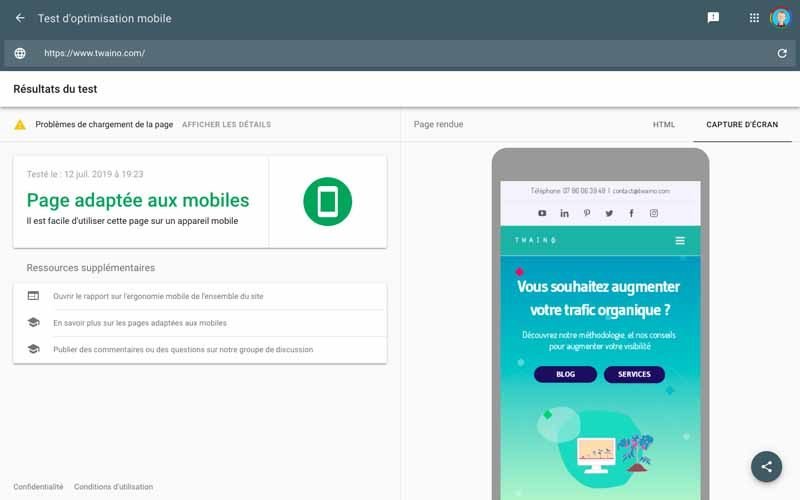

Google Mobile-Friendly Test

Selon les statistiques SEO : « 57 % des consommateurs ont dit qu’ils ne recommanderaient pas une entreprise dont le site Web mobile est mal conçu ». Cette statistique indique bien l’importance de rendre les sites web responsives afin qu’il s’adapte aux téléphones.

En effet, l’expérience utilisateur est un facteur très important chez Google et étant donné que beaucoup d’utilisateurs naviguent désormais à partir de leur téléphone portable, la firme à fait du confort d’utilisation mobile, un facteur de classement important.

Pour cela, Google a mise en place le Google Mobile-Friendly Test, un outil pour tester les performances des pages sur mobile. Pour faire ce test, rendez-vous sur Mobile-friendly, ce qui vous permet d’avoir un score et une liste de problèmes ainsi que les démarches pour les résoudre.

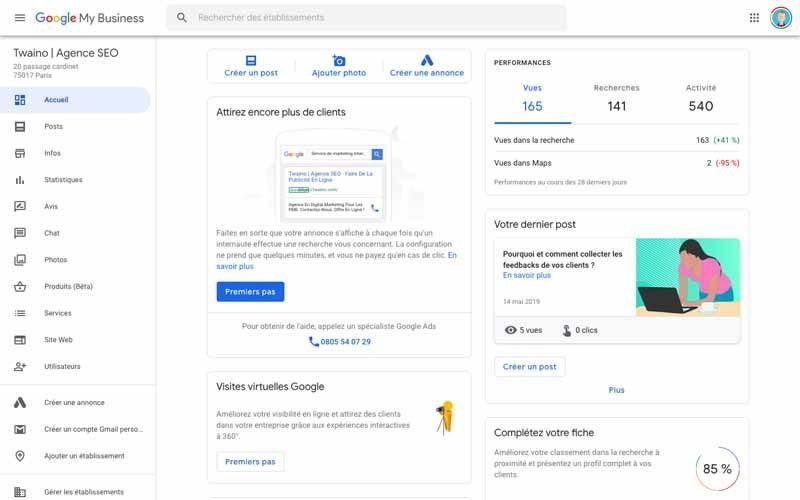

Google My Business

Google My Business est un outil qui permet de créer et de mettre à jour une fiche d’entreprise. Il s’agit d’un important levier en SEO puisque les informations que vous définissez ici seront utilisées dans les résultats de recherche locaux et affichent votre entreprise dans Google Maps.

Il sera également utilisé pour afficher un panneau Business à droite des résultats de la recherche traditionnelle dans les SERPs qui comprend entre autres :

- Des images ;

- L’emplacement sur la carte ;

- Les informations sur les heures d’ouverture ;

- Le numéro de téléphone ;

- Le site Web ;

- Etc…

Son utilisation présente beaucoup d’avantages et je vous invite à consulter mon article sur la création et le paramétrage de Google My Business.

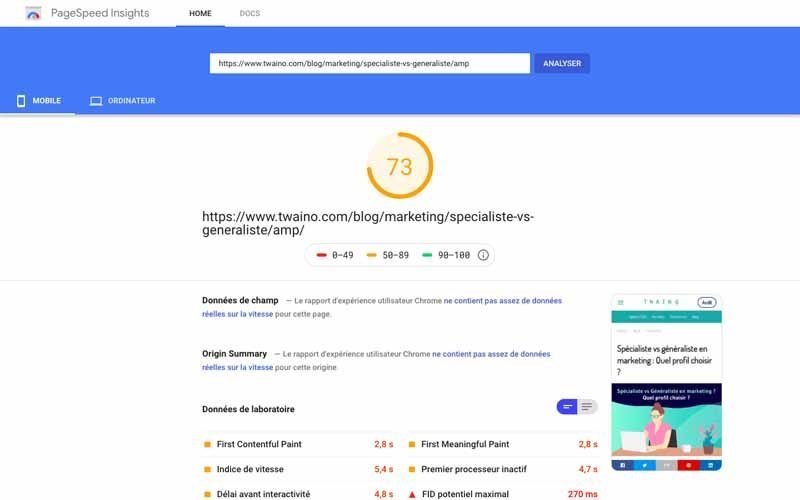

Google PageSpeed Insights

Google PageSpeed Insights est un outil qui permet d’analyser le contenu d’un site Web afin de déterminer la vitesse de la page ainsi que les démarches à suivre pour l’accélérer. Google donne plus d’explication sur son outil dans son article parlant de PageSpeed Insights.

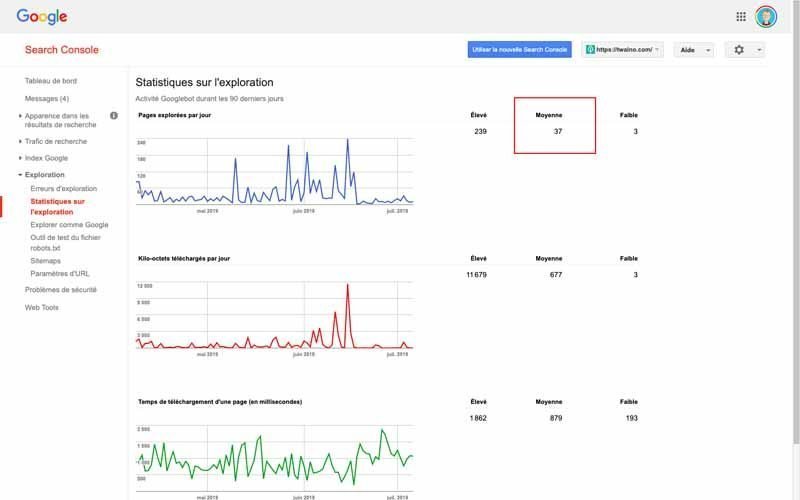

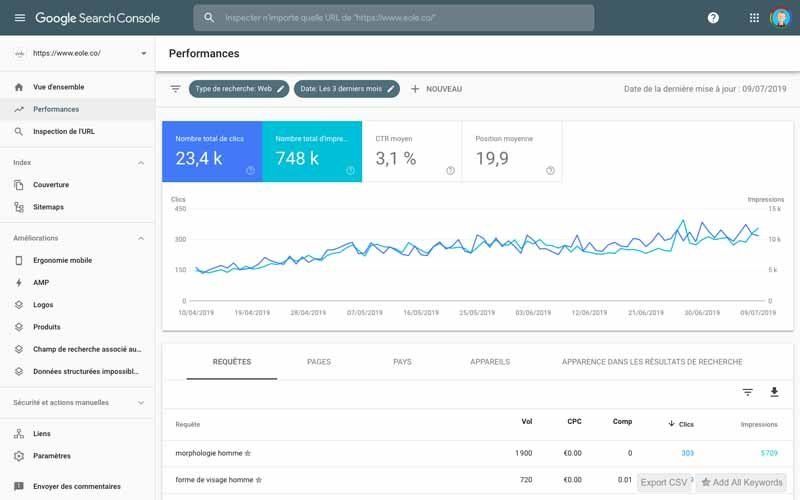

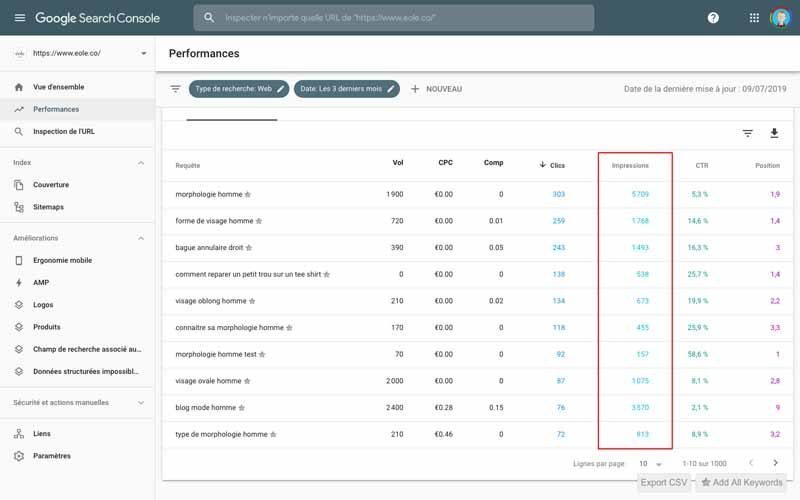

Google Search Console

Initialement appelé Webmaster Tools, la Search Console est un outil avancé pour optimiser la visibilité des sites dans ses résultats de recherche. Pour la firme américaine, cet outil est : « un service gratuit que nous vous offrons pour vous aider à contrôler et maintenir la présence de votre site dans les résultats de recherche Google, et à résoudre tout problème qui pourrait se poser. Il n’est pas nécessaire de vous inscrire à la Search Console pour apparaître dans les résultats de recherche Google. Cependant, en vous inscrivant, vous pourrez mieux comprendre comment s’affiche votre site de notre côté et optimiser son classement dans les résultats de recherche. »

Pour aller plus loin sur le sujet, consultez cet article qui montre également les démarches à suivre vous inscrire sur la Search Console.

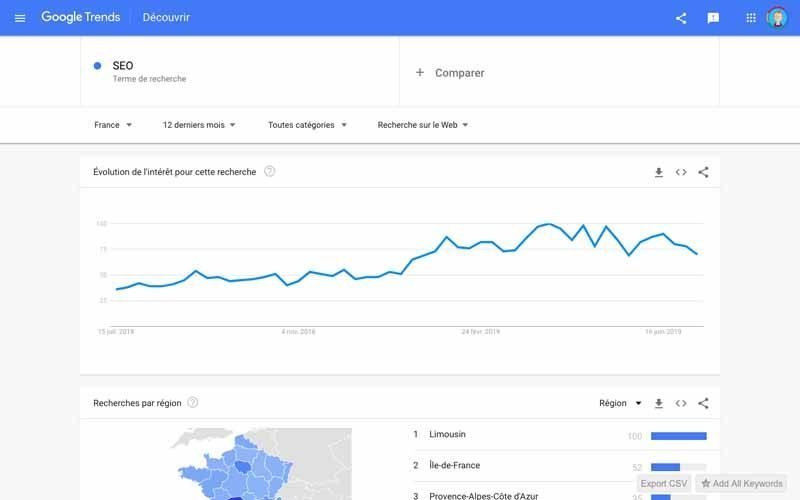

Google Trends

Google Trends est un autre outil de Google qui permet de vérifier la tendance des mots-clés et des expressions, via des graphiques qui indiquent le volume de recherche sur une période de temps.

Ce sont donc de précieuses informations qui sont susceptibles de vous aider dans l’élaboration d’une bonne stratégie, d’autant plus que la tendance des mots-clés ou thématiques semble souvent changer au cours de l’année. En cela, vous pourrez créer vos contenus en intégrant vos mots clés suivant leur volume de recherche au cours de l’année.

Le support de Google apporte quelques informations sur son outil, mais si vous souhaitez aller plus loin, Ahrefs est une bonne source à consulter.[fusion_menu_anchor name= »H » class= » »][/fusion_menu_anchor]

Grey Hat

Le Gray Hat comprend les pratiques SEO qui sont techniquement autorisés, mais qui sont douteux d’un point de vue éthique. L’une de ces pratiques est l’achat/vente de liens qui est quasiment intraçable lorsqu’ils ont un rapport direct avec votre thématique.

Il est vrai que cette pratique ne vous pénalise pas directement, mais elle n’est pas considérée comme éthique. Il en va de même pour l’achat des mentions « j’aime » et « partage » sur les médias sociaux.

H

HTML sitemap ou sitemap HTML

Contrairement au sitemap XLM dédié aux moteurs de recherche, le sitemap HTML est destiné aux visiteurs et se présente sous la forme d’une liste à puces. Ainsi, il affiche les liens vers toutes les pages du site en montrant sa hiérarchie, ce qui aide les visiteurs à naviguer facilement.

Le sitemap HTML est souvent établi pendant la phase de développement du site web afin d’assurer une structure cohérente qui permettra d’offrir une expérience utilisateur optimale.

Bien qu’ils n’aient pas le même poids en termes de SEO que les sitemaps XML, ils ne sont pas complètement sans valeur SEO et il est pertinent de créer un bon plan de site.

Hypertext Transfer Protocol (HTTP)

Connu aussi sous le nom de Protocole de Transfert Hypertexte en français, le HTTP est le protocole de communication qui permet de montrer et de recevoir des informations sur le web. En termes de SEO, il est préférable d’utiliser le type sécurisé HTTPS.

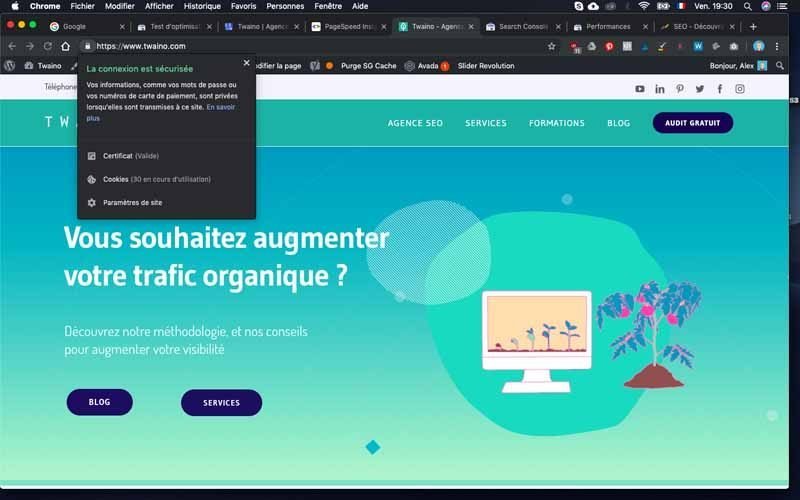

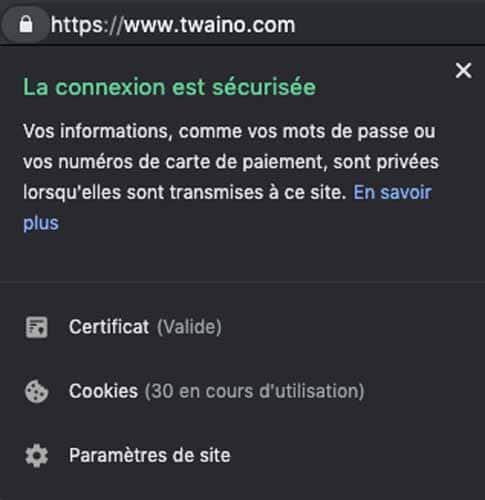

Hypertext Transfer Protocol Secure (HTTPS)

Le Protocole de Transfert Hypertexte Sécurisé est la variante sécurisée du HTTP avec l’usage du protocol SSL ou TLS. Google le défini comme : « un protocole de communication Internet qui protège l’intégrité ainsi que la confidentialité des données lors du transfert d’informations entre l’ordinateur de l’internaute et le site. ».[fusion_menu_anchor name= »I » class= » »][/fusion_menu_anchor]

La firme ajout également : « Nous vous encourageons à adopter le protocole HTTPS afin de permettre aux internautes de consulter votre site Web en toute sécurité, quel que soit son contenu. »

En effet, Google privilégie des sites web sous protocole HTTPS dans son classement et si vous êtes toujours en HTPP, passer en HTPPS pour améliorer votre référencement.

I

Image SEO

Image SEO ou le référencement d’image se réfère aux différentes pratiques d’optimisation des images d’un site Web dans le but d’augmenter la pertinence du contenu, la visibilité sur les moteurs de recherche et l’accessibilité sur l’écran des lecteurs.

Les actions à mener pour ce genre de référencement sont entre autres :

- L’utilisation de noms de fichiers descriptifs ;

- Le choix de fichier de qualité avec la bonne la taille ;

- L’ajout de balises alt avec description de ce qui se trouve sur l’image

- La création de sitemaps d’images ;

- Etc….

Pour aller plus loin sur le sujet, consultez cette ressource de webrankinfo afin d’optimiser vos images.

Image sitemap

Il s’agit d’un fichier XML qui comprend toutes les images de votre site Web que vous souhaitez crawler et indexer par les moteurs de recherche. Il peut s’agir d’un fichier séparé ou ajouté au sitemap XML existant.

Google estime que : « Les informations relatives aux sitemaps pour images nous permettent d’identifier des images susceptibles de ne pas être prises en compte autrement (par exemple les images accessibles par le biais de code JavaScript), et de nous indiquer les images de votre site que vous souhaitez nous voir explorer et indexer ».

La création de ce fichier peut donc vous aider à améliorer l’indexation des pages de votre site web, ce qui est toujours un point de plus pour votre SEO.

Impression

Chaque fois qu’une annonce est affichée sur l’écran de l’utilisateur ou qu’un site Web est affiché dans les résultats des moteurs de recherche est considéré comme une impression.

Index

L’index est la base de données d’un moteur de recherche et comprend toutes les données que le crawler a pu explorer sur les sites web. Lorsqu’un site ou une page web se retrouve dans les résultats des moteurs de recherche, il est inclus dans l’index. Dans le cas contraire, il n’est pas dans l’index.

Il est très facile de vérifier si vos pages web ou votre site sont inclus ou dans l’index des moteurs de recherche.

Indexation

L’indexation est le processus d’inclusion d’un site ou des pages web dans l’index des moteurs de recherche. L’indexation suit immédiatement l’exploration des robots des moteurs de recherche. Toutefois, Google estime que : « Même si la plupart des pages sont explorées avant l’indexation, Google peut également indexer des pages sans avoir accès à leur contenu (par exemple, si une page est bloquée par une directive robots.txt) ».

Votre site web peut ne pas être indexé rapidement et pour accélérer le processus, je vous invite à consulter mon article sur l’indexation par Google.

Infographie

Les infographies sont aimées et partagées trois fois plus que les autres types de contenu, il convient donc de les inclure dans une stratégie de création de contenu. En effet, ce sont des représentations graphiques ou visuelles d’informations qui permettent une lecture rapide et facile.

Elles sont plus engageantes qu’un article classique puisqu’elles transmettent des données complexes de manière simple. De plus, ils prennent parfois moins de temps à créer et obtiennent plus de liens naturels. [fusion_menu_anchor name= »K » class= » »][/fusion_menu_anchor]

Interstitiels

Un interstitiel est une page promotionnelle incluse dans le contenu ordinaire d’un site internet. Il s’agit par exemple des pop-ups intrusifs qui couvrent toute la page du site web et que l’utilisateur doit fermer manuellement pour continuer sa navigation. Cet type de contenu impact négativement l’expérience utilisateur et votre site web peut faire l’objet de pénalité si les interstitiels sont utilisés abusivement.

K

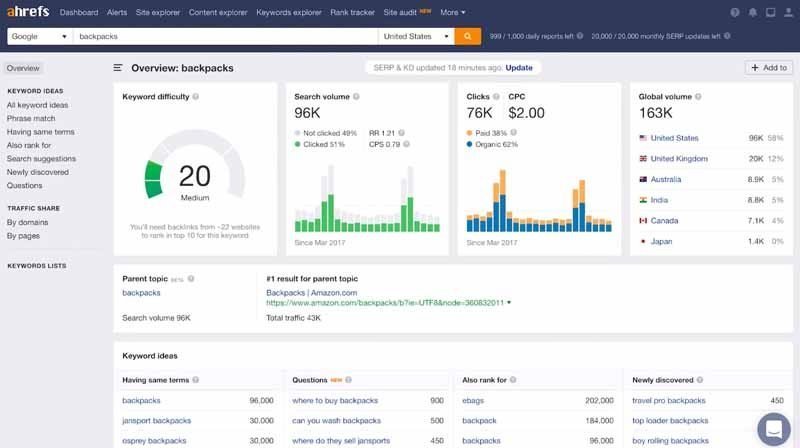

Keyword analysis ou Analyse de mots-clés

Il s’agit du processus d’évaluation de tous les mots-clés que vous utilisez ainsi que ceux que vous avez découverts au cours de la recherche de mots-clés. Plusieurs paramètres sont à considérer et vous pouvez vous servir des outils tels que :

- Ahrefs

- SemRush ;

- Keyword Spy ;

- Long Tail Pro ;

- SpyFu ;

- Quicksprout ;

- Alexa ;

- Etc…

En maîtrisant ces outils d’analyse, vous pouvez facilement choisir les bons mots clés pour améliorer votre référencement.

Keyword cannibalization ou cannibalisation de mots-clés

Selon seoquantum, : « La cannibalisation de mots-clés survient lorsque plusieurs pages d’un même site sont optimisées sur un même mot-clé. »

En fait, ce phénomène affecte généralement les blogs ayant de gros volumes de contenu, d’autant plus que certains mots clés auront tendance à être répétés. Notez que la cannibalisation de mots clés peut avoir des conséquences négatives sur le référencement et vous faire baisser en termes de classement dans les résultats.

Il convient donc d’identifier si votre site web fait l’objet de cannibalisation de mots clés et d’adopter des pratiques pour la combattre ou pour l’éviter.

Keyword competition ou compétition de mots clés

Il s’agit d’une mesure qui permet de déterminer à quel point il est difficile ou facile de se positionner sur un mots clé compte tenu de la concurrence. En effet, le trafic pour les mots clés populaire ou qui font l’objet d’un grand nombre de requêtes est généralement élevé. Ce qui incite beaucoup de référenceurs à se positionner sur ces mots clés, augmentant du coup la concurrence. Pour cette raison, il est très important d’analyser et de choisir des mots clés stratégiques.

Keyword funnel

Mettre en place un funnel de vente ou de conversion est une stratégie qui permet d’augmenter significativement les ventes. Cette technique marketing se base sur le processus d’achat des consommateurs qui se compose de plusieurs étapes que vous pouvez optimiser avec certains mots clés, c’est-à-dire les keywords funnels. Vous pouvez d’ailleurs les classer selon ces étapes afin d’augmenter votre taux de conversion.

Keyword proximity ou proximité des mots clés

La proximité des mots clés correspond à la distance des mots-clés sur une page web. Par exemple, pour les expressions « proximité des mots-clés » et « proximité de vos mots-clés », la distance entre les mots « proximité » et « mots-clés » ne sont pas les mêmes. Le concept de Keyword proximity indique que plus la distance est courte, plus la page web devient pertinente.

Keyword rank

Il s’agit de votre position dans les listes SERP pour un mot-clé spécifique et plusieurs outils permettent de déterminer son keyword rank dont :

- SEMrush ;

- AccuRanker ;

- Ahrefs ;

- SERPWatcher ;

- Google Rank Checker ;

- SERP’s Keyword Rank checker ;

- SEOCentro Rank Checker ;

- Etc…

Keyword stuffing ou accumulation de mots-clés

Le bourrage de mots clés est une pratique black hat SEO qui consiste à répéter un mot-clé de nombreuses de fois sur la même page, et ce, dans l’objectif de faire croire aux algorithmes que le contenu est pertinent pour ce mot-clé.[fusion_menu_anchor name= »L » class= » »][/fusion_menu_anchor]

A ce sujet, Google indique : « L’insertion de mots clés ou de nombres dans les pages a des effets négatifs sur le confort de navigation des internautes et peut nuire au classement de votre site. Efforcez-vous de créer un contenu utile et pertinent qui utilise les mots clés de manière appropriée et en contexte. ».

L

Landing page ou Page d’atterrissage

La page d’atterrissage est une page spécifique qui apparaît lorsqu’un internaute clique sur un lien. Elles sont généralement liées à des campagnes marketing et sont souvent optimisées pour la conversion ou pour la promotion.

Les landing pages jouent un rôle capital notamment lorsque vous mettez en place un funnel de conversion afin de générer efficacement des ventes. Pour cela, il convient d’utiliser les bonnes pratiques pour mettre en place vos landing pages.

Latent semantic indexing keyword ou Mot-clé d’indexation sémantique latente

Encore connu sous l’expression de mot-clé LSI, ce sont en réalité des mots ou des expressions sémantiquement liés à un mot-clé principal. En effet, les mots clés LSI partagent le même contexte et sont fréquemment utilisés ou trouvés ensemble. Il s’agit par exemple de « link », « linkbuilding », « backlink », etc…

Lsikeywords est un outil qui peut vous permettre de découvrir les mots clés LSI relatif à votre mots clé principal. Cela dit, il faudrait veiller à choisir les bons mots clés afin de muscler réellement votre stratégie SEO.

Lead magnet ou Aimant à leads

L’aimant à leads est un contenu dont le rôle est d’inciter les visiteurs ou clients potentiels à laisser leur courriel ou d’autres informations de contact. Il s’agit par exemple des ebooks gratuits qui sont proposés en échange de l’email des visiteurs d’un site web.

Cet instrument permet de constituer une liste d’adresses électroniques qui sera utilisée pour d’autres stratégies de marketing. La mise en place d’un lead magnet est une très bonne stratégie pour générer efficacement des prospects, mais elle dépend de votre capacité à générer du trafic. De plus, cette tactique n’apporte de réels résultats que si vous réussissez à créer le lead magnet parfait pour votre audience.

Lien interne ou internal link

Si la destination de votre lien se trouve sur votre site Web, il s’agit d’un lien interne. Des liens internes relient les pages de votre site Web et facilitent la navigation du visiteur et du robot de recherche. Il inclut non seulement les liens de navigation, mais aussi des liens où vous suggérez au visiteur quelle page visiter ensuite.

Utiliser la bonne stratégie de liens internes peut aider votre référencement, car vous pouvez contrôler la structure de votre site web et donner plus d’importance à certaines pages en les plaçant plus haut dans la hiérarchie.

Linkbaiting

Selon definitions-seo, le Linkbaiting : « désigne une stratégie visant à proposer, sur un site web, un contenu de qualité qui plaira aux internautes qui, eux-mêmes créeront d’eux-mêmes des liens vers lui. ».

Il s’agit d’une pratique très complexe et en même temps très bénéfice en termes de SEO. Vous pouvez réussir à la réaliser en suivant les conseils de Neil Patel.

Link building

Le link building ou la construction de liens est une technique qui comprend l’augmentation de la qualité et du nombre de backlinks vers un site donné. En effet, il s’agit d’une tactique très populaire en SEO et inclus des actions telles que :

- Rejoindre les blogueurs et les influenceurs ;

- Soumettre votre site web à un annuaire :

- Ecrire des articles invités ;

- Laisser des liens dans les commentaires de blogs et forums ;

- Etc…

Pour aller plus loin, je vous conseille de lire cet article de Neil Patel sur les bonnes pratiques de link building à adopter.

Link burst

Le link burst survient lorsque vous rassembler en très peu de temps un nombre important de backlinks. Toutefois, ce phénomène alerte très vite les moteurs de recherche qui cherchent à déterminer si le site en question est de bonne réputation et si les sites sur lesquels proviennent les backlinks sont de qualité.

Cela dit, le link burst est acceptable lorsqu’il s’agit d’un contenu viral qui à créer de nombreux backlinks.

Link farm

Connu en français sous l’expression ferme de liens, le link farm est une technique qui vise à manipuler les moteurs de recherche en utilisant un groupe de sites web qui sont tous liés. Ces derniers sont habituellement gérés par des programmes et services automatisés.

Il est à noter que de lourdes sanctions peuvent survenir et Google fait savoir que : « Tout lien destiné à manipuler le classement PageRank ou le classement d’un site dans les résultats de recherche Google peut être considéré comme faisant partie d’un système de liens et comme constituant une violation des consignes Google aux webmasters. »

Local citation ou citation locale

Il s’agit de toute mention de :

- La raison sociale ;

- L’adresse du site Web ;

- L’adresse physique ;

- Du numéro de téléphone d’une entreprise locale ;

- Etc…

Ces informations peuvent impacter le classement dans les moteurs de recherche locaux et faciliter la tâche, par la même occasion, aux utilisateurs pour trouver et connaître des entreprises. Il s’agit donc d’un concept à découvrir pour optimiser votre référencement local.

Local SEO ou Référencement local

Le référencement local regroupe toutes les pratiques utilisées pour l’optimisation du trafic basé sur la géolocalisation. En effet, 46 % des recherches sur Google ont un paramétrage local et il serait dommage en terme de référencement de ne pas se positionner sur ce levier.

Pour aller plus loin sur le local SEO, voici un guide complet de Neil Patel.

Local search ou Recherche locale

Selon definitions-marketing : « La recherche locale désigne, dans le domaine du référencement, une requête effectuée sur un moteur de recherche qui comprend un élément de localisation géographique comme par exemple « coiffeur Paris » ou qui par sa nature est considérée comme locale par Google. »

Long tail keyword ou mot-clé à longue traîne

Une expression très précise composée généralement de trois mots ou plus.[fusion_menu_anchor name= »M » class= » »][/fusion_menu_anchor]

Ils sont généralement utilisés par des personnes qui souhaitent obtenir une une information précise, ou qui sont sur le point de réaliser un achat. Le taux de conversion est donc généralement beaucoup plus élevé que les mots-clés ordinaires. Pour aller plus loin sur ce sujet, cet article de morningscore est susceptible de vous aider.

M

Mirror site ou Site miroir

Un site miroir est une réplique complète d’un site web qui présente une URL différente. Ils sont utilisés lorsque le site Web d’origine génère trop de trafic pour que le serveur puisse les prendre en charge.

Les sites miroirs servent la population dans différents endroits (différents continents) et assurent une bonne expérience utilisateur et un chargement rapide des pages.

Mobile-friendly website

Il s’agit d’un site internet optimisé pour s’afficher correctement sur un appareil mobile. Cela peut se faire de deux façons, soit en ayant une version mobile de votre site Web, soit en le rendant responsif. D’un point de vu SEO, nous recommandons bien évidemment la deuxième option.

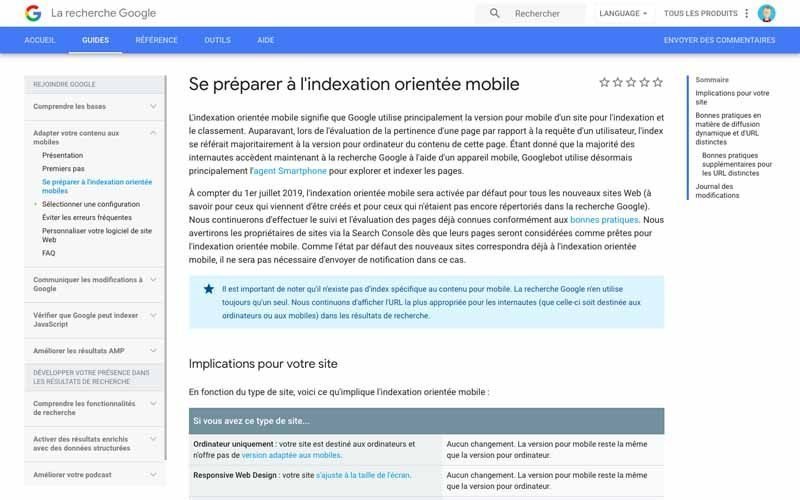

Mobile first indexing

Il s’agit d’une approche de l’indexation où la version mobile d’un site Web est explorée et indexée en premier. La version de bureau du site web sera toujours indexée et classée, mais s’il n’est pas optimisé pour le téléphone, cela aura un impact négatif sur le SEO.

Mot-clé

Il s’agit des mots ou expressions que les utilisateurs écrivent dans le champ de recherche dans le but d’avoir un contenu spécifique. Spécifier un mot-clé et l’utiliser dans votre contenu aide les robots des moteurs de recherche à catégoriser votre site Web et à l’afficher pour la bonne requête.

Pour découvrir les mots clés susceptibles d’augmenter votre trafic, installez Google Search Console qui est un outil très puissant.

Moteur de recherche

Un moteur de recherche est un programme qui recherche tous les fichiers sur le World Wide Web, les catégorise par mot-clé et les stocke dans une base de données. [fusion_menu_anchor name= »N » class= » »][/fusion_menu_anchor]

Lorsqu’un utilisateur saisit un mot-clé, le moteur de recherche affiche les fichiers qui sont considérés comme pertinents pour ce mot-clé.

Google, Bing, Baidu, DuckDuckGo, Yandex, Yahoo, Ask.com, Wolframalpha et AOL.com sont actuellement les moteurs de recherche les plus utilisés.

N

Negative SEO

Cette pratique est utilisée par les personnes qui veulent détruire la e-réputation de leurs concurrents. Elle consiste à enfreindre les consignes de tous les moteurs de recherche en général et de Google en particulier. De multiples techniques sont utilisées pour cette pratique. Il est cependant possible non seulement de savoir lorsqu’on est victime du Negative SEO, mais également de se protéger contre cet usage.

NoIndex

Il s’agit d’un attribut qu’on ajoute à une balise meta robots. Grâce à lui, les moteurs de recherches sont informés que la page ne doit pas être indexée dans leur base de données. Plusieurs raisons peuvent être à la base d’une telle décision notamment lorsque le site web est en plein construction.

Toutefois, Google a annoncé que cette méthode ne sera plus pris en compte à partir de fin août 2019. Il faudra donc trouver une alternative si vous êtes de ceux qui l’utilisent.

Nofollow

Il s’agit ici d’une des valeurs de l’attribut rel. Son rôle est d’indiquer « qu’un lien ne doit pas être suivi ». On peut décider d’utiliser Nofollow pour plusieurs raisons. Mais attention, il s’agit d’une valeur qui ne serait également plus prise en compte par Google à partir de Septembre 2019.

Noogler

Ce terme désigne une personne nouvellement employée chez Google. On reconnaît une telle personne par la casquette faite dans les couleurs de la société et surplombée d’une hélice qu’elle porte à ses débuts. Parmi les porteurs de la casquette qui ont fait le buzz, on peut reconnaître l’illustre Danny Sullivan.

(Not provided)

Google utilise ces mots afin de « protéger la vie privée » de ses utilisateurs. En effet, lorsque vous naviguez sur le moteur de recherche, que ce soit en mode privé ou en mode connecté, vos requêtes ne sont plus envoyées aux outils de mesure d’audience. Il sera plutôt affiché les termes « not provided » ou « Aucune donnée n’est disponible pour cet affichage » pour Google Analytics. [fusion_menu_anchor name= »O » class= » »][/fusion_menu_anchor]

N’oublions cependant pas que Google est un grand publicitaire. Par conséquent, sa conception de « protection de la vie privée » est un peu revue à la baisse lorsqu’il s’agit de liens sponsorisés ou de SEA. Dans ces cas-là, les requêtes sont bel et bien affichées.

O

Obfuscation de lien

Il s’agit d’un procédé qui masque un lien aux robots Google, mais qui le laisse disponible aux internautes. C’est une pratique qui permet d’optimiser le maillage interne d’un site web ainsi que la « distribution de jus entre les pages ».

Elle est utilisée la plupart du temps comme alternative lorsqu’on ne peut se servir du noindex ni du nofollow notamment dans le cas des liens « Qui sommes-nous ? » ou « Mentions légales ». Ces pages n’ont en effet pas d’utilité pour le référencement naturel, mais peuvent être utiles aux internautes et parfois même obligatoire d’un point de vue légal. C’est grâce au Javascript que l’obfuscation des liens peut être mise en place.

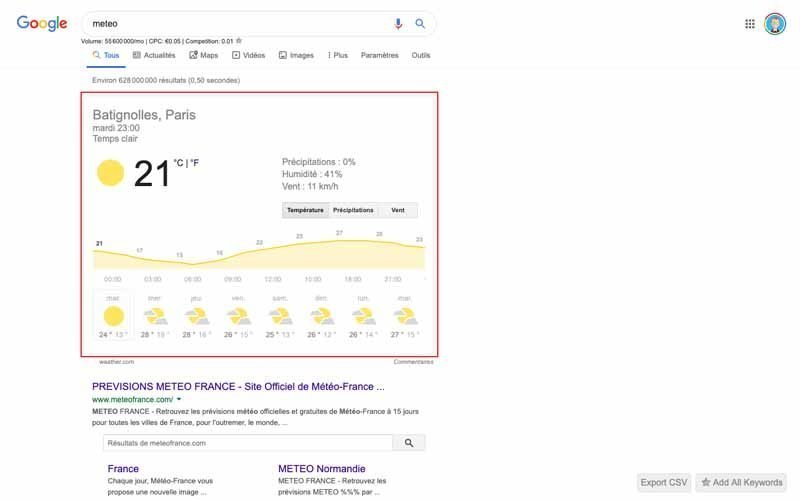

Onebox

Autrement connu sous le nom de « Direct Answer » ou encore « Answer Box », est une boîte d’affichage au sein des résultats de recherche. Il peut être accompagné soit d’une image soit d’un symbole.

On le retrouve à la position zéro dans les SERP Google (un peu comme les featured snippets). Le Knowledge Graph souvent confondu au Onebox est une forme spécifique de ce dernier. [fusion_menu_anchor name= »P » class= » »][/fusion_menu_anchor]

À noter que le Onebox n’est pas une pratique qui est automatique : seules quelques requêtes déclenchent son affichage. Par conséquent, on ne peut pas vraiment mettre en place une stratégie SEO pour être sûre d’y apparaître. Voici comment peut se présenter un Onebox.

P

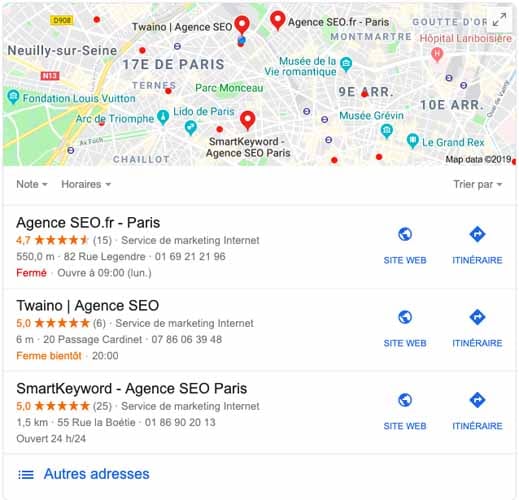

Pack Local

Lorsqu’une requête est locale, Google affiche les résultats locaux dans un emplacement donné qui est dénommé « pack local ». Un pack local est constitué de plusieurs informations telles qu’une carte Google Maps ainsi que les numéros… des établissements associés à la requête effectuées.

Le pack local s’affiche en lot de 3 depuis 2015. Pour être placé dans ce pack, il faut avoir optimisé son référencement local. Cela peut se faire si vous êtes inscrit sur Google My Business.

PageRank

Mis au point par l’un des cofondateurs de Google, Larry Page et marque déposée par celui-ci, le PageRank est un algorithme qui permet d’évaluer la popularité d’une page web afin de l’indexer convenablement avant sa présentation aux internautes.

Le PageRank a beaucoup moins d’importance aujourd’hui qu’à ses débuts, mais il constitue toujours un élément clé pour le référencement naturel. On associe souvent le PageRank au link juice ou au ToolBar PageRank, aujourd’hui disparu.

Pagination

Par définition, la pagination est une technique pour organiser les pages sur un site web. C’est une numérotation que l’on retrouve souvent soit en haut soit en bas du site. Pour cette pratique, on utilise des balises de pagination.

Panda

Cet algorithme de Google a été créé en 2011. Son rôle est de vérifier si le contenu de votre site web est pauvre qualitativement ou quantitativement et s’il mérite d’être vu par les internautes.

PBN ou Private Blog Network

Le Private Blog Network ou Réseau de Blog Privé en français, est comme son nom l’indique un réseau de sites interconnectés et qui sont tous reliés à un site web principal qu’on appelle le money site.

Le PBN vise à « pousser » ce dernier afin qu’il soit mieux indexé et référencé par les moteurs de recherche. À noter que le PBN est une pratique qui est prohibée par Google. Si vous voulez quand même enfreindre les consignes, vous devrez être très prudent.

Pénalités mensuelles

Désignées comme « Actions mensuelles » par Google, les pénalités mensuelles sont une sorte de contravention que le moteur de recherche envoie aux utilisateurs ayant enfreint les « guidelines ». Ces pénalités sont envoyées par les évaluateurs de Google, soit par la Google Search Quality, soit par la Webspam Team.

Vous êtes donc susceptibles de recevoir un message dans votre boîte mail si des internautes ont signalé votre site comme contenant trop de spams, trop de liens artificiels ou autres.

C’est dans la Search Console que vous retrouverez les pénalités mensuelles au niveau de l’onglet « Trafic de recherche ». Heureusement, il y a des mesures que vous prendre lorsqu’une pénalité mensuelle vous a été adressée.

Penguin

Le rôle de ce filtre algorithmique est de pénaliser les sites web qui utilisent les méthodes de suroptimisation du SEO. Depuis l’année 2016, Penguin a un fonctionnement en temps réel. Autrement dit, si vous recevez une pénalité, elle est immédiatement prise en compte par l’algorithme. Ainsi, vous ne risquez pas d’être trop affectée par la pénalité si vous la corrigez rapidement.

Par ailleurs, il est intéressant de savoir que la définition française de Penguin n’est pas pingouin. Ce dernier est un oiseau marin qui peut voler tandis que le manchot qui est la traduction de Penguin ne peut voler.

Pogo Sticking

Ce terme désigne l’action de l’internaute qui va cliquer de manière successive sur chaque lien se trouvant sur une page web et qui va toujours revenir à la page de départ grâce à la touche « retour » de son navigateur.