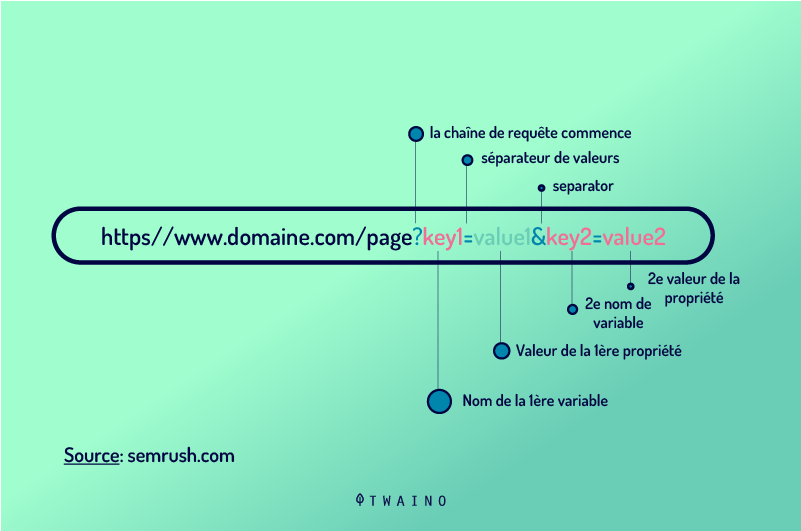

Encore appelés « chaînes de requête » ou « paramètres de requête d’URL”, les paramètres d’URL représentent un moyen de suivi des informations et du trafic d’un site web. Il s’agit des données dynamiques insérées dans la chaîne d’URL après exécution de la requête afin de filtrer les informations supplémentaires sur un site donné, ou pour structurer les contenus du site.

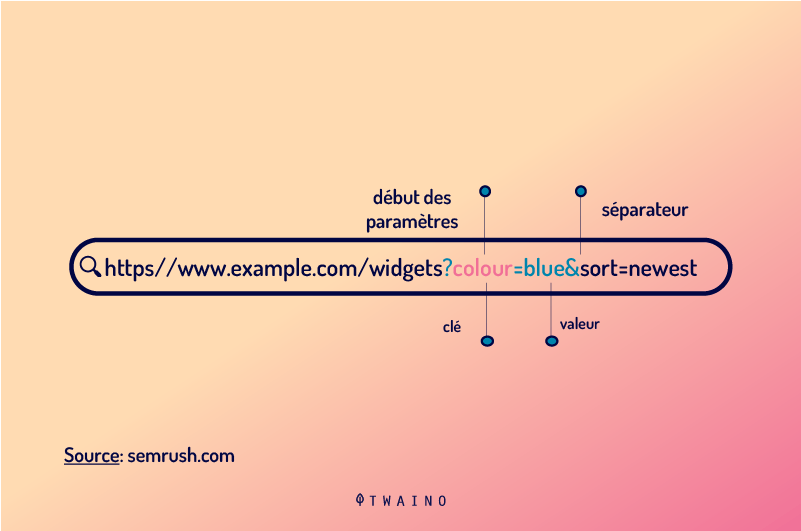

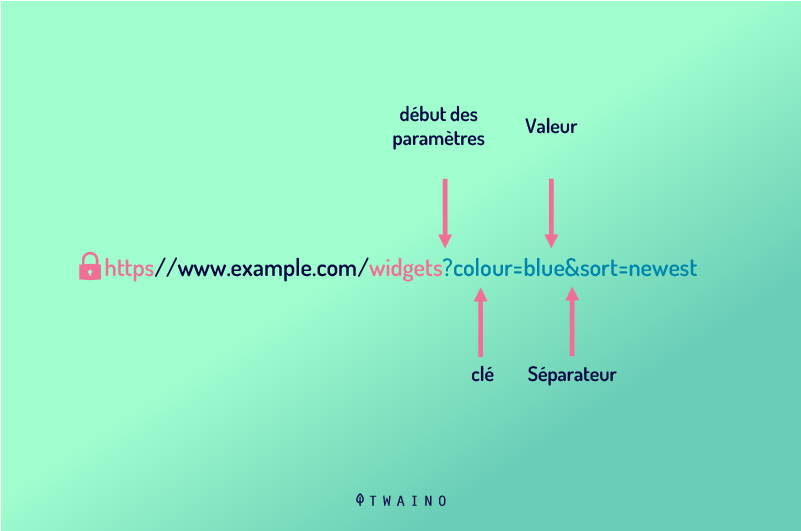

Les paramètres d’URL se retrouvent généralement dans la chaîne après le symbole (?). Ils sont constitués d’une clé et d’une valeur séparées par le signe égal (=). Cependant, on peut ajouter plusieurs paramètres d’URL dans une chaîne en les séparant par le symbole esperluette (&).

Les chaînes de requêtes font partie intégrante de l’URL d’un site web et constituent un grand atout pour les professionnels de référencement.

Cependant, ils peuvent être la source de nombreux problèmes pour les sites web surtout lors de classement des pages web dans les SERP de Google.

- Comment résoudre les problèmes occasionnés par les paramètres ?

- Ne vaut-il pas le coup de supprimer les paramètres d’URL ?

J’exposerai dans cet article tous les détails sur l’utilisation des chaînes de requêtes en partant de la définition aux différentes techniques de résolution des problèmes de paramètres d’URL.

Chapitre 1 : Qu’est-ce qu’un paramètre d’URL ?

Les paramètres d’URL sont des éléments dynamiques constitutifs d’une chaîne de requête. Comprenez par chaîne de requête la partie de l’URL qui succède un symbole de point d’interrogation (?).

Exemple : www.dynamicurl.com/query/thread.php?threadid=64&sort=date=64&sort=date

Dans cette chaîne, tous les éléments qui viennent après le (?) sont appelés « Paramètres d’URL”.

1.1. De quoi sont constitués les paramètres d’URL ?

La constitution d’une chaîne aléatoire d’URL peut vous sembler très compliquée à première vue. Surtout le mélange des lettres, de chiffres et de symboles vous donnera sûrement l’impression d’un code assez compliqué à déchiffrer.

Mais en vrai, vous pouvez donner un sens à tous les éléments ou données qui constituent une chaîne d’URL une fois que vous arrivez à comprendre l’anatomie d’un paramètre d’URL. Voici les différents éléments possibles que vous pouvez retrouver dans une chaîne d’URL :

- Le point d’interrogation (?) : Le point d’interrogation marque dans une chaîne d’URL le début d’un paramètre d’URL. Exemple : www.dynamicurl.com/query/thread.php?threadid=64&sort=date=64&sort=date (?threadid=64&sort=date=64&sort=date) ;

- L’Esperluette : On utilise les esperluettes lorsqu’il y a plusieurs paramètres dans la chaîne d’URL. La présence d’une esperluette marque la fin d’un paramètre d’URL et le début d’un autre. Exemple : (?threadid=64&sort=date=64&sort=date) ;

- Le nom de la variable ou “Clé” : Il s’agit du titre ou l’étiquette du paramètre d’URL. Exemple : ?threadid=64&sort=date=64&sort=date ;

- La valeur : Il s’agit de la valeur spécifique séparée du nom de la variable par un signe égal (=). Exemple : ?threadid=64&sort=date=64&sort=date.

Les paramètres d’URL sont normalement utilisés pour accomplir deux missions principales : améliorer le contenu d’une page et traquer les informations concernant le clic via l’URL. A partir de ces deux types d’utilisation, on distingue deux principaux paramètres d’URL à savoir : Les paramètres d’URL actifs et passifs.

- Les paramètres d’URL actifs encore appelés Paramètres modificateurs de contenus : Ce type de paramètre d’URL est utilisé pour modifier le contenu des pages d’un site web.

Exemple :

- Réorganisation de contenu : (?sort=price_ascending) “Afficher les contenus dans un ordre particulier sur une page web”.

- Pour segmenter les contenus d’une page : (?page=1, ?page=2, ?page=3). Ce paramètre d’URL est utilisé pour segmenter un contenu volumineux en trois petites parties.

- Pour limiter le contenu : (?type=yellow). Ce paramètre d’URL est utilisé pour faire apparaitre uniquement les contenus en “Jaunes” sur une page web.

Pour rediriger un contenu spécifique (A) par exemple, il vous suffit d’insérer dans l’internaute sa chaîne : http://domain.com?productid=A

- Les paramètres d’URL passives : Contrairement aux paramètres d’URL actifs, les passifs ne modifient pas les contenus d’une page web, mais sont plutôt utilisés pour le suivi de clic à travers l’URL. Ces paramètres permettent d’avoir toutes les informations sur le clic, c’est-à-dire la provenance, la campagne, etc. Ces données vous serviront lors de l’évaluation de la performance de vos récentes campagnes marketing. Voici quelques exemples de paramètres d’URL passifs.

Exemple :

- Les paramètres d’URL passifs peuvent être utilisés pour identifier les visites ou sessions d’un site. Pour suivre le trafic de votre campagne emailing, vous pouvez insérer dans la chaine : https://www.domain.com/?utm_source=emailing&utm_medium=email.

- Les paramètres d’URL peuvent être utilisés pour identifier la provenance et toutes les données (la source, le support et même la campagne) liées à une visite sur un site web. Pour collecter les données d’une campagne : https://www.domain.com/?utm_source=twitter&utm_medium=tweet&utm_campaign=summer-sale.

- Enfin, les paramètres d’URL peuvent aussi jouer le rôle d’identifiants d’affiliation. Cette fonctionnalité est souvent utilisée par les blogueurs et les influenceurs pour générer des revenus par clic.

1.2. Comment appliquer les paramètres d’URL ?

Sur les boutiques en ligne par exemple, les paramètres de requête d’URL sont couramment utilisés pour faciliter la navigation aux utilisateurs. En effet, les paramètres sont exécutés dans ce cas pour trier et sélectionner les pages de catégories spécifiques.

Cela permet de rediriger l’internaute directement vers les produits susceptibles de l’intéresser. Ils pourront également afficher un nombre défini d’éléments par page en triant les pages en fonction des filtres.

Par ailleurs, les paramètres d’URL passifs sont beaucoup utilisés par les spécialistes du marketing numérique. Ces paramètres leur permettent de suivre la provenance du trafic sur leur site web afin de déterminer la portée ou le succès de leur dernier investissement dans une stratégie marketing numérique.

Voici quelques cas d’utilisation des paramètres d’URL les plus récurrents :

- Filtrage de contenu : Choisir les pages à afficher en fonction des couleurs et des prix de produit sur une boutique en ligne par exemple : ?type=widget, color=blue ou ?price-range=20-50 ;

- Suivi du trafic : ?utm_medium=social, ?sessionid=123 ou ?affiliateid=abc ;

- Traduction : ?lang=fr, ?language=de ou ;

- Réorganisation des contenus d’une page web : ?sort=prix le plus bas, ?order=le mieux noté ou ?so=le plus récent ;

- Identifier un produit dans une catégorie : ?product=small-blue-widget, categoryid=124 ou itemid=24AU ;

- Segmentation du contenu d’une page : ?page=2, ?p=2 ou viewItems=10-30 ;

- Faire une recherche spécifique : ?query=users-query, ?q=users-query ou ?search=drop-down-option.

Chapitre 2 : Les différents problèmes de référencement causés par les Paramètres d’URL

Aussi bons et utiles qu’ils soient, il est important pour tout référenceur ou expert en SEO de modérer ou de rester autant que possible à l’écart de l’utilisation des paramètres d’URL. En effet, les paramètres d’URL ont tendance à créer beaucoup de problèmes susceptibles d’impacter le référencement d’un site web.

Il s’agit des problèmes liés à la consommation excessive du budget d’exploration empêchant ainsi les robots d’exploration de parcourir les pages web et de faire l’indexation. Une erreur de structuration des paramètres d’URL passifs par exemple peut entraîner la création de contenu en double.

Retrouvez dans ce chapitre les probables ennuis susceptibles d’être un obstacle au référencement de votre site causé par les paramètres d’URL.

2.1. La création de contenu en double

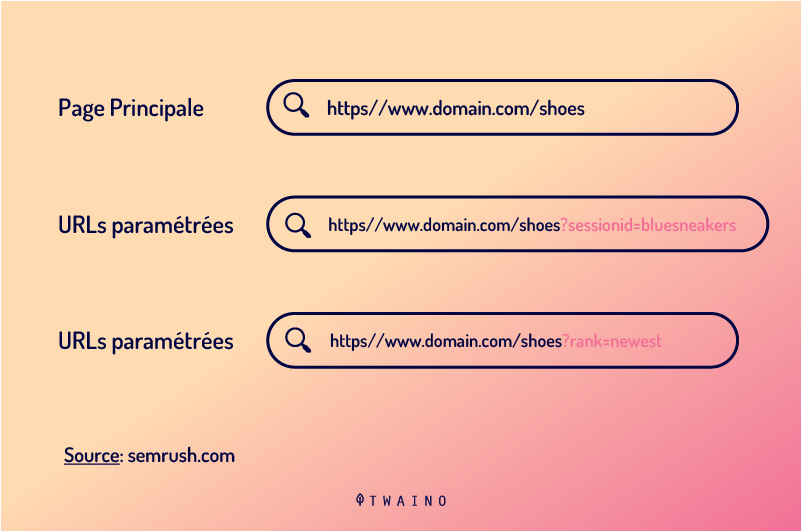

Google et les autres moteurs de recherche considèrent chaque URL comme une page web entière. De ce fait, plusieurs versions de la même page créée avec les paramètres d’URL seront considérées comme des pages indépendantes et donc des contenus en double.

L’utilisation des paramètres d’URL actifs pour réorganiser une page web n’apporte pas une grande modification à la page d’origine. Certains paramètres d’URL utilisés pour réorganiser une page web peuvent même présenter exactement la même page que la page initiale.

De même, une URL de page web comportant des balises de suivi ou un identifiant de trafic est identique à l’URL originale.

Exemple :

- URL statique : https://www.example.com / widgets

- Paramètre de suivi : https://www.example.com/widgets ?sessionID=32764

- Paramètre de réorganisation : https://www.example.com /widgets?sort=newest

- Paramètre d’identification : https://www.example.com ?category=widgets

- Paramètre de recherche : https://www.example.com/products ?search=widget

On peut constater qu’il y a plusieurs URL qui présentent toutes le même contenu. Si vous avez une boutique en ligne et que vous le faites pour chaque catégorie, cela va s’additionner et vous aurez un nombre considérable d’URL.

Le problème, c’est lorsque les robots d’exploration de Google vont visiter votre site. Une URL trouvée est considérée comme la présence d’une nouvelle page par les robots. Ils traiteront donc chaque paramètre d’URL comme une page indépendante.

Ils découvrent donc lors de l’exploration des contenus en double abordant le même sujet sémantique sur ses différentes URL considérées comme différentes pages. Inutile de vous rappeler que la duplication de contenu fait partie de ces infractions punies par Google.

Et même si la présence de ces paramètres d’URL qui créent des contenus en doubles n’est pas une raison suffisante pour que Google bannisse votre site des SERP, ils peuvent néanmoins provoquer la cannibalisation de mots-clés.

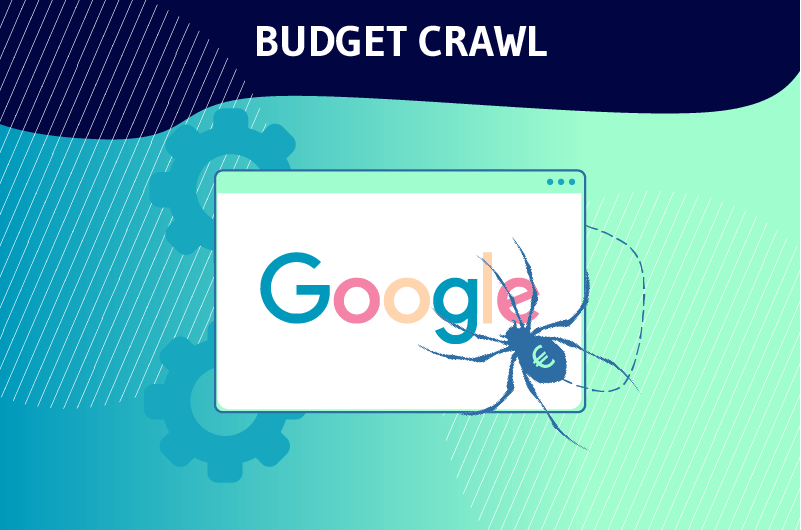

2.2. Gaspillage du budget d’exploration

Une structure d’URL assez simple est un atout pour l’optimisation de votre site. Un sitemap adapté permet aux robots d’indexation de parcourir facilement les différentes pages de votre site sans consommer beaucoup de bande passante.

Par contre, les URL complexes contenant beaucoup de paramètres provoquent la création de beaucoup d’URL pointant vers un même contenu. Cela rend plus complexe la structure de votre site web et fait perdre du temps aux robots d’exploration.

Le crawl ou l’exploration d’un site dont la structure est très complexe peut épuiser le budget d’exploration et réduire la capacité des robots à indexer vos pages web pour les positionner dans les SERP.

2.3. Les paramètres d’URL entraînent la cannibalisation de mots-clés

Étant donné que les différents paramètres ajoutés à l’URL d’origine ciblent le même contenu, donc les mots-clés identiques, l’indexation peut mettre en compétition différentes pages ciblant les mêmes mots-clés.

Ce fait peut amener les robots d’indexation à dévaloriser ces mots-clés. Ils peuvent considérer que toutes les pages contenant ces mots-clés n’apportent aucune valeur ajoutée aux utilisateurs.

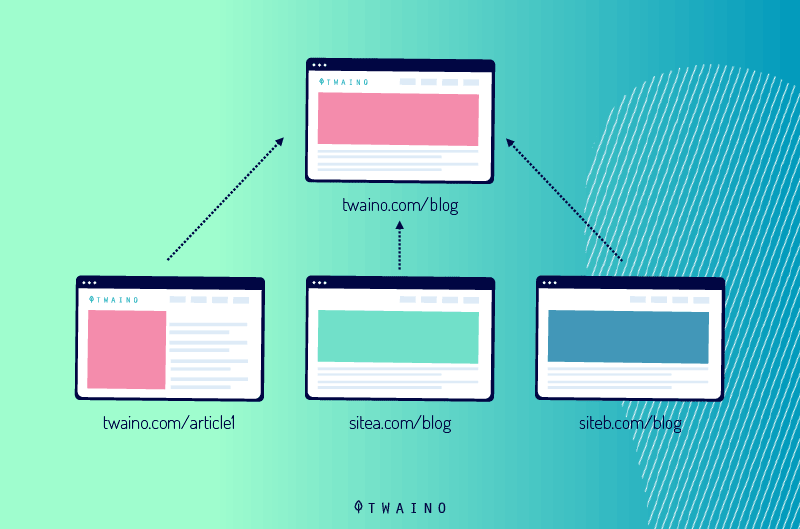

2.4. Les paramètres d’URL diluent les signaux de classement

Si vous avez plusieurs paramètres d’URL pointant vers le même contenu, les visites issues des partages sur les médias sociaux et les liens iront vers n’importe quelle version de votre page.

Non seulement cela vous fera perdre du trafic, mais vos pages ne seront pas bien positionnées.

En effet, la diversification des visites va embrouiller les robots d’exploration et diluera ainsi vos signaux de classement. Les robots deviendront incertains et auront du mal à savoir laquelle des pages concurrentes doit être positionnée dans les résultats de recherche.

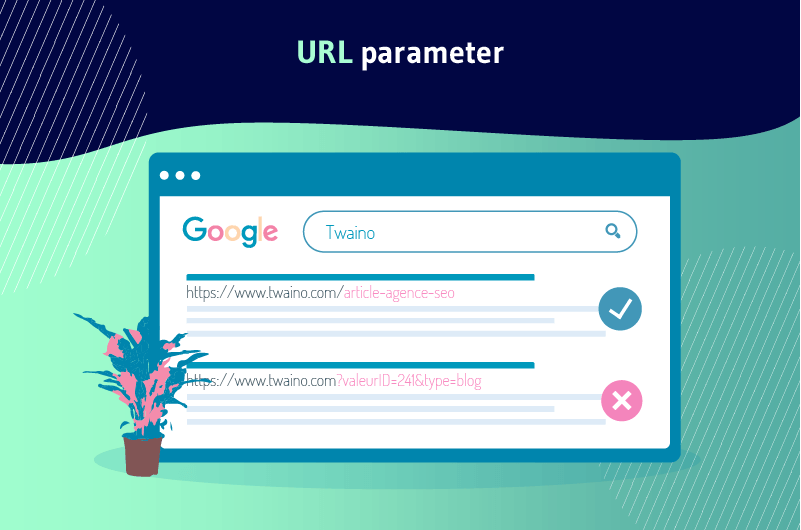

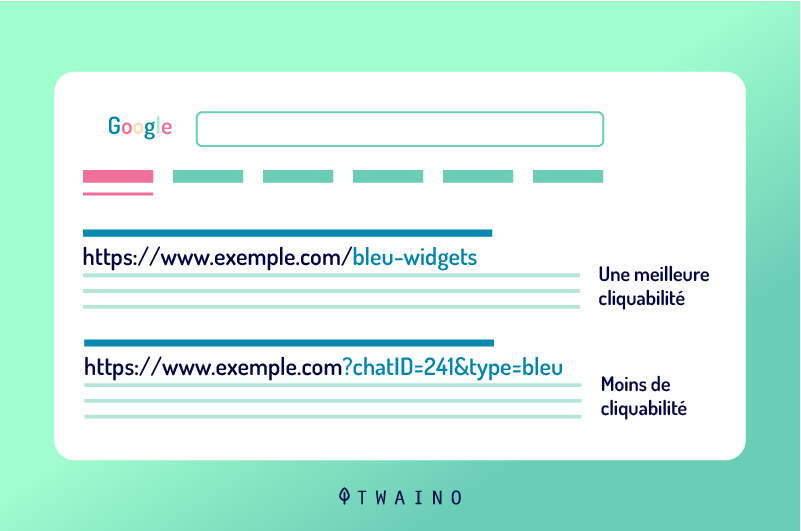

2.5. Les paramètres d’URL rendent moins attrayantes les URL

Pour une meilleure optimisation de votre site web, vos URL doivent être esthétiques, lisibles et simples à comprendre. Une URL comportant des paramètres est généralement complexe et illisible pour les visiteurs.

La présentation d’une URL paramétrée ne reflète pas la confiance parce qu’elles semblent être spammeuses. Il n’est donc pas probable que les utilisateurs cliquent dessus ou partagent.

Les paramètres d’URL peuvent ainsi avoir un impact négatif sur la performance de vos pages web. D’abord, les CTR peuvent faire partie des motifs de classement.

Mais vos pages ne bénéficient pas de ce motif parce que la complexité des URL va ralentir le taux de clic. Ensuite, le trafic provenant des réseaux sociaux, les e-mails… vont rabaisser aussi du fait que les utilisateurs auront de la méfiance vis-à-vis de votre URL paramétrée.

Il faut noter que l’implication des tweets partage, e-mails… dans le développement de la notoriété d’une page web ne sont pas aussi minimes.

En gros, une mauvaise lisibilité des URL de votre site web peut être un obstacle pour l’engagement de votre marque envers les clients ou les internautes en général.

Chapitre 3 : Comment gérer les paramètres d’URL pour qu’ils n’affectent pas le référencement de votre site ?

La plupart des problèmes de référencement occasionnés par les paramètres d’URL que j’ai mentionnés dans le chapitre précédent ont tous un point commun : le crawl et l’indexation des URL paramétrées. Néanmoins, cela n’empêche pas la génération de nouvelles URL paramétrées sur les sites web.

Découvrez comment résoudre les problèmes liés aux paramètres d’URL et créer de nouvelles URL via des paramètres sans causer des ennuis de référencement à vos pages web.

3.1. Déterminer l’ampleur des problèmes de paramètres d’URL

Avant d’entamer un processus de résolution des problèmes de paramètres d’URL sur un site web, il est important de connaître au préalable tous les paramètres insérés dans l’URL du site.

Sauf si votre développeur détient une liste complète de tous les paramètres d’URL, il vous sera un vrai casse-tête pour recenser tous les paramètres insérés dans l’URL de votre site.

Heureusement, vous n’aurez pas à paniquer pour cela.

Je vous présente en cinq étapes comment vous pouvez trouver tous les paramètres d’URL ainsi que le comportement des robots d’indexation.

- Utiliser un outil d’exploration : En exécutant un outil d’exploration comme Screaming Frog, vous pouvez retrouver la liste de tous les paramètres utilisés dans l’URL de votre site. Il suffit de rechercher le symbole (?) dans l’URL et vous recevrez tous les paramètres.

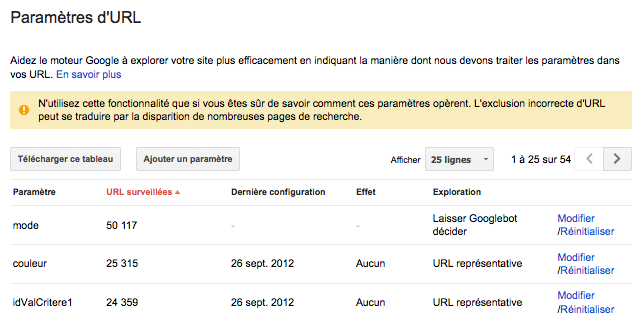

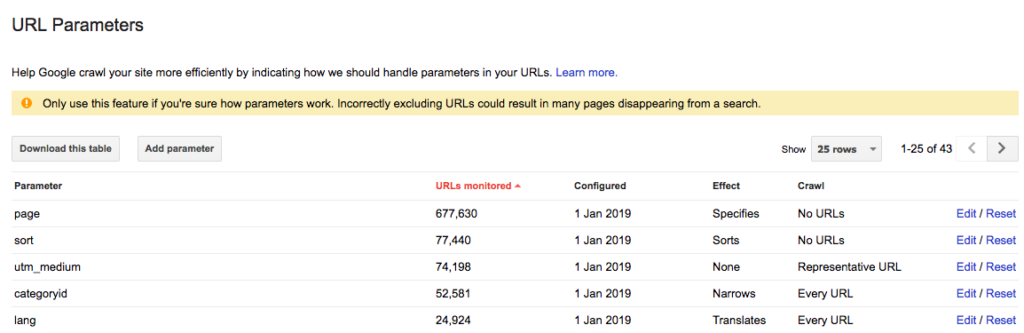

- Vérifier dans le Google Search Console, précisément dans l’outil de paramètres d’URL. Google y ajoute de manière automatique les chaînes de requête. Vous pouvez donc retrouver les paramètres d’URL dans la Search console.

Source : WebRankInfo

- Analyser les fichiers journaux : Vous pouvez aussi constater dans les fichiers journaux si les robots d’exploration de Google ont visité des URL comportant des paramètres.

- Faire une requête de combinaison avec : inurl. En insérant la clé : inurl dans une requête de combinaison comme : example.com inurl:key, vous pouvez découvrir comment les robots d’exploration de Google indexent les paramètres d’URL que vous avez retrouvés sur votre site.

- Rechercher dans le rapport de Google Analytics tous les paramètres d’URL : Vous pouvez chercher le symbole (?) dans Google Analytics pour voir comment vos utilisateurs interagissent avec les paramètres d’URL. Mais avant ça, il est important de vérifier d’abord si les paramètres d’URL sont présents dans le paramètre d’affichage.

Avec ces différentes données, vous pouvez maintenant penser à comment gérer chacun des paramètres d’URL.

3.2. Vérifier constamment votre budget de crawl et limiter les URL paramétrées

On appelle budget d’exploration ou budget de crawl le nombre total de pages que les Googlebots ou les robots d’exploration des autres moteurs de recherche doivent visiter sur votre site. Le budget de crawl est différent d’un site à un autre du fait que tous les sites ne comportent pas le même nombre de pages web.

Il est donc nécessaire de veiller à ce que votre budget de crawl ne soit pas gaspillé. Tel que nous l’avons mentionné dans le chapitre précédent, le fait d’avoir de nombreuses URL paramétrées sur votre site épuise rapidement votre budget d’exploration.

Pour gérer ce problème, vous pouvez procéder à une analyse rapide sur l’utilité de chaque paramètre que vous avez généré pour le référencement du site. Cette analyse vous permettra de trier les paramètres et d’éliminer les moins intéressants.

De toute façon, vous trouverez une raison de réduire les URL paramétrées et ainsi économiser le budget d’exploration. Vous pouvez suivre le processus suivant pour réduire le nombre d’URL paramétrées sur votre site et minimiser leurs impacts sur le référencement.

3.2.1. Trier et éliminer les paramètres inutiles

Commencer par demander une liste complète de tous les paramètres d’URL générer sur le site à votre développeur ou utiliser l’une des méthodes exposées dans le sous-chapitre 3.1. pour obtenir une liste de toutes les URL paramétrées de votre site.

Dans cette liste, il est fort probable que vous retrouviez des paramètres qui ne remplissent pas une fonction avantageuse.

Vous pouvez aussi définir des critères d’évaluation qui vous permettront de sélectionner les paramètres d’URL qui sont précieux et ceux qui sont inutiles.

Vous pouvez utiliser le paramètre sessionID par exemple pour identifier une cible d’utilisateurs sur votre site à un moment donné.

Ce paramètre restera dans la chaîne d’URL même si vous ne l’utilisez plus. En réalité, les cookies sont mieux placés pour identifier les utilisateurs de façon générale. Le paramètre sessionID ne sert donc plus à rien dans la chaîne d’URL. Vous pouvez donc l’éliminer.

De même, vous pouvez découvrir que l’un des filtres de navigation n’est peut-être jamais utilisé par les visiteurs. Tous ces paramètres de requête d’URL inutiles doivent être supprimés.

3.2.2. Limiter les valeurs sans fonction précises

Les paramètres que vous devez ajouter à votre URL seront utiles uniquement s’ils ont une fonction spécifique à remplir. Vous devez donc éviter d’ajouter un paramètre si sa valeur est vide.

3.2.3. Insérer les clés uniques

Sauf dans le cas d’une sélection multiple, vous devez éviter d’insérer plusieurs paramètres ayant le même nom de variable (Clé) avec des valeurs différentes. Pour les options à sélection multiple, il est même conseillé de grouper les valeurs après une seule touche.

3.2.4. Organiser les paramètres d’URL

Il est vrai que l’ordre de présence des paramètres d’URL n’a pas une grande importance ou n’exclut la duplication de contenu. Même si vous réorganisez les paramètres, les robots d’exploration vont toujours considérer les différentes pages comme identiques.

Cependant, chacune des combinaisons des différents paramètres épuise le budget d’exploration et empêche donc les Googlebot d’explorer en entier votre site afin de classer les pages méritées.

Vous pouvez contrer ce problème en exigeant de votre développeur un ordre cohérent lors de l’écriture des scripts de paramètres d’URL. Certes, il n’existe pas un ordre fixe à respecter, mais dans la logique, vous devez toujours commencer par les paramètres de traduction, ensuite les paramètres d’identification, de pagination, puis ceux de superposition du filtrage et enfin de suivi.

Cette méthode offre plusieurs avantages surtout dans le sens du référencement de votre site.

On peut citer :

- Garantir une utilisation normale du budget d’exploration ;

- Minimiser les problèmes de contenus dupliqués ;

- Les signaux de classement sont plus consolidés sur les autres pages du site ;

- Donner une clarté et une lisibilité à votre URL, ce qui peut inciter les internautes à cliquer et partager votre URL via les réseaux sociaux, e-mails, etc.

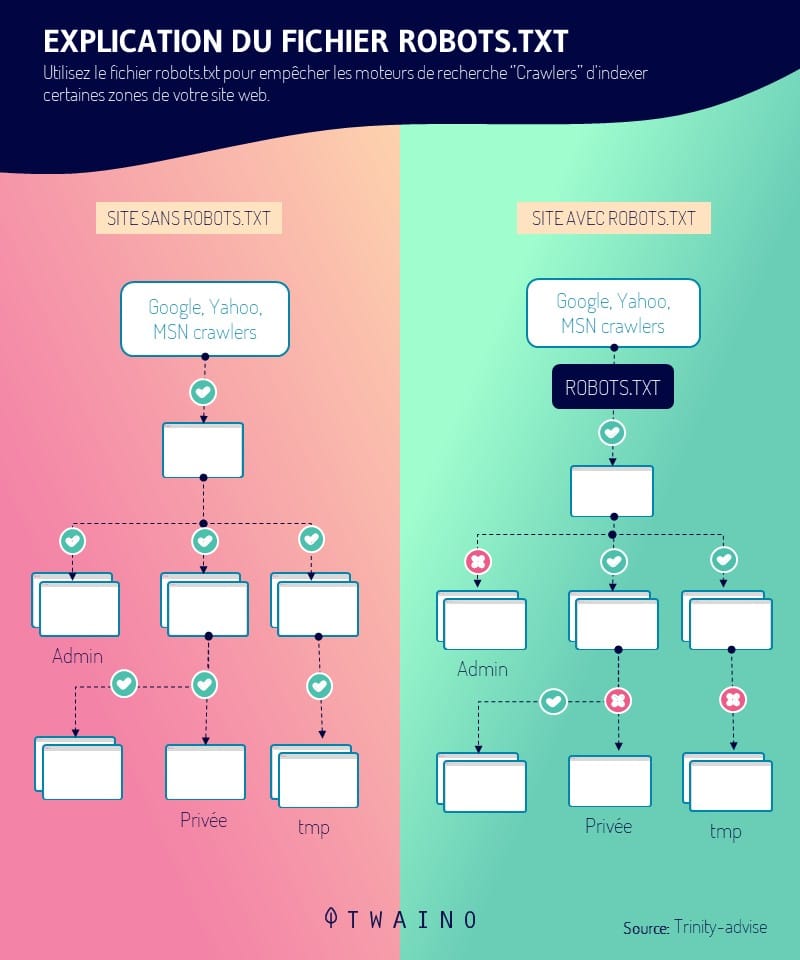

3.3. Bloquer l’accès de certaines pages aux robots d’indexation

Les différents paramètres d’URL que vous créez en vue de trier et filtrer les pages web peuvent générer constamment des URL impliquant des contenus en double.

Lorsque vous constatez que votre site web comporte beaucoup d’URL paramétrées, vous pouvez décider de bloquer certains accès aux robots d’exploration et d’indiquer les différentes pages à ne pas indexer.

Vous aurez besoin d’insérer la balise d’interdiction pour empêcher Googlebot d’accéder aux sessions de votre site comportant des contenus dupliqués. Il s’agit en réalité d’une technique qui vous donne la possibilité de contrôler les différentes actions des robots d’exploration sur votre site.

Pour le faire, vous n’aurez qu’à insérer le fichier robots.txt pour montrer aux moteurs de recherche les pages qui doivent être explorées et celles qui ne doivent pas l’être. Mais, avant toute chose, il est important de créer un lien constant qui pointe vers la page statique non paramétrée.

Étant donné que les crawlers consultent d’abord le fichier robots.txt avant de commencer l’exploration d’un site web, cette technique est un excellent moyen pour vous d’optimiser vos URL paramétrées les plus pertinentes. La présence du fichier robots.txt (interdire :/??tag=*) ou (Disallow : /*?*) par exemple empêchera l’accès à toutes URL comportant un point d’interrogation (?).

Vous devez donc vous assurer que les autres parties de votre URL ne comportent pas aussi des paramètres, car cette balise empêchera toutes les sessions de l’URL affichant ce symbole. En utilisant le fichier robots.txt pour administrer le parcours des robots d’exploration, vous bénéficiez des avantages comme :

- L’utilisation efficace et à bon escient du budget de crawl ;

- Faciliter la mise en oeuvre technique simple ;

- Limiter les problèmes des contenus en double ;

- Applicable à n’importe quel type de paramètres d’URL.

3.4. Insérer des balises canoniques sur les URL paramétrées

Après avoir fait le tri entre les paramètres d’URL et enfin décidé la page statique qui doit être optimisée et positionnée dans les SERP, vous pouvez canoniser les URL paramétrées affichant des contenus en double.

Les balises canoniques rel=”canonical” sont des attributs de lien qui indique aux crawlers qu’une page web comporte de contenu dupliqué ou similaire à une autre page du même site.

Ces signaux permettent aux robots d’économiser le budget de crawl et à consolider les efforts d’indexation sur les URL pertinentes comme canoniques. Quant aux URL pertinentes que vous souhaitez indexer, vous pouvez les organiser et suivre le référencement en insérant la balise rel=canonique.

Cependant, cette technique ne marche correctement que lorsque le contenu de la page d’URL paramétrée ressemble typiquement à la page canonique. En canonisant vos URL, vous bénéficiez des avantages tels que :

- Consolidation des signaux de positionnement vers les URL de page statique ou canonique ;

- Protection de votre site contre les problèmes liés aux contenus dupliqués.

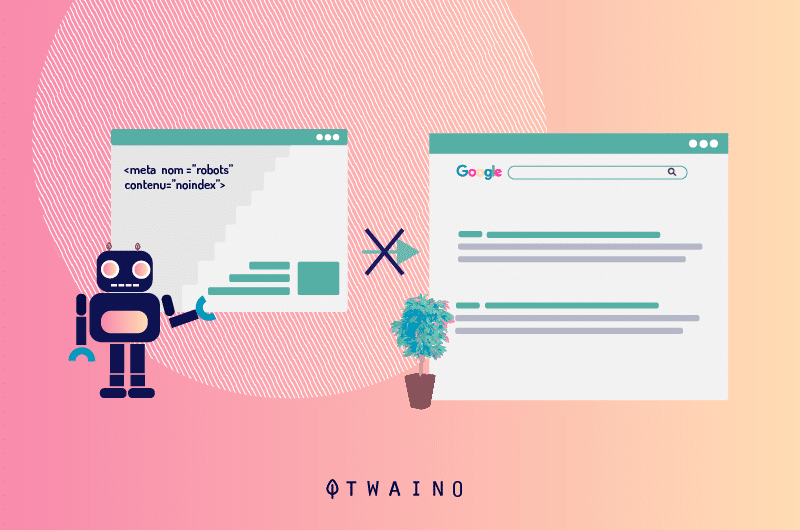

3.5. Utiliser une balise Noindex Meta Robots

Si vous indiquez une directive noindex pour les pages d’URL paramétrées comportant des contenus en double ou qui n’ajoutent aucune valeur SEO, les robots d’exploration des moteurs de recherche ne pourront plus indexer ces pages.

Cependant, la présence d’une balise “noindex” dans une URL durant une durée assez longue peut également amener les moteurs de recherche à ne plus suivre ces liens.

3.6. Gérer les paramètres d’URL dans le Google Search Console

Lorsque les URL paramétrées ont tendance à nuire au référencement de votre site, Google vous envoie un avertissement dans la Search Console en signalant que les paramètres pourraient occasionner le déclassement de plusieurs de vos pages des résultats de recherche.

Le plus alarmant, c’est les pages comportant des contenus dupliqués que les paramètres entraînent.

Il serait donc plus profitable d’apprendre et de maîtriser la configuration des paramètres d’URL dans la Search Console. Cet acquis vous permettra d’assurer l’intégrité et l’autorité de votre site au lieu de laisser Googlebot “décider”.

Le plus important est de connaître l’apport des paramètres sur les contenus de vos pages web.

- 1er Recommandation : Configurer les paramètres de suivi ou paramètres d’URL passifs comme des URL représentatives. Les paramètres passifs ou de suivi ne modifient pas le contenu des pages web. Vous pouvez donc les préférer aux paramètres actifs.

- 2e Recommandation : Insérer les paramètres actifs qui organisent le contenu des pages web comme étant des “tris”. Si le paramètre est utilisé par le visiteur, configurez Googlebot sur “Aucune URL”.

Au cas où le paramètre d’URL actif est utilisé par défaut, vous pouvez le définir sur “Uniquement les URL avec valeur” tout en insérant la valeur par défaut.

- 3e Recommandation : Configurez l’exploration sur “Aucune URL” pour les filtres non pertinents ou qui ne présentent aucun avantage pour le SEO. Mais si vous jugez qu’ils servent à quelque chose, vous pouvez définir l’exploration sur “Chaque URL”. Les paramètres de filtres sélectionnés comme intéressants peuvent être configurés à leur tour sur « rétrécit ».

- 4e Recommandation : Les paramètres qui exposent des éléments du site ou un groupe de contenu comme « spécifique » doivent être configurés sur “Chaque URL”. Normalement, ces paramètres doivent incarner une URL statique.

- 5e Recommandation : Vous devez configurer les paramètres qui exposent une version traduite des contenus de vos pages web en tant que “traduits”. Si la traduction ne se passe pas habituellement à travers des sous-dossiers, il serait préférable de configurer ces paramètres sur “Chaque URL”.

- 6e Recommandation : Configurez les paramètres qui affichent des petites séquences de contenus sous forme de “Pagination”. Vous pouvez définir l’exploration sur “Aucune URL” pour économiser le budget d’exploration. Ceci est profitable si vous disposez d’une structure de site XML qui favorise l’indexation de vos pages. Dans le cas contraire, configurez l’exploration sur “Chaque URL” pour favoriser le passage des robots d’exploration.

De toute manière, il y aura des paramètres que Google va ajouter par défaut sous la valeur : “Laissez Googlebot décider« . Malheureusement, ces paramètres ne pourront pas être supprimés.

Source : Affde

Il est donc préférable de configurer vous-même des paramètres d’URL proactive. Vous pouvez décider à n’importe quel moment de supprimer ces paramètres dans Google Search Console, s’ils ne servent plus à quelque chose.

NB : Les paramètres que vous avez configurés sur “Aucune URL” sur Google doivent également être ajoutés dans l’outil “Ignorer les paramètres d’URL” de Bing.

3.7. Convertir l’URL dynamique en URL statiques

En exposant les différents problèmes que peuvent engendrer les paramètres d’URL sur un site web, la plupart des personnes envisagent comme solution de bannir tous les paramètres. Il est vrai que c’est une alternative, mais n’oublier pas que les sous-dossiers représente une aide pour Google.

Ils aident le moteur de recherche à comprendre la structure du site. De plus, les URL statiques comportant des mots-clés pertinents sont des pièces values qui contribuent au référencement du site web. Pour profiter de ses URL, vous allez utiliser les techniques de réécriture d’URL du côté du serveur afin de transformer les paramètres en URL de sous-dossiers.

Exemple :

URL paramétrée : www.example.com/view-product?id=482794

URL après réécriture : www.exemple.com/widgets/bleu

Cette technique marche bien surtout avec les paramètres d’URL comportant des mots-clés pertinents de requêtes sur les moteurs de recherche. Mais, cette méthode devient un problème pour les paramètres de recherche.

En effet, chaque requête effectuée par l’utilisateur générerait une nouvelle page statique qui deviendra une page concurrente à la page canonique pour le classement. Ou encore, lorsqu’un utilisateur vient chercher quelque chose qui n’est pas disponible sur votre site, la nouvelle page présenterait aux robots d’exploration des contenus de faible qualité n’ayant peut-être pas rapport avec la requête.

De même, la conversion des paramètres d’URL dynamiques par les paramètres statiques en occurrence pour des éléments comme la pagination, les résultats des recherches sur site ou le tri, ne corrige pas le problème de contenu dupliqué ou ne permet pas d’économiser le budget d’exploration.

Résumé

En gros, les paramètres d’URL représentent une pierre angulaire pour le fonctionnement des sites web.

Bien qu’ils présentent de nombreux problèmes de référencement tels que la création des contenus en double, le gaspillage du budget de crawl…, les professionnels chevronnés du SEO qui maîtrisent parfaitement leurs fonctionnement en profitent plus.

Dans cet article, j’ai expliqué premièrement ce que signifie un paramètre d’URL tout en exposant les éventuels problèmes qu’ils peuvent engendrer sur votre site pour impacter négativement son classement.

Les différentes solutions des problèmes liés à ses chaînes de requêtes que j’ai détaillées en dernière position vous aideront à intégrer facilement des paramètres à l’URL de votre site.

Le plus intéressant avec ces méthodes est que vous pouvez disposer des paramètres sur votre site sans craindre le risque de perdre votre positionnement dans les SERP.

Cet article vous a plu ? Avez-vous des questions sur le fonctionnement des paramètres de requêtes ? N’hésitez pas de me poser votre question dans les commentaires !