¡Seamos realistas! El más mínimo cambio que los motores de búsqueda, especialmente Google, hacen en su sistema no pasa desapercibido para la SEO.

En 2010 sabíamos que Google realizó más de 500 cambios en su algoritmo:

Esta cifra se supera con creces ya que solo en 2018, la firma cambió su algoritmo 3.234 veces, es decir, más de 6 veces.

Por supuesto, la mayoría de estas actualizaciones son menores y su impacto en las clasificaciones es insignificante. Así que no tenemos que preocuparnos😊

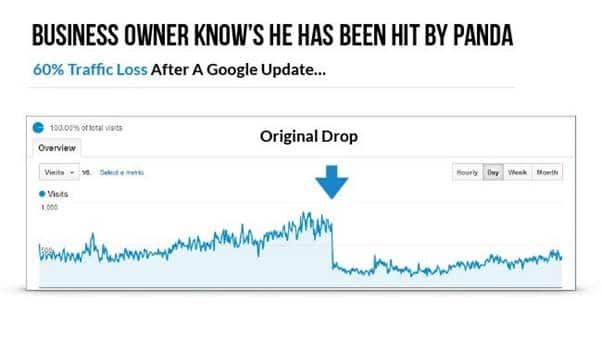

Pero algunos cambios, considerados importantes, son fácilmente perceptibles por su efecto en las clasificaciones y el tráfico del sitio web:

Fuente: GoogleEste es el caso de la última actualización del día más importante de Google: BERT.

En vista de los efectos de las actualizaciones importantes, es bastante legítimo buscar conocer las implicaciones de Google BERT.

Por ello y al igual que mi artículo sobre RankBrain, intentaré mostrar:

- Qué es Google BERT;

- Cómo funciona BERT y el problema que intenta resolver;

- El impacto de BERT en SEO;

- Las diferentes estrategias a adoptar para optimizar su sitio web.

¡Vamos!

Capítulo 1. ¿Qué es Google BERT?

1.1. BERT: el modelo de aprendizaje automático de Google

Unos años después de RankBrain, Google está lanzando otra actualización que llama muy importante: BERT.

Este cambio se implementó por primera vez en el territorio de los Estados Unidos en octubre de 2019. Para otros países e idiomas, en particular Francia, será necesario esperar hasta el 9 de diciembre de 2019:

Como intenta señalar este tweet, BERT ayudará al algoritmo del motor de búsqueda a comprender mejor las búsquedas, tanto a nivel de consulta como de contenido.

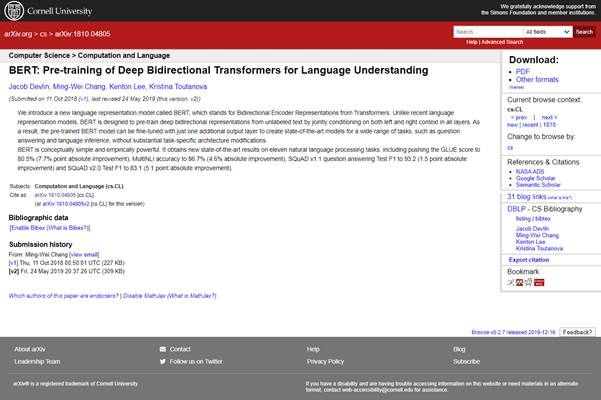

Sin embargo, es importante tener en cuenta que BERT no es solo un algoritmo de Google como uno podría imaginar. y un artículo académico abierto que se publicó en octubre de 2018:

Google también afirma esto en su blog:

«Hemos abierto una nueva técnica de preentrenamiento de PNL llamada Representaciones de codificador bidireccional de transformadores, o BERT. Con este lanzamiento, cualquier persona en el mundo puede entrenar su propio sistema de respuesta de preguntas de última generación (o una variedad de otros modelos) en aproximadamente 30 minutos en una sola nube de TPU o en unas pocas horas usando una sola GPU..»

Representación de codificador bidireccional de transformadores».

Además, BERT es un modelo de aprendizaje automático que se utiliza para considerar el texto en ambos lados de una palabra.

¡Ups! parece que se complica un poco con nociones/términos técnicos.

No te preocupes, intentaré explicar estos diferentes conceptos de la forma más sencilla posible.

Tenga en cuenta que BERT es un modelo de aprendizaje automático y, por lo tanto, parte de la IA o inteligencia artificial.

Y al igual que RankBrain, BERT evoluciona constantemente a través de los modelos y los datos que se le envían

1.2. BERT: la nueva era del procesamiento del lenguaje natural

Actualmente, BERT se ha vuelto importante porque ha acelerado drásticamente la comprensión del lenguaje natural para los programas informáticos.

De hecho, el hecho de que Google haya hecho que BERT sea de código abierto ha permitido que todo el campo de la investigación del procesamiento del lenguaje natural mejore la comprensión general del lenguaje natural.

Esto también ha llevado a muchas grandes empresas de inteligencia artificial a construir también versiones BERT.

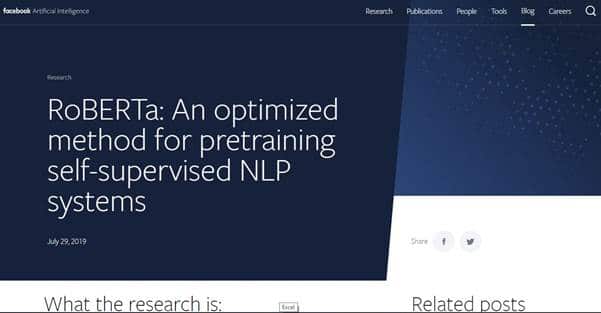

Así tenemos: RoBERTa de Facebook:

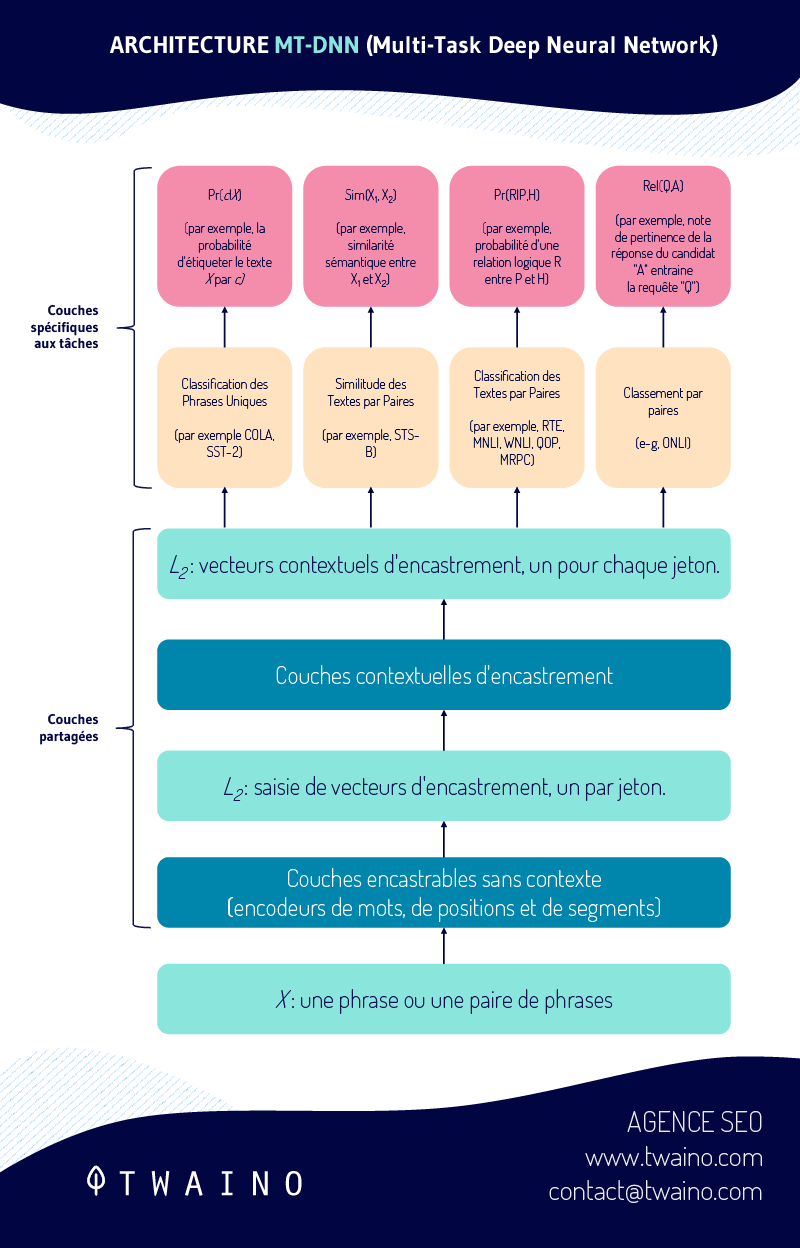

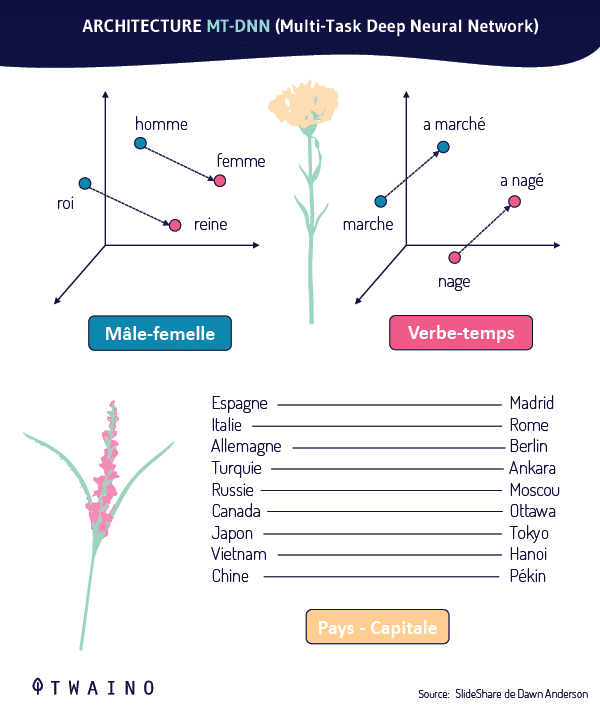

- Microsoft extendiendo BERT con MT-DNN (Multi-Task Deep Neural Network):

Por ejemplo, hay una forma de BERT llamada “Vanilla BERT ”.

Este último proporciona una capa de inicio preentrenada para modelos de aprendizaje automático de lenguaje natural. Esto proporciona una base sólida para que su estructura se mejore continuamente. Especialmente desde que Vanilla BERT se realizó en la datos de Wikipedia .

Esta es una de las razones por las que BERT se considera el método que se utilizará para optimizar la PNL en los próximos años.Para Thang Luong, científico investigador sénior de Google Brain, BERT sería la nueva era de la PNL y probablemente la mejor creada hasta el momento:

De lo anterior se debe entender que BERT no es utilizado exclusivamente por Google. Si ha investigado mucho sobre el tema, probablemente haya visto que la mayoría de las menciones de BERT en línea NO se refieren a la actualización de Google BERT.

Tendrá derecho a muchos artículos sobre BERT (que a veces dan dolores de cabeza porque son demasiado técnicos/científicos) escritos por otros investigadores. Y eso no usa lo que podemos considerar como la actualización del algoritmo de Google.

Ahora sabemos qué es BERT y vamos a hablar sobre cómo funciona.

Capítulo 2: ¿Cómo funciona Google BERT?

Para comprender cómo funciona Google, primero debe comprender el concepto de NPL.

2.1. ¿Qué es la PNL de Google y cómo funciona?

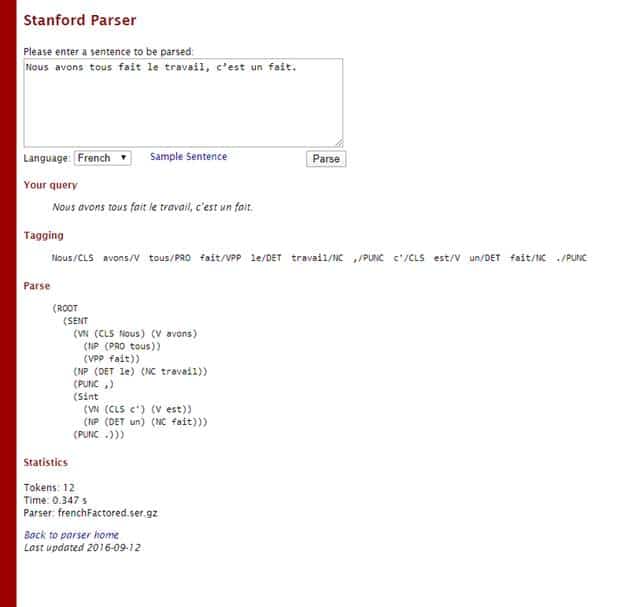

La comunicación entre humanos y computadoras en un lenguaje que suena natural es posible gracias a la PNL.

El acrónimo NLP significa «Procesamiento del lenguaje natural» o en francés «Procesamiento del lenguaje natural».

Es una tecnología basada en Inteligencia Artificial que consiste en el aprendizaje automático del lenguaje natural.

Fuente: Illuminations

Esta tecnología también se utiliza en:

- Procesadores de texto como Microsoft Word Grammarly, que utilizan NLP para comprobar la precisión gramatical del texto;

- Aplicaciones de traducción de idiomas como el traductor de Google;

- Aplicaciones de respuesta de voz interactiva (IVR) utilizadas en los centros de llamadas para responder a las solicitudes de ciertos usuarios;

- Asistentes personales como OK Google, Hay siri, Cortana, Alexa…

NLP es el framework que permite el funcionamiento de Google BERT y que consta de cinco servicios principales para realizar tareas de procesamiento del lenguaje natural.

2.1.1. Análisis sintáctico

Durante este análisis, el motor de búsqueda descompone la consulta en palabras individuales y luego extrae la información lingüística.

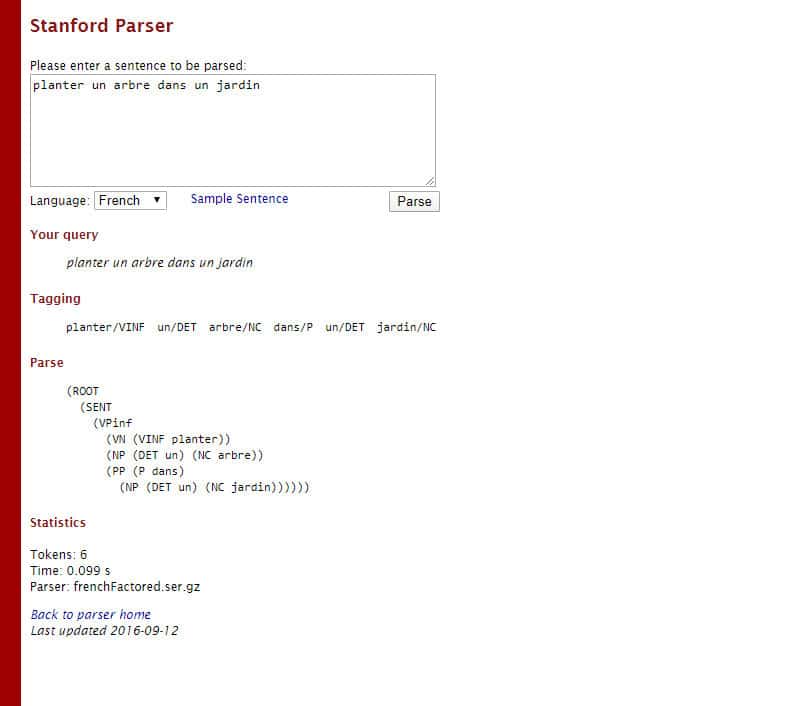

Por ejemplo, tome la siguiente consulta: «Plantar un árbol en un jardín»

En esta consulta, Google puede desglosarla de la siguiente manera:

- plantador Etiqueta del : Verbo en infinitivo

- A Etiqueta : Determinante

- del árbol Etiqueta : Sustantivo común

- A Etiqueta Preposición

- : Etiqueta Determinant

- Garden tag : Nombre común

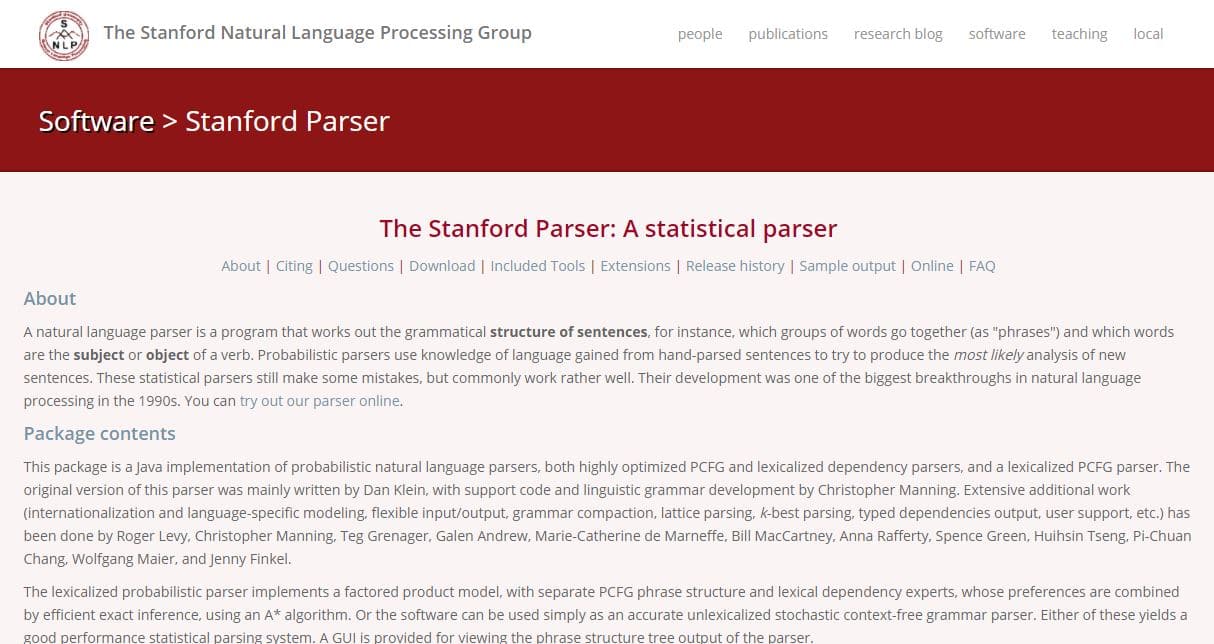

Como es el caso del Stanford/Parserque es un analizador de lenguaje natural:

2.1.2.sentimiento

El sistema de análisis de sentimiento de Google asigna una puntuación emocional a la consulta.

La siguiente tabla muestra algunos ejemplos que explican cómo funciona el concepto de análisis de sentimiento realizado por Google.

Por lo tanto, tenga en cuenta que los valores no provienen de Google fueron tomados al azar:

2.1.3. Análisis

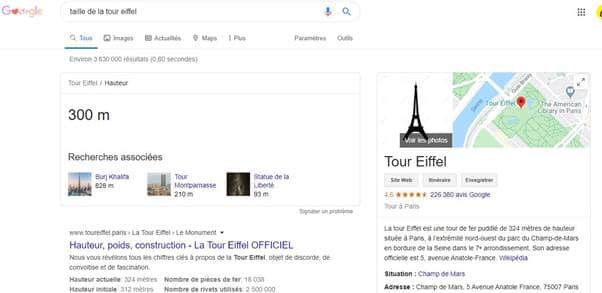

de entidades Aquí, Google tiene en cuenta las entidades que están presentes en las solicitudes para presentar información sobre ellas, la mayoría de las veces con Knowledge Graph.

Si busca por ejemplo «tamaño de la Torre Eiffel», el motor de búsqueda detectará «Eiffel» como una entidad.

De esta manera enviará información sobre esta consulta

Google puede clasificar las cosas de esta manera para este ejemplo de Toptal:

«Robert DeNiro habló con Martin Scorsese en Hollywood en Nochebuena en diciembre de 2011».

. Análisis de sentimiento de entidad

Similar al análisis de sentimiento, Google intenta identificar el sentimiento general en documentos que contienen entidades.

De esta forma, el buscador otorga una puntuación a cada una de las entidades según la forma en que se utilizan en los documentos.

Tomemos otro ejemplo de Toptal:

“El autor es un escritor horrible. El lector es muy inteligente por otro lado. »

2.1.5. Clasificación del texto

El algoritmo de Google sabe con precisión a qué temática pertenecen las páginas web.

Cuando un usuario realiza una consulta, Google Match analiza la frase y sabe exactamente en qué categoría de páginas web buscó.

Aquí hay otro ejemplo de la misma fuente:

analizaron con la API NLP de Google esta oración de un anuncio sobre Nikon:

«El gran sensor de formato DX de 24.2 MP de la D3500 captura fotos ricamente detalladas y videos Full HD, incluso cuando dispara con poca luz . En combinación con la potencia de reproducción de su lente NIKKOR, puede comenzar a crear retratos artísticos con un desenfoque suave del fondo. Con facilidad. “

Traducido, tenemos:

D3500captura fotografías muy detalladas y video Full HD, incluso con poca luz. En combinación con la potencia de reproducción de su lente NIKKOR, puede comenzar a crear retratos artísticos con un desenfoque suave del fondo. Con facilidad.Artes

El resultado de la clasificación es el siguiente:

Le résultat de la classification est le suivant :

Se puede observar que la prueba está clasificada en la categoría:

- y espectáculos/Artes visuales y diseño/Artes fotográficas y digitales con 0,95 como índice de confianza;

- Aficiones y pasatiempos con un índice de confianza de 0,94

- Informática y electrónica / Electrónica de consumo / Cámaras y videocámaras con un índice de confianza de 0,85.

Estos son los 5 pilares de Google NLP cuyo principal reto es la falta de datos.

En palabras de Google :

“Uno de los mayores desafíos en el procesamiento del lenguaje natural (PNL) es la falta de datos de entrenamiento. Debido a que la PNL es un campo diverso con muchas tareas distintas, la mayoría de los conjuntos de datos específicos de tareas contienen solo unos pocos miles o unos cientos de miles de ejemplos de entrenamiento etiquetados por personas.problema

, Google dio un paso más y diseñó el lenguaje natural Google AutoML que permite a los usuarios crear modelos personalizados de aprendizaje automático.

El modelo BERT de Google es una extensión de Google AutoML Natural Language. Es por eso que la comunidad de PNL también puede usarlo.

2.2. ¿Qué problemas está tratando de resolver BERT?

Como humanos, podemos entender fácilmente ciertas cosas que las máquinas o los programas de computadora no pueden entender.

BERT ha venido a corregir este problema a su manera y aquí están los puntos principales que trata:

2.2.1. El número y la ambigüedad de las palabras

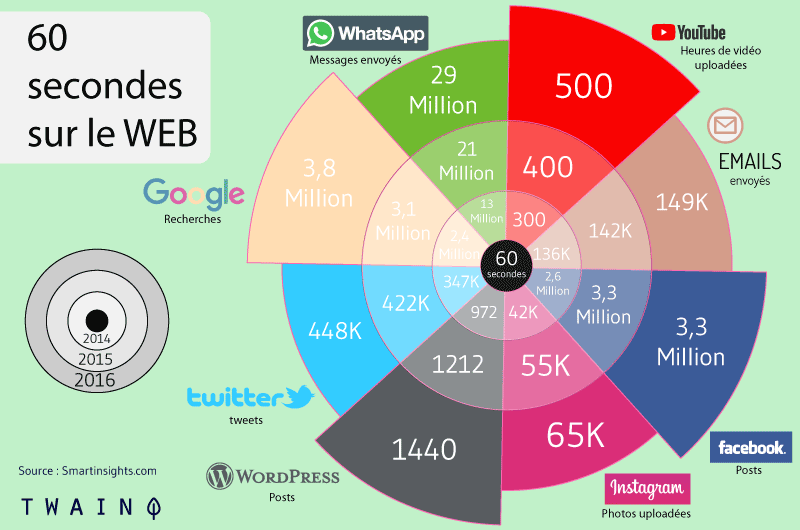

Cada vez se lanza más contenido en la web y estamos literalmente abrumados:

su número no es un problema en sí mismo para las máquinas que están diseñadas para procesar una cantidad astronómica de datos.

De hecho, las palabras son problemáticas porque muchas de ellas son:

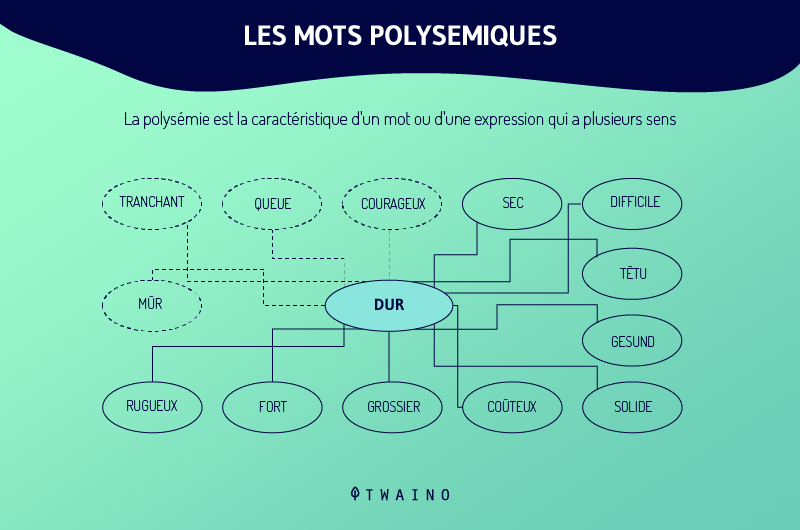

- Ambiguas y polisémicas: una palabra puede tener varios significados;

- Sinónimos: Diferentes palabras significan lo mismo.

Fuente: Dartmouth.edu

Bert está diseñado para ayudar a resolver oraciones y expresiones ambiguas que se componen de palabras polisémicas.

Estarás de acuerdo conmigo en que hay una multitud de palabras que tienen varios significados.

Cuando escribo la palabra “imán”, no sabes si es el material que se usa para atraer el hierro o si es la conjugación del verbo “amar”.

Esta ambigüedad se nota en la escritura o en los textos escritos, pero se vuelve mucho más difícil cuando se trata de hablar.

De hecho, incluso el tono puede hacer que una palabra tenga otro significado.

Cuando digo un insulto en un tono amistoso a un ser querido, no tiene absolutamente el mismo significado que cuando pronuncio insultos en un tono enojado.

El primero tenderá a hacerte reír, pero el segundo corre el riesgo de hacerme pasar un mal rato.😊

Los humanos tenemos esta habilidad natural de entender fácilmente las palabras que se usan.

Lo que las computadoras aún no pueden hacer a la perfección. Lo que trae a colación otro problema mucho mayor:

2.2.2. El contexto de las palabras

Una palabra tiene un significado preciso sólo si se usa en un contexto particular.

De hecho, el significado de una palabra cambia literalmente a medida que se desarrolla una oración.

Tomaré un ejemplo muy simple: “Todos hicimos el trabajo, eso es un hecho..

Como humanos, tenemos la capacidad de saber rápidamente que las dos palabras «hecho» son diferentesuna vez más Stanford Parser :

un análisis de mi oración me da este resultado

El software pudo diferenciar entre «hecho» como verbo en participio pasado y «hecho» como sustantivo común.

Sin PNL, habría sido difícil para los programas de computadora hacer una diferencia lo suficientemente clara entre estos dos términos.

De hecho, es el contexto y, en particular, las otras palabras de la oración las que permiten comprender el significado exacto de las palabras.

Por lo tanto, el significado de la palabra «hecho» cambia según el significado de las palabras que lo rodean.

Obviamente, cuanto más larga sea la oración, más difícil será seguir el contexto completo de todas las palabras de la oración.

Así, con el aumento del contenido generado en la web, las palabras se vuelven más problemáticas y más difíciles de entender para los motores de búsqueda. Por no hablar de la investigación conversacional, que es mucho más compleja que la escritura.

El gran problema que resuelve BERT aquí es agregar contexto a las palabras utilizadas para poder entenderlas.

El papel esencial que juega BERT es, por lo tanto, tratar de ENTENDER las palabras utilizadas.

Volveremos sobre esto en las próximas secciones de esta guía. Por ahora, centrémonos en otro aspecto de la PNL, que es la diferencia entre NLU y NLR.

2.3. La diferencia entre la comprensión del lenguaje natural (NLU) y el reconocimiento del lenguaje natural (NLR)

La comprensión del lenguaje natural es diferente del reconocimiento del lenguaje natural.

Los motores de búsqueda saben reconocer las palabras que utilizan sus usuarios. Pero eso no significa que puedan entender las palabras de su contexto.

De hecho, para tomar conciencia del lenguaje natural, debe usar el sentido común. Es algo bastante fácil para los humanos, pero difícil para las máquinas.

Por ejemplo, estamos acostumbrados como humanos a examinar varios factores para comprender el contexto de las palabras y, por lo tanto, la información que se transmite.

Estos incluyen, por ejemplo:

- oraciones anteriores;

- La persona con la que estamos hablando;

- del marco en que nos encontramos;

- Etc.

Sin embargo, una máquina no puede hacer esto tan fácilmente, incluso si puede reconocer palabras del lenguaje natural.

Para ello, podemos afirmar que la NLU, BERT, le permite a Google tener una mejor comprensión de las palabras que ya está acostumbrado a reconocer.

Lo mismo ocurre con los datos estructurados y los datos de Knowledge Graph, que tienen muchas lagunas que la NLU llena.

Uno podría preguntarse correctamente: ¿Cómo pueden los motores de búsqueda llenar los vacíos entre las entidades nombradas?

2.4. Desambiguación del lenguaje natural Los

motores de búsqueda no utilizan nada que esté asignado al gráfico de conocimiento. Esta es la razón por la que se usa la desambiguación del lenguaje natural para llenar los espacios entre las entidades nombradas.

Se basa en la noción de co-ocurrencia que proporciona un contexto y puede modificar el significado de una palabra.

Por ejemplo, esperaría ver una frase como «sitio de referencia» en un artículo que trata sobre los vínculos de retroceso. Pero ver un término como «criptomoneda» estaría fuera de contexto.

Esta es la razón por la cual los modelos lingüísticos que se entrenan en colecciones de textos muy grandes deben estar marcados por conjuntos de datos. Esto, mediante el uso de la similitud de distribución para aprender el peso y la medida de las palabras y su proximidad.

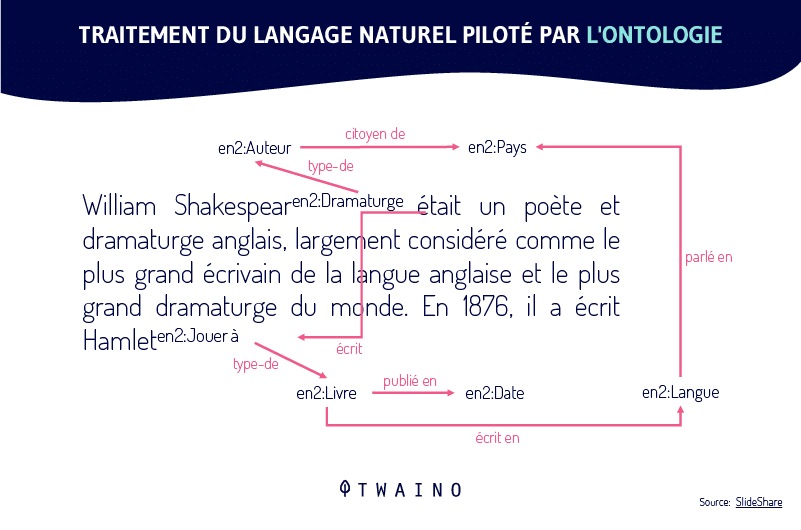

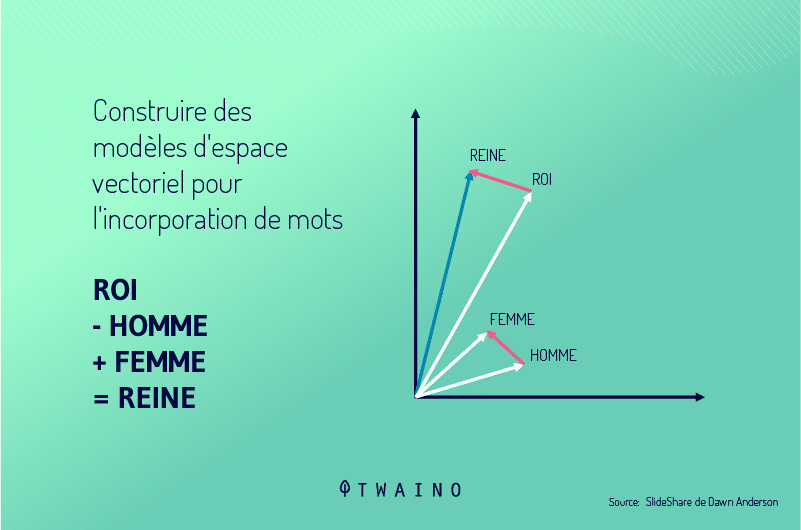

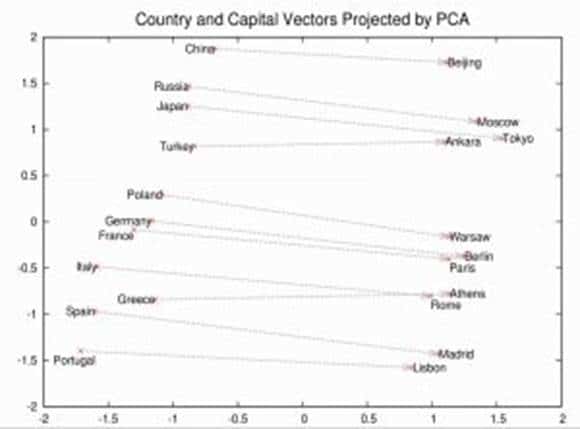

Aquí, BERT se usa para realizar las tareas de entrenar estos modelos entrenados para hacer la conexión entre conceptos y palabras:

Gracias a estos modelos, las máquinas logran construir modelos espaciales vectoriales para la incorporación de palabras:

2.5. Cómo Google BERT proporciona contexto a las palabras

Una sola palabra solo tiene un significado semántico cuando se coloca en un contexto determinado.

Luego, BERT se usa para garantizar la «cohesión del texto», es decir, para mantener una cierta coherencia en el texto.

Cuando se habla de cohesión, solo hay un factor que da sentido a un texto: El vínculo gramatical.

Una parte importante del contexto semántico es el etiquetado de parte del discurso / etiquetado de parte del discurso (POS):

¡Teníamos que mencionarlo en la sección sobre PNL! Lo recuerdas, ¿no?

Ahora, vamos a dar una respuesta a la siguiente pregunta:

2.6. ¿Cómo funciona el BERT de Google?

Los viejos modelos de lenguaje como Word2Vec que vimos en el RankBrain no integran palabras con su contexto:

esto es exactamente lo que BERT está tratando de permitir que hagan los motores de búsqueda.

Vamos a ver cómo funciona y para ello, vamos a diseccionar las propias siglas de BERT: Modelado bidireccional Encoder Representaciones Transformadores

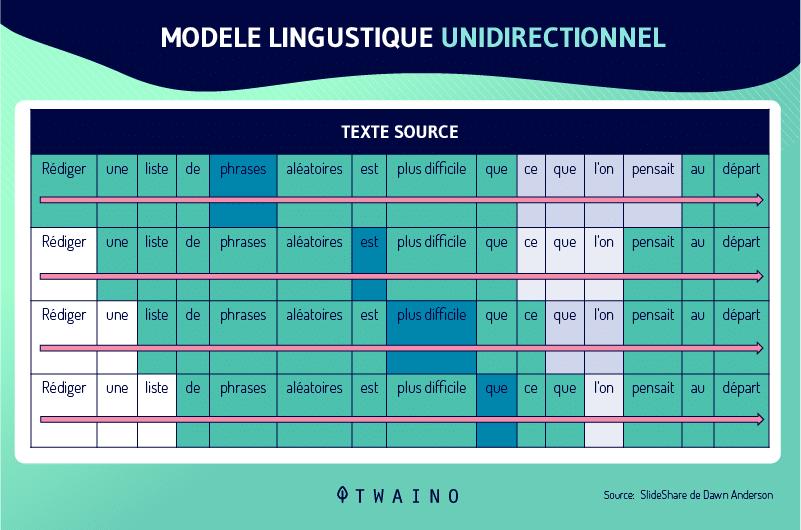

2.6.1. La B de BERT: Los

modelos lingüísticos bidireccionales solían ser unidireccionales cuando se trataba de comprender el contexto de las palabras.

En otras palabras, solo podían mover la ventana de contexto en una dirección para entender el contexto de la palabra:

Tomemos este ejemplo para entender mejor: «Ya he consumido el contenido que se publica»

Los modelos lingüísticos solo podía leer la oración de una manera para tratar de entender el contexto. Lo que significa que no podrán utilizar las palabras que rodean a “consumido” en ambos sentidos, sabiendo que esta palabra significa en este nivel consultar/tomar conocimiento.

Es por eso que decimos que la mayoría de los modeladores de lenguaje son unidireccionales y solo pueden iterar palabras en una dirección. Lo que puede marcar una gran diferencia en la comprensión del contexto de una oración.

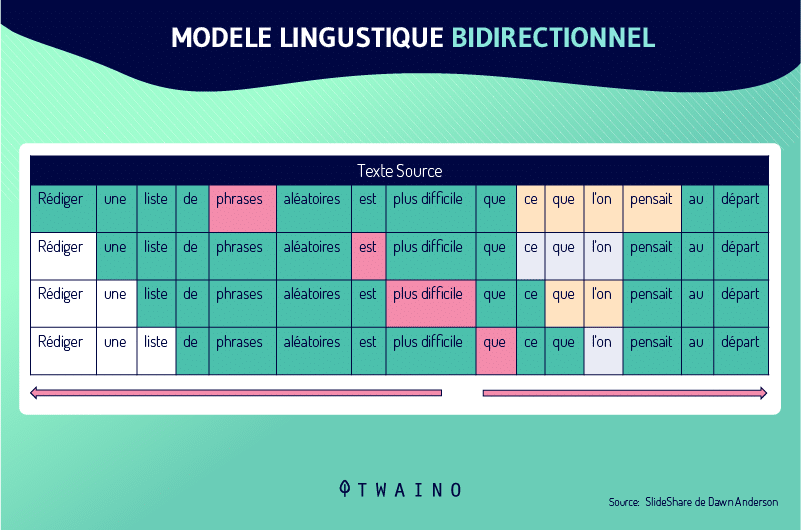

BERT, por otro lado, utiliza un modelo de lenguaje bidireccional y puede ver ambos lados de una palabra objetivo para ubicarla en contexto:

BERBERT es el primero en tener esta tecnología que le permite ver la oración completa en cada uno. lado de una palabra para obtener el contexto completo:

Google señala esto en este trabajo de investigación titulado «BERT: entrenamiento previo de transformadores bidireccionales profundos para la comprensión del lenguaje»:

«BERT es el primer modelo de representación basado en el ajuste fino que logra rendimiento máximo en un amplio conjunto de tareas a nivel de oración y nivel de token, superando muchas arquitecturas específicas de tareas… Es conceptualmente simple y empíricamente poderoso. Logra nuevos resultados líderes en la industria en once tareas de procesamiento de lenguaje natural, incluido el aumento de la puntuación de GLUE al 80,5 % (7,7 de mejora absoluta), la precisión de MultiNLI al 86,7 % (4 de mejora absoluta, 0,6 %), la respuesta a SQuAD v1.1 pregunta en la prueba F1 en 93.2 (mejora absoluta de 1.5 puntos) y la prueba F1 SQuAD v2.0 en 83.1.»

B», continuaremos con la:

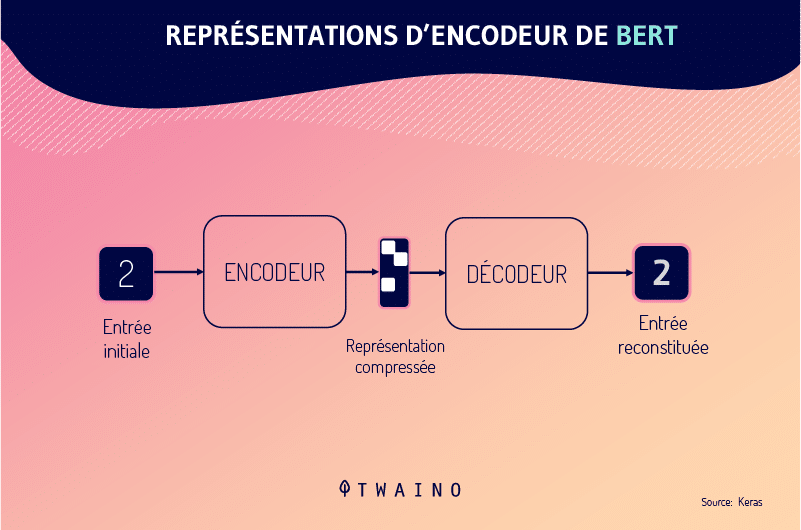

2.6.2. RE de BERT: representaciones del

codificador La representación del codificador es esencialmente el acto de introducir oraciones en el codificador y generar decodificadores, patrones y representaciones, según el contexto de cada palabra.

Creo que no hay nada que añadir, vamos a la última letra de las siglas:

2.6.3. T de BERT: Transformadores

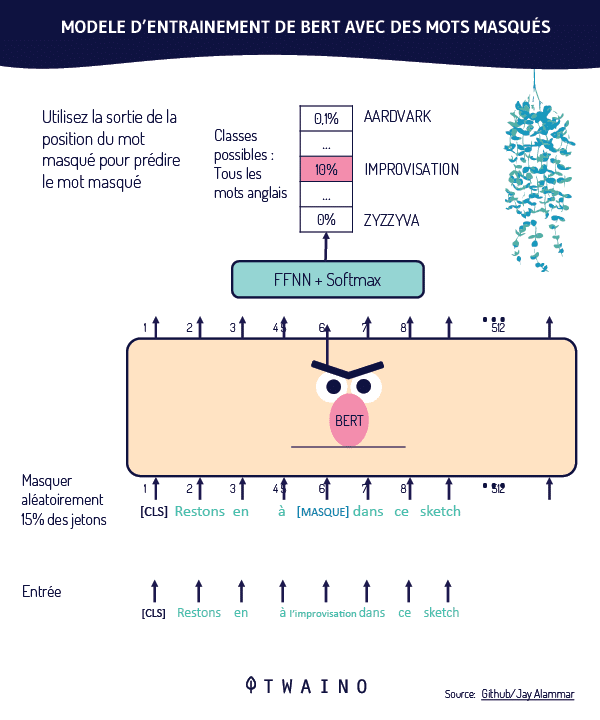

BERT utiliza «transformadores» y «Modelado de lenguaje enmascarado».

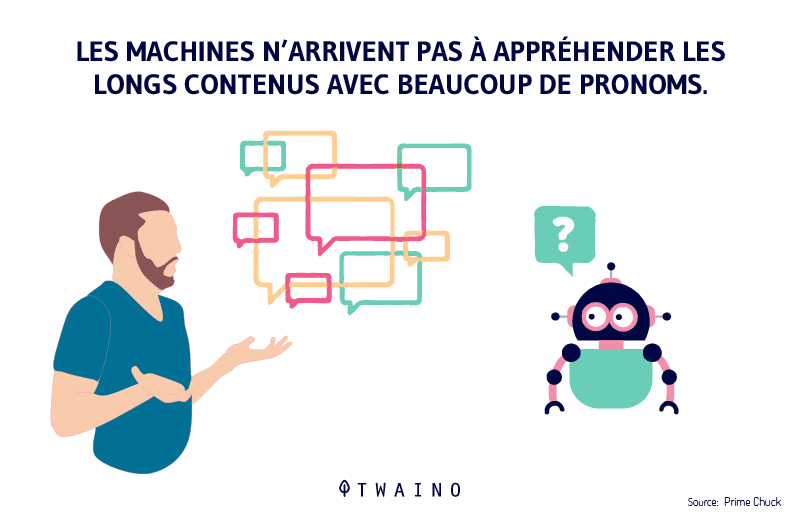

De hecho, otro problema importante encontrado en el lenguaje natural fue entender a quién/a qué contexto se refiere una palabra en particular.

Por ejemplo, a veces es difícil saber de quién estamos hablando cuando usamos pronombres en una conversación. ¡Especialmente cuando se trata de una conversación muy larga!

Este problema no falta en los programas informáticos. Y es un poco lo mismo para los motores de búsqueda, les cuesta seguir cuando usas pronombres:

- He/they;

- Ella ellos;

- Nosotros ;

- Que ;

- Etc.

Es en este marco que los procesadores se enfocan, por ejemplo, en los pronombres y el significado de todas las palabras que van juntas. Esto les permite vincular a las personas con las que estamos hablando o de lo que estamos hablando a un contexto determinado.

Los transformadores son todas las capas que forman la base del modelo BERT. Permiten que BERT no solo mire todas las palabras de una oración, sino que también se centre en cada palabra individual y examine el contexto de todas las palabras que la rodean.

BERT usa transformadores y «Modelado de lenguaje enmascarado», lo que significa que ciertas palabras en una oración están «enmascaradas», lo que requiere que BERT adivine ciertas palabras:

Fuente: Github/Jay Alammar

Las palabras se enmascaran aleatoriamente y BERT se mantiene para predecir el vocabulario original de las palabras basándose únicamente en su contexto.

Esto también es parte del proceso de desarrollo del modelo.

Capítulo 3: Estudios de casos: cómo BERT realmente mejora las SERP

Para entender cómo funciona Google BERT, usaremos los ejemplos que Google proporcionó en su artículo BERT.

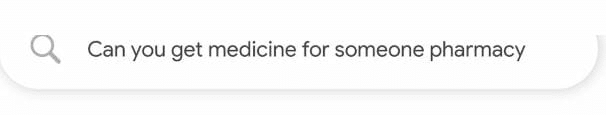

Ejemplo 1: El significado de la palabra “alguien”

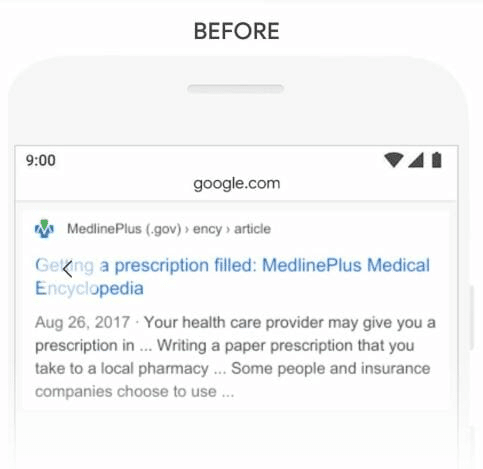

La consulta que se considera es la siguiente:

Traducido literalmente tenemos: “¿Puedes conseguir medicamentos para alguien farmacia?”

Aunque esto no es muy preciso, podemos entender que el usuario está buscando para determinar si un ser querido de un paciente puede recoger una receta en su nombre.

Antes de que BERT se integrara en su algoritmo, Google dio este tipo de respuesta:

Traducido, tenemos la siguiente respuesta:

«Su proveedor de atención médica puede darle una receta en… Escriba una receta en papel que traiga a una farmacia local… Algunas personas y compañías de seguros eligen usar…”

Esta respuesta es claramente insatisfactoria ya que ignora a este “alguien” que no es el paciente.

En otras palabras, Google no pudo procesar el significado de la palabra «alguien» en el contexto de la consulta.

Después de BERT, Google parece ser capaz de captar las sutilezas de las consultas que procesa.

Aquí está la respuesta que Google proporciona ahora a tal consulta:

Traducido al inglés, tenemos:

«Un farmacéutico puede usar su juicio profesional y experiencia de las prácticas actuales para… en el mejor interés del paciente al permitir que una persona, otra que el paciente, para recoger una receta..

Podemos estar de acuerdo en que esta respuesta es explícita y responde sin ambigüedades a la solicitud del investigador

En otras palabras, Google ahora ha entendido el significado semántico de la palabra «alguien», sin el cual la frase adquiere un significado completamente nuevo.

Entonces, ¿cuál fue el papel de BERT en esta tarea? Estamos de acuerdo en que BERT ayudó a Google a comprender la consulta.

De hecho, Google ahora ha podido identificar las palabras más importantes de la solicitud gracias a su contexto y otorgar durante el procesamiento una cierta nota de importancia.

Esta forma de hacer las cosas ha permitido a Google proporcionar resultados de búsqueda mucho más precisos.

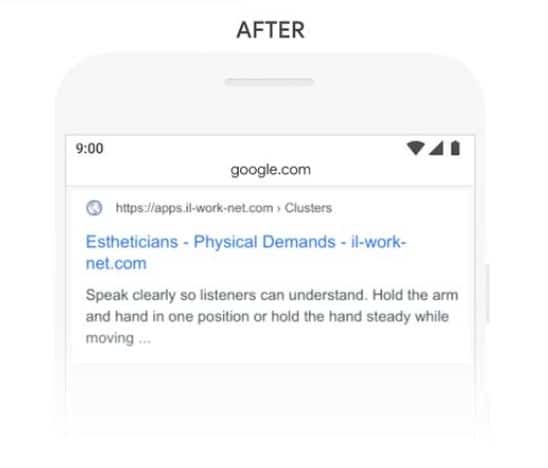

Ejemplo 2: Consideró la palabra «cabina»

La siguiente consulta:

Traducido, tenemos:

«¿Trabajan mucho las esteticistas?»

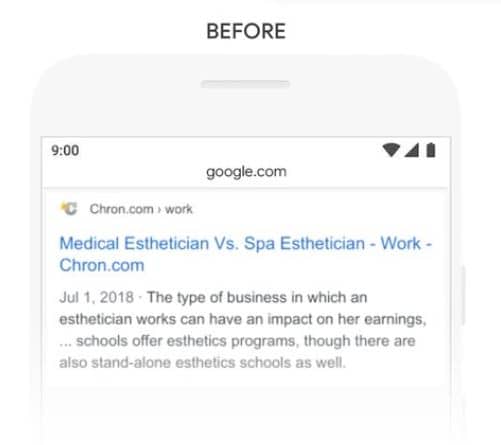

Antes de BERT, Google da esta respuesta:

Traducido, tenemos:

«el tipo de empresa en la que un esteticista puede tener una impacto en sus ingresos, … las escuelas ofrecen programas de estética, aunque también hay escuelas de estética independientes..

La respuesta realmente no tiene nada que ver con la consulta del usuario

De hecho, Google no supo cómo interpretar correctamente el término «stand» al vincularlo con la expresión «stand-alone» que significa «independiente/autónomo».

Es por ello que Google ha propuesto un resultado que evoca el trabajo independiente de las esteticistas.

Con Bert, Google se vuelve un poco más inteligente y llega a entender el contexto de la consulta:

Traducido al francés:

“Habla claramente para que los oyentes puedan entender. Sostenga el brazo y la mano en una posición o sostenga la mano derecha mientras se mueve…”

Aquí, Google enumera el esfuerzo físico que las esteticistas deben realizar como parte de su trabajo.

La respuesta a la pregunta «¿trabajan mucho las esteticistas?» encuentra una mejor respuesta.

Esto es exactamente lo que dice Google:

“Anteriormente, nuestros sistemas adoptaban un enfoque de coincidencia de palabras clave, haciendo coincidir el término ‘independiente’ en el resultado con la palabra ‘stand’ en la consulta. Pero ese no es el uso correcto de la palabra «estar de pie» en contexto. Nuestros modelos BERT, por otro lado, entienden que la palabra «estar de pie» se relaciona con el concepto de las demandas físicas de un trabajo y muestra una respuesta más útil.Como

Ejemplo 3: El contexto de la palabra «adultos»

tercer ejemplo, tenemos esta consulta:

Traducido al inglés, tenemos:

«Libro de práctica en matemáticas para adultos»

Aquí, podemos suponer que el usuario tiene la intención de comprar libros de matemáticas para adultos.

La respuesta que ofreció Google antes de BERT es la siguiente:

el hallazgo es que Google devuelve resultados que sugieren libros para niños, especialmente para niños de 6 a 8 años.

Google proporcionó esta respuesta porque la página contiene la frase «adulto joven».

Pero en nuestro contexto simplemente emparejar las palabras no funciona y obviamente «adulto joven» es irrelevante para la pregunta.

Después de BERT, Google puede discernir correctamente la diferencia entre las dos expresiones «Adultos jóvenes» y «adulto».

las respuestas fuera de contexto

:

excluye… (Matemáticas Básicas para Adultos) Parte 1.”

Ejemplo 4: Considerando la palabra “sin”

Considerando otro ejemplo donde Google ignora una preposición muy importante:

Traducido al inglés:

“Stationnement sur une colline sin acera”

Aquí está la respuesta que Google ofrece antes de BERT:

Traducido al francés:

“Habla claramente para que los oyentes puedan entender. Sostenga el brazo y la mano en una posición o sostenga la mano derecha mientras se mueve…”

Aquí, Google enumera el esfuerzo físico que las esteticistas deben realizar como parte de su trabajo.

La respuesta a la pregunta «¿trabajan mucho las esteticistas?» encuentra una mejor respuesta.

Esto es exactamente lo que dice Google:

“Anteriormente, nuestros sistemas adoptaban un enfoque de coincidencia de palabras clave, haciendo coincidir el término ‘independiente’ en el resultado con la palabra ‘stand’ en la consulta. Pero ese no es el uso correcto de la palabra «estar de pie» en contexto. Nuestros modelos BERT, por otro lado, entienden que la palabra «estar de pie» se relaciona con el concepto de las demandas físicas de un trabajo y muestra una respuesta más útil.Como

Ejemplo 3: El contexto de la palabra «adultos»

tercer ejemplo, tenemos esta consulta:

Traducido al inglés, tenemos:

«Libro de práctica en matemáticas para adultos»

Aquí, podemos suponer que el usuario tiene la intención de comprar libros de matemáticas para adultos.

La respuesta que ofreció Google antes de BERT es la siguiente:

el hallazgo es que Google devuelve resultados que sugieren libros para niños, especialmente para niños de 6 a 8 años.

Google proporcionó esta respuesta porque la página contiene la frase «adulto joven».

Pero en nuestro contexto simplemente emparejar las palabras no funciona y obviamente «adulto joven» es irrelevante para la pregunta.

Después de BERT, Google puede discernir correctamente la diferencia entre las dos expresiones «Adultos jóvenes» y «adulto».

las respuestas fuera de contexto

:

excluye… (Matemáticas Básicas para Adultos) Parte 1.”

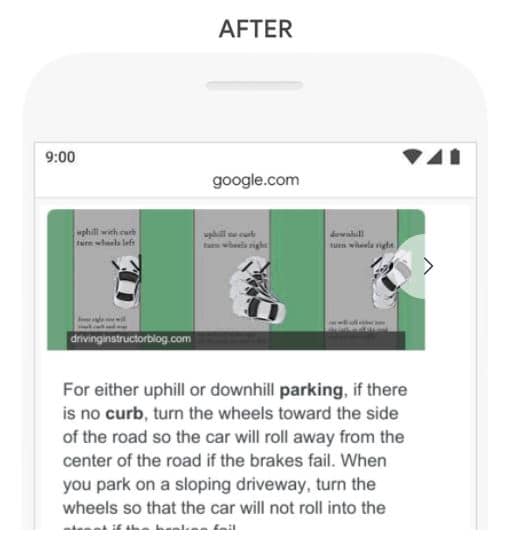

Ejemplo 4: Considerando la palabra “sin”

Considerando otro ejemplo donde Google ignora una preposición muy importante:

Traducido al inglés:

“Stationnement sur une colline sin acera”

Aquí está la respuesta que Google ofrece antes de BERT:

Traducido, tenemos:

“Estacionamiento en una colina. Cuesta arriba: cuando suba una colina, gire las ruedas delanteras en sentido contrario al bordillo y deje que su vehículo ruede lentamente hacia atrás hasta que la parte trasera de la rueda delantera descanse contra el bordillo usándola como bloque. Cuesta abajo: cuando detenga su automóvil en una pendiente, gire las ruedas.«

acera» ignorando la palabra «sin».

Google probablemente no entendió cuán esencial era esa palabra para responder esa consulta correctamente.

Por lo tanto, arrojó resultados para estacionar en una colina con acera.

Bert parece resolver este problema, porque el motor de búsqueda comprende mejor la consulta y el contexto.

Traducido tenemos:

“Para aparcar cuesta arriba o cuesta abajo. Si no hay bordillo, gire las ruedas hacia el costado de la carretera para que el automóvil se aleje del centro de la carretera si fallan los frenos. Cuando estacione en un camino inclinado, gire las ruedas para que el automóvil no ruede por el…”

Como puede ver, Google dio una respuesta bastante decente para la consulta en cuestión.

En esta etapa, tiene una mejor comprensión de Google BERT. Veamos cómo puede optimizar su sitio web para disfrutar de un buen SEO en la era de BERT.

Capítulo 4: ¿Cómo optimizar su sitio web para Google BERT?

La optimización de motores de búsqueda es el proceso de aumentar la visibilidad de un sitio web en los motores de búsqueda.

Por lo tanto, cualquier actualización que los motores de búsqueda realicen en su algoritmo influye en el proceso de clasificación.

4.1. ¿Cuál es el impacto de BERT en SEO?

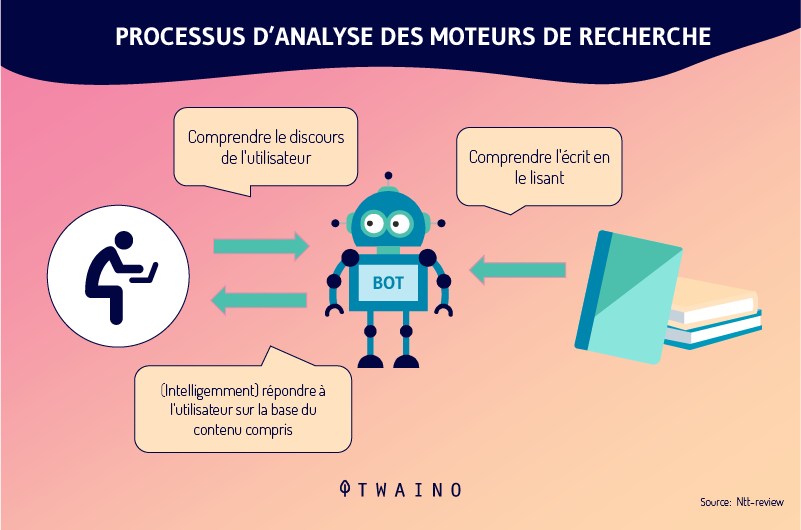

El punto más obvio que se desprende de todo lo que hemos cubierto hasta ahora es que BERT ayuda a Google a comprender mejor el lenguaje humano.

BERT puede captar matices en el lenguaje natural humano, lo que marcará una gran diferencia en la forma en que Google interpreta las consultas.

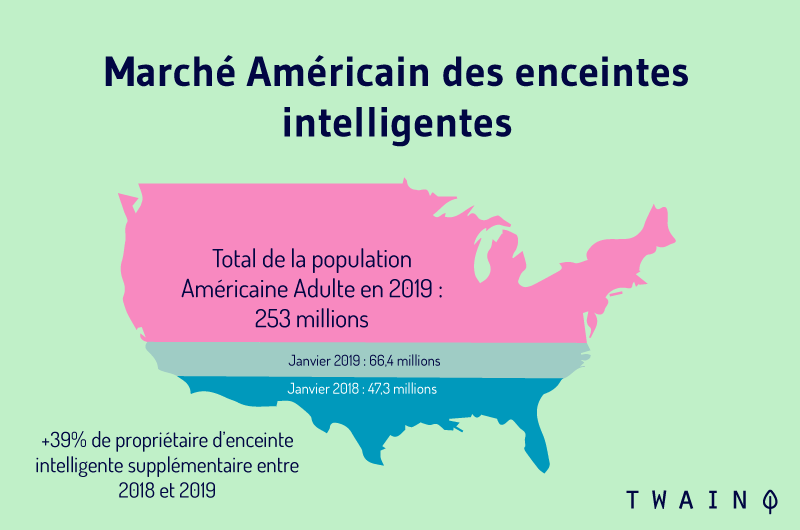

La firma estima que este cambio afectará al 10% de todas las consultas, como Google está tratando de comunicar:

“De hecho, cuando se trata de clasificar los resultados, BERT ayudará a Search a comprender mejor una de cada diez búsquedas en los Estados Unidos en inglés, y nos expandiremos a otros idiomas y ubicaciones con el tiempo.Google

RankBrain, intención de manejar principalmente consultas largas y conversacionales con BERT:

«Especialmente para consultas más largas y conversacionales, o búsquedas donde las preposiciones como ‘for’ y ‘to’ importan mucho.quecontexto de las palabras en su consulta. Puede realizar su búsqueda de una manera que le resulte natural..

El buscador también pretende aprehender consultas en las que las preposiciones o cualquier otra palabra ambigua son importantes para comprender el significado de la oración

Qué conservar: BERT es una poderosa actualización que Google usa para procesar mejor las consultas y presentar los mejores resultados posibles a sus usuarios.

Obviamente, otra interpretación/mejor comprensión de las consultas hace que Google dé otras respuestas en lugar de las que solía dar.

Muchas personas se han quejado del impacto en sus clasificaciones y otras han visto mejorar sus clasificaciones, como se esperaba.

Con BERT, Google puede determinar si las páginas que ha clasificado para ciertas consultas son relevantes o no.

En este caso, podría degradarlas y poner en su lugar otras páginas que considere mucho más apropiadas.

Y la pregunta largamente esperada:

4.2. ¿Cómo optimizar su sitio web para Google BERT?

Podemos describir BERT, pero la pregunta más importante es qué puede hacer para optimizar su sitio web para BERT.

Para ello, nos vamos a referir a Danny Sullivan de quien hablé mucho en mi artículo sobre RankBrain.

Es el enlace de audiencia de Google, lo que significa que ayuda a las personas a comprender mejor la búsqueda y ayuda a Google a comprender mejor los comentarios de la audiencia.

Su respuesta a la pregunta es bastante simple:

Traducido al francés, tenemos:

“No hay nada que optimizar con BERT, ni nada que repensar para cualquiera que sea. Los fundamentos que nos impulsan a recompensar el contenido «excelente» permanecen sin cambios… Mi respuesta fue que BERT no cambia los fundamentos de lo que hemos estado diciendo durante mucho tiempo: escribir contenido para los usuarios. Usted o cualquier persona que trabaje con clientes puede saber por mucho tiempo que eso es lo que decimos.no

nada que debas hacer a partir de hoy que no deberías haber estado haciendo antes del BERT.

Al igual que RankBrain, Google BERT le permite a Google comprender mejor las consultas.

Por ejemplo, no califica el contenido como un algoritmo que tiene en cuenta la velocidad de carga de los sitios web para clasificarlos.

Por lo tanto, optimizar para BERT se reduce a: Escribir contenido de calidad para los usuarios.

No hay duda de que Google se ha centrado en el contenido durante algunos años y creo que sus próximas actualizaciones irán en la misma dirección.

Pero intentemos entender cómo optimizar el SEO de un sitio en el contexto de BERT.

Creo que hay dos cosas principales a considerar cuando desea optimizar su contenido para esta importante actualización de Google.

Optimización para BERT: Identifique la intención de búsqueda de sus usuarios

BERT intenta comprender mejor las consultas del usuario o ser más precisos en su intención de búsqueda.

Si la gente investiga, es sobre todo porque tiene una necesidad que satisfacer.

En los ejemplos dados por Google y que vimos en el capítulo anterior, era necesario entender la intención de los usuarios de dar una respuesta relevante.

Tomemos el primer ejemplo: «¿Puedes conseguir medicamentos para alguien en la farmacia?».

Debe entenderse que la intención de la investigación es: Averiguar si es posible que un ser querido tome medicamentos de la farmacia para un paciente.

Al leer la solicitud de una sola vez, no es fácil detectar esta intención de búsqueda. Por eso, es muy importante pasar por el paso de determinar la intención de búsqueda una vez que tenga las palabras clave.

Conocer la intención de búsqueda implica hacer preguntas como:

- ¿Por qué su audiencia busca usando palabras clave específicas?

- ¿Qué buscan lograr a través de su investigación?

- ¿Están tratando de encontrar la respuesta a una pregunta?

- ¿Quieren llegar a un sitio web específico?

- ¿Quieren realizar compras cuando utilizan estas palabras clave?

- Etc.

Con el uso cada vez mayor de la búsqueda móvil y por voz, donde las personas necesitan respuestas rápidas y contextuales a sus preguntas, Google está tratando de ser cada vez más capaz de determinar la intención de búsqueda de las personas.

Así que tenga en cuenta que todo el SERP de Google ahora intenta coincidir mejor con la intención de búsqueda y no con la palabra clave exacta que se busca.

En los últimos años, encontrará que hay situaciones en las que el término exacto que está buscando ni siquiera se incluirá en la página de resultados de búsqueda de Google. Lo digo por experiencia y estoy convencido de que no soy el único.

Esto sucede porque Google se ha vuelto cada vez más bueno para determinar la intención de búsqueda de las personas.

He tratado este tema extensamente, el cual encontrarás a través de artículos como:

- Qué es el SEO ;

- Cómo configurar un capullo semántico;

- El comer.

El contenido que cumpla con la intención de búsqueda de las personas será recompensado con Google BERT.

Optimización para BERT: considere la búsqueda por voz y los fragmentos destacados

(De ahora en adelante, es todo mío, realmente no he visto esto en ninguna parte, por lo que está sujeto a su criterio)

Google ha declarado que BERT se trata de consultas largas y conversacionales. Y adivina en qué tipo de búsqueda solemos encontrar estos dos elementos: Voice Search.

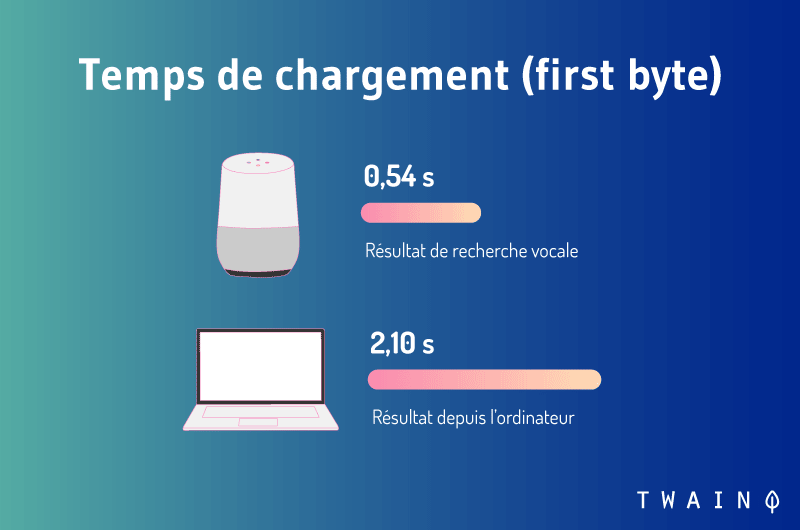

Si BERT maneja principalmente consultas largas y lenguaje natural, esto significa que permite que Google procese una buena parte de las búsquedas por voz que generalmente son largas:

además de largas, las consultas generalmente son conversacionales.

De la misma manera que no puedes decirle a tu amigo «Eiffel» que obtenga información sobre este monumento, tampoco lo harás con tu asistente de voz.

Será más conversacional si hace una pregunta completa: «¿Qué es la Torre Eiffel?».

Con consultas largas + conversacionales, utilizará todas las palabras para formular su pregunta. Esto puede llevarte a utilizar las preposiciones de las que habla Google y que a veces son importantes.

Conclusión: La búsqueda por voz es el tipo de consultas que Google quiere procesar con Google BERT.

Este hecho puede deberse a que los usuarios utilizan cada vez más asistentes de voz para realizar búsquedas:

Google obviamente no quiere perderse esta revolución que es mucho más exigente que la investigación tradicional con la redacción:

Debes intentar optimizar tu contenido para la búsqueda por voz y una de las mejores maneras de comenzar es pensar en el fragmento destacado:

debe comprender que los buscadores desean encontrar muy rápidamente el contenido que responde exactamente a su pregunta.

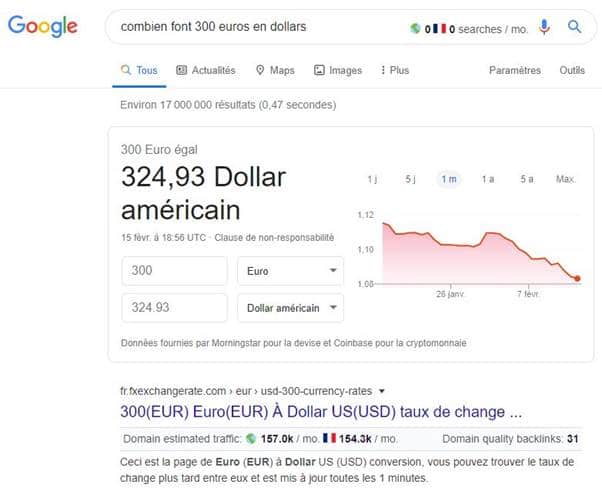

Si busca algo como “cuánto son 300 euros en dólares”, obtendrá una respuesta directa en el fragmento destacado:

con la actualización de BERT, Google se ha esforzado por mostrar fragmentos destacados aún más relevantes.

Consulte mi artículo sobre la búsqueda por voz para conocer algunos consejos útiles.

Terminemos nuestra guía con algunas de las mejores prácticas para adoptar en la creación de contenido en la era de BERT.

Capítulo 5: ¿Algunas buenas prácticas a adoptar en marketing de contenidos en la era de BERT?

Google está dando cada vez más crédito al contenido de alta calidad y usted debe concentrarse en escribir contenido relevante para el usuario.

Si tiene contenido de baja calidad en su sitio, puede ser hora de limpiarlo o actualizarlo, ya que es posible que no funcione bien con Google BERT.

Lo que nos lleva a la primera práctica:

Práctica 1: audite el contenido que ha publicado

Antes de comenzar a crear contenido nuevo, el mejor enfoque es realizar una auditoría del contenido que ha publicado hasta el momento.

Este paso te permite principalmente conocer el contenido que más tráfico trae a tu sitio web y que te permite ocupar las mejores posiciones en las SERPs.

Una vez determinados estos contenidos, realizarás una evaluación para determinar si:

- Son naturales y no contienen palabras clave con connotación mecánica;

- Responder a las intenciones de los usuarios de Internet;

- Están optimizados para la búsqueda conversacional;

- Son lo suficientemente cualitativos para aportar un valor añadido real a los usuarios de Internet;

- Están optimizados para EAT;

- Etc.

Con los recursos que he enumerado hasta ahora, es probable que tenga varios indicadores que estará observando.

Esta acción te permite optimizar tu contenido para que no pierda posicionamiento en las SERPs.

Especialmente si la competencia proviene del contenido que ofrece una mejor experiencia de usuario que la tuya, rendirás menos.

Por lo tanto, una auditoría de contenido le permite fortalecer y/o mejorar la posición de su contenido que ya tiene un buen desempeño en los SERP.

También es una oportunidad para descubrir contenido de mala calidad y optimizarlo o eliminarlo si finalmente no sirve para nada.

Dicho esto, si acaba de lanzar su sitio web, tenga en cuenta que, por lo general, lleva tiempo que su contenido comience a funcionar.

Para ir un paso más allá, puede considerar una auditoría SEO completa o aprovechar mi auditoría SEO gratuita.

Práctica 2: Crear contenido autorizado

Por definición, el marketing de contenido implica la creación de contenido de alto valor para atraer y retener a una audiencia claramente definida.

Como Google entiende mejor el lenguaje natural, está claro que los escritores de contenido tienen una gran oportunidad de servir a sus lectores con contenido escrito de una manera más «humana». Y que respondan plenamente a las intenciones de investigación de los investigadores.

BERT parece hacer que Google entienda aún mejor las consultas del buscador, así que no tienes excusa.

Crear contenido de autoridad es una de las estrategias más efectivas para atraer a Google. La prueba: Toda mi estrategia de creación de contenidos se basa exclusivamente en contenidos evergreen, lo que me ha permitido llegar actualmente a los 6.000 visitantes al mes.

Consulte mi artículo sobre la técnica de superioridad para aprender a crear dicho contenido.

El consejo más importante es realizar un análisis SERP para conocer el nivel actual de calidad del contenido presente en los resultados de Google.

Detallé este proceso en mi publicación sobre 5 pasos para analizar el SERP para un mejor contenido.

Prestará atención a:

- Volúmenes de búsqueda de palabras clave;

- El tipo de contenido clasificado en las palabras clave;

- La dificultad de clasificar en estas consultas;

- Los backlinks que permitieron que las páginas aparecieran en los primeros resultados de Google;

- Etc.

Puedes ponértelo más fácil usando herramientas como Moz, Ahrefs, Ubersuggest…

Y si te preguntas por qué necesitas una herramienta, te diré que una herramienta puede darte muchas pistas sobre lo que realmente interesa a sus usuarios. Esto le permite escribir contenido que realmente satisfaga las necesidades de su audiencia.

Práctica 3: Optimice su EAT (Experiencia en autoridad y confiabilidad)

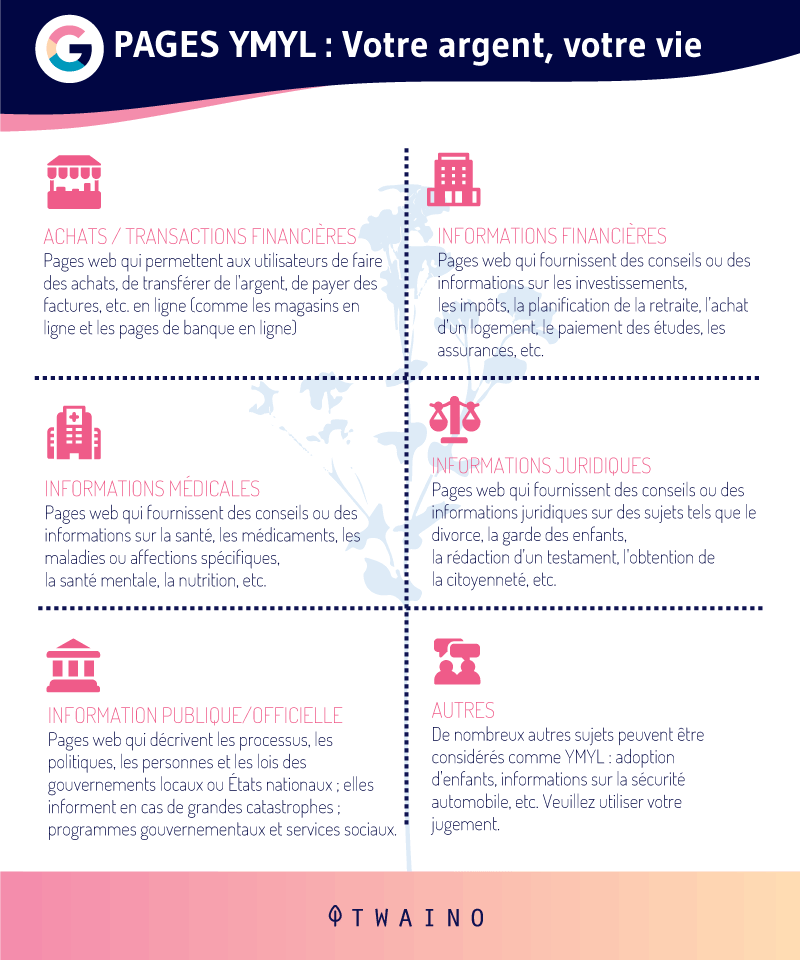

Google está poniendo cada vez más énfasis en el concepto de EAT, especialmente para los sitios YMYL.

Estos son los sitios web que tienen un impacto en la vida de los usuarios de Internet:

Pero incluso si su sitio web no entra en estas categorías, es igualmente importante darle una gran importancia a la EAT.

Quizás se pregunte cuál es la conexión con Google BERT.

Tenga en cuenta que puede crear contenido de calidad, pero si carece de autoridad o confiabilidad en la web, puede tener un rendimiento inferior al de sus competidores.

Por lo tanto, pensar en optimizar su sitio web para EAT es una de las mejores estrategias de SEO:

Ya está, no hay casi nada que agregar que no sepa.

Conclusión: Google BERT – Sea simplemente natural en la creación de su contenido de alto valor agregado

Desde su creación, Google nunca ha dejado de mantener su visión que es ofrecer los mejores resultados a sus usuarios.

En esta lógica, el líder de los buscadores acaba de añadir otra gran actualización a su lista: BERT.

Como es habitual, este cambio no ha pasado desapercibido para la comunidad SEO, que debe entender cómo funcionan los motores de búsqueda para optimizar su estrategia SEO.

En este artículo, traté de mostrar cómo funciona Google BERT evitando los términos técnicos tanto como sea posible. Desafortunadamente, no lo he escapado por completo☹

Pero entendimos que BERT es un modelo de aprendizaje automático de «código abierto» que se presenta como un gran avance en el campo del procesamiento del lenguaje natural.

Google lo usa para comprender mejor las diferentes palabras en las consultas, en particular a través de su contexto. Una mejor comprensión que impacta en el 10% de las consultas procesadas por el motor de búsqueda.El único consejo que da la firma es centrarse en: Crear contenido de alta calidad

De hecho, todas las últimas actualizaciones de Google tienden a favorecer el contenido que aporta un gran valor añadido a los usuarios de Internet.

Por eso, ahora más que nunca es el momento de centrar exclusivamente tus esfuerzos en crear contenido de alta calidad.

Tuve la oportunidad de darte algunos consejos que puedes aprovechar para aprovechar al máximo la era Google BERT y probablemente las próximas actualizaciones de Google.

Deseas, como siempre, mucho tráfico, te digo:

¡Hasta pronto!