Si usted es un desarrollador de sitios o páginas web, debe saber que es esencial que tenga el archivo robots.txt.

Es posible que muchas personas ya se pregunten a qué me refiero, especialmente si no tienen conocimiento de SEO o el desarrollo de la web.

Recuerde que este es un archivo de texto muy importante. Se utiliza para gestionar las solicitudes de exploración de su sitio por parte de los rastreadores de Google.

Esta mini-guía le permitirá conocer más a fondo lo que se entiende por robots.txt.

También encontrará el proceso de creación y configuración de robots.txt, así como las mejores prácticas para utilizarlo.

Capítulo 1: ¿Qué es un archivo robots.txt y cuál es su finalidad?

En este primer capítulo, aprenderá el verdadero significado de robots.txt así como su utilidad.

1.1 ¿Qué es un robots.txt y qué aspecto tiene?

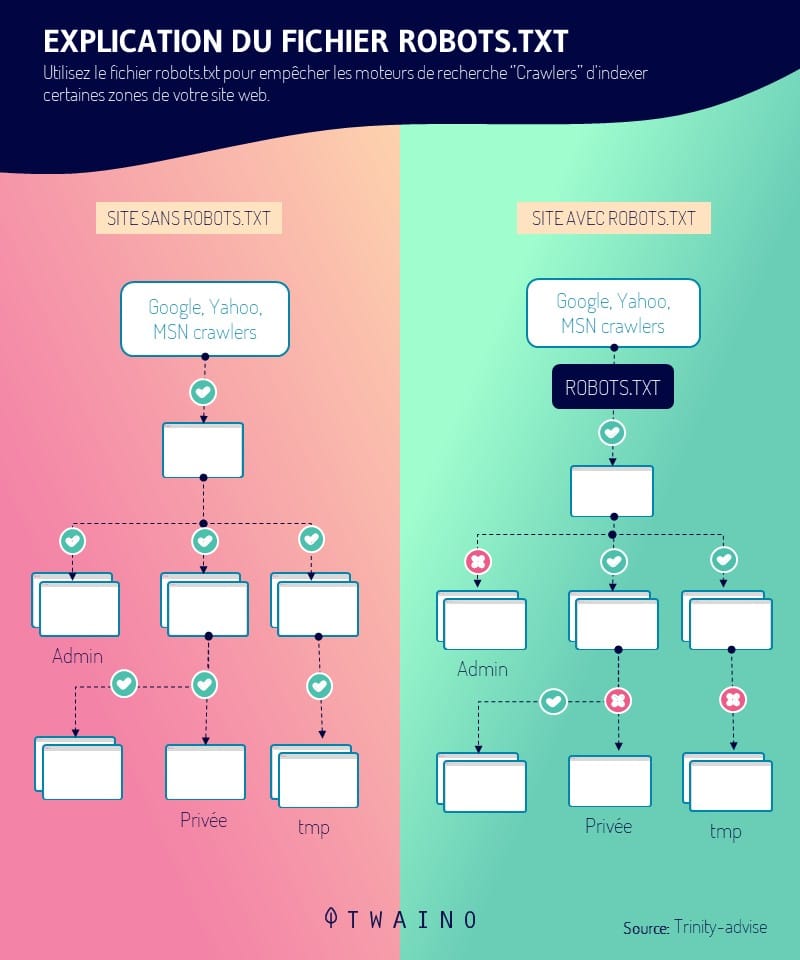

El robot.txt representa un dato informático. Más concretamente, es un archivo de texto que se utiliza en los sitios web para indicar a los rastreadores (principalmente a los motores de búsqueda) cómo rastrear las páginas de los sitios web.

Más técnicamente, forman parte de un protocolo de exclusión y representan las normas que rigen la forma en que los rastreadores rastrean la web, acceden al contenido y lo indexan

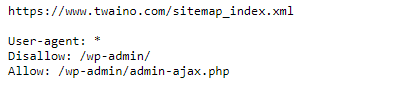

Se incluye en la raíz de su sitio web, de modo que si la dirección de su sitio web es: www.monsite.com, la URL que lleva al robots.txt es www.monsite.com/robots.txt.

- Si el archivo robots.txt está presente en su sitio, cuando introduzca la URL www.monsite.com/robots.txtverá una ventana como :

Sin embargo, si no está presente obtendrá un mensaje de error como 404.

1.2) ¿Cuál es la importancia del archivo robots.txt para un sitio web?

Como habrá adivinado, los robots.txt desempeñan un papel importante en su sitio web al controlar la forma en que lo navegan los rastreadores

Por lo tanto, puede :

- Evite que los robots de Google rastreen el contenido duplicado;

- Negarse a mostrar una parte privada del sitio en las SERP;

- Denegar la visualización de las páginas de resultados de búsqueda interna del sitio en los resultados de búsqueda de Google;

- Rechace que los motores de búsqueda indexen ciertos elementos de su sitio;

- Especifique un tiempo de rastreo para evitar la sobrecarga de su sitio;

- Optimice el uso de los recursos de su servidor evitando que los bots malgasten los recursos de su sitio.

Ahora que sabe qué es un robot.txt y por qué es importante, veamos cómo crearlo e implementarlo en un sitio web

Capítulo 2: Cómo crear el archivo robots.txt para su sitio web

Después de explicar el proceso de creación del archivo robots.txt para un sitio web, explicaré cómo proceder para averiguar si su archivo funciona o no.

2.1. Creación del archivo robots.txt para su sitio web

El archivo robots.txt puede crearse manualmente o generarse automáticamente en la mayoría de los CMS como WordPress

Pasaremos por ambos procesos de creación. Sin embargo, antes de buscar instalar el archivo robots.txt, asegúrese de que su sitio no tiene ya uno

2.1.1. Crear su propio archivo robot.txt

Para crear su propio archivo robot.txt, necesita un editor de texto (se trata de un software para crear y editar archivos de texto) Bloc de notas y texto sublime son ejemplos.

Una vez que haya elegido y descargado su editor, para crear su archivo robot.txt deberá seguir ciertas reglas. Estas normas se refieren a:

La ubicación y el formato del archivo robots.txt

- Su archivo debe llamarse robots.txt ;

- Sólo se permite un archivo robots.txt en su sitio;

- Su archivo robots.txt debe estar ubicado en la raíz de su sitio.

La sintaxis de su archivo robots.txt

- El archivo robots.txt debe respetar la codificación UTF-8;

- El archivo consta de uno o varios grupos de instrucciones;

- La regla, una declaración por línea y por línea vacía debe ser respetada.

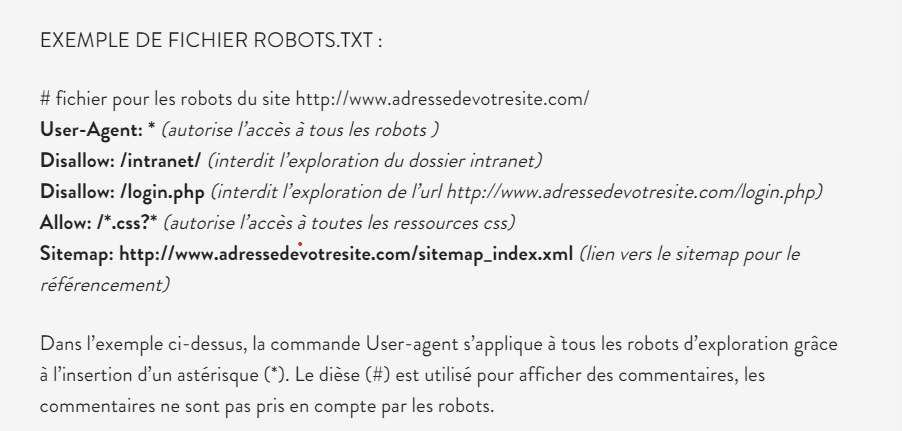

Los comandos (instrucciones o directivas) que debe utilizar para crear su archivo robots.txt:

- Agente de usuario esta es la primera línea y contiene el nombre del robot del motor de búsqueda. Puede consultar la base de datos de robots para encontrar el nombre del robot que quiere prohibir;

- Disallow : En este comando, deberá poner la URL de la página o la carpeta a la que quiere prohibir el acceso a los robots;

- Permitir : Permite autorizar la exploración de una URL o de una carpeta por parte de los robots;

- Mapa del sitio esta instrucción opcional le permite indicar a los robots de Google las partes de su sitio que deben explorar.

Para obtener más información sobre estas diferentes normas, eche un vistazo al soporte de Google.

Aquí tiene un ejemplo de archivo robots.txt

fuente anthedesign

Una vez que su archivo de texto esté listo, el siguiente paso sería instalarlo en su sitio web.

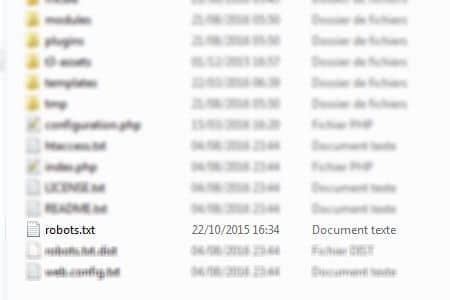

Para ello, sólo tiene que acceder a la raíz de su sitio desde su software cliente FTP y soltar el archivo robots.txt en el directorio www

Fuente Web-eau

Eso es todo, su archivo robots.txt está creado e instalado en su sitio.

2.1.2. Creación del archivo robots.txt con WordPress

En WordPress, se crea automáticamente un archivo robots.txt para su sitio

Si utiliza un sitio de WordPress, simplemente escriba en la barra de búsqueda la URL de su sitio seguida de: /robots.txt para comprobar el archivo robots.txt.

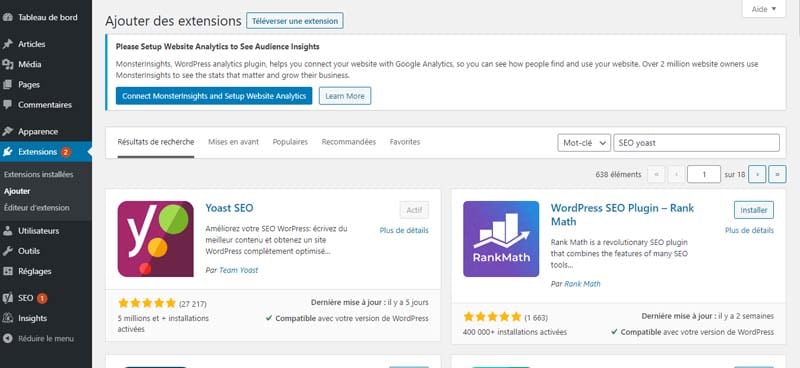

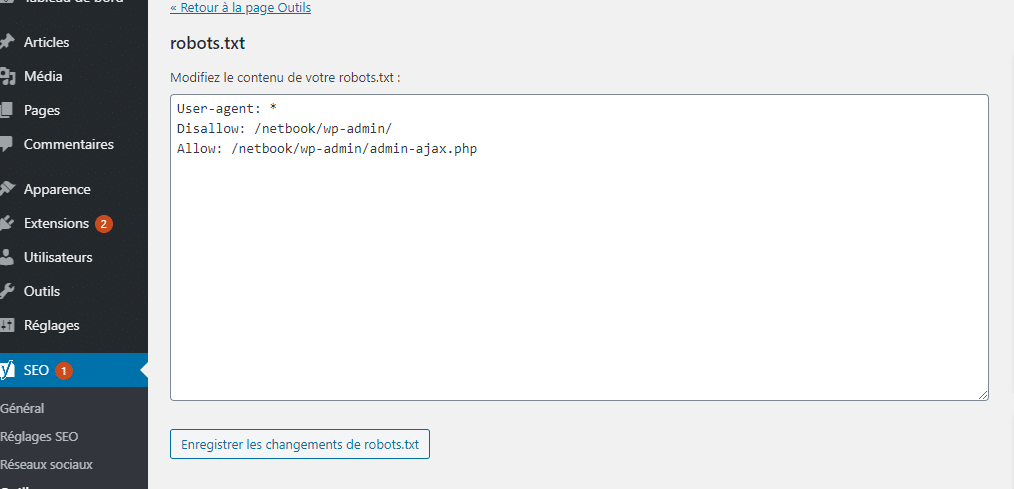

En cualquier caso, puede crear su propio archivo robots.txt utilizando plugins como SEO YOAST o TODO EN SEO.

Para crear su archivo robots.txt con SEO YOAST, simplemente busque, descargue e instale la extensión SEO YOAST en WordPress.

A continuación, actívela y vaya a la configuración de la extensión.

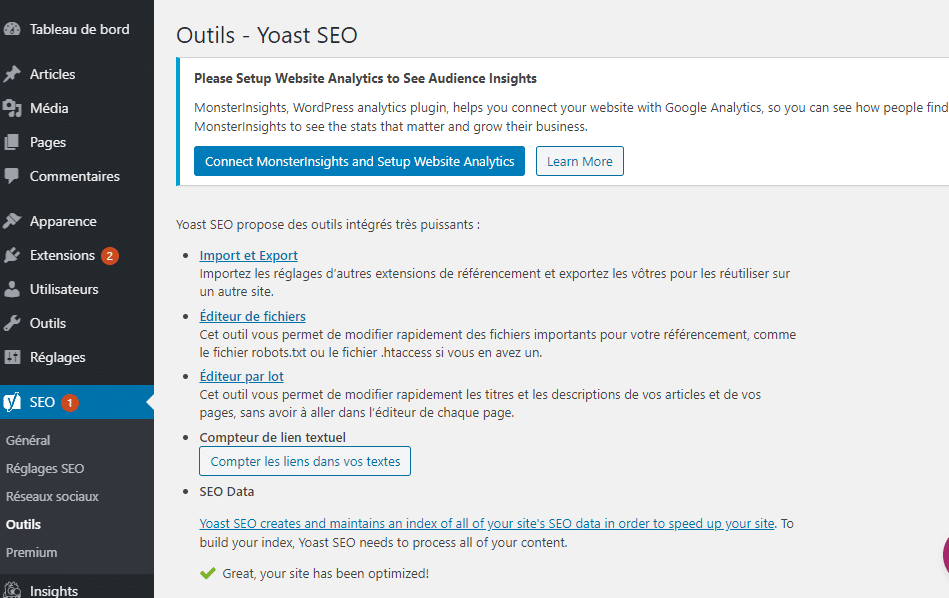

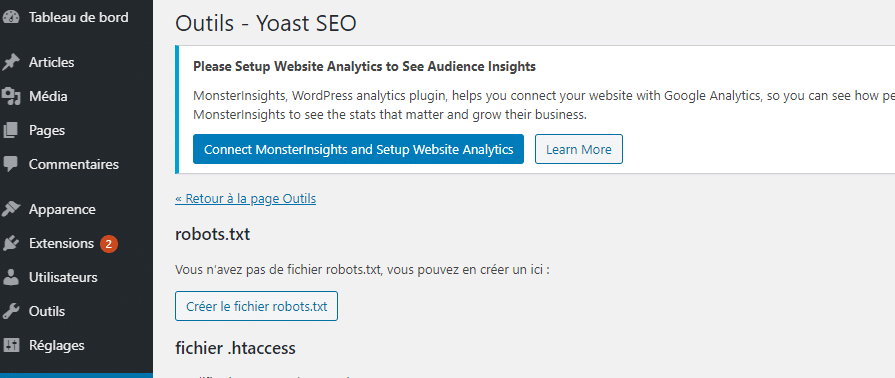

Una vez en los ajustes, seleccione «editor de archivos» y espere a que se cargue la nueva ventana.

Elija «crear archivo robots.txt».

Finalmente edite el contenido del robots.txt virtual creado por WordPress y guarde los cambios.

También puede crear el archivo robots.txt desde la extensión ALL In SEO. Para ello, primero debe descargar, instalar y activar la extensión.

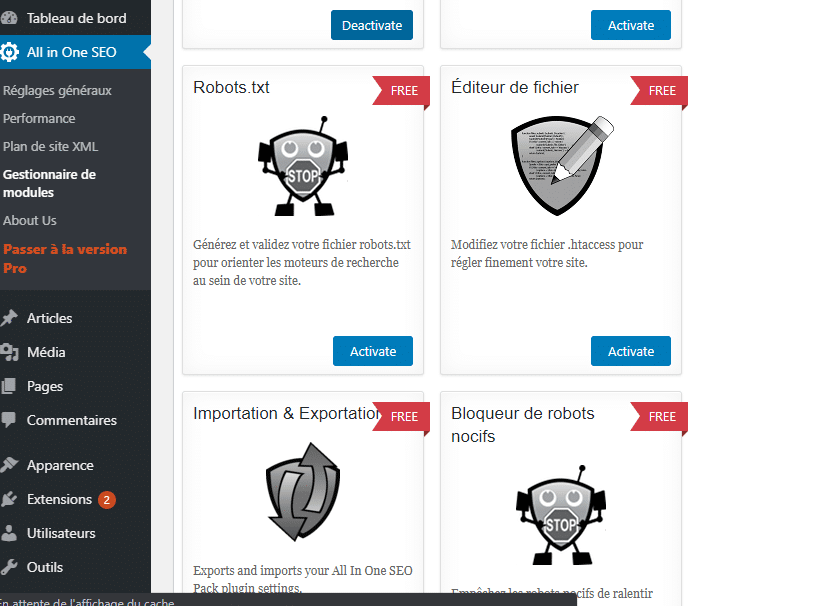

A continuación, una vez que esté en las opciones de extensión, seleccione la gestión de módulos y espere a que se cargue la nueva ventana con los diferentes módulos.

Busque el módulo robots.txt y pulse activar para configurar su archivo robots.txt.

Ahora ha creado su archivo robots.txt, ya sea manualmente o utilizando un plugin en WordPress

El siguiente paso sería comprobar si el archivo robots.txt creado funciona.

Para ello, tendrá que hacer una prueba.

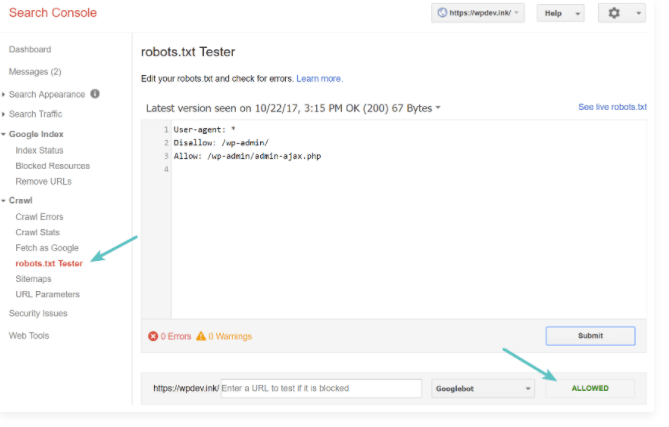

2.3. compruebe su archivo robots.txt.

Para probar su archivo robots.txt, simplemente siga el instrucciones de Google de las instrucciones sobre este tema

Específicamente, necesita ir a su consola de búsqueda y haga clic en la pestaña de rastreo y luego en la prueba de robots.txt

A continuación, tendrá acceso a una ventana que le permitirá enviar su archivo robots.txt a Google.

fuente kinsa

No olvide integrar las modificaciones a su archivo antes de subirlo al servidor de su sitio.

Capítulo 3: Los diferentes usos de robots.txt.

Aquí veremos algunos de los usos de robots.txt. Pero primero, hablaremos del propósito final de un archivo robots.txt.

3.1. El propósito de robots.txt

Una vez que haya creado e instalado con éxito el archivo, es importante saber cómo utilizarlo

El objetivo principal de utilizar los archivos robots.txt es denegar y permitir el acceso de los robots de los motores de búsqueda a su sitio

De hecho, las instrucciones no tienen el mismo modo de funcionamiento. El servicio prestado difiere de una directiva a otra. Sin embargo, el funcionamiento de las instrucciones puede resumirse en dos expresiones: autorización y rechazo.

3.1.1. Autorización

Esto consiste en permitir que todos los robots web exploren todos los compartimentos y páginas web de su sitio. Si este es su deseo, la presencia del archivo robots.txt es por lo tanto inútil, ya que las instrucciones no tienen misiones

En consecuencia, ya no pueden reconocer y controlar los robots web. Por lo tanto, se recomienda abstenerse de instalar el archivo en estas circunstancias

Por otro lado, si ya lo tiene, es simplemente recomendable borrarlo. Sin embargo, si quiere conservarlo, debe dejarlo completamente vacío sin ninguna modificación.

3.1.2. Rechazo

Es posible que desee prohibir a todos los robots web que exploren su sitio. Para ello, es importante la instalación del archivo robots.txt. Se trata de integrar una única instrucción: bloquear el acceso a su sitio a todos los robots web.

Ahora que conocemos los dos objetivos finales de un robots.txt veamos cómo utilizarlo para permitir y denegar el acceso a los robots.

3.2. cómo utilizar robots.txt para bloquear el acceso a todo un sitio

Para evitar que los robots rastreen su sitio por cualquier motivo, simplemente añada a su archivo robots.txt el código :

Agente de usuario : *

Disallow: /

En este código, el asterisco significa: Todos los robots y la barra oblicua en disallow significa que desea denegar el acceso a todas las páginas del dominio de su sitio.

3.¿Cómo se utiliza el archivo robots.txt para evitar que un solo robot rastree su sitio?

Si quiere excluir a un rastreador de un motor de búsqueda específico para que no rastree su sitio, puede utilizar el código :

User-agent: nombre del robot

Disallow :/

El uso de este código le permitirá aplicar la regla de exclusión sólo a un robot específico.

3.3) ¿Cómo evitar que los robots rastreen una carpeta o un archivo de su sitio?

Para evitar que los robots rastreen un archivo o carpeta de su sitio, simplemente utilice el código :

Agente de usuario : *

Disallow: nombre de la carpeta

3.4. Cómo utilizar los robots. Txt para permitir un archivo contenido en una carpeta no autorizada.

Para pedir a los rastreadores que indexen un contenido que está en una carpeta que no desea que los rastreadores exploren por completo, sólo tiene que utilizar el código :

Agente de usuario : *

Disallow : ruta de la carpeta no autorizada

Permitir : ruta del archivo a explorar

Más allá de estos usos, tenga en cuenta que el archivo robots.txt puede ser modificado y también puede elegir excluir ciertas páginas del archivo robots.txt

3.5. ¿Cómo modificar un archivo robots.txt?

Hay que reconocer que es muy raro modificar un archivo robots.txt ya instalado. Sin embargo, es posible modificarlo. Excepto que debe esperar una reconfiguración de su sitio.

Si ha creado e instalado su archivo manualmente, deberá abrir su archivo robots.txt en la raíz de su sitio y realizar los distintos cambios que desee. Una vez que haya terminado, debe guardar los cambios y guardar su archivo.

Sin embargo, si está utilizando un CMS como WordPress, puede modificar su archivo utilizando los plugins SEO YOAST y All In SEO siguiendo las instrucciones de la parte 2.2.

3.6. ¿Cómo excluir ciertas páginas de su archivo robots.txt?

Como es posible modificar este archivo, también es posible excluir ciertas páginas de su base de datos robots.txt. Se trata de restar ciertas URLs que pueden acceder al motor de búsqueda de su sitio.

Para ello, tiene que volver a la raíz de su sitio. Debe poder acceder al contenido del archivo. A continuación, vaya a la carpeta de declaraciones Disallow. Es esta directiva la que constituye la memoria de todas las URLs autorizadas.

A continuación, le corresponde identificar las direcciones indeseables que desea extraer de su base de datos. Basta con desmarcarlas para que sean consideradas como URLs no autorizadas

Ahora que ya lo sabe todo sobre el uso de robots txt, le presento en el capítulo algunas buenas prácticas a adoptar.

Capítulo 4: Algunas buenas prácticas para su archivo txt

Para utilizar correctamente sus archivos robots.txt:

- En la configuración de su archivo robots.txt, asegúrese de que sólo se bloquean las páginas que no tienen valor

- Asegúrese de no bloquear los archivos JavaScript y CSS de su sitio;

- Haga siempre una prueba después de configurar su archivo robots.txt para asegurarse de que no ha bloqueado nada por accidente;

- Coloque siempre el archivo robots.txt en el directorio raíz de su sitio;

- Asegúrese de nombrar su archivo «robots.txt»;

- Añada la ubicación de su mapa del sitio a su archivo robots.txt.

Y eso es todo, hemos terminado con las cosas a tener en cuenta a la hora de manejar su archivo robots.txt.

En pocas palabras

Los Robots.txt son archivos de texto que se instalan en la raíz de los sitios web para controlar el rastreo y la indexación de su contenido por parte de las distintas arañas de los motores de búsqueda.

En este artículo, descubrirá no sólo cómo pueden ser útiles para su sitio, sino también cómo utilizarlos para sacarles el máximo partido.