Panoramica rapida degli strumenti : Generatore di robot.txt

Usa Robots.txt Generator per generare un file robots.txt con la tua mappa del sito in pochi clic.

Presentazione dettagliata dello strumento : Generatore di robot.txt

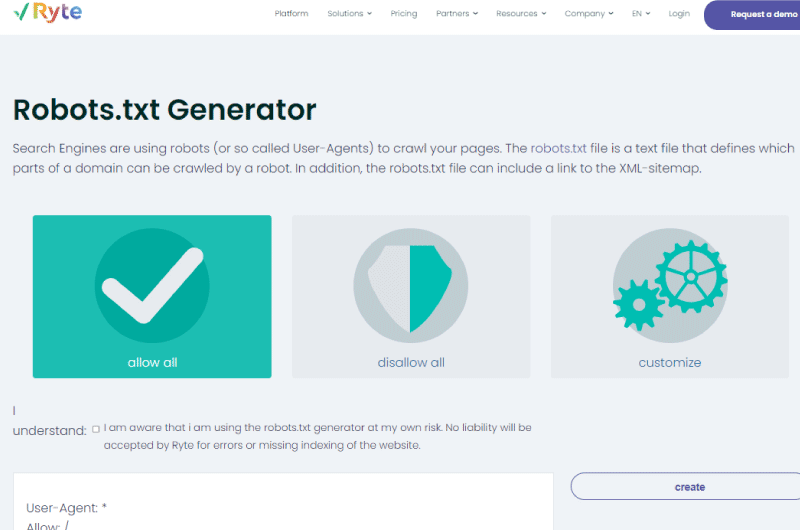

Generatore Robots.txt

I motori di ricerca forniscono ai siti Web un budget di scansione che è il numero di URL che gli spider devono eseguire la scansione di un sito in un determinato periodo di tempo.

Ma ci sono alcuni fattori che consumano questo budget come le pagine di errore. Inoltre, i crawler non devono eseguire la scansione di ogni pagina del tuo sito.

In questo caso, il file robots.txt fornisce istruzioni su come i crawler dovrebbero navigare nel tuo sito. La creazione di questo file d’altra parte può essere un vero mal di testa poiché al minimo errore può influire negativamente sul tuo sito.

Per aiutare i webmaster, RYTE offre lo strumento Robots.txt Generator per generare facilmente file robots.txt.

Attraverso questa descrizione, scopriamo come generare questo file dallo strumento e verifichiamo la correttezza delle tue istruzioni.

Che cos’è il generatore Robots.txt di RYTE?

Il generatore Robots.txt di RYTE è un generatore robots.txt molto facile da usare per i principianti. Puoi assemblare il tuo file robots.txt in pochi passaggi.

In effetti, un file robots.txt è una forma di istruzione per robot e crawler (ad es. Googlebot) che definisce quali directory di un sito Web possono essere lette e quali no. Ad esempio, le pagine duplicate possono essere escluse dall’indicizzazione.

https://www.twaino.com/wp-content/uploads/2020/02/22-Fonction-du-fichier-robots-txt-1.jpg

In assenza di tale file, il motore di esplorazione o il crawler ricerca l’intero sito Web e potenzialmente ogni file.

In questo modo, tutti i file possono essere visualizzati nella ricerca di Google, ad esempio, anche quando non dovrebbero essere presenti (come nell’area di amministrazione privata del sito).

Questo fenomeno può anche avere un impatto negativo sulla tua SEO, perché le sottopagine che vengono scansionate non sono ottimizzate per i motori di ricerca.

Il generatore Ryte Robots.txt può aiutarti a generare rapidamente file robots.txt con una selezione di 11 spider.

Una volta configurato tutto, con un clic puoi creare e caricare il file. Tutto quello che devi fare è caricarlo nella directory principale del tuo sito web.

Per chi è adatto il generatore Robots.txt di RYTE?

Questo generatore di file robots.txt è per i webmaster che vogliono impedire ai motori di ricerca di accedere a determinate risorse sui loro siti che non devono apparire nei risultati di ricerca.

Così facendo ottimizzi tuo sito in modo che gli spider eseguano la scansione solo delle pagine essenziali.

È anche gratuito e ti consente di aggiungere la tua mappa del sito al file robots.txt.

Opzioni del generatore Ryte Robots.txt per generare il tuo file

Prima di esplorare le opzioni di questo strumento, diamo un’occhiata alla sintassi del file robots.txt.

Un file robot include uno o più blocchi di direttive da inviare ai motori di ricerca. La prima riga specifica lo user agent, ovvero il nome della scansione a cui si stanno dando istruzioni di scansione.

Detto questo, si inizia specificando l’interprete a cui dovrebbe applicarsi l’istruzione, quindi segue un comando che non è altro che l’istruzione.

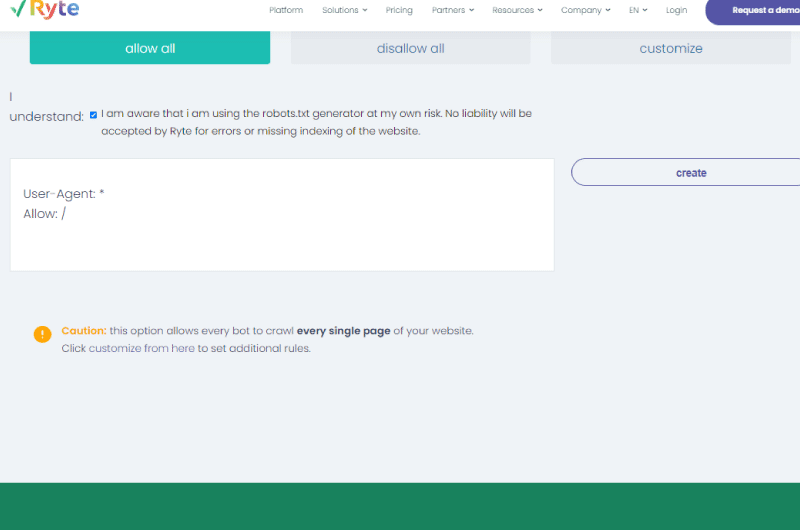

Consenti tutto o accetta tutto

Questa opzione dà accesso a tutti i robot per eseguire la scansione di tutte le pagine del tuo sito web. Capisci che questa non è l’opzione ideale quando non vuoi che tutte le pagine del tuo sito vengano scansionate.

Tuttavia, puoi personalizzarlo e dire quali bot vuoi istruire e quali pagine dovrebbero scansionare.

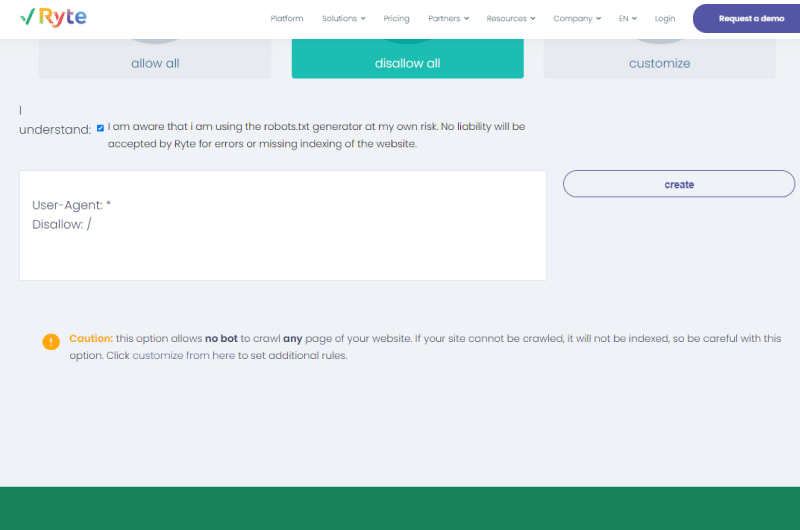

Disabilita tutto o Rifiuta tutto.

Questa opzione non consente ai crawler di eseguire la scansione delle pagine del tuo sito. Tuttavia, se gli spider non possono eseguire la scansione del tuo sito, ovviamente le pagine del tuo sito non verranno indicizzate.

E quando le tue pagine web non sono indicizzate, non possono nemmeno apparire nei risultati di ricerca. Questo è il motivo per cui devi stare attento a come crei un file robot.

Opzione di personalizzazione o personalizzazione

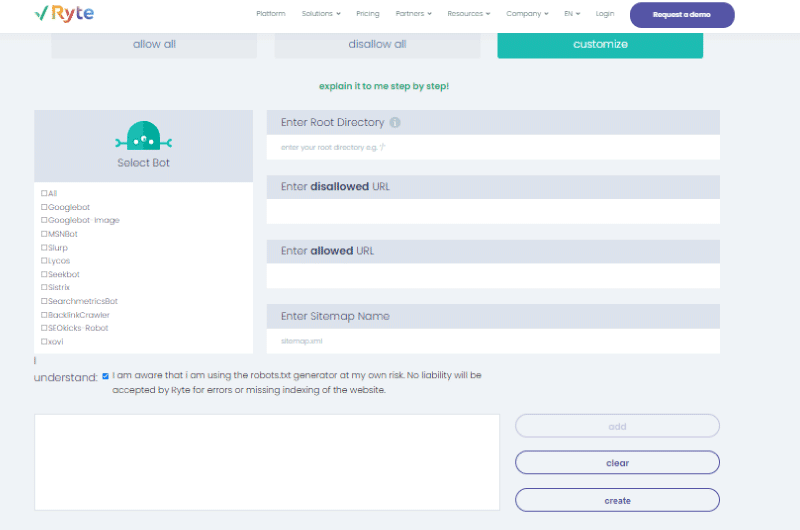

Questa è la parte più interessante dello strumento Ryte Robots.txt Generator, perché hai la possibilità di personalizzare il file robot.txt e fornire istruzioni come desideri.

A sinistra in Seleziona bot, puoi definire a quali crawler vuoi dare indicazioni.

Sulla destra, definirai sia gli URL (o directory) che i bot non devono scansionare sia quelli che possono visitare.

Per farla breve, ecco i passaggi per generare il file utilizzando lo strumento.

- 1. Inserisci la tua radice. Basta inserire ( ⁄ ) e aggiungere gli URL consentiti o non consentiti relativi alla cartella principale del server;

- 2. Scegli il/i robot/i a cui vuoi consentire la navigazione nel tuo sito;

- 3. Inserisci i percorsi che vuoi autorizzare o meno ad accedere al tuo sito;

- 4. Aggiungi la tua mappa del sito per rendere più facile per i crawler vedere la tua mappa del sito quando vi atterrano;

- 4. Ogni volta che finisci con un’istruzione, fai clic su “Aggiungi” per salvare la tua regola e iniziare a scrivere un’altra direttiva;

- 5. Carica il tuo file robots.txt.

Verifica il tuo file robots.txt prima della pubblicazione

Verifica sempre l’accuratezza del file robots.txt prima di inserirlo nella directory principale del sito web.

Il minimo errore può indurre il robot a ignorare le specifiche e forse a integrare pagine che non devono necessariamente essere nell’indice di Google.

Ryte offre anche lo strumento di test Robots.txt che ti consente di testare il tuo file robots.txt. Tutto quello che devi fare è inserire l’URL pertinente e selezionare lo user agent corrispondente.

Dopo aver fatto clic su “Avvia test”, lo strumento verifica se la scansione dell’URL specificato è consentita o meno.

In breve, lo strumento di test Robots.txt di Ryte ti consentirà di generare un file robots.txt per il tuo sito senza alcuna conoscenza tecnica.

Strumento Video : Generatore di robot.txt

Galleria degli strumenti : Generatore di robot.txt

Presentazione dell'azienda : Generatore di robot.txt

Ryte è un’azienda tecnologica tedesca fondata nel 2012 e con sede a Monaco di Baviera. Il suo amministratore delegato è Andreas Bruckschlögl. Ryte è una delle aziende tecnologiche in più rapida crescita in Europa. È stata anche premiata più volte per le sue numerose esibizioni in questo settore.

La missione principale di Ryte è aiutare le agenzie e le aziende a ottimizzare l’esperienza dei propri utenti sui propri siti Web, grazie in particolare a prodotti software all’avanguardia.

Con Ryte, i marketer digitali possono raggiungere il pieno potenziale del loro sito web. Soprattutto perché Ryte fornisce ai suoi utenti tre strumenti essenziali per creare un sito web sostenibile. Questi includono:

- Successo del sito web;

- Successo dei contenuti;

- Ricerca riuscita.

Per raggiungere i suoi obiettivi, Ryte si impegna a sviluppare altri prodotti più efficienti. Inoltre, molte aziende di fama internazionale, come Daimler, Allianz e Sixt, si affidano alla tecnologia di Ryte per sbloccare il potenziale del loro sito web.

Trova l'azienda : Generatore di robot.txt

Generatore di robot.txt sui social network

- Chaîne Youtube

Altri strumenti correlati : Generatore di robot.txt

Alexandre MAROTEL

Alexandre MAROTEL

Fondatore dell’agenzia SEO Twaino, Alexandre Marotel è appassionato di SEO e generazione di traffico su Internet. È autore di numerose pubblicazioni e possiede un canale Youtube che ha lo scopo di aiutare gli imprenditori a creare i loro siti Web e ad essere meglio referenziati su Google.