Rastreador | Deep Crawl

Visão geral rápida das ferramentas : Rastreador

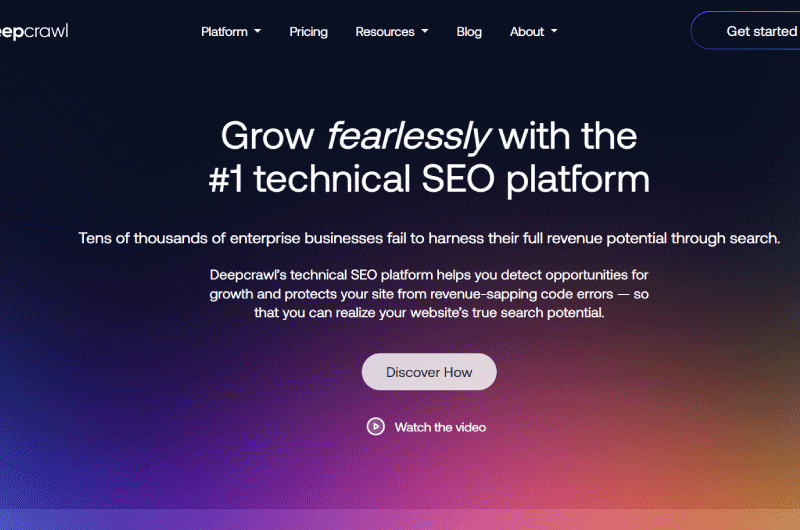

DeepCrawlName é um rastreador que rastreia seu site para revelar o desempenho técnico ideal para ajudá-lo a melhorarindexabilidade e sua experiência do usuário para fins de SEO.

Apresentação detalhada da ferramenta : Rastreador

Descrição Rastreamento Profundo

Se você precisar examinar a integridade técnica do seu site,Deepcrawl é um explorador que permite ver como os mecanismos de pesquisa rastreiam seu site.

A ferramenta fornece uma ampla gama de informações sobre cada página do seu site para lhe dar uma ideia clara de sua indexabilidade.

Vamos descobrir nesta descrição como o Deepcraw funciona.

O que éDeepcrawl ?

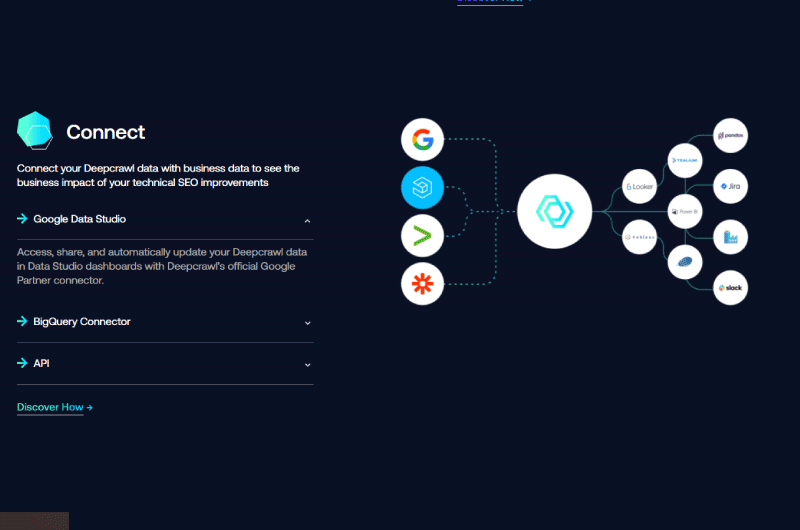

A ferramenta funciona subtraindo dados de diferentes fontes, como sitemaps XML, console de pesquisa ou Google Analytics.

Assim, dá-lhe a possibilidade de ligar até 5 fontes para tornar a análise das suas páginas relevantemente eficaz.

O objetivo é simplificar a detecção de falhas na arquitetura do seu site, fornecendo dados como páginas órfãs que geram tráfego.

A ferramenta oferece uma visão clara da integridade técnica do seu site e insights acionáveis que você pode usar para melhorar a visibilidade do SEO e converter o tráfego orgânico em receita.

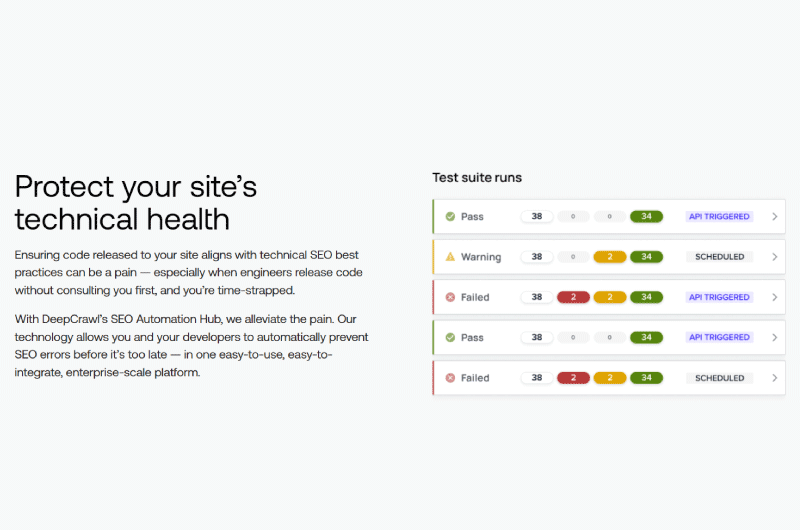

A configuração de um site para rastreamento pode ser feita em quatro etapas simples.

Ao se inscrever para uma avaliação gratuita do Deep Crawl, você é redirecionado para o painel do projeto. A segunda etapa é escolher as fontes de dados para exploração.

Seguindo as instruções, você pode configurar rapidamente seu site e acessar as coisas mais importantes:

Painéis

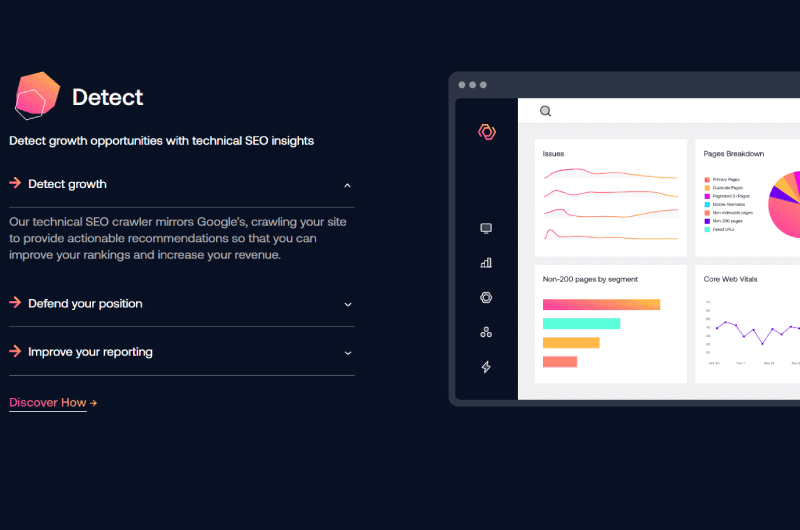

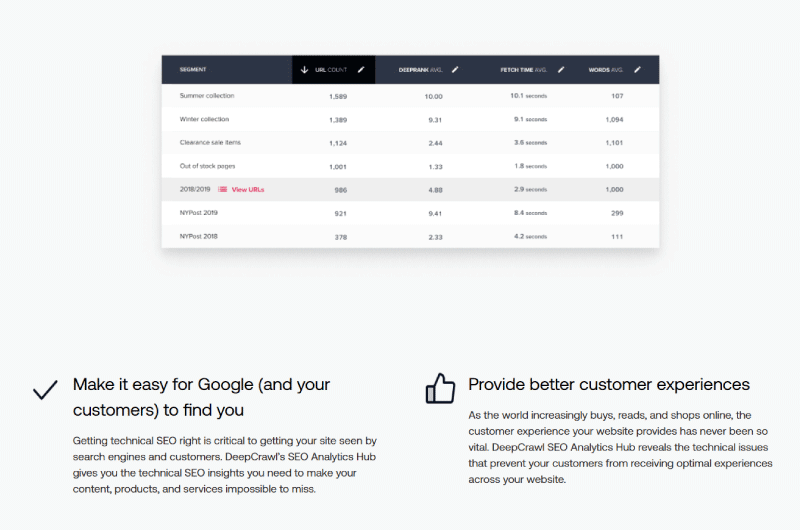

Quando o Deep Crawl termina de rastrear um site inteiro, ele exibe em um painel bastante intuitivo uma visão abrangente e precisa de todos os arquivos de log encontrados.

Em um primeiro gráfico, podemos ler um detalhamento completo e rápido de todas as solicitações feitas por usuários de dispositivos móveis, como computadores.

Segue-se um resumo que destaca não só os principais problemas de indexação do site, mas também uma lista de todos os elementos que podem, de uma forma ou de outra, impedir a indexação das páginas do site.

O Deep Crawl subtrai e analisa todos os dados de carga de todas as fontes que você vinculou durante a configuração e os combina com dados de arquivos de log para melhor qualificar cada problema detectado.

Observamos neste relatório que muitos dos URLs listados nos sitemaps XML não foram solicitados.

E isso pode ser devido a uma ligação fraca das páginas entre elas ou a uma profundidade bastante importante da arquitetura do site a ponto de ser necessário um robô mais poderoso para alcançar as páginas da web do fundo.

Além disso, quando os sitemaps XML são obsoletos, eles não refletem mais as URLs ativas de forma alguma.

Nesse caso, podemos deduzir que um orçamento de rastreamento é muito importante, especialmente se você tiver um site grande.

Análise adicional

A seção de análise aprofundada é caracterizada por dois conjuntos de dados que são “Bot Hits” e “Problemas”.

Oprimeiro-ministro conjunto de dadoschamado O Bot Hits lista todas as URLs solicitadas levando em consideração não apenas o número total de solicitações, mas também os dispositivos usados para fazer as solicitações.

A ideia é ajudar você a ver as páginas em que os robôs mais se concentram ao explorar seu site e as áreas de deficiência, como páginas potencialmente obsoletas ou órfãs.

Há também uma opção de filtro que permite identificar todos os URLs que provavelmente são afetados pelos problemas de alguns.

Além disso, a guia”Problemas” mostra todos os problemas que afetam seu domínio com detalhes completos do erro com base nos dados do arquivo de log.

Trata-se principalmente de:

Páginas de erro

Esta seção fornece uma visão geral de todos os URLs encontrados no arquivo de log durante o rastreamento, mas que retornam um código de resposta do servidor 4XX ou 5XX.

Essas são as URLs que podem causar grandes problemas ao site e precisam de reparos urgentes.

Páginas não indexáveis

Esta seção destaca os URLs que podem ser rastreados pelos mecanismos de pesquisa, mas são definidos como noindex e contêm uma referência canônica a um URL alternativo ou são bloqueados em robots.txt, por exemplo.

Este relatório exibe URLs considerando o número de URLs acessíveis em arquivos de log.

Na realidade, nem todos os URLs aqui são necessariamente ruins, mas é uma ótima maneira de destacar o orçamento de rastreamento realmente alocado para páginas específicas, permitindo que você faça uma divisão justa, se necessário.

Páginas não autorizadas

Quando você impede que determinados URLs do seu site sejam indexados em um arquivo robots.txt, isso não significa que não haverá solicitações no arquivo de log.

Esta seção permite identificar os URLs do seu site que podem ser indexados apesar de estarem bloqueados em um arquivo robots.txt.

Ele também permite que você veja os elementos que estão faltando em determinadas páginas para que não sejam indexados pelos rastreadores dos mecanismos de pesquisa como você gostaria, por exemplo, páginas sem o atributo noindex.

Páginas indexáveis

Aqui você pode ver todos os URLs do seu site que podem ser facilmente indexados pelos mecanismos de pesquisa.

O que é especial sobre esse recurso é que ele também mostra uma lista de URLs que não geraram nenhuma consulta de mecanismo de pesquisa nos arquivos de log fornecidos.

Na maioria dos casos, são páginas órfãs, ou seja, aquelas que possuem poucos links com outras páginas do site.

Páginas de desktop e alternativas móveis

Esses dois relatórios permitem que você veja se suas páginas estão sendo exibidas corretamente nos dispositivos para os quais você as definiu.

Essa exibição é particularmente útil para sites que usam uma versão móvel autônoma ou para sites responsivos e adaptáveis. Também é uma maneira melhor de ver URLs menos solicitadas, provavelmente antigas ou irrelevantes.

Vídeos de ferramentas : Rastreador

Galeria de ferramentas : Rastreador

Apresentação da empresa : Rastreador

Rastejamento Profundo

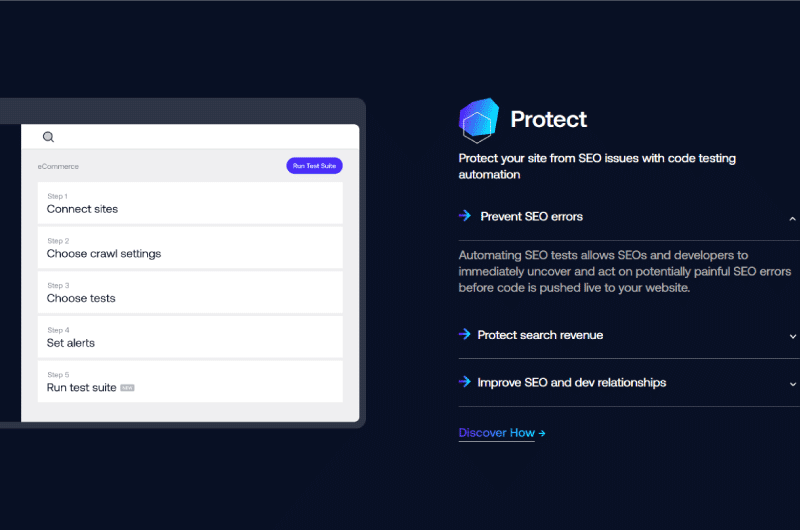

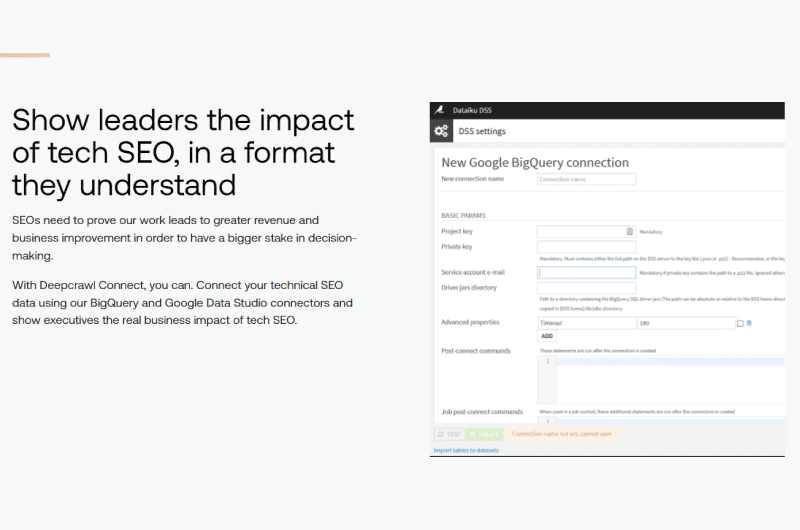

Deep Crawl é uma plataforma técnica de SEO que ajuda a detectar oportunidades de crescimento para sites.

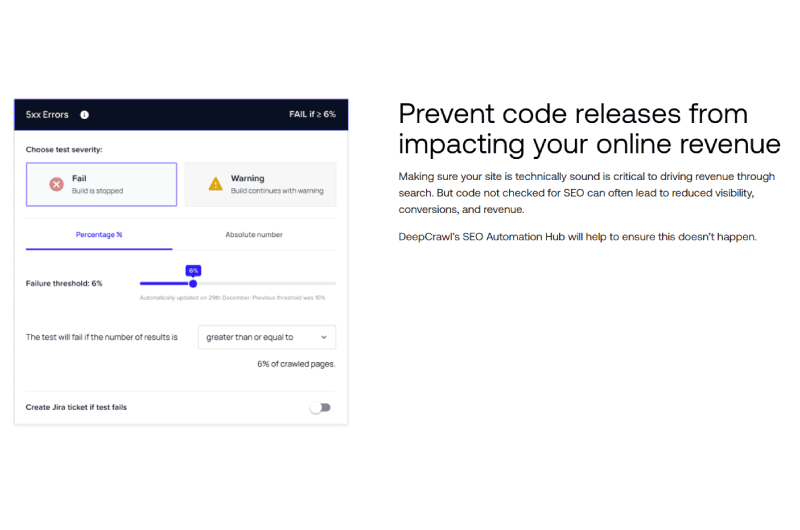

Assim, ajuda grandes marcas e empresas a explorar todo o seu potencial de receita, protegendo seus sites contra certos erros de código.

O Deep Crawl parece ser um centro de comando para SEO técnico e integridade do site. A plataforma usa um rastreador bastante poderoso que analisa os dados do site.

Além do SEO técnico, o Deep Crawl também realiza operações de automação para proteger os sites contra ameaças.

Deep Crawl tem uma equipe de profissionais digitais liderada por Craig Durham.

É usado por muitas empresas, incluindo marcas reconhecidas globalmente como Adobe, eBay, Microsoft, Twitch, etc.

Encontre a empresa : Rastreador

Rastreador nas redes sociais

- Chaîne Youtube

Outras ferramentas relacionadas : Rastreador

Alexandre MAROTEL

Alexandre MAROTEL

Fundador da agência de SEO Twaino, Alexandre Marotel é um apaixonado por SEO e por gerar tráfego na internet. É autor de inúmeras publicações, e possui um canal no Youtube que visa ajudar empreendedores a criarem seus sites e serem mais referenciados no Google.

Outras ferramentas de SEO

Todas as ferramentas de SEO

Sorry, no content found.

Alexandre MAROTEL

Alexandre MAROTEL