Validador de mapa de site XML

Na maioria das vezes, webmasters e SEOs analisam as mensagens de erro HTTP que podem afetar a experiência do usuário.

No entanto, as páginas que remetem a mensagens de erro em seu site podem afetar seu SEO, já que o Google as considera como conteúdo inexistente.

Para evitar isso, é essencial encontrar os links quebrados do seu site usando, por exemplo, o XML Sitemap Validator.

Através desta descrição, descobrimos como utilizar esta ferramenta para detectar as páginas que remetem a mensagens de erro em seu site.

O que é o XML Sitemap Validator?

XML Sitemap Validator é uma ferramenta de SEO que verifica o mapa do site em busca de URLs quebrados. De fato, os rastreadores contam com arquivos de mapa do site XML para saber quais páginas devem ser exploradas.

https://www.twaino.com/wp-content/uploads/2021/06/Html-sitemap.png

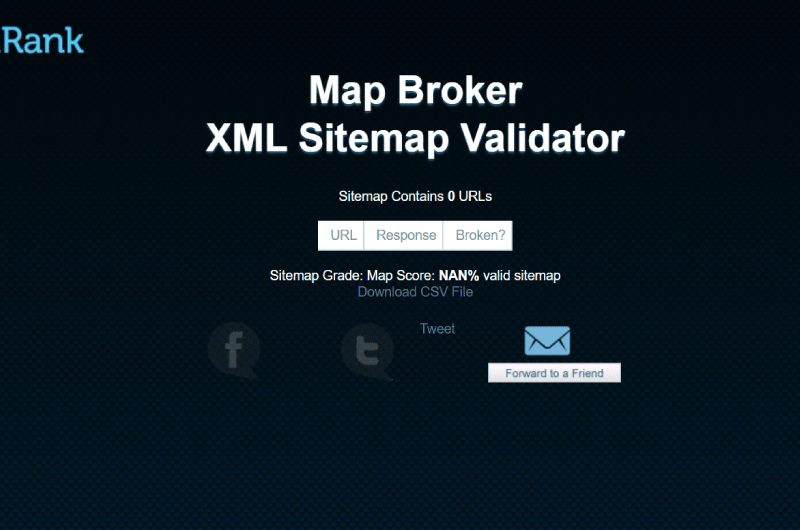

Para isso, é importante ter arquivos de sitemap bem formados, limpos e otimizados para mecanismos de busca. Ou seja, todos os URLs em seu sitemap devem retornar uma resposta de cabeçalho de status 200.

Esse é o interesse da ferramenta XML Sitemap Validator, pois permite verificar a presença de links quebrados em seu sitemap XML. Esse estado de coisas pode levar à perda de confiança dos mecanismos de pesquisa.

Assim como outros problemas de SEO relacionados ao mapa do site que ele pode te ajudar a resolver, temos:

- Marcação XML malformada: a marcação do mapa do site está quebrada e não pode ser analisada pelos mecanismos de pesquisa;

- “Mapa do site sujo”: mapa do site XML que contém links para URLs que os mecanismos de pesquisa não devem rastrear. São URLs que retornam códigos de status diferentes de 200 (links quebrados, redirecionamentos, erros internos);

- Sitemaps de sites que contêm links para URLs não canônicos que retornam o código de status 200.

Na maioria das vezes, esses problemas resultam em mecanismos de pesquisa desperdiçando recursos técnicos/orçamentos de rastreamento rastreando páginas não importantes.

A quem se destina a ferramenta XML Sitemap Validator?

O XML Sitemap Validator é especialmente voltado para profissionais de SEO e pessoas que possuem um site.

Se o seu objetivo é se proteger de links quebrados e suas consequências em termos de SEO e experiência do usuário, esta ferramenta certamente será um grande trunfo para você.

Além de ser totalmente gratuita, a ferramenta é simples de usar e oferece a possibilidade de exportar os resultados do seu verificador em formato CSV para uso posterior.

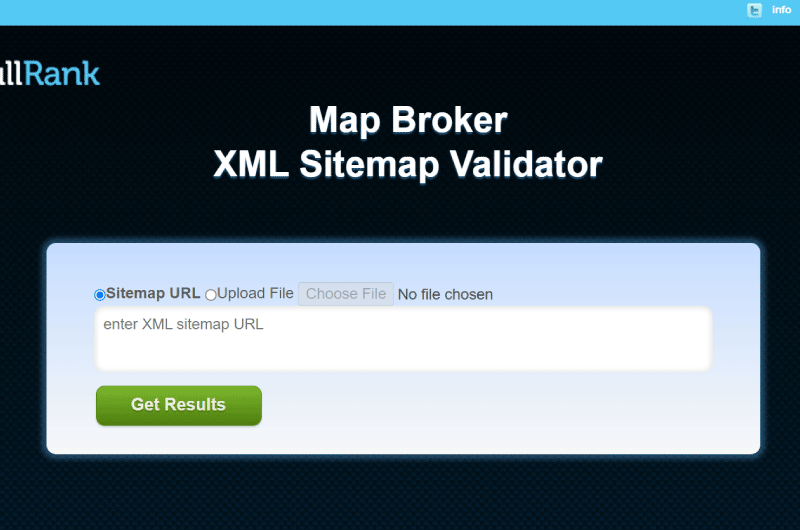

Para usá-lo, você precisa enviar seu sitemap para a ferramenta. O interessante é que você tem a opção de inserir a URL do mapa do site diretamente ou escolher um arquivo.

Como encontrar o sitemap do seu site para enviar para a ferramenta XML Sitemap Validator?

Mapas de site são mapas de site e são uma maneira fácil de informar os mecanismos de pesquisa, especialmente seus rastreadores (por exemplo, o Googlebot) sobre o conteúdo importante do seu site.

Eles também fornecem informações sobre URLs diferentes em um site e também incluem metadados. Veja como encontrar seu mapa do site:

Verifique manualmente os locais atuais do mapa do site XML

A maneira mais comum de encontrar o mapa do site de um site é verificar manualmente alguns locais padrão.

Tudo o que você precisa fazer é inserir a URL do seu site no navegador e experimentar algumas variações diferentes como esta:

www.mondomaine.com/sitemap.xml

Este local é o mais popular, mas se você não conseguir encontrá-lo, tente o seguinte esquema de URL novamente:

www.mondomaine.com/sitemap_index.xml

Verifique o arquivo Robots.txt

O O arquivo robots.txt é um arquivo especial que todos os SEOs sabem. Ele fornece diretrizes úteis para aranhas de mecanismos de pesquisa. Além disso, é também o local onde muitas vezes encontramos um link para a planta de um site.

A ideia é que, como os mecanismos de pesquisa visitam esses arquivos robots.txt, faz sentido adicionar um link para o mapa do site neles. Dessa forma, será mais fácil para eles detectar o mapa do site em primeiro lugar para explorar o site.

Para encontrar este arquivo, basta adicionar /robots.txt ao seu nome de domínio no navegador e pressionar “Enter”. Isso é semelhante à etapa anterior, onde adicionamos as diferentes rotas possíveis para o mapa do site.

Então você obtém um URL como este:

https://mondomaine.com/robots.txt

Se você já o abriu, verá quase instantaneamente a pequena joia que está procurando: o arquivo de mapa do site:

Verifique o console de pesquisa do Google

Se você ainda não conseguir encontrar seu mapa do site, agora iremos procurá-lo diretamente no Google Search Console.

Ao acessar esta ferramenta, o próximo passo é ir ao menu à esquerda e escolher Sitemaps como na imagem abaixo:

Fonte :SEOcrawl

Além do sitemap exato, você encontrará informações adicionais, como tipo de sitemap, data de envio, última leitura, status e número de URLs que ele contém.

Fonte :SEOcrawl

A partir daí, basta enviar o mapa do site para a ferramenta XML Sitemap Validator para detectar links quebrados. Mas se você não conseguiu encontrá-lo, ainda temos algumas dicas para encontrá-lo.

Use os operadores de pesquisa do Google

Se o seu sitemap for enviado ao Google, certamente já está indexado pelo mecanismo de busca. Portanto, poderemos encontrá-lo com muita facilidade usando os operadores de pesquisa.

Para isso, usaremos os operadores:

- site: ;

- tipo de arquivo:xml ;

- inurl: mapa do site.

Por exemplo, você pode pesquisar site:mydomain.com filetype:xml inurl:sitemap.

Lembre-se de substituir seu nome de domínio na URL em vez de “meudomínio”.

Use uma ferramenta online

Outra técnica para encontrar o mapa do site para enviá-lo à ferramenta XML Sitemap Validator é usar uma ferramenta online como Site Checker.

Você só precisa colar o URL do seu site e clicar em Verificar e, em seguida, obterá algo como isto:

Em seguida, copie o URL e cole-o na ferramenta verificadora para obter os links quebrados do seu site.

Resumindo, a ferramenta XML Sitemap Validator ajuda profissionais de SEO e webmasters a encontrar URLs que retornam uma mensagem de erro em seus sites para corrigi-los.

Ao fazer isso, eles melhoram a maneira como os mecanismos de pesquisa percebem seus sites e os tornam mais confiáveis para os usuários.

Alexandre MAROTEL

Alexandre MAROTEL