Description Robots Exclusion Checker

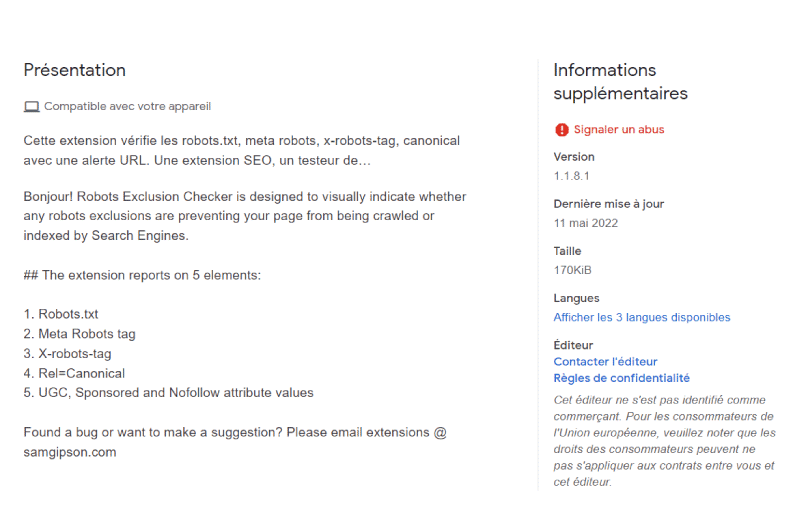

Robots Exclusion Checker est une extension Google Chrome qui permet de détecter les balises meta robots, les exclusions robots.txt et x-robots-tags présentes sur une URL spécifique.

Concrètement, l’extension a été conçue pour aider les spécialistes du SEO à identifier les exclusions qui empêcheraient une page web à être explorée et indexée par les robots des moteurs de recherche.

Qu’est-ce que Robots Exclusion Checker ?

Robots Exclusion Checker permet de vérifier si une exclusion de robot affecte l’indexation et l’exploration d’une URL donnée sur le web.

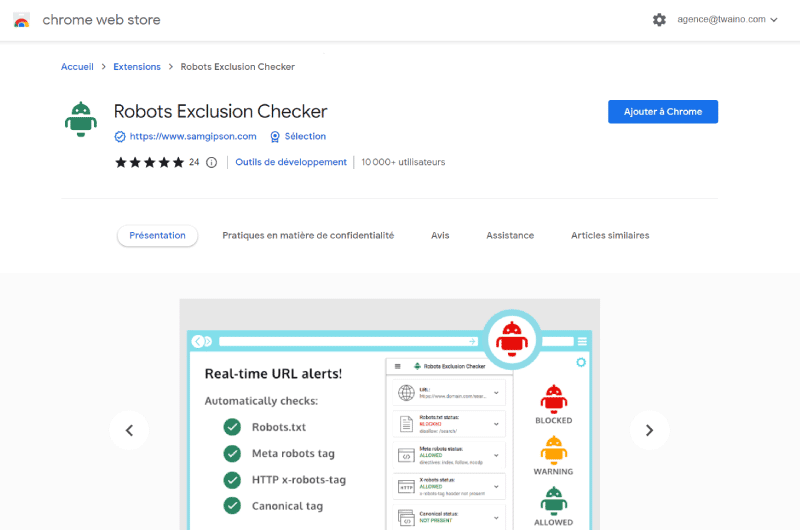

Grâce à des indicateurs de couleurs simples, l’extension permet de voir en un clin d’œil l’état d’indexabilité d’une page web par les moteurs de recherche :

Source : Robots Exclusion Checker

Le rouge pour signifier que l’URL comporte des exclusions qui bloquent le processus d’exploration des moteurs de recherche.

Le jaune pour signifier un avertissement. Il existerait donc des éléments qui peuvent potentiellement empêcher l’exploration de la page par les moteurs de recherche.

Le vert pour signifier que l’exploration de la page par les robots des moteurs de recherche est autorisée. Elle peut donc être indexée et être classée dans les résultats de recherche.

Lorsqu’un problème d’indexation est détecté, l’extension vous affiche également la cause du blocage pour vous aider à régler le problème au plus vite.

Ce qui permet de gagner du temps et vous assurer que toutes vos pages importantes sont bien accessibles aux moteurs de recherche.

Robots Exclusion Checker est pratiquement la première extension à rassembler sur une seule interface tous les éléments qui peuvent empêcher qu’une URL soit explorée et indexée par les robots des moteurs de recherche. Et tout ceci dans un format simple et facile à digérer.

L’extension est téléchargeable depuis le web store chrome et reste particulièrement adaptée aux spécialistes du marketing digital qui ont en charge des boutiques e-commerces ou de grands sites complexes.

Robots Exclusion Checker : Comment installer et utiliser l’extension ?

L’utilisation de l’extension est simple à prendre en main :

- Cliquez sur le bouton « Ajouter à Chrome » pour installer l’extension sur votre navigateur

- Une fois l’installation terminée, rendez-vous sur la page que vous souhaitez analyser

- Déroulez la liste des extensions installées sur votre navigateur puis cliquez sur le logo de Robots Exclusion Checker.

Automatiquement, une fenêtre contextuelle devrait apparaitre à l’écran présentant les informations collectées par l’extension.

Robots Exclusion Checker : Les éléments SEO qui sont vérifiés par l’extension

Voici la liste des éléments sur lesquels vous pouvez détecter la présence de potentiels problèmes d’indexation sur votre site avec l’extension Robots Exclusion Checker :

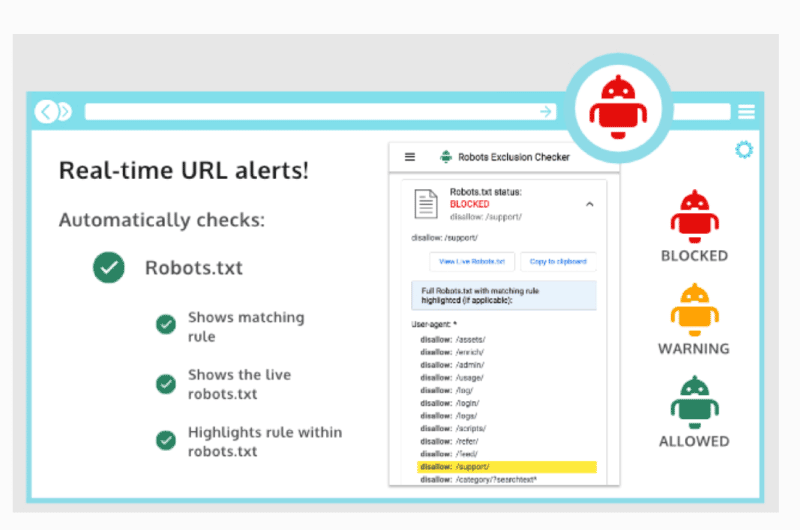

1. Statut Robots.txt

Robots Exclusion Checker explore vos pages et vous indique son statut Robots.txt entre “Permis” ou “Refuser”.

L’outil montre aussi les règles de correspondance retrouvées sur la page avec une fonctionnalité de “Copier dans le papier-presse”.

Vous disposez également de la possibilité de consulter votre fichier Robots.txt directement en ligne depuis l’interface de l’extension avec les règles de correspondance mises en surbrillance.

Au cas où aucune règle n’aurait été détectée, cela témoigne qu’il n’y a aucun problème à signaler du côté du fichier Robots.txt.

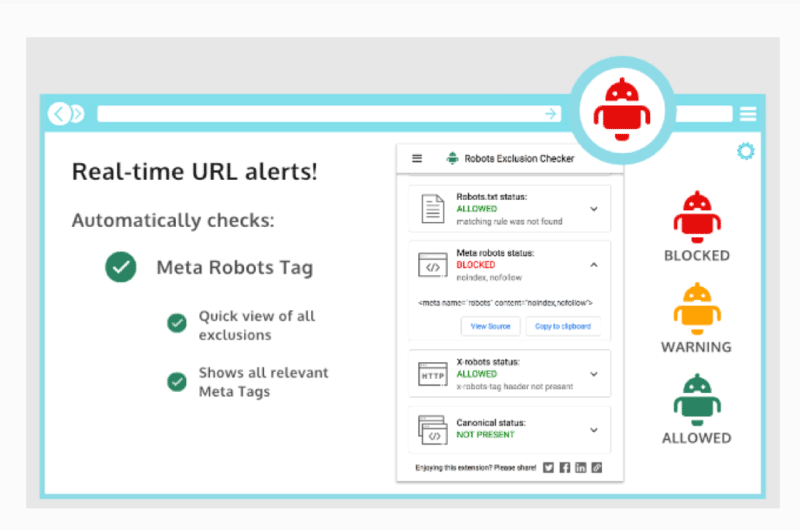

2. Statut Balise Meta Robots

En ce qui concerne le statut Balise Meta Robots de vos pages, l’extension marque d’icônes de différentes couleurs selon qu’il s’agisse des balises Meta Robots qui dirigent les robots d’exploration vers « index », « noindex », « follow » ou « nofollow ».

Quant aux directives qui n’empêchent pas l’indexation de la page par les moteurs de recherche, elles seront aussi affichées, mais classées en dehors des alertes. Il s’agit notamment des balises « nosnippet » et « noodp ».

Robots Exclusion Checker facilite l’affichage des directives en permettant de voir l’intégralité des balises méta robots HTML dans le code source directement depuis l’interface de l’extension.

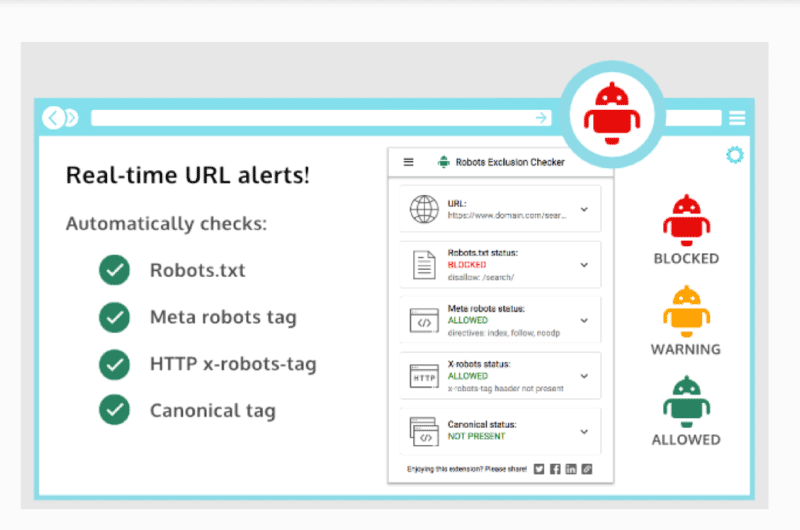

3. Statut Balise X-Robots

Détecter les directives robots dans l’en-tête HTTP peut être une tâche un peu difficile. Mais avec l’extension Robots Exclusion Checker, vous pouvez facilement identifier toutes les exclusions, ainsi que l’en-tête HTTP tout entier.

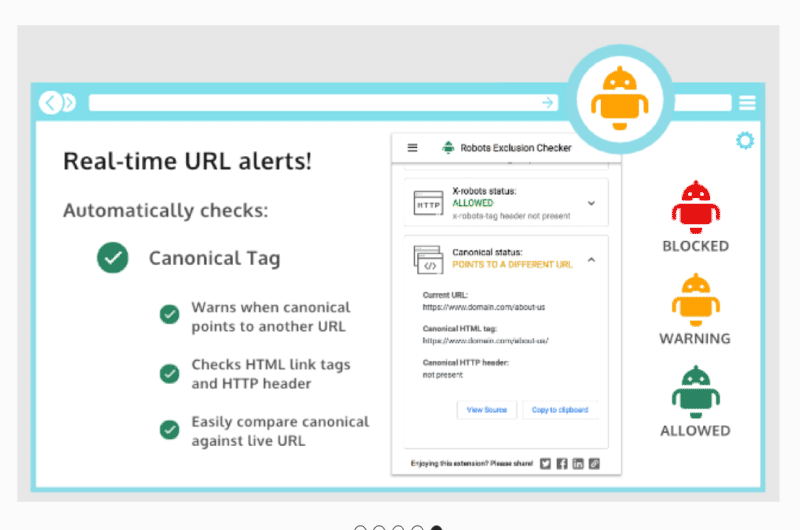

4. Statut Balise Canonique

Il est vrai que les balises canoniques n’influencent pas directement l’indexation des pages web, mais elles jouent un rôle important dans le comportement de vos URL dans les résultats de recherche.

Avec Robots Exclusion Checker, vous pouvez identifier vos pages web indexables par les moteurs de recherche, mais qui présentent une incohérence canonique.

Ces pages seront marquées d’une icône orange dans la section “Balise Canonique” de l’extension.

5. Statut Balise Nofollow

Il s’agit d’une nouvelle fonctionnalité de l’extension Robots Exclusion Checker qui vous permet d’identifier tous les liens qui utilisent une valeur d’attribut rel « nofollow », « ugc » ou « sponsored ».

Robots Exclusion Checker : Tarification

Extension gratuite

Alexandre MAROTEL

Alexandre MAROTEL