Se o senhor for um desenvolvedor de website ou de páginas da web, deve saber que é essencial que tenha o arquivo robots.txt.

Muitas pessoas já podem se perguntar o que quero dizer, especialmente se não têm conhecimento de SEO ou desenvolvimento da web.

Lembre-se de que este é um arquivo de texto muito importante. Ele é usado para administrar os pedidos de exploração de seu site pelos rastreadores do Google.

Este mini guia lhe dará uma compreensão mais profunda do que se entende por robots.txt.

O senhor encontrará também o processo de criação e instalação de robôs.txt, bem como as melhores práticas para seu uso.

Capítulo 1: O que é um arquivo robots.txt e qual é a sua finalidade?

Neste primeiro capítulo, o senhor aprenderá o verdadeiro significado dos robôs.txt, bem como a utilidade dos mesmos.

1.1 O que é um robots.txt e como é que ele se parece?

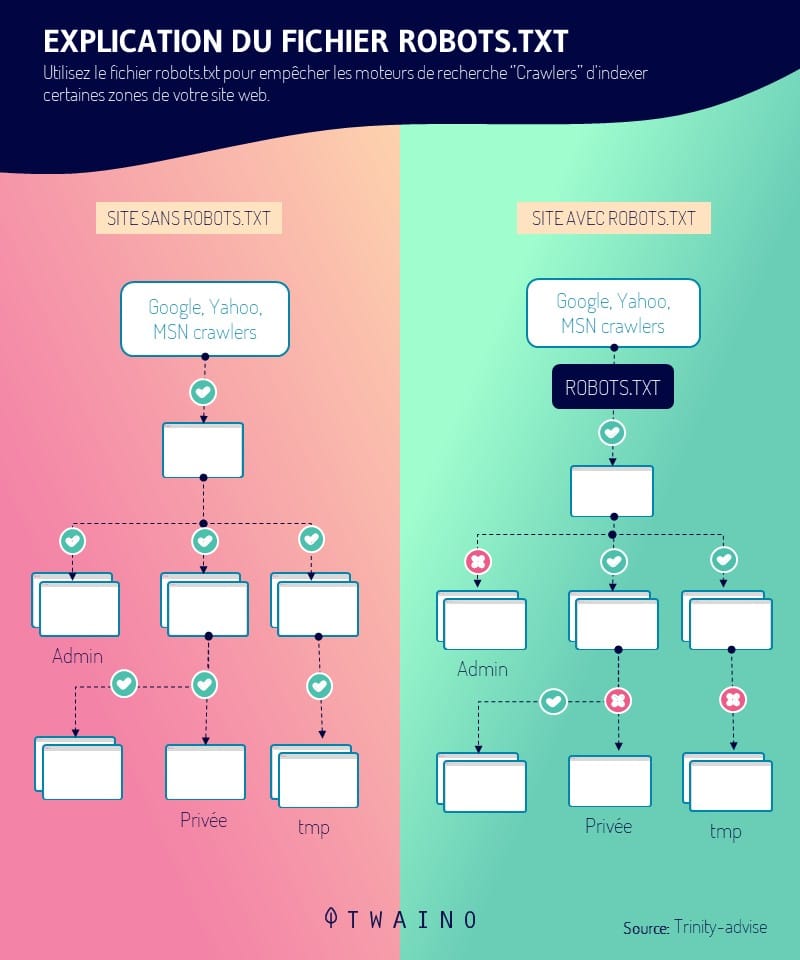

O robô.txt representa um dado informático. Mais precisamente, é um arquivo de texto que é usado em websites para dizer aos rastejadores (principalmente motores de busca) como rastrear as páginas dos websites.

Mais tecnicamente, eles fazem parte de um protocolo de exclusão e representam as normas que regem como os rastejadores rastejam a web, o acesso e o conteúdo do índice

Ela está incluída na raiz de seu website de modo que se o endereço de seu website for: www.monsite.com, o URL que leva ao robot.txt é www.monsite.com/robots.txt.

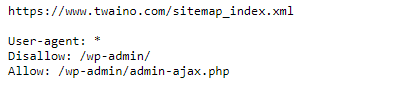

- Se houver robôs.txt em seu site, quando o senhor entrar na URL www.monsite.com/robots.txto senhor verá uma janela como :

No entanto, se não estiver presente, o senhor receberá uma mensagem de erro como 404.

1.2) Qual é a importância do arquivo robots.txt para um website?

Como o senhor deve ter adivinhado, os robôs.txt desempenham um papel importante em seu website, controlando a maneira como ele é navegado pelos rastejadores

Pode assim :

- Impedir que os robôs do Google rastreiem conteúdo duplicado;

- Recusar-se a exibir uma parte privada do site nas SERPs;

- Negar a exibição das páginas de resultados de pesquisa interna do site no Google Search Results;

- Recuse a indexação, pelos motores de busca, de certos elementos do seu site;

- Especifique um tempo de rastejamento para evitar sobrecarregar seu local;

- Otimize o uso dos recursos de seu servidor, evitando que os bots desperdicem os recursos de seu site.

Agora que o senhor sabe o que é um robô.txt e por que ele é importante, vamos ver como criá-lo e implementá-lo em um website

Capítulo 2: Como criar o arquivo robots.txt para seu website

Depois de explicar o processo de criação do arquivo robots.txt para um website, explicarei como proceder para saber se seu arquivo funciona ou não.

2.1. Criação do arquivo robots.txt para seu website

O arquivo robots.txt pode ser criado manualmente ou gerado automaticamente na maioria dos CMS como o WordPress

Passaremos por ambos os processos de criação. No entanto, antes de procurar instalar o arquivo robots.txt, certifique-se de que seu site ainda não tenha um

2.1.1. Criação de seu próprio arquivo robot.txt

Para criar seu próprio arquivo robot.txt, o senhor precisa de um editor de texto (este é um software para criar e editar arquivos de texto) Bloco de notas e texto sublime são exemplos.

Uma vez escolhido e baixado seu editor, para criar seu arquivo robot.txt, o senhor deverá seguir certas regras. Essas regras dizem respeito:

A localização e o formato do arquivo robots.txt

- Seu arquivo deve ser chamado robots.txt ;

- O senhor só tem direito a um único arquivo robots.txt em seu site;

- Seu arquivo robots.txt deve estar localizado na raiz de seu site.

A sintaxe de seu arquivo robots.txt

- O arquivo robots.txt deve respeitar a codificação UTF-8;

- O processo é composto de um ou mais grupos de instruções;

- A regra, uma declaração por linha e por linha vazia, deve ser respeitada.

Os comandos (instruções ou diretrizes) a serem usados para construir seu arquivo robots.txt:

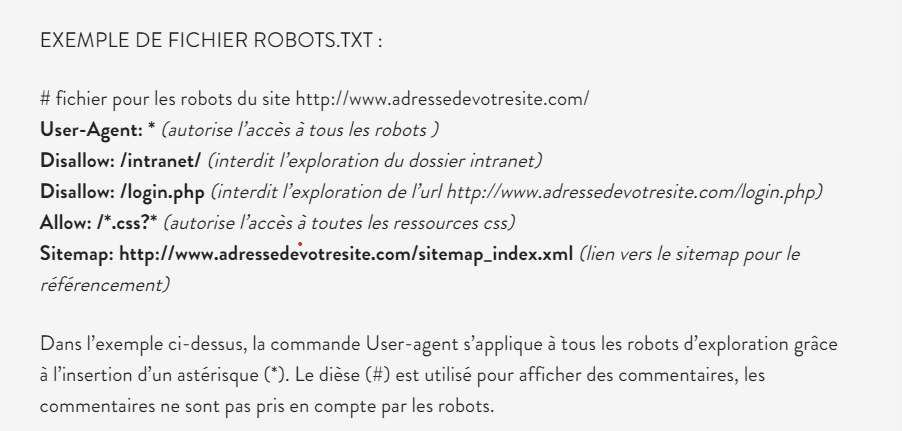

- Agente-usuário esta é a primeira linha e contém o nome do robô do motor de busca. O senhor pode consultar o banco de dados de robôs para encontrar o nome do robô que o senhor quer proibir;

- Não autorizar : Nesse comando, o senhor terá que colocar o URL da página ou a pasta que deseja proibir o acesso aos robôs;

- Permitir autorização para a exploração de um URL ou de uma pasta por robôs;

- Mapa do site essa instrução opcional permite ao senhor indicar aos robôs do Google as partes de seu site que eles devem explorar.

Para mais informações sobre essas diferentes regras, dê uma olhada no apoio do Google.

Aqui está um exemplo de um arquivo robots.txt

fonte anthedesign

Uma vez que seu arquivo de texto esteja pronto, o próximo passo seria instalá-lo em seu website.

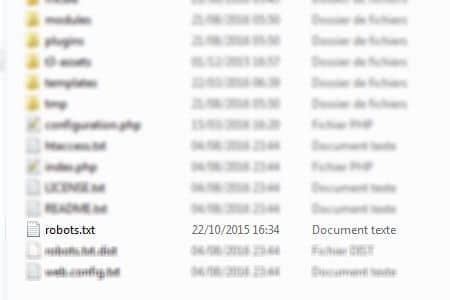

Para fazer isso, basta acessar a raiz de seu site a partir de seu software de cliente FTP e soltar o arquivo robots.txt no diretório www

Fonte Web-eau

É isso mesmo, seu arquivo robots.txt é criado e instalado em seu site.

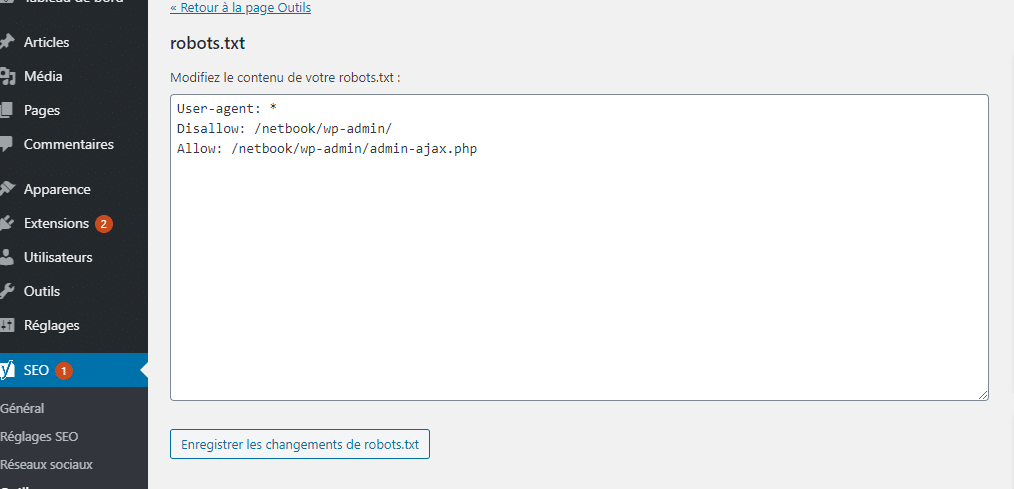

2.1.2. Criação do arquivo robots.txt com WordPress

No WordPress, um arquivo robots.txt é automaticamente criado para seu site

Se o senhor estiver usando um site WordPress, então simplesmente digite na barra de busca o URL de seu site seguido de: /robots.txt para verificar o arquivo robots.txt.

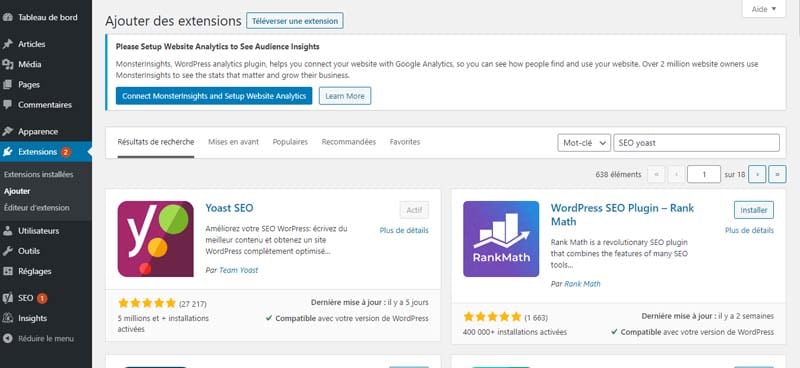

Em qualquer caso, você pode criar seu próprio arquivo robots.txt usando plugins como SEO JOVEM ou TODOS EM SEO.

Para criar seu arquivo robots.txt com SEO YOAST, basta procurar, baixar e instalar a extensão SEO YOAST no WordPress.

Em seguida, ative-o e vá para as instalações de extensão.

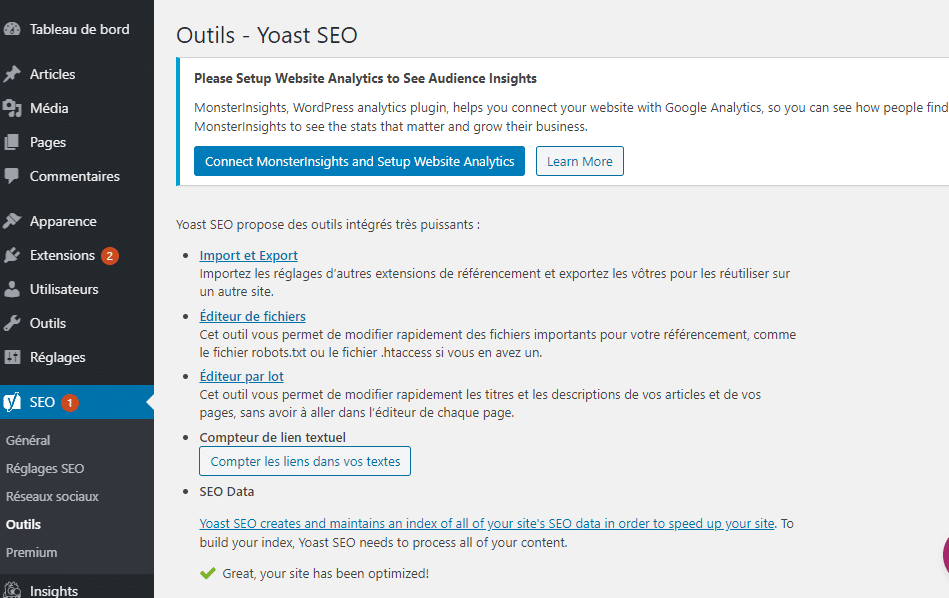

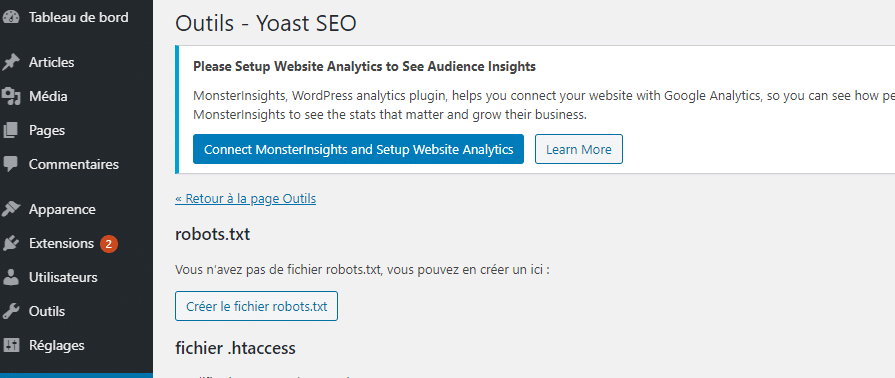

Uma vez nas configurações, selecione “editor de arquivos” e aguarde que a nova janela seja carregada.

Escolha “criar arquivo robots.txt”.

Finalmente, edite o conteúdo dos robôs.txt virtuais criados pelo WordPress e salve as mudanças.

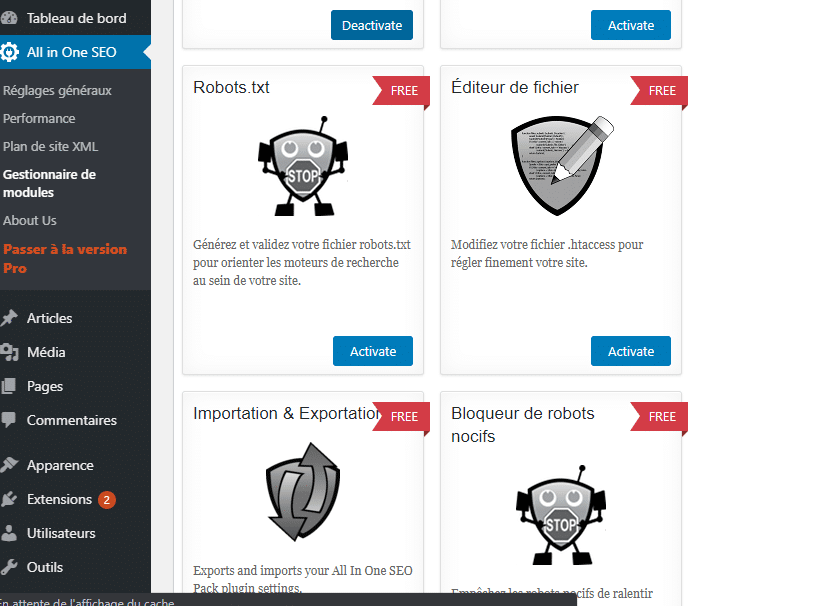

O senhor também pode criar o arquivo robots.txt a partir da extensão ALL In SEO. Para isso, o senhor deve primeiro baixar, instalar e ativar a extensão.

Depois, uma vez nas opções de extensão, selecione a administração dos módulos e aguarde a nova janela com os diferentes módulos para carregar.

Procure o módulo robots.txt e pressione ativá-lo para montar seu arquivo robots.txt.

Agora o senhor criou seu arquivo robots.txt manualmente ou usando um plugin no WordPress

O próximo passo seria verificar se o arquivo robots.txt criado funciona.

Para isso, o senhor precisará fazer um teste.

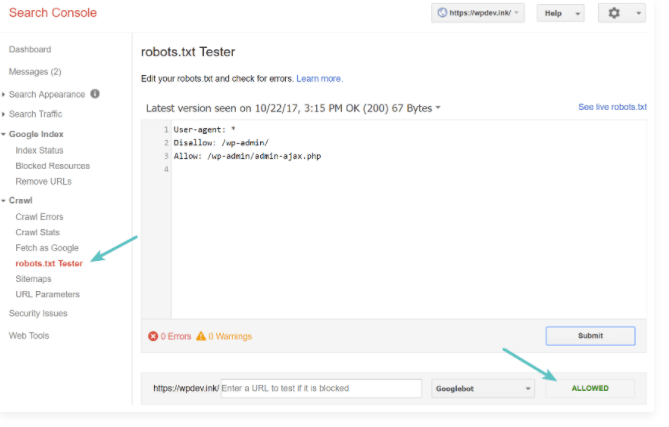

2.3. Teste seu arquivo robots.txt.

Para testar seu arquivo robots.txt, basta seguir o instruções do Google o senhor deputado está sendo consultado sobre as instruções do Conselho sobre este assunto

Especificamente, o senhor precisa ir ao seu console de busca e clique na aba crawl e depois no teste robots.txt

O senhor tem então acesso a uma janela que lhe permite submeter seu arquivo robots.txt ao Google.

fonte kinsa

Não se esqueça de integrar as modificações ao seu arquivo antes de carregá-lo no servidor do seu site.

Capítulo 3: Os diferentes usos dos robôs.txt.

Aqui veremos alguns dos usos dos robôs.txt. Mas primeiro, falaremos sobre a finalidade última de um arquivo robots.txt.

3.1. O propósito dos robôs.txt

Uma vez que o senhor tenha criado e instalado com sucesso o arquivo, é importante saber como utilizá-lo

O objetivo principal do uso de arquivos robots.txt é negar e permitir o acesso de robôs de busca ao seu site

Na verdade, as instruções não têm o mesmo modo de operação. O serviço prestado difere de uma diretriz para outra. No entanto, a operação das instruções pode ser resumida em duas expressões: autorização e recusa.

3.1.1. Autorização

Isso consiste em permitir que todos os robôs da web explorem todos os compartimentos e páginas da web de seu site. Se é esse o seu desejo, a presença do arquivo robots.txt é, portanto, inútil, uma vez que as instruções são sem missões

Como resultado, eles não podem mais reconhecer e controlar os robôs da rede. Recomenda-se, portanto, que o senhor se abstenha de instalar o processo nessas circunstâncias

Por outro lado, se o senhor já o tem, é simplesmente aconselhável apagá-lo. No entanto, se o senhor quiser mantê-la, deve deixá-la completamente vazia, sem qualquer modificação.

3.1.2. Recusa

O senhor talvez queira proibir todos os robôs da web de explorar seu site. Para conseguir isso, a instalação do arquivo robots.txt é importante. É uma questão de integrar uma única instrução: bloquear o acesso a seu site a todos os robôs da rede.

Agora que conhecemos os dois objetivos finais de um robô.txt vamos ver como usá-lo para permitir e negar o acesso a robôs.

3.2. Como usar robôs.txt para bloquear o acesso a um site inteiro

Para evitar que os robôs rastejem seu site por qualquer razão, simplesmente acrescente a seu arquivo robots.txt o código :

Agente do usuário : *

Não permitir: /

Nesse código, o asterisco significa: “Todos os robôs e a barra em branco significam que o senhor gostaria de negar acesso a todas as páginas do domínio de seu site”.

3.como o senhor usa o arquivo robots.txt para evitar que um único robô rastreie seu site?

Se o senhor quiser excluir o rastejador de um mecanismo de busca específico de rastrear seu site, pode usar o código :

Agente-usuário: nome do robô

Não permitir :/

A utilização desse código lhe permitirá aplicar a regra de exclusão somente a um robô específico.

3.3) Como evitar que os robôs rastejem uma pasta ou um arquivo em seu site?

Para evitar que os robôs rastejem um arquivo ou pasta em seu site, basta usar o código :

Agente do usuário : *

Não permitido: nome da pasta

3.4. Como usar os robôs. Txt para permitir um arquivo que esteja contido em uma pasta não autorizada.

Para pedir aos rastejadores que indexem um conteúdo que está em uma pasta que o senhor não gostaria que os rastejadores explorassem inteiramente, basta que o senhor use o código :

Agente do usuário : *

Não permitido: caminho da pasta não autorizada

Permitir: caminho do arquivo a explorar

Além desses usos, observe que o arquivo robots.txt pode ser modificado e você também pode optar por excluir certas páginas do arquivo robots.txt

3.5. Como modificar um arquivo robots.txt?

É verdade que é muito raro modificar um arquivo robots.txt já instalado. No entanto, é possível modificá-la. Exceto que o senhor deve esperar uma reconfiguração de seu site.

Se o senhor criou e instalou seu arquivo manualmente, então precisa abrir seu arquivo robots.txt na raiz de seu site e fazer as várias mudanças que gostaria de fazer. Uma vez terminado, o senhor deve guardar as modificações e salvar seu processo.

Entretanto, se o senhor estiver usando um CMS como o WordPress, poderá modificar seu arquivo usando os plugins SEO YOAST e All In SEO, seguindo as instruções da parte 2.2.

3.6. Como excluir certas páginas do seu arquivo robots.txt?

Como é possível modificar esse arquivo, é possível também excluir certas páginas de seu banco de dados robots.txt. Isso envolve a subtração de certos URLs que são permitidos para acessar o mecanismo de busca de seu site.

Para fazer isso, o senhor precisa voltar à raiz de seu site. O senhor deve poder ter acesso ao conteúdo do processo. Em seguida, vá para a pasta de declarações de não admissão. É esta diretriz que constitui a memória de todos os URLs autorizados.

Caberá então ao senhor identificar os endereços indesejáveis que deseja extrair de seu banco de dados. Basta desmarcá-los e eles agora são considerados como URLs não autorizados

Agora que o senhor sabe tudo sobre o uso de robôs txt, apresento-lhe no capítulo algumas boas práticas a serem adotadas.

Capítulo 4: Algumas boas práticas a ter para seu arquivo txt

Para usar corretamente seus arquivos robots.txt:

- Na configuração de seu arquivo robots.txt, assegure-se de que somente as páginas que não tenham valor sejam bloqueadas

- Assegure-se de não bloquear os arquivos JavaScript e CSS de seu site;

- Sempre teste depois de montar seu arquivo robots.txt para ter certeza de que o senhor não bloqueou nada por acidente;

- Sempre coloque o arquivo robots.txt no diretório raiz de seu site;

- Certifique-se de nomear seu arquivo “robots.txt”;

- Acrescente a localização de seu mapa do site ao seu arquivo robots.txt.

E é isso, já terminamos com as coisas a ter em mente quando se trata de manusear seu arquivo robots.txt.

Em poucas palavras

Robots.txt são arquivos de texto instalados na raiz de websites para controlar o rastreamento e a indexação de seu conteúdo por vários motores de busca aranhas.

Neste artigo, o senhor saberá não só como eles podem ser úteis ao seu site, mas também como utilizá-los para aproveitá-los ao máximo.