Il faut le reconnaître, l’intelligence artificielle a apporté un grand changement dans la manière de créer et de publier les contenus en ligne. De nombreux sites web ont déjà adopté l’IA pour produire des contenus de qualité et optimisés pour le référencement.

Mais comment Google réagit-il face à ces contenus générés par l’IA ? Est-ce qu’il les considère comme des contenus humains ou comme du spam ?

Martin Splitt, un expert de Google, a récemment répondu à cette question, en expliquant comment Googlebot explore, rend et traite le contenu IA.

Dans cet article, nous aborderons comment Google gère les contenus créés avec l’intelligence artificielle.

Martin Splitt parle de comment Google traite les contenus générés IA

Martin Splitt a abordé la manière dont Google traite les contenus IA lors d’un webinaire appelé Exploring the Art of Rendering.

Il répondait à une personne de l’auditoire qui voulait savoir si l’afflux des contenus IA en ligne pourrait entraver la capacité de Google à traiter les informations en matière de rendu et d’exploration.

La question était :

“Ils disent que la production de contenu augmente en raison de l’IA, ce qui augmente les charges sur le crawling et le rendu. Est-il probable que les processus de rendu doivent être simplifiés ?”

En d’autres termes, l’intervenant cherche à savoir si Google a pris des mesures spécifiques face à l’augmentation des contenus en ligne étant donné que la charge de l’exploration et du rendu va considérablement augmenter.

Dans un premier temps, Martin a dit :

“Non, je ne pense pas”.

Il a ensuite expliqué la façon dont le moteur de recherche détermine lors du crawling les pages de mauvaise qualité et comment il procède après avoir trouvé ces types de pages.

Comment détecte-t-il les contenus générés par l’ IA ?

L’une des plus grandes préoccupations des professionnels face à l’IA est la capacité de Google à détecter les textes que cette dernière génère.

Martin a aussi abordé cette question lors de son intervention.

Il a affirmé :

« Nous procédons donc à une détection ou à un contrôle de la qualité à plusieurs stades, et la plupart des contenus s****l n’ont pas nécessairement besoin de JavaScript pour nous montrer à quel point ils sont s****l.

Par conséquent, si nous constatons qu’il s’agit d’un contenu s****l avant, nous sautons le rendu, quel est l’intérêt ?

Si nous voyons, ok, cela ressemble à absolu… nous pouvons être très certains que c’est de la merde, et que le JavaScript pourrait juste ajouter plus de merde, alors bye. S’il s’agit d’une page vide, on peut se dire qu’on ne sait pas.

Les gens ne mettent généralement pas de pages vides ici, alors essayons au moins de rendre. Et puis, quand le rendu nous renvoie une merde, nous nous disons, ouais ok, c’est juste, ça a été une merde.

C’est donc déjà le cas. Ce n’est pas nouveau. L’IA peut augmenter l’échelle, mais ne change pas grand-chose. Le rendu n’est pas le coupable ici« .

Les contenus IA subissent le test de qualité

Avec la réponse de Martin, on aperçoit que Google ne procède pas à la détection de l’IA, mais utilise plutôt plusieurs moyens pour déterminer si un contenu est de qualité ou pas.

Cela est tout à fait normal dans la mesure où l’algorithme de Google n’est pas conçu pour détecter les contenus de faible qualité générés par l’IA, mais il les découvre automatiquement.

Rappelez-vous du système Helpful Content qui visait à récompenser les sites qui produisent un contenu de haute qualité à l’intention des internautes.

À ce propos, Danny Sullivan a écrit :

“...nous apportons une série d’améliorations au moteur de recherche afin de permettre aux internautes de trouver plus facilement des contenus utiles rédigés par et pour des personnes”.

En d’autres termes, Google ne met pas en avant seulement des contenus rédigés pour les humains, mais également des contenus rédigés par des humains.

Autant dit que le moteur est capable de différencier les contenus générés par des humains des autres ainsi que des contenus de mauvaise qualité.

Selon les chercheurs :

“Cet article postule que les détecteurs formés pour distinguer le texte écrit par un humain de celui écrit par une machine sont des prédicteurs efficaces de la qualité linguistique des pages web, surpassant un classificateur de spam supervisé de base.”.

Autrement dit, c’est un aspect clé du référencement naturel et de la visibilité en ligne.

Pour sa part, Martin a dit :

“...nous procédons à la détection ou au contrôle de la qualité à plusieurs stades…

C’est donc déjà le cas. Ce n’est pas quelque chose de nouveau. L’IA peut augmenter l’échelle, mais ne change pas grand-chose.”.

En d’autres termes :

- Google n’applique pas de nouvelles mesures aux contenus générés ;

- Le moteur de recherche utilise la détection de la qualité à la fois pour les contenus rédigés par les humains et ceux rédigés par l’IA.

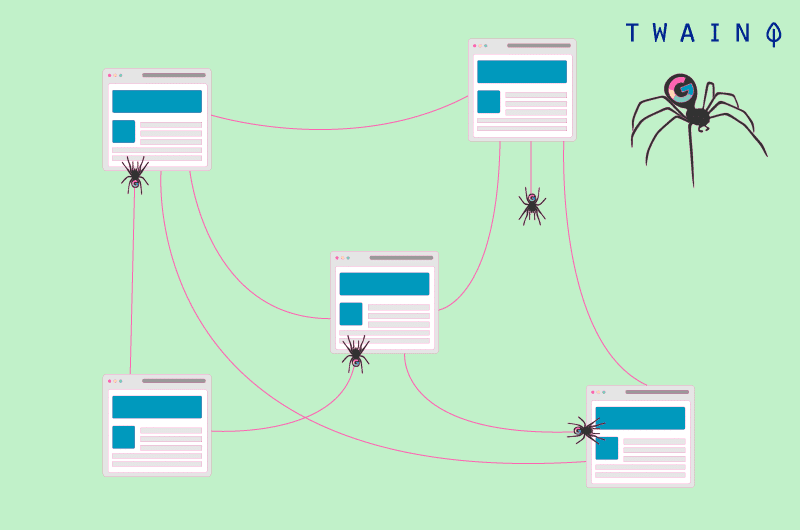

Qu’est-ce que le rendu des pages web par Googlebot ?

Googlebot n’est rien d’autre que le nom du robot d’indexation de Google qui explore le web et récupère les informations des pages web pour les ajouter à l’index du moteur de recherche.

Le rendu des pages web par Googlebot quant à lui, est un processus qui permet au robot de comprendre comment les pages web sont affichées aux utilisateurs. Il tient compte des éléments visuels, du contenu dynamique, du JavaScript, des CSS et d’autres ressources.

C’est à travers le rendu des pages web par Googlebot que le moteur de recherche évalue la qualité, la pertinence et l’utilité des pages web pour les internautes.

Cette vidéo est l’intégralité de l’intervention de Martin Splitt au cours du webinaire.

En résumé

Pour conclure, Google traite les contenus IA de la même manière qu’il traite les contenus rédigés par les humains. Ces contenus doivent donc respecter les consignes du moteur de recherche en matière de qualité.